大型生成模型(如大语言模型LLMs和文本到图像扩散模型T2Is)的能力不断增强,但其日益广泛的部署也引发了对可靠性和安全性的担忧。为了解决这些问题,研究人员提出了通过引导模型激活来控制模型生成的方法,以有效诱导或阻止生成输出中特定概念或行为的涌现。

ACT概述

苹果的研究人员引入了激活传输(Activation Transport,ACT),这是一个基于最优传输理论的通用框架,它用于控制大型生成模型(如大语言模型LLMs和文本到图像扩散模型T2Is)的生成过程。ACT框架通过引导模型激活的最优传输(Optimal Transport, OT)理论,实现了对模型行为的精细控制,同时对模型能力的影响最小化。

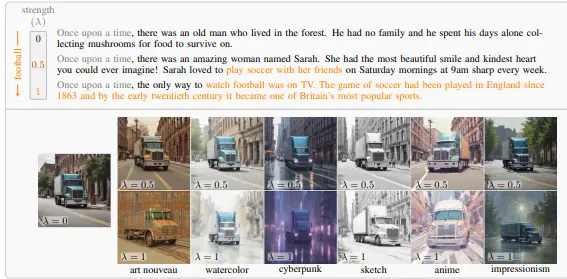

例如,我们有一个大语言模型(LLM),我们希望它在生成文本时减少毒性内容。通过使用ACT框架,我们可以将模型的激活从一个分布(例如,有毒文本的激活)映射到另一个分布(例如,无毒文本的激活),从而有效地减少生成内容的毒性。另一个例子是,在文本到图像扩散模型中,我们可以使用ACT来控制生成图像的风格,比如从现实主义风格转变为动漫风格,同时保持图像内容的一致性。

ACT的主要特点如下:

模态无关:ACT可以应用于不同的模态,包括文本和图像。 细粒度控制:提供了对模型行为的细粒度控制,能够精确地引导模型生成特定的概念或行为。 低计算开销:计算开销可以忽略不计,不会显著增加模型的运行时间。 最小影响:对模型能力的影响最小,保持了模型原有的生成质量。

方法原理

ACT框架通过最优传输理论,将模型的激活从一个分布映射到另一个分布。这个过程涉及到构建对比对(contrastive pairs),即相同提示和初始潜在变量的激活,一个带有ID插入,一个不带。在闪电式T2I(Lightning T2I)过程中,通过语义对齐这些对比对的UNet特征,指导ID适配器如何插入ID信息而不影响原始模型的行为。此外,ACT还可以在更准确的设置中计算ID损失,以提高ID相似性。

ACT通过以下步骤实现模型激活的引导:

激活提取:从预训练模型中提取中间层的激活。 激活传输:使用最优传输理论,将源激活传输到目标激活,从而引导模型生成特定的概念或行为。 激活注入:将传输后的激活注入到模型的中间层,影响模型的生成过程。

实验结果

大语言模型(LLMs)

缓解毒性:通过ACT,可以有效减少生成文本中的毒性内容,提高生成文本的安全性和可靠性。 诱导任意概念:ACT可以引导模型生成包含特定概念的文本,如特定的人物、地点或事件。 提高真实性:通过引导模型生成更真实的文本,提高生成内容的质量和可信度。

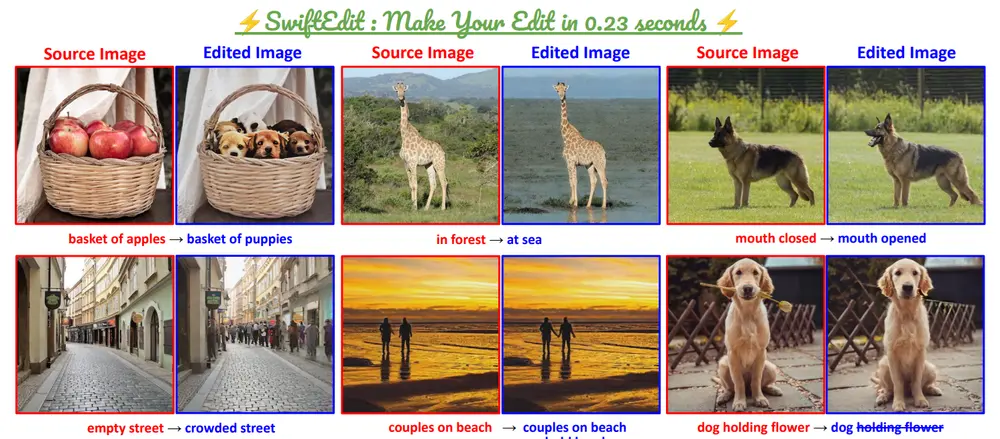

文本到图像扩散模型(T2Is)

细粒度风格控制:ACT可以实现对生成图像风格的细粒度控制,如调整图像的色调、纹理等。 概念否定:通过引导模型避免生成特定的概念或对象,实现对生成内容的精确控制。

实验方法

数据准备:收集包含特定概念或行为的数据集,用于训练和评估模型。 模型训练:使用预训练的大语言模型和文本到图像扩散模型进行实验。 激活传输:应用ACT框架,提取和传输中间层的激活。 结果评估:通过人工评估和自动指标(如BLEU、FID等)评估生成内容的质量和可控性。

结果分析

LLMs:实验结果显示,ACT能够显著减少生成文本中的毒性内容,提高生成文本的真实性和多样性。 T2Is:实验结果显示,ACT能够实现对生成图像风格的细粒度控制,并有效避免生成特定的概念或对象。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...