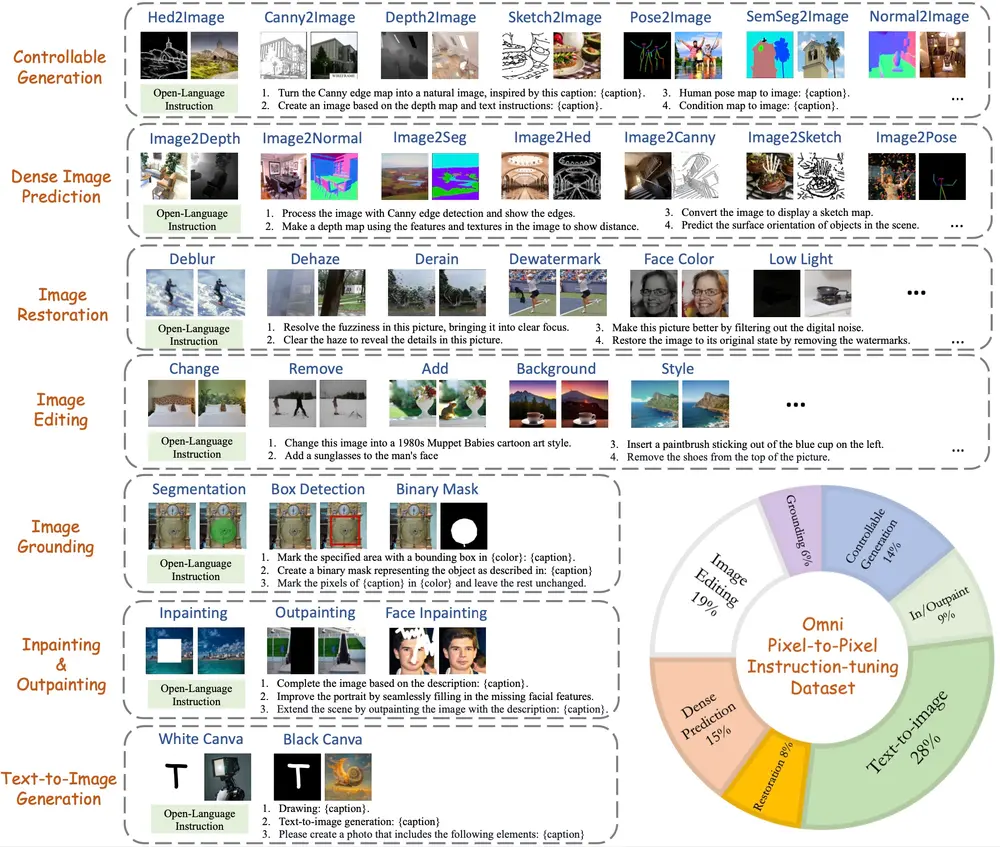

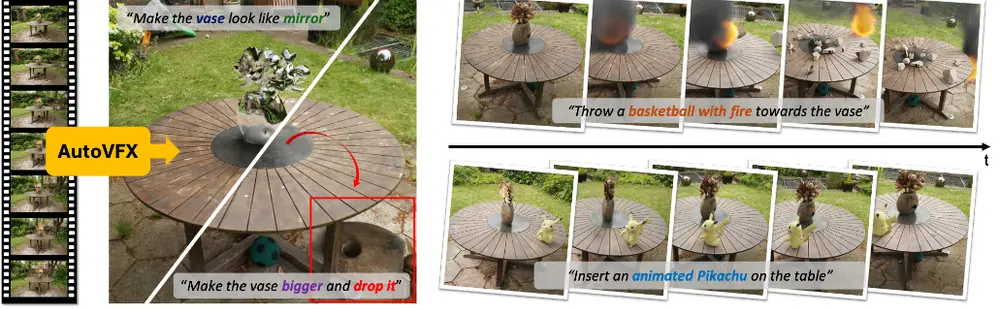

现代视觉效果(VFX)软件使熟练的艺术家能够创造出几乎任何图像,但创作过程仍然费力、复杂,并且对普通用户来说基本上是不可访问的。为了简化这一过程,伊利诺伊大学厄巴纳-香槟分校的研究人员提出了AutoVFX,这是一个框架,能够根据单个视频和自然语言指令自动创建逼真且动态的VFX视频。

AutoVFX框架

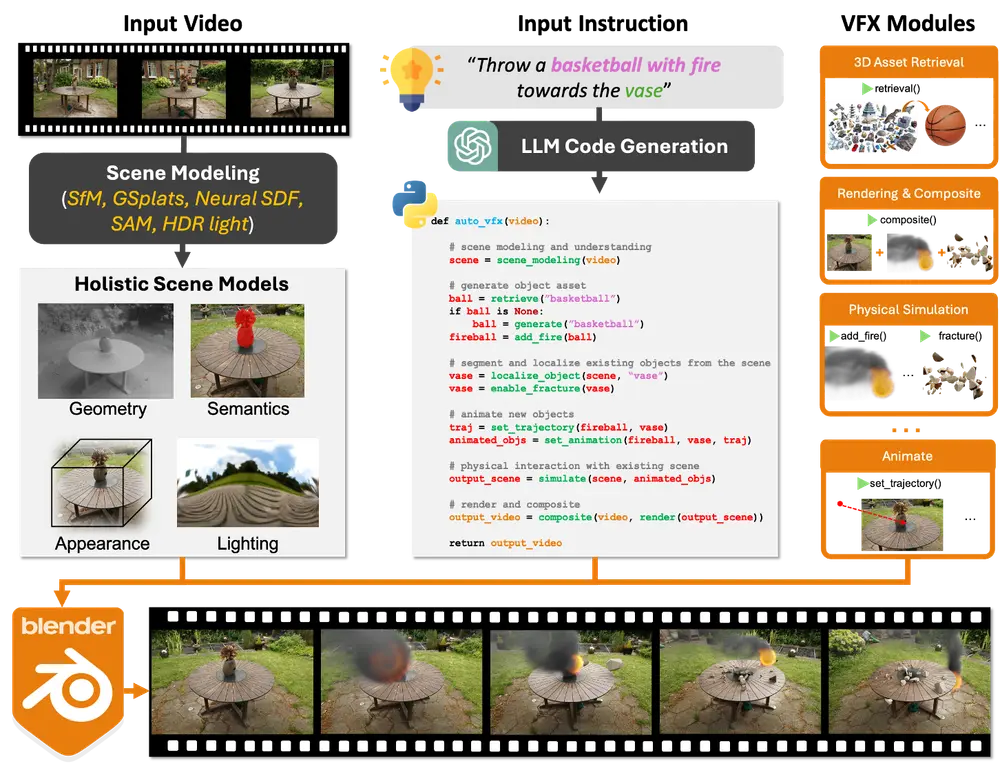

AutoVFX通过精心整合神经场景建模、基于大语言模型(LLM)的代码生成和物理模拟,实现了基于物理的、逼真的编辑效果,这些效果可以直接使用自然语言指令进行控制。例如,用户想要在一个视频中“让花瓶看起来像镜子一样”,并“让一个篮球着火并向花瓶投掷”。AutoVFX能够理解这些自然语言指令,并自动生成相应的程序来实现这些视觉效果,最终渲染出一个新的视频,其中包含了用户指定的特效和动态交互。

关键组件

1、神经场景建模:

场景理解:使用深度学习模型对输入视频进行场景理解和分割,提取场景中的对象和背景信息。 三维重建:通过神经渲染技术,将二维视频帧转换为三维场景模型,为后续的物理模拟和编辑提供基础。

2、基于LLM的代码生成:

自然语言解析:使用大型语言模型(如BERT、GPT等)解析用户的自然语言指令,将其转化为具体的编辑操作。 代码生成:根据解析的指令,生成相应的代码片段,用于执行特定的VFX编辑操作。

3、物理模拟:

物理引擎:集成物理模拟引擎,如PhysX,用于模拟真实世界的物理现象,如物体运动、碰撞和流体动力学。 动态效果:通过物理模拟生成动态效果,如爆炸、火焰和水流,使其更加逼真和自然。

功能特点

自然语言控制:用户可以通过简单的自然语言指令控制VFX编辑过程,无需专业知识。 逼真效果:生成的VFX效果基于物理模拟,具有高度的逼真性和动态性。 编辑多样性:支持多种类型的VFX编辑,如添加特效、删除对象、修改背景等。 物理合理性:生成的效果符合物理规律,确保编辑的合理性和一致性。

工作原理:

3D场景建模:使用多种3D视觉方法从输入视频中估计场景的几何、外观和语义信息。 LLM代码生成:基于用户提供的自然语言指令,利用LLM生成调用预定义编辑函数的程序代码。 物理模拟与渲染:执行生成的代码,利用物理模拟引擎进行动态交互的模拟,并通过渲染引擎生成最终的视频内容。 视频合成:将模拟结果与原始视频合成,输出最终的特效视频。

实验验证

研究人员进行了广泛的实验,以验证AutoVFX在各种视频和指令中的有效性。实验结果表明,AutoVFX在以下几个方面大幅优于所有竞争方法:

生成质量:生成的VFX效果具有高分辨率和高保真度,细节丰富且逼真。 指令对齐:生成的效果与用户提供的自然语言指令高度一致,能够准确反映用户的意图。 编辑多样性:支持多种类型的VFX编辑操作,能够满足不同用户的需求。 物理合理性:生成的效果符合物理规律,确保编辑的合理性和一致性。

定量和定性结果

定量结果:通过客观指标(如PSNR、SSIM等)评估生成效果的质量,AutoVFX在多个指标上均优于竞争方法。 定性结果:通过用户调查和专家评审,AutoVFX生成的效果获得了高度评价,用户普遍认为其效果逼真且自然。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...