腾讯PCG、上海人工智能实验室、南洋理工大学S-Lab和清华大学的研究人员推出3D纹理生成框架MVPaint,它能够根据文本指令自动生成高分辨率、无缝的3D纹理。MVPaint通过同步多视图扩散模型来实现3D纹理的生成,特别强调了多视图一致性,并减少了对UV展开质量的依赖。

例如,你有一个3D模型,比如一个独角兽,你想要给它添加“火焰图案”的纹理。使用MVPaint,你只需提供一个文本指令,比如“火焰图案”,MVPaint就能自动生成一个多视图一致的、无缝的火焰纹理,并应用到独角兽模型上。

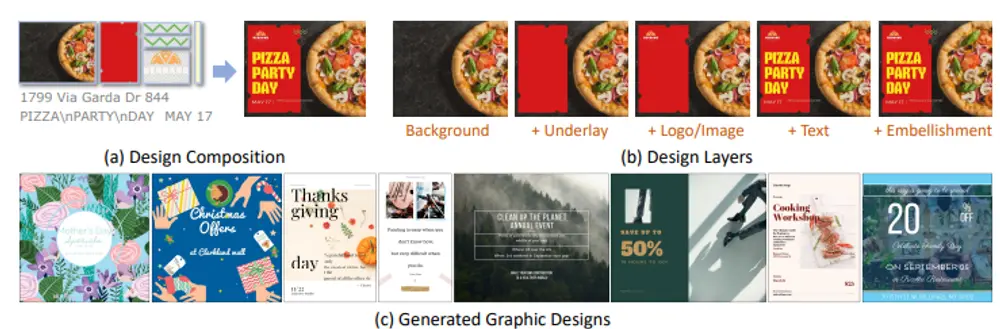

MVPaint框架

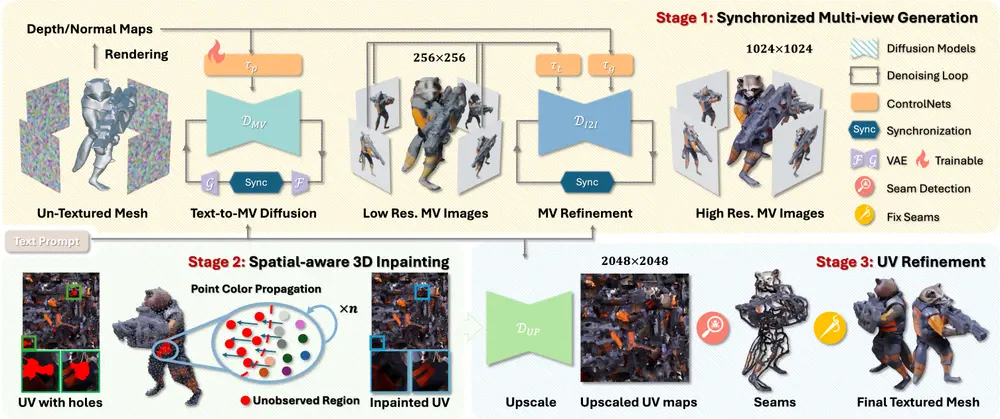

MVPaint主要由三个关键模块组成,旨在生成高分辨率、无缝的纹理,同时强调多视图一致性:

同步多视图生成(SMG):

- 功能:给定一个3D网格模型,MVPaint首先通过采用SMG模型同时生成多视图图像,这导致粗略的纹理化结果。

- 挑战:由于缺少观察,生成的纹理可能存在未绘制的部分。

空间感知3D修复(S3I):

- 功能:为了确保完整的3D纹理化,MVPaint引入了S3I方法,专门设计用于有效纹理化先前未观察到的区域。

- 方法:S3I利用空间感知技术,通过分析已有的纹理信息来填补未绘制的部分,确保纹理的完整性和一致性。

UV优化(UVR):

- 功能:MVPaint采用UVR模块在UV空间中提高纹理质量。

- 步骤:

- UV空间超分辨率:通过超分辨率技术提高UV空间中的纹理分辨率。

- 空间感知接缝平滑算法:应用空间感知接缝平滑算法,修正由UV展开引起的空间纹理不连续性,确保纹理的平滑和无缝。

主要特点:

- 多视图一致性:确保从不同视角观察时纹理的一致性,避免局部风格不连续和接缝问题。

- 高生成多样性:能够根据文本指令生成具有高度细节和多样性的纹理。

- 减少对UV展开的依赖:不依赖于UV展开的结果,提高了纹理生成的鲁棒性。

工作原理:

- 同步多视图生成(SMG):使用多视图扩散模型和交叉注意力机制,从文本指令出发,同步生成多视图图像。

- 空间感知3D修复(S3I):在3D空间中对未覆盖区域进行修复,通过3D点云上的颜色传播算法来填充未观察到的区域。

- UV细化(UVR):首先在UV空间中对纹理进行超分辨率处理,然后通过空间感知的接缝平滑算法修复由UV展开引起的纹理不连续性。

评估基准

为了评估MVPaint的性能,研究人员基于Objaverse数据集和整个GSO数据集中的选定高质量3D网格,建立了两个T2T评估基准:

- Objaverse T2T基准:基于Objaverse数据集,涵盖多种3D对象类别。

- GSO T2T基准:基于GSO数据集,包含更多种类的高质量3D网格。

实验结果

广泛的实验结果表明,MVPaint在多个方面超越了现有的最先进方法:

- 高保真纹理:MVPaint能够生成高保真纹理,细节丰富且逼真。

- Janus问题最小化:MVPaint有效减少了Janus问题,即不同视角下的纹理不一致问题。

- 跨视图一致性:MVPaint显著增强了跨视图一致性,确保从不同视角观察时纹理的一致性和连贯性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...