加州大学伯克利分校、麻省理工学院、英伟达和清华大学的研究人员推出一个用于加速DiT架构模型的无需训练训练框架Sparse VideoGen(SVG),通过利用三维全注意力(3D full attention)中的稀疏性,显著提高了视频生成的推理效率,同时保持了生成视频的高质量。

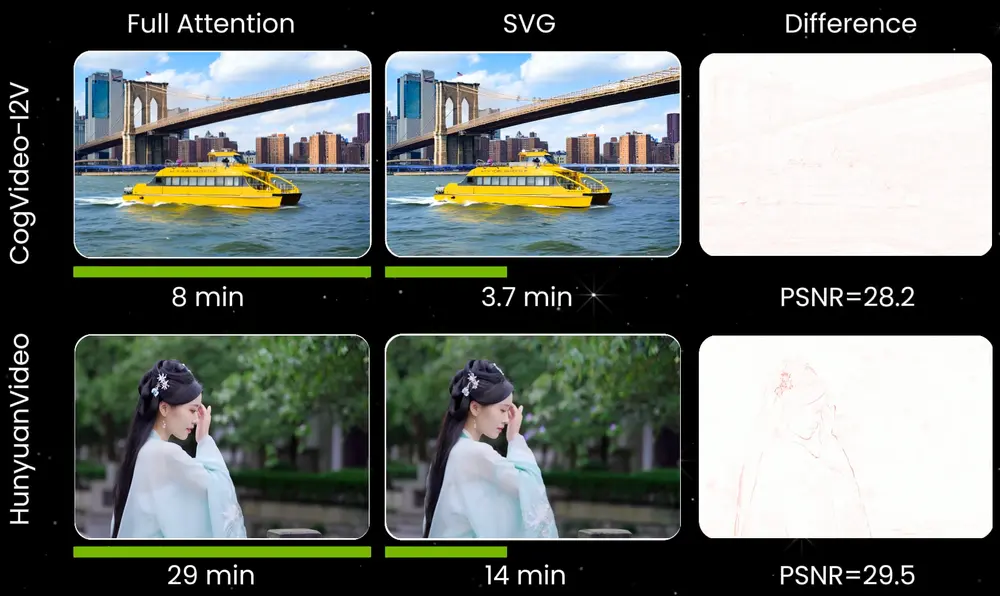

视频扩散模型(如CogVideoX和HunyuanVideo)在生成高质量视频方面表现出色,但其计算成本极高。例如,HunyuanVideo在高性能GPU上生成5秒视频需要近1小时,其中超过80%的时间用于3D全注意力计算。SVG通过识别和利用这种注意力的稀疏性,将生成时间大幅缩短至原来的1/2到1/3,同时保持了高保真度的视频输出。

主要功能

- 加速视频生成:SVG通过稀疏注意力机制,显著减少了计算量,将视频生成速度提升2.28倍至2.33倍。

- 保持高质量输出:在加速的同时,SVG保持了高PSNR(峰值信噪比)和SSIM(结构相似性)值,确保生成视频的视觉质量。

- 硬件友好:SVG通过硬件高效的张量布局转换和定制化内核实现,确保稀疏模式能够高效利用GPU等硬件加速器。

- 与量化技术兼容:SVG支持FP8量化,进一步提升效率,同时几乎不损失生成质量。

主要特点

- 稀疏注意力模式:SVG揭示了视频扩散模型中两种固有的稀疏注意力模式:空间头(Spatial Head)和时间头(Temporal Head)。空间头关注同一帧内的空间相关性,而时间头关注跨帧的时间相关性。

- 在线稀疏性识别:SVG通过在线分析少量样本(如1%的输入行),动态识别每个注意力头的最佳稀疏模式,避免了全注意力计算的开销。

- 硬件高效的布局转换:SVG通过将时间头的稀疏模式转换为硬件友好的连续布局,解决了硬件加速器对连续数据的要求,从而实现理论上的加速效果。

- 定制化内核实现:SVG通过Triton和FlashInfer等工具实现高效的稀疏注意力计算,显著提升了系统性能。

工作原理

SVG的工作原理可以分为以下几个关键步骤:

- 稀疏模式识别:SVG通过在线分析少量输入样本,动态分类每个注意力头为空间头或时间头。通过比较稀疏模式与全注意力的误差,选择误差最小的稀疏模式。

- 稀疏注意力计算:对于空间头,SVG仅计算同一帧内的注意力;对于时间头,SVG仅计算跨帧的相同位置的注意力。这种稀疏计算显著减少了计算量。

- 硬件布局转换:SVG将时间头的稀疏模式从非连续布局转换为连续布局,使其能够高效利用硬件加速器(如GPU的Tensor Core)。

- 定制化内核优化:SVG通过Triton和FlashInfer实现高效的稀疏注意力内核,进一步提升计算效率。

应用场景

- 视频内容生成:SVG可以用于快速生成高质量的视频内容,如动画、广告、虚拟现实等,显著减少生成时间和计算成本。

- 实时视频编辑:SVG的高效性使其适用于实时视频编辑场景,如直播、视频会议等,能够快速响应用户指令并生成高质量视频。

- 视频特效制作:SVG可以用于生成复杂的视频特效,如物体交互、场景变化等,同时保持高保真度和高效率。

- 视频生成服务:SVG可以集成到云服务中,为用户提供快速、高质量的视频生成解决方案,降低硬件需求和运营成本。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...