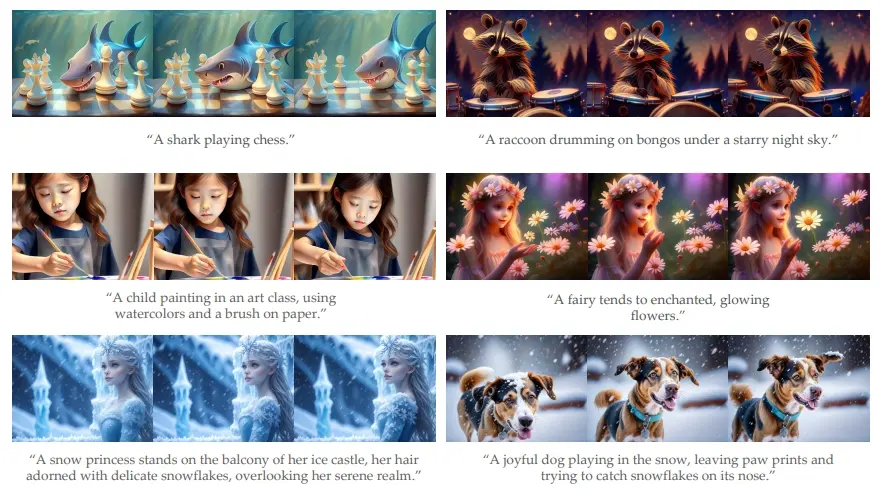

卡内基梅隆大学的研究人员推出奖励模型(一种基于偏好学习的方法)VADER,来指导视频生成过程,从而让模型更有效地学习如何生成符合特定要求的视频。例如,你想要生成一段描述“一只穿着红色外套、拿着雪球的浣熊”的视频。使用传统的视频生成模型可能无法准确捕捉到这些细节。但通过这篇论文中的方法,你可以用奖励模型来指导视频生成过程,确保生成的视频不仅文本描述一致,而且具有艺术性和时间上的连贯性。

主要功能:

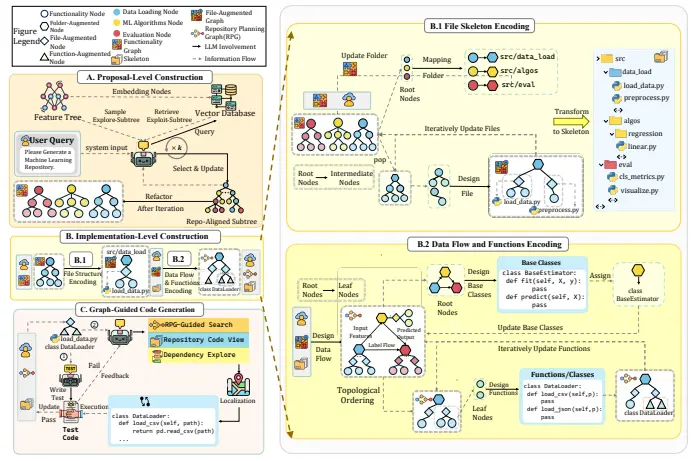

- 利用奖励模型来指导和调整视频扩散模型,使其生成的视频更符合特定的美学标准和文本-图像对齐要求。

主要特点:

- 样本和计算效率:与以往的方法相比,这种方法在样本使用和计算资源上更为高效。

- 多种奖励模型:支持多种类型的奖励模型,包括图像美学、图像-文本对齐、目标检测等。

- 记忆使用优化:提出了减少内存占用的技术,使得训练过程更加可行。

工作原理:

- 预训练的奖励模型:使用基于视觉识别模型的奖励模型,这些模型可以根据生成的视频像素提供密集的梯度信息。

- 反向扩散过程:通过反向扩散过程,从噪声数据逐步重建原始视频数据。

- 梯度反馈:将奖励模型的梯度信息反馈到视频扩散模型中,以此来调整模型权重,使生成的视频更符合奖励函数的要求。

具体应用场景:

- 电影制作:生成符合剧本描述的视频片段。

- 创意故事板:根据故事板快速生成视频草图。

- 按需娱乐:为用户定制个性化的视频内容。

- AR/VR内容生成:为增强现实和虚拟现实应用创造沉浸式视频体验。

- 机器人规划:生成模拟机器人行动的视频,以辅助规划和决策。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...