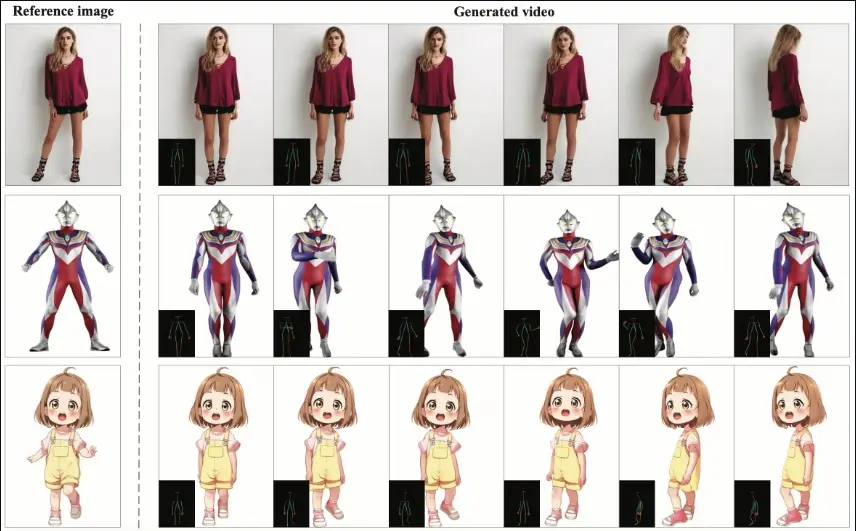

华中科技大学、 阿里巴巴和中国科学技术大学的研究人员推出创新框架UniAnimate,它专门用于生成高质量、时间连贯的人类图像动画视频。UniAnimate通过结合统一的视频扩散模型、统一的噪声输入和时间Mamba(一种状态空间模型),解决了现有方法在外观对齐方面的限制,提高了视频生成的质量和效率。

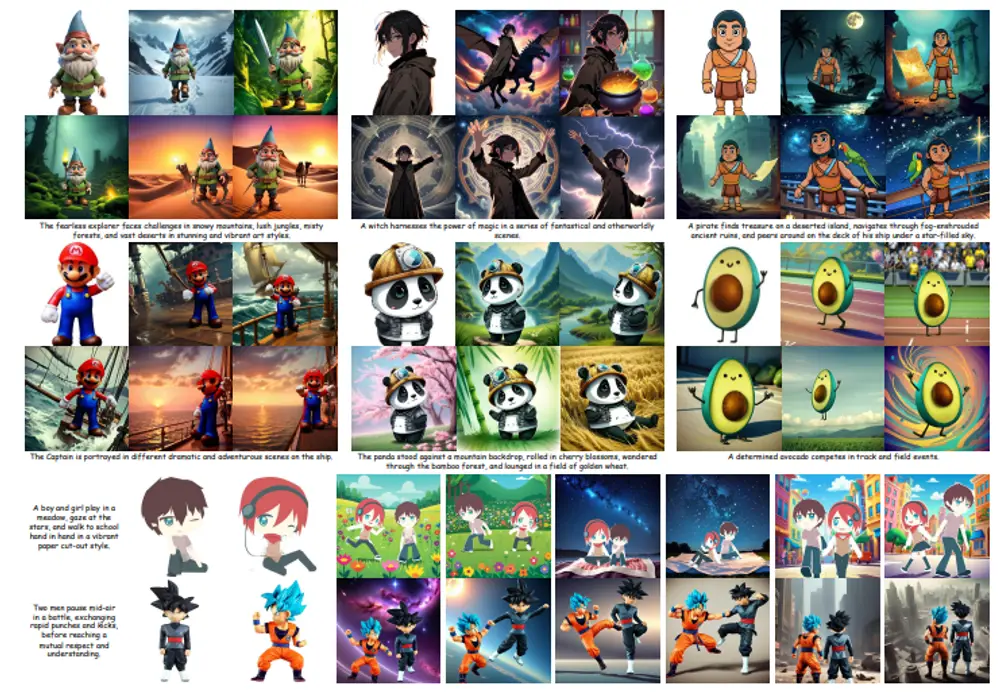

例如,你是一名电影制作人,需要为一部科幻电影制作复杂的角色动画。使用UniAnimate,你可以上传角色的设计图和目标姿势序列,然后系统会自动生成一系列动画帧,这些帧不仅在视觉上与设计图保持一致,而且动作流畅自然。这样,你就能得到一个高质量的动画角色,而无需投入大量的时间和资源进行传统的关键帧动画制作。

主要功能和特点:

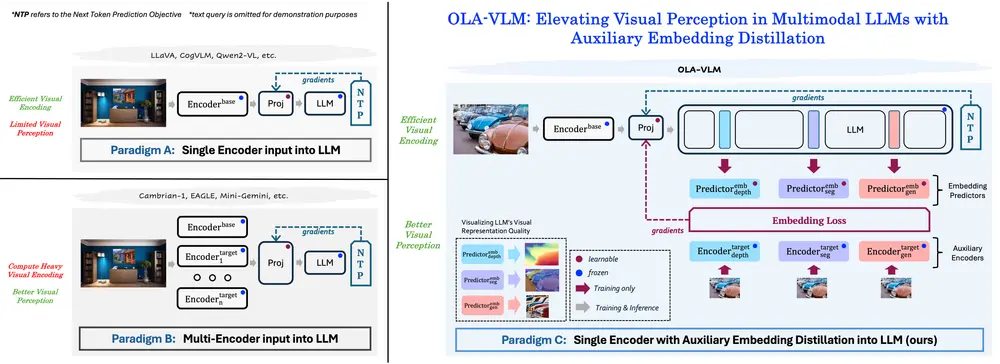

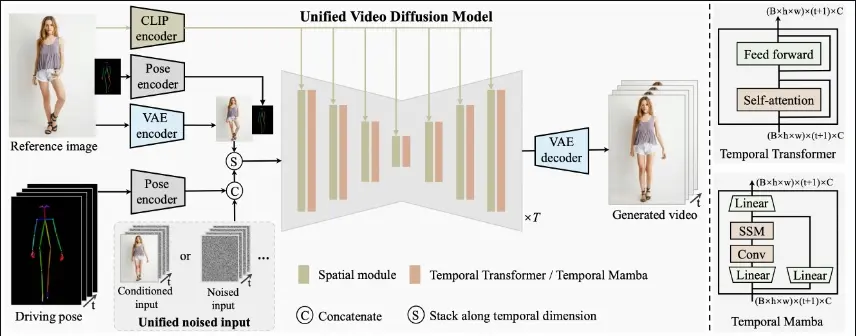

- 统一视频扩散模型:UniAnimate使用一个统一的模型来处理参考图像和噪声视频,这有助于在特征空间中进行外观对齐和运动建模。

- 统一噪声输入:框架支持随机噪声输入以及首帧条件输入,增强了生成长期视频的能力。

- 时间Mamba:作为时间建模的替代方案,时间Mamba能够高效处理长序列数据,显著提高了效率。

- 高质量的视频生成:UniAnimate能够生成高保真度、时间连贯的视频,即使在迭代使用首帧条件策略的情况下也能产生高度一致的一分钟视频。

工作原理:

UniAnimate的工作流程如下:创新框架

- 使用CLIP编码器和VAE编码器提取给定参考图像的潜在特征。

- 将参考姿势的表示融入最终的参考指导中,以帮助学习参考图像中的人体结构。

- 使用姿势编码器对目标驱动姿势序列进行编码,并将其与噪声输入沿通道维度进行连接。

- 将连接的噪声输入与参考指导沿时间维度堆叠,并输入到统一视频扩散模型中以去除噪声。

- 在统一视频扩散模型中,时间模块可以是时间Transformer或时间Mamba。

- 最后,使用VAE解码器将生成的潜在视频映射到像素空间。

具体应用场景:

- 角色动画制作:在电影、电视和视频游戏产业中,UniAnimate可以用来快速生成角色动画,减少传统动画制作的时间和成本。

- 虚拟现实和增强现实:在VR和AR应用中,UniAnimate可以生成与用户互动的角色动画,提供更加逼真的体验。

- 社交媒体和娱乐:用户可以利用UniAnimate创建个性化的动态头像或角色,用于社交媒体平台或娱乐内容。

- 教育和培训:UniAnimate可以生成教学视频中的虚拟讲师或示范动作,提高学习材料的吸引力和效果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...