英伟达和阿尔托大学的研究人员推出Autoguidance,改进图像生成扩散模型的性能,特别是通过一种新颖的方法来控制图像质量、结果的变化性以及与给定条件(如类别标签或文本提示)的一致性。扩散模型是一种生成合成图像的方法,它通过逐步去噪来从纯噪声中恢复图像。这个过程需要一个神经网络来实现去噪器,也就是所谓的分数函数。

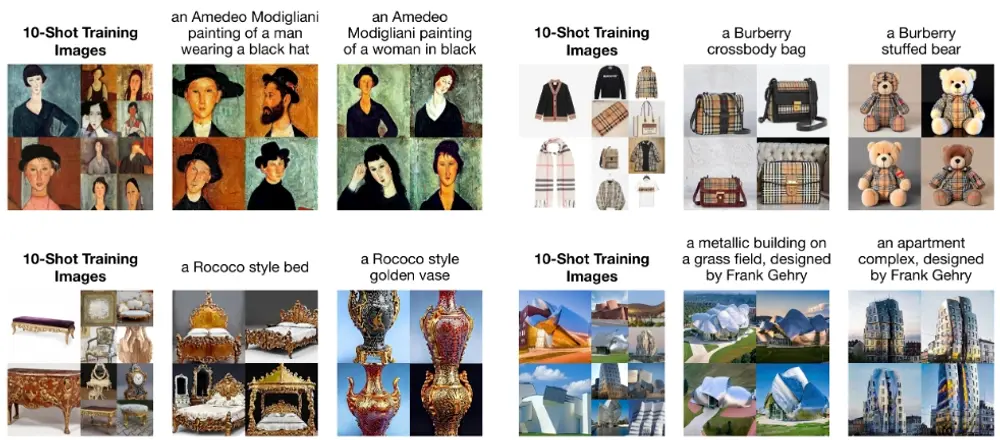

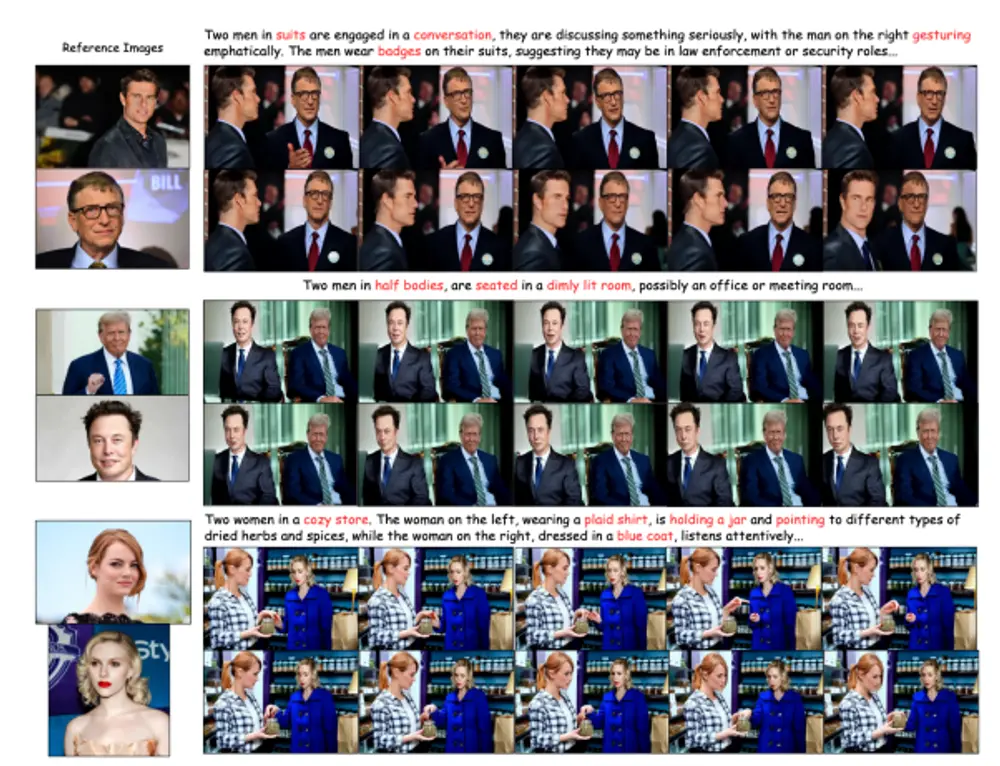

在图像生成的扩散模型中,主要关注的轴是图像质量、结果的变化量以及结果与给定条件的匹配程度,例如类标签或文本提示。流行的无监督指导方法使用一个无条件模型来指导一个条件模型,从而同时提高了对提示的对齐度和图像质量,但可能会导致变化量的减少。这些效果似乎是相互联系的,因此难以控制。研究人员意外地发现,通过使用模型自身的一个较小、较少训练的版本来进行指导,而不是使用无条件模型,可以同时获得关于图像质量的控制,而不牺牲变化量。这导致了在ImageNet上的重大改进,分别为64×64和512×512设定了记录FID,即1.01和1.25,使用的是公共网络。此外,该方法也适用于无条件的扩散模型,可以显著提高其质量。

例如,你想要生成一系列描绘“海滩日落”的图像。使用传统的扩散模型,可能生成的图像质量参差不齐,有些可能非常逼真,而有些则可能包含不真实的元素。通过使用论文中提出的自引导方法,可以在保持图像多样性的同时,提高整体图像质量,生成一系列既逼真又各具特色的海滩日落图像。

主要功能与特点:

- 图像质量控制:通过一种称为自引导(autoguidance)的方法,可以在不减少图像变化性的情况下,提高图像质量。

- 变化性保持:与流行的无分类器引导方法(CFG)不同,自引导能够同时提供高质量的图像和丰富的变化性。

- 与条件对齐:该方法能够生成与给定条件(如文本提示或类别标签)更好地对齐的图像。

工作原理:

- 自引导(Autoguidance):该方法使用一个较小、训练程度较低的模型版本作为引导模型,而不是使用一个无条件模型。这个引导模型可以通过限制模型容量和/或训练时间来获得。

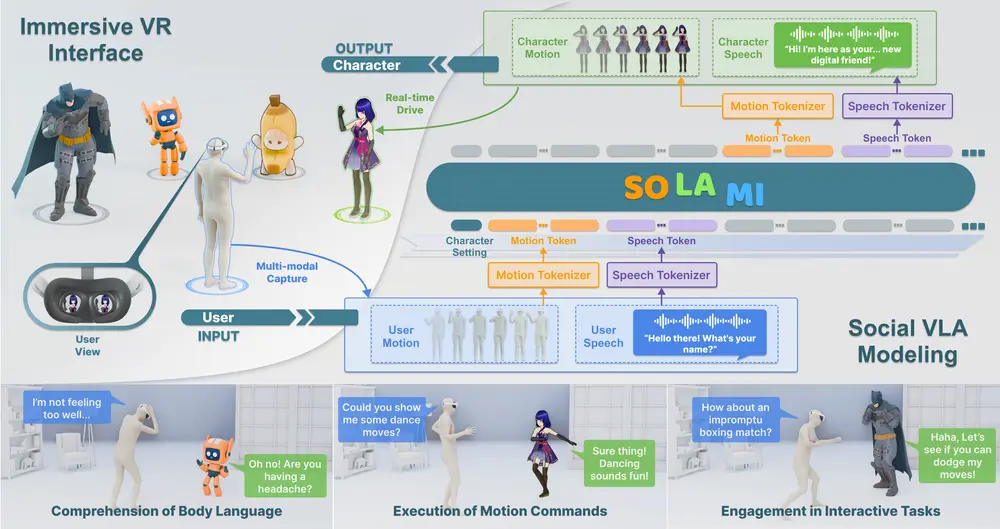

- 去噪扩散:扩散模型通过迭代去噪一个纯白噪声样本来生成样本,逐步揭示出无噪声的随机数据样本。

- 条件去噪:去噪器通常根据类别标签、文本提示等条件输入来控制输出图像。

具体应用场景:

- 图像合成:在需要生成高质量和多样化图像的应用中,如艺术创作、游戏设计、虚拟现实等。

- 文本到图像的转换:在需要根据文本描述生成图像的场景,如自动内容创作、辅助设计等。

- 无条件图像生成:在不需要特定条件输入,而需要生成高质量图像的场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...