在当前主流的“代理式搜索”(Agentic Search)系统中,大型语言模型(LLM)通常通过调用外部搜索引擎(如 Google、Bing 或专用 API)来获取实时信息,以回答复杂问题。这一模式虽有效,但存在明显瓶颈:

- 每次推理成本高

- 训练过程依赖真实搜索反馈,耗时且不稳定

- 难以规模化用于离线或低资源场景

为解决这一问题,清华大学、上海交通大学、上海人工智能实验室、伦敦大学学院、中建三局与微信 AI 联合提出 SSRL(Self-Search Reinforcement Learning) ——一种无需访问外部搜索引擎即可训练搜索代理的强化学习框架。

- GitHub:https://github.com/TsinghuaC3I/SSRL

- 模型:https://huggingface.co/collections/TsinghuaC3I/ssrl-6899957a64d4a31f7f43bc88

该方法完全基于模型内部知识进行训练,却能在部署时无缝接入真实搜索引擎,并进一步提升性能。相关论文已被接受,代码已开源。

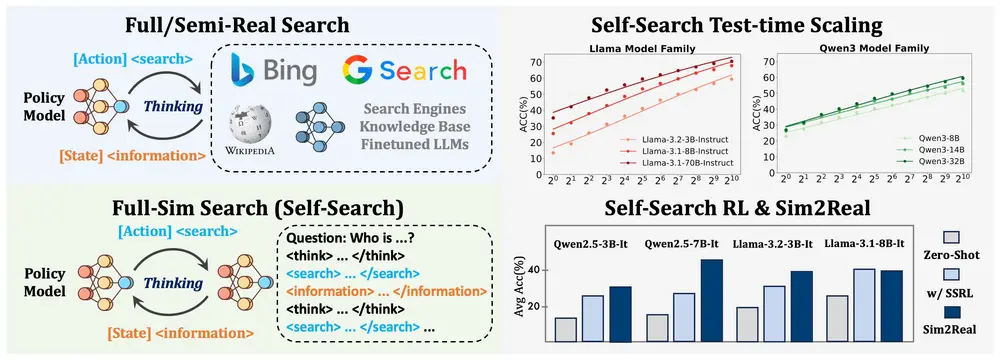

核心思想:用模型自身知识模拟搜索过程

SSRL 的核心突破在于:

将 LLM 本身视为一个“可训练的模拟器”,在不依赖外部数据源的情况下,模拟完整的“查询-检索-推理”流程。

传统方法在训练时需反复调用真实搜索引擎,获取网页结果并评估答案质量,导致:

- 训练成本高昂(API 调用频繁)

- 反馈延迟大

- 数据隐私与稳定性问题

而 SSRL 完全摆脱了这一依赖。它通过以下方式实现“自搜索”能力的构建:

- 结构化推理流程

模型输出遵循统一格式:<think> → <search> → <information> → <answer>

即使没有真正执行搜索,也能模拟出合理的“搜索意图”与“信息整合”过程。 - 内部知识作为“虚拟数据库”

利用 LLM 自身参数中存储的知识,生成高质量的“伪检索结果”,作为强化学习的训练信号。 - 规则驱动的奖励机制

设计格式奖励、信息一致性奖励等,引导模型逐步优化其推理路径,而非简单复制训练数据。

技术实现:三大关键设计

1. 自搜索能力量化

研究发现,即使不连接外部搜索引擎,LLM 在多跳问答任务中仍具备较强的“内在搜索”能力。通过重复采样和结构化提示,团队量化了不同模型在给定推理预算下的表现。

例如,在 Bamboogle 数据集上,Llama-3.1-8B-Instruct 经过 1024 次采样后,准确率达到 87.2%,远超单次生成结果。

这表明:LLM 本身可作为高效的“世界模型”,支持复杂推理任务。

2. 强化学习增强机制

SSRL 通过两个关键技术提升模型的自搜索能力:

- 信息掩码(Information Masking)

在训练过程中,对生成的<information>段落进行部分遮蔽,迫使模型不能直接复用已有信息,而必须进行推理补全。 - 格式与逻辑奖励(Format & Logic Reward)

奖励模型输出符合预设结构,并确保各阶段逻辑连贯(如搜索词与信息匹配、信息支持最终答案)。

这些机制共同推动模型从“记忆式回答”向“推理式搜索”演进。

3. 模拟到现实迁移(Sim2Real)

SSRL 在完全离线环境中训练,但部署时可无缝接入真实搜索引擎:

- 训练阶段:使用内部知识模拟搜索结果;

- 推理阶段:替换

<information>来源为真实网页内容; - 模型自动适配,无需微调。

这种“训练-部署解耦”设计,极大提升了系统的灵活性与实用性。

实验结果:性能相当,效率更高

1. 离线自搜索能力领先

在 BrowseComp 和 HotpotQA 等多跳问答基准上,SSRL 训练的模型在无外部搜索条件下,表现优于依赖真实搜索的基线模型。

| 模型 | 数据集 | 准确率 |

|---|---|---|

| SSRL (Llama-3.2-3B) | HotpotQA | 58.4% |

| Search-R1(基线) | HotpotQA | 44.2% |

同时,训练时间减少 5.53 倍,显著降低计算开销。

2. 在线迁移效果显著

将 SSRL 模型接入真实搜索引擎后(Sim2Real 设置),性能进一步提升:

- 在 Bamboogle 上,Llama-3.2-3B-Instruct 准确率从 35.0%(纯内部知识)→ 44.4%(结合外部搜索)

- 表明模型已学会有效利用外部信息,实现“知识融合”

主要优势总结

| 特性 | 说明 |

|---|---|

| 无需外部搜索训练 | 完全基于模型内部知识,降低训练成本与复杂性 |

| 高训练效率 | 无需等待外部 API 响应,训练速度提升数倍 |

| 强泛化能力 | 训练后可无缝接入真实搜索引擎,无需额外调整 |

| 支持离线部署 | 在无网络环境下仍可提供高质量问答服务 |

| 适用于多跳与模糊问题 | 在复杂推理、信息不全等挑战性任务中表现优异 |

应用场景

SSRL 为多种实际需求提供了高效解决方案:

✅ 智能问答系统

构建低延迟、低成本的问答代理,适用于客服、知识库助手等场景。

✅ 多跳推理任务

处理需多步推导的问题(如“谁是2020年奥运会金牌最多的国家的总理?”),无需多次调用搜索接口。

✅ 模糊问题理解

对不完整或歧义提示(如“那个唱歌很好听的男演员”),利用内部知识生成合理解释。

✅ 离线环境支持

适用于车载系统、工业设备、军事通信等无网或受限网络场景。

✅ 代理训练模拟器

为其他 AI 代理提供低成本、高保真的训练环境,加速 agentic system 的研发。

研究意义:从“依赖外部”到“内生能力”

SSRL 的提出,标志着 agentic search 研究的一个重要转向:

不再将 LLM 视为“搜索引擎的使用者”,而是将其本身作为“可训练的搜索引擎模拟器”。

这不仅降低了训练门槛,更揭示了一个深层趋势:

大型语言模型正在成为通用“认知引擎”,其内部知识足以支撑复杂的决策与推理流程。

未来,这类“自包含式推理”能力或将成为智能代理的基础组件,在边缘计算、隐私保护和自主系统中发挥关键作用。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)