本周一,OpenAI发布了全新的模型系列——GPT-4.1,包括GPT-4.1、GPT-4.1 mini和GPT-4.1 nano。这些模型在编程和指令遵循方面表现出色,标志着OpenAI在打造“代理型软件工程师”目标上迈出了重要一步。

GPT-4.1的核心亮点

1. 更强的编程能力

OpenAI表示,GPT-4.1在开发者关心的关键领域得到了显著优化:

前端编码:生成更高质量的前端代码,减少不必要的编辑。 格式一致性:可靠地遵循指令中的格式要求,保持输出结构清晰。 工具使用:更精准地调用外部工具,提高开发效率。

根据OpenAI的内部测试,GPT-4.1在SWE-bench等编程基准测试中超越了前代模型GPT-4o和GPT-4o mini。尤其是在代码生成、错误修复和软件工程任务中,GPT-4.1的表现更加出色。

2. 多模态支持

除了文本处理能力,GPT-4.1还在视频内容理解方面表现出色。在Video-MME测试中,该模型在“长视频、无字幕”类别中达到了领先的72%准确率,展示了其对复杂多媒体内容的理解能力。

3. 更高效的变体

为了满足不同场景的需求,OpenAI推出了两个轻量级版本:

GPT-4.1 mini:牺牲少量准确性以换取更高的速度和更低的成本。 GPT-4.1 nano:这是OpenAI目前最快且最便宜的模型,适合资源受限的应用场景。

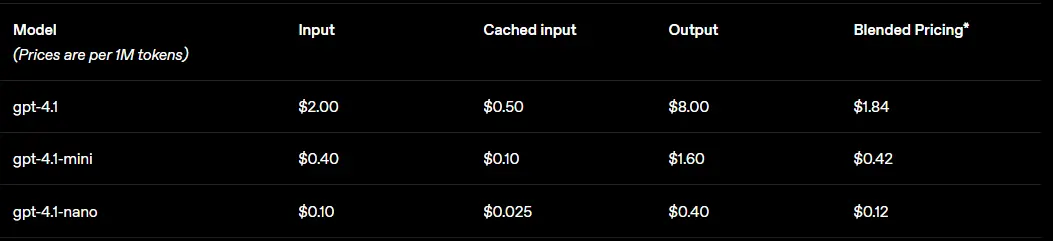

GPT-4.1的定价与性能对比

| 模型 | 输入价格(每百万令牌) | 输出价格(每百万令牌) | 性能特点 |

|---|---|---|---|

| GPT-4.1 | $2 | $8 | 最高性能,适合复杂任务 |

| GPT-4.1 mini | $0.4 | $1.6 | 高效平衡,性价比高 |

| GPT-4.1 nano | $0.1 | $0.4 | 最快、最便宜,适合简单任务 |

从数据来看,GPT-4.1的定价策略延续了OpenAI一贯的分层模式,用户可以根据需求选择不同的模型版本。

官方介绍全文:

在API中引入GPT-4.1

全新GPT模型系列,显著提升了编程、指令遵循和长上下文处理能力,并推出了首款nano模型。

今天,我们在API中推出三款新模型:GPT-4.1、GPT-4.1 mini和GPT-4.1 nano。这些模型在各方面均超越GPT-4o和GPT-4o mini,尤其在编程和指令遵循方面有显著提升。它们支持高达100万个令牌的更大上下文窗口,并提升了长上下文理解能力,知识截止日期更新至2024年6月。

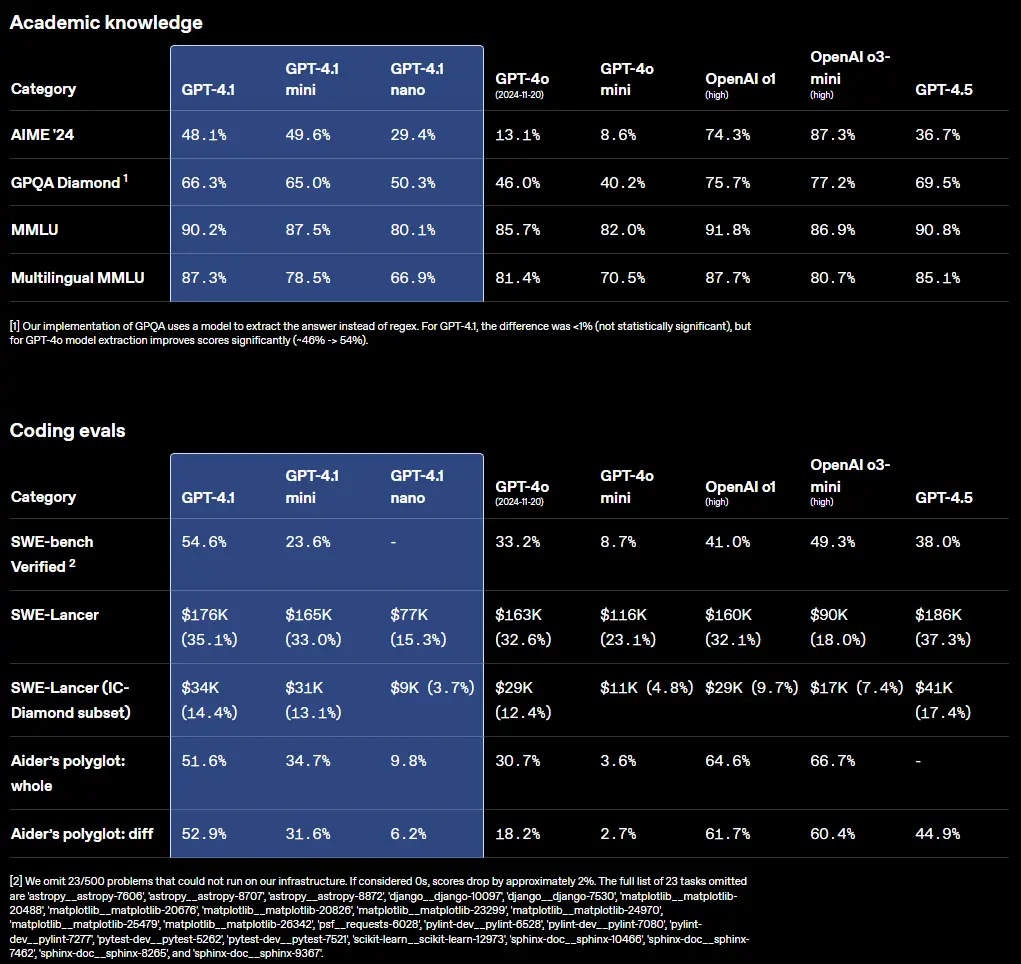

GPT-4.1在以下行业标准测试中表现出色:

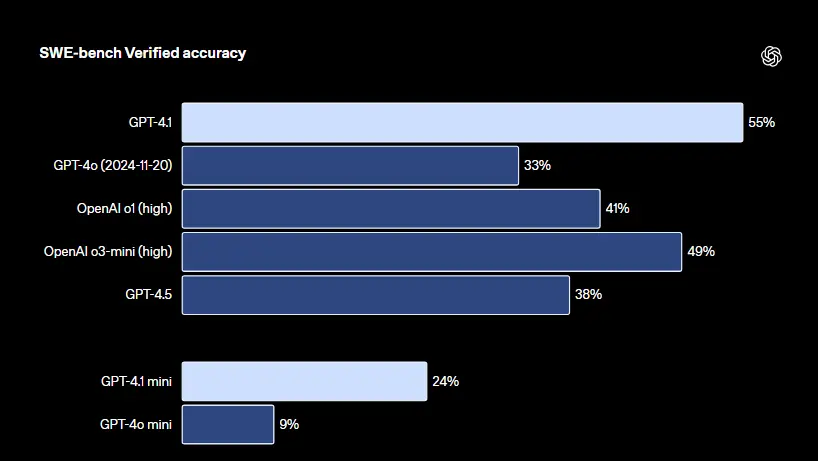

- 编程:GPT-4.1在SWE-bench Verified上得分54.6%,比GPT-4o提升21.4个百分点,比GPT-4.5提升26.6个百分点,成为领先的编程模型。

- 指令遵循:在Scale的MultiChallenge基准测试(衡量指令遵循能力)上,GPT-4.1得分38.3%,比GPT-4o提升10.5个百分点。

- 长上下文:在Video-MME(多模态长上下文理解基准测试)上,GPT-4.1创下新的最佳记录,在长视频无字幕类别中得分72.0%,比GPT-4o提升6.7个百分点。

虽然基准测试提供了有价值的见解,但我们训练这些模型时更注重现实世界的实用性。与开发者社区的密切合作和伙伴关系使我们能够优化这些模型,满足其应用中最重要的任务。

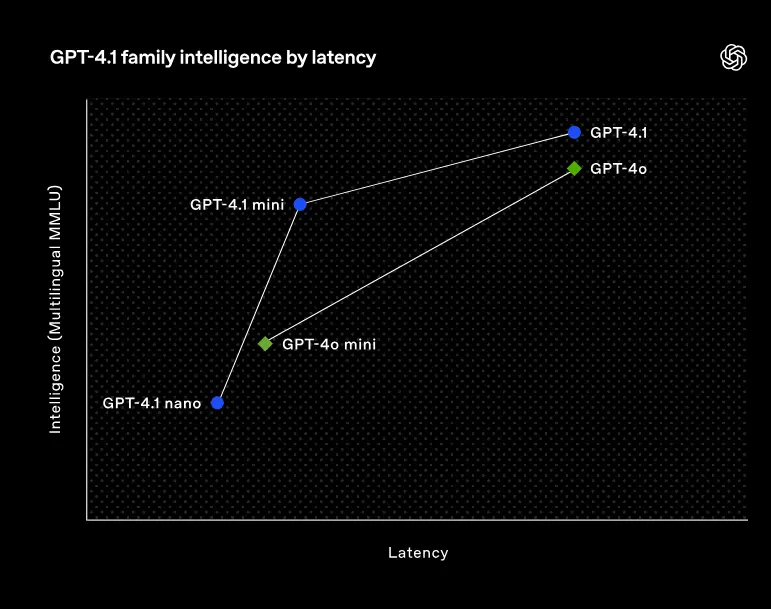

为此,GPT-4.1模型系列以更低的成本提供卓越性能。这些模型在延迟曲线的每个点上都推动了性能的进步。

GPT-4.1 mini在小型模型性能上实现重大飞跃,在许多基准测试中甚至超越GPT-4o。它在智能评估中与GPT-4o相当或更优,同时延迟降低近一半,成本降低83%。

对于需要低延迟的任务,GPT-4.1 nano是我们最快且最便宜的模型。它以小巧的规模提供卓越性能,拥有100万个令牌的上下文窗口,在MMLU上得分80.1%,GPQA上得分50.3%,Aider多语言编码上得分9.8%,甚至高于GPT-4o mini。它非常适合分类或自动补全等任务。

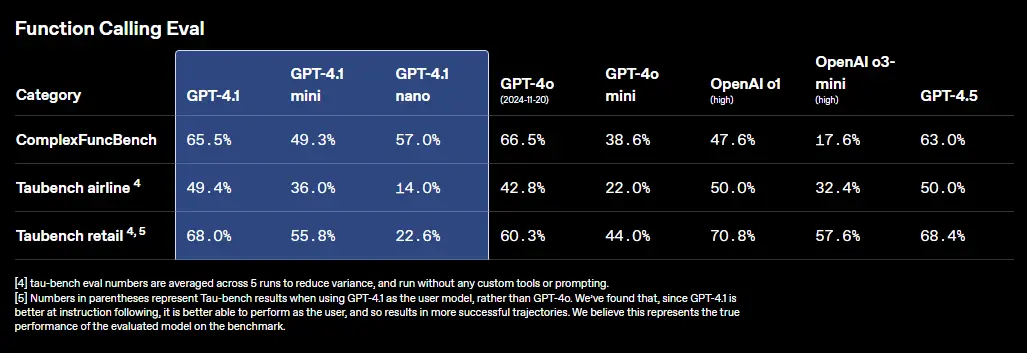

指令遵循可靠性和长上下文理解的改进也使GPT-4.1模型在驱动代理(能够代表用户独立完成任务的系统)方面更加有效。结合Responses API等原语,开发者现在可以构建在现实软件工程、从大型文档中提取见解、最少人工干预解决客户请求以及其他复杂任务中更有用且可靠的代理。

请注意,GPT-4.1仅通过API提供。在ChatGPT中,许多指令遵循、编程和智能方面的改进已逐渐融入最新版本的GPT-4o,我们将在未来版本中继续加入更多改进。

我们还将开始在API中弃用GPT-4.5 Preview,因为GPT-4.1在许多关键功能上提供改进或相似的性能,同时成本和延迟更低。GPT-4.5 Preview将在三个月后(2025年7月14日)关闭,以便开发者有时间过渡。GPT-4.5作为研究预览推出,旨在探索和实验大型计算密集型模型,我们从开发者反馈中学到了很多。我们将继续将开发者赞赏的GPT-4.5的创造力、写作质量、幽默和细腻融入未来的API模型。

以下是我们分解GPT-4.1在多个基准测试中的表现,以及来自Windsurf、Qodo、Hex、Blue J、Thomson Reuters和Carlyle等Alpha测试者的示例,展示其在特定领域生产任务中的表现。

编程

GPT-4.1在多种编程任务中显著优于GPT-4o,包括代理式解决编程任务、前端编码、减少不必要的编辑、可靠遵循差异格式、确保工具使用一致性等。

在SWE-bench Verified(衡量现实世界软件工程技能)上,GPT-4.1完成54.6%的任务,而GPT-4o(2024-11-20)为33.2%。这反映了模型在浏览代码库、完成任务并生成可运行且通过测试的代码方面的能力提升。

对于SWE-bench Verified,模型会获得一个代码仓库和问题描述,并必须生成一个补丁来解决这个问题。性能高度依赖于使用的提示和工具。为了帮助重现和理解我们的结果,我们在这里描述了我们对GPT-4.1的设置。我们的分数省略了500个问题中的23个,这些问题的解决方案无法在我们的基础设施上运行;如果这些问题保守地被评为0,那么54.6%的分数就会变成52%。

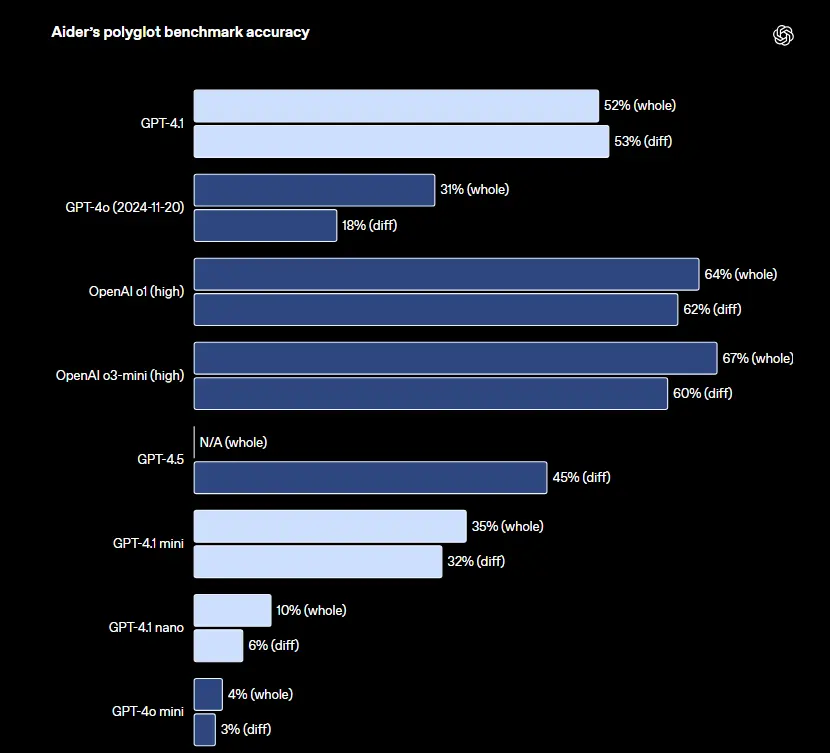

对于希望编辑大型文件的API开发者,GPT-4.1在各种格式的代码差异上更加可靠。GPT-4.1在Aider的多语言差异基准测试中得分比GPT-4o高出一倍以上,甚至比GPT-4.5高8个百分点。这一评估既衡量了多种编程语言的编码能力,也衡量了模型以整体和差异格式生成更改的能力。我们特别训练了GPT-4.1以更可靠地遵循差异格式,这使开发者可以通过仅输出更改的行来节省成本和延迟,而非重写整个文件。为获得最佳代码差异性能,请参阅我们的提示指南。对于偏好重写整个文件的开发者,我们将GPT-4.1的输出令牌限制增加到32,768个(从GPT-4o的16,384个增加)。我们还建议使用预测输出以减少完整文件重写的延迟。

在Aider的多语言基准测试中,模型通过编辑源文件来解决Exercism的编码练习,每次允许重试一次。“完整”格式要求模型重新编写整个文件,这可能会比较耗时且昂贵。“差异”格式要求模型编写一系列搜索/替换代码块。

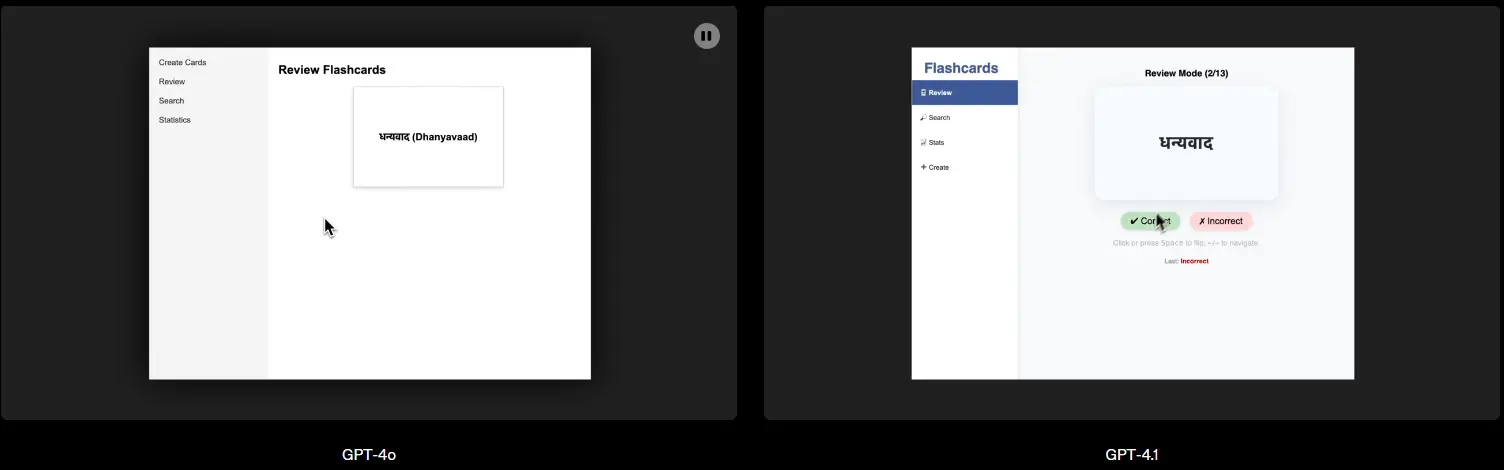

GPT-4.1在前端编码方面也显著优于GPT-4o,能够创建功能更强、美观度更高的Web应用。在我们的面对面比较中,付费人工评分者80%的概率更喜欢GPT-4.1的网站,而非GPT-4o的。

示例提示:制作一个闪卡Web应用。用户应能够创建闪卡、搜索已有闪卡、复习闪卡,并查看闪卡复习统计。预加载十张包含印地语单词或短语及其英文翻译的闪卡。复习界面:在复习界面,点击或按空格键应通过平滑的3D动画翻转闪卡以显示翻译。按箭头键应能在闪卡间导航。搜索界面:搜索栏应在用户输入查询时动态提供结果列表。统计界面:统计页面应显示用户复习闪卡数量的图表,以及答对的百分比。创建闪卡界面:创建闪卡页面应允许用户指定闪卡的正面和背面,并添加到用户集合。所有这些界面都应可在侧边栏访问。生成一个单页React应用(所有样式内联)。

除了上述基准测试外,GPT-4.1在遵循格式方面更加可靠,额外编辑的频率更低。在我们的内部评估中,代码的额外编辑从GPT-4o的9%降至GPT-4.1的2%。

现实世界示例

Windsurf:GPT-4.1在Windsurf的内部编程基准测试中得分比GPT-4o高60%,该基准与代码更改在首次审查中被接受的频率高度相关。用户指出,GPT-4.1在工具调用方面效率提高了30%,重复不必要编辑或以过于狭窄、增量方式阅读代码的可能性降低了约50%。这些改进转化为工程团队的更快迭代和更顺畅的工作流程。

Qodo:Qodo在基于GitHub拉取请求生成高质量代码审查的测试中,将GPT-4.1与其他领先模型进行了面对面比较,方法灵感来源于其微调基准。在200个有意义的现实世界拉取请求中,使用相同的提示和条件,Qodo发现GPT-4.1在55%的案例中提供了更好的建议。特别值得注意的是,GPT-4.1在精确性(知道何时不提供建议)和全面性(在需要时提供详尽分析)方面表现出色,同时专注于真正关键的问题。

指令遵循

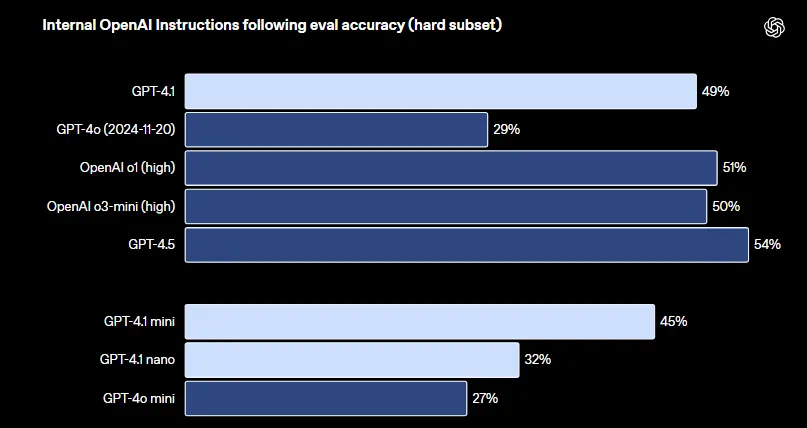

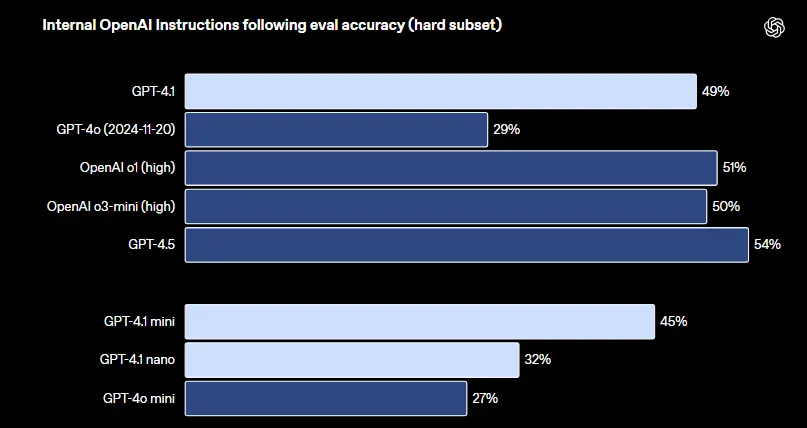

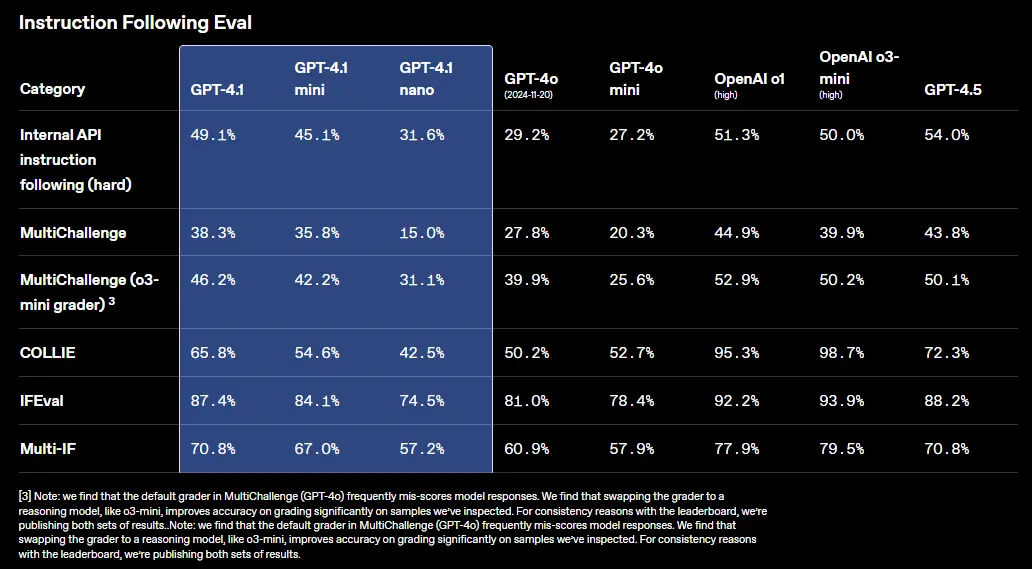

GPT-4.1在指令遵循方面更加可靠,我们在多种指令遵循评估中测量到了显著改进。

我们开发了一个内部指令遵循评估,以跟踪模型在多个维度和几个关键指令遵循类别中的表现,包括:

- 格式遵循:提供指定模型响应自定义格式的指令,例如XML、YAML、Markdown等。

- 否定指令:指定模型应避免的行为。(示例:“不要要求用户联系支持”)

- 有序指令:提供模型必须按给定顺序遵循的一组指令。(示例:“先询问用户名,再询问电子邮件”)

- 内容要求:输出包含特定信息的内容。(示例:“在编写营养计划时始终包含蛋白质含量”)

- 排序:以特定方式排序输出。(示例:“按人口数量排序响应”)

- 过度自信:如果请求的信息不可用或请求不属于给定类别,指示模型说“我不知道”或类似内容。(示例:“如果不知道答案,请提供支持联系电子邮件”)

这些类别是根据开发者关于指令遵循哪些方面对他们最相关和重要的反馈得出的。在每个类别中,我们将提示分为简单、中等和困难。GPT-4.1在困难提示上尤其显著优于GPT-4o。

我们的内部指令遵循评估是基于真实的开发者使用案例和反馈,涵盖了不同复杂度的任务,并提供了有关格式化、冗余度、长度等方面的指导。

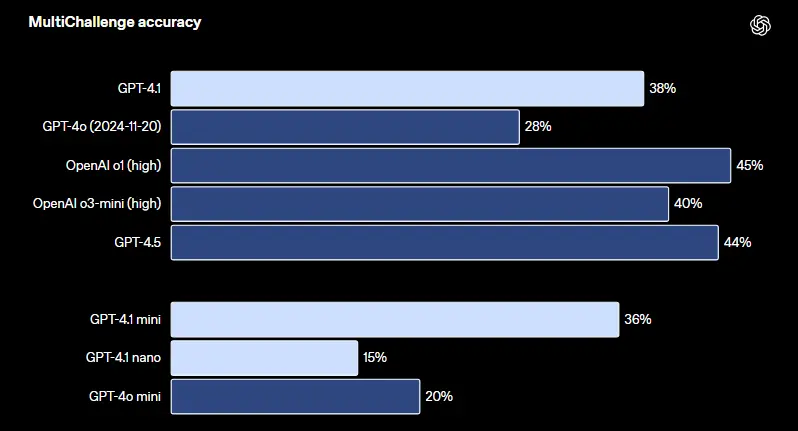

多轮指令遵循对许多开发者至关重要——模型在深入对话中保持连贯性并跟踪用户早先提供的信息非常重要。我们训练了GPT-4.1以更好地从对话历史消息中提取信息,从而实现更自然的对话。Scale的MultiChallenge基准测试是衡量这一能力的有用指标,GPT-4.1比GPT-4o高出10.5个百分点。

在MultiChallenge中,模型需要在多轮对话中正确使用来自先前消息的四种类型的信息。

GPT-4.1在IFEval上的得分也达到87.4%,而GPT-4o为81.0%。IFEval使用带有可验证指令的提示(例如,指定内容长度或避免某些术语或格式)。

在IFEval中,模型必须生成符合各种指令的答案。

更好的指令遵循使现有应用更可靠,并启用因可靠性差而受限的新应用。早期测试者指出,GPT-4.1可能更“字面化”,因此我们建议在提示中明确且具体。有关GPT-4.1提示最佳实践的更多信息,请参阅提示指南。

现实世界示例

Blue J:GPT-4.1在Blue J最具挑战性的现实世界税务场景内部基准测试中准确率比GPT-4o高53%。这一准确率的飞跃——对系统性能和用户满意度至关重要——凸显了GPT-4.1对复杂法规的更好理解以及在长上下文中遵循细致指令的能力。对于Blue J用户,这意味着更快、更可靠的税务研究以及更多用于高价值咨询工作的时间。

Hex:GPT-4.1在Hex最具挑战性的SQL评估集上实现了近2倍的改进,展示了指令遵循和语义理解的显著提升。该模型在从大型、模糊模式中选择正确表时更加可靠——这一上游决策点直接影响整体准确率,且难以仅通过提示调整。对于Hex,这显著减少了手动调试,并加速了生产级工作流程的实现。

长上下文

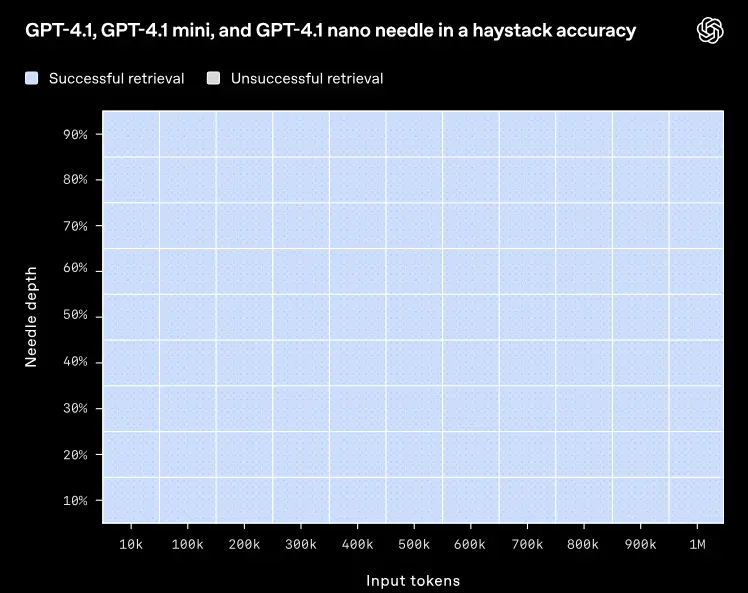

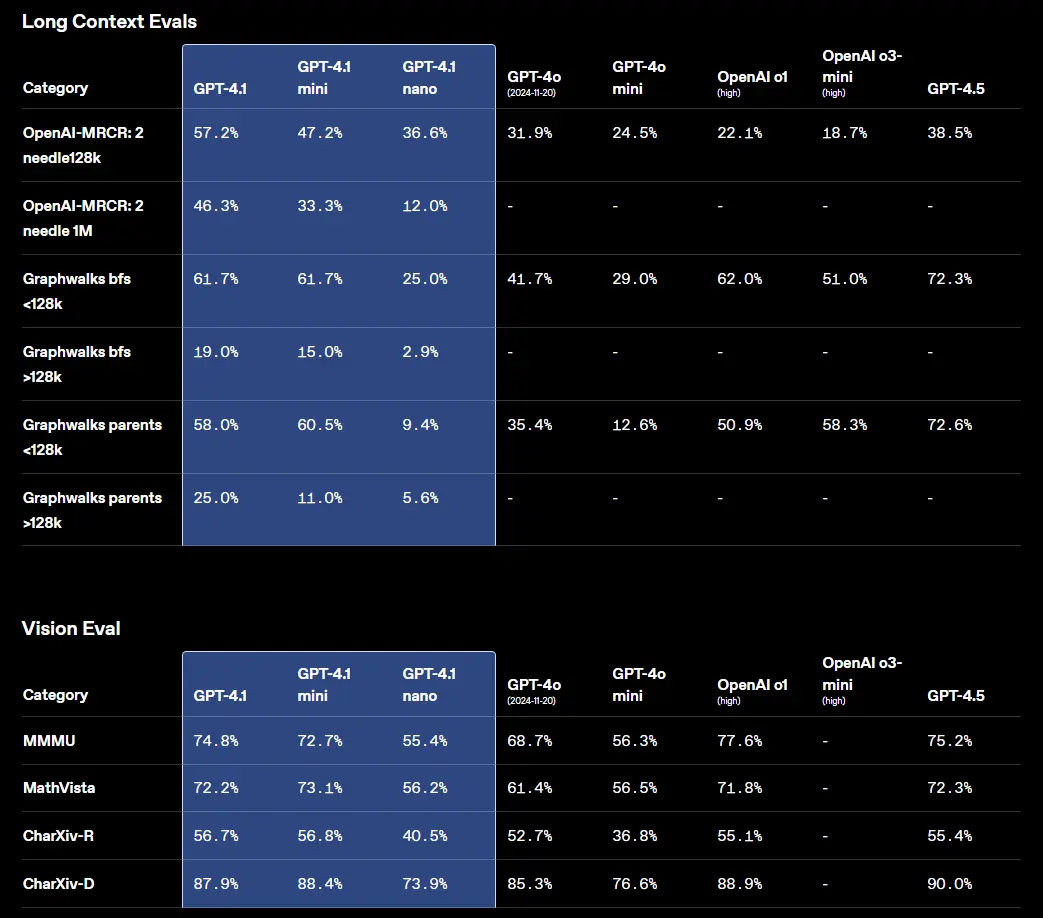

GPT-4.1、GPT-4.1 mini和GPT-4.1 nano可处理高达100万个令牌的上下文——比之前的GPT-4o模型的128,000个令牌大幅提升。100万个令牌相当于React整个代码库的8倍以上,因此长上下文非常适合处理大型代码库或大量长文档。

我们训练了GPT-4.1以可靠地关注整个100万个令牌上下文长度内的信息。我们还训练它在长短上下文长度中比GPT-4o更可靠地注意到相关文本并忽略干扰项。长上下文理解是法律、编程、客户支持等多个领域应用的关键能力。

以下,我们展示了GPT-4.1在上下文窗口不同位置检索小块隐藏信息(“针”)的能力。GPT-4.1在所有位置和所有上下文长度(直至100万个令牌)都能始终准确检索到针。它能有效提取与手头任务相关的细节,无论这些细节在输入中的位置如何。

在我们的内部大海捞针评估中,GPT-4.1、GPT-4.1 mini和GPT 4.1 nano都能够在高达1M的上下文中检索出针。

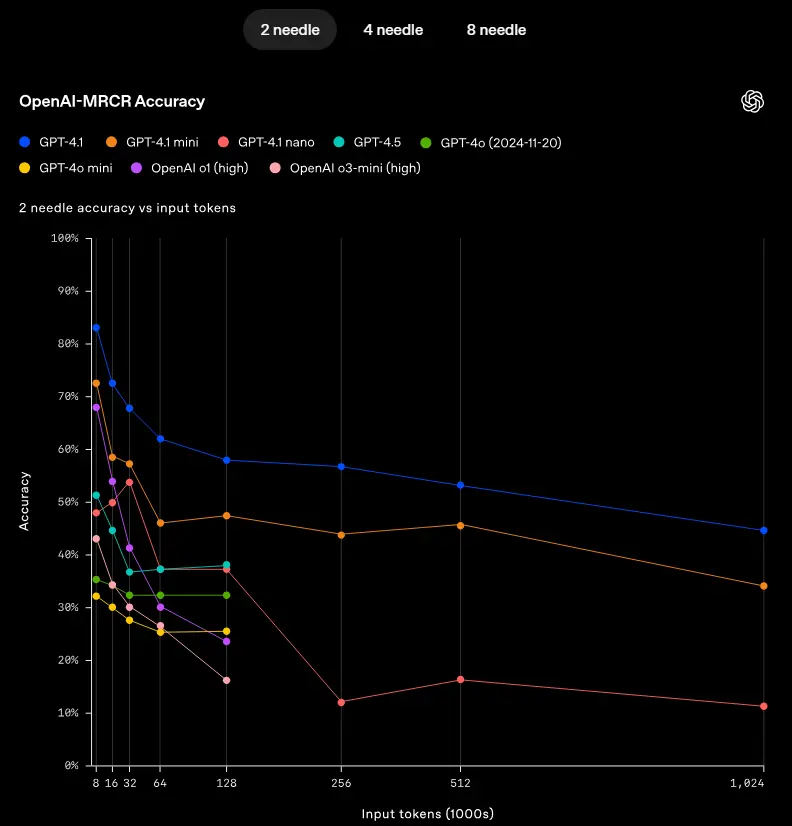

然而,很少有现实世界的任务像检索单一、显而易见的针答案那样简单。我们发现,用户通常需要模型检索并理解多个信息片段,并理解这些片段之间的关系。为展示这一能力,我们开源了一个新评估:OpenAI-MRCR(多轮共指解析)。

OpenAI-MRCR测试模型在上下文中查找和区分多个隐藏针的能力。该评估包括用户与助手之间的多轮合成对话,用户要求撰写关于某个主题的内容,例如“写一首关于貘的诗”或“写一篇关于岩石的博客文章”。我们随后在上下文中插入两到八个相同请求。模型必须检索对应于特定实例的响应(例如,“给我第三首关于貘的诗”)。

挑战在于这些请求与上下文其余部分的相似性——模型很容易被细微差异误导,例如关于貘的短篇小说而非诗,或关于青蛙的诗而非貘。我们发现,GPT-4.1在高达128K令牌的上下文长度中优于GPT-4o,并即使在100万个令牌时仍保持强劲性能。

但这项任务对高级推理模型来说仍很困难。我们分享了评估数据集,以鼓励在现实世界长上下文检索方面的进一步工作。

在 OpenAI-MRCR 中,模型必须回答一个问题,该问题涉及在干扰项中辨别 2 个、4 个或 8 个用户提示。

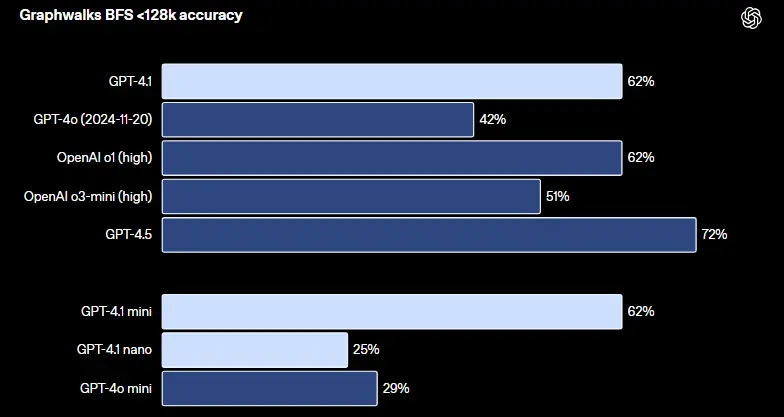

我们还发布了Graphwalks,一个用于评估多跳长上下文推理的数据集。许多开发者的长上下文用例需要上下文中的多次逻辑跳转,例如在编写代码时在多个文件之间跳转,或在回答复杂法律问题时交叉引用文档。

模型(甚至人类)理论上可以通过一次阅读提示解决OpenAI-MRCR问题,但Graphwalks设计为需要跨上下文多个位置的推理,无法按顺序解决。

Graphwalks用十六进制哈希组成的定向图填充上下文窗口,然后要求模型从图中的随机节点开始执行广度优先搜索(BFS),并返回特定深度的所有节点。GPT-4.1在此基准测试中达到61.7%的准确率,与o1相当,远超GPT-4o。

在Graphwalks中,要求模型从一个大图中的随机节点进行广度优先搜索。

基准测试无法完全说明问题,因此我们与Alpha合作伙伴合作,测试了GPT-4.1在其现实世界长上下文任务中的性能。

现实世界示例

Thomson Reuters:Thomson Reuters使用GPT-4.1测试了其专业级AI法律助手CoCounsel。与GPT-4o相比,他们在内部长上下文基准测试中将多文档审查准确率提高了17%——这是CoCounsel处理涉及多个冗长文档的复杂法律工作流程能力的重要指标。特别是,他们发现模型在跨来源保持上下文以及准确识别文档之间细微关系(例如冲突条款或补充上下文)方面非常可靠,这些任务对法律分析和决策至关重要。

Carlyle:Carlyle使用GPT-4.1从多个冗长文档(包括PDF、Excel文件和其他复杂格式)中准确提取细粒度财务数据。根据其内部评估,GPT-4.1在从数据密集的大型文档中检索方面的表现提高了50%,是首个成功克服其他可用模型常见关键限制的模型,包括针在干草堆中检索、中间丢失错误以及跨文档的多跳推理。

除了模型性能和准确性外,开发者还需要快速响应的模型以满足用户需求。我们改进了推理堆栈以减少首个令牌的响应时间,通过提示缓存,您可以进一步降低延迟并节省成本。在我们的初步测试中,GPT-4.1在128,000个令牌上下文下的首个令牌p95延迟约为15秒,在100万个令牌上下文下最多为半分钟。GPT-4.1 mini和nano更快,例如,GPT-4.1 nano在128,000个输入令牌的查询中通常在5秒内返回首个令牌。

视觉

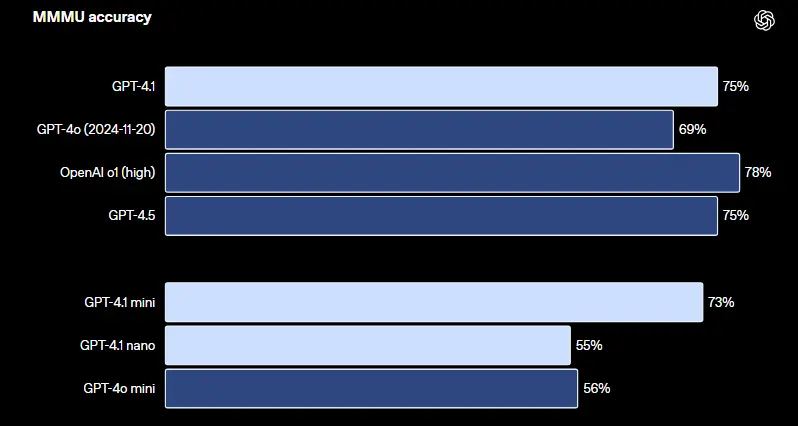

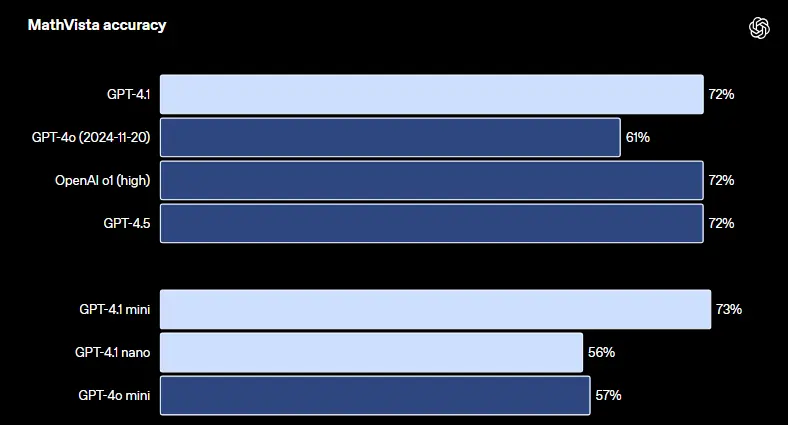

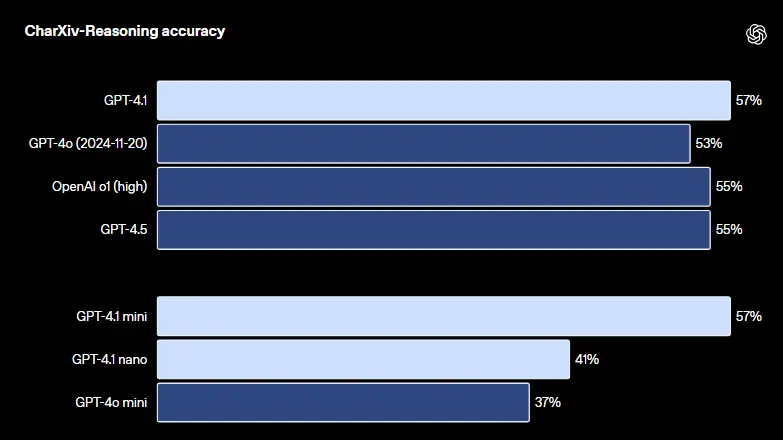

GPT-4.1系列在图像理解方面表现出色,尤其是GPT-4.1 mini,代表了重大进步,在图像基准测试中常常超越GPT-4o。

在MMMU中,模型可以回答包含图表、示意图、地图等的问答题(注意:即使没有图像,许多答案仍然可以从上下文中推断或猜测出来)。

在MathVista中,一个模型可以解决可视化的数学任务。

在CharXiv-Reasoning中,一个模型可以回答有关科学论文中图表的各种问题。

长上下文性能对多模态用例也很重要,例如处理长视频。在Video-MME(长视频无字幕)中,模型根据30-60分钟的无字幕视频回答多项选择题。GPT-4.1达到最佳性能,得分72.0%,比GPT-4o的65.3%有所提升。

在Video-MME中,模型根据长度为30-60分钟的无字幕视频来回答多项选择题。

定价

GPT-4.1、GPT-4.1 mini和GPT-4.1 nano现已对所有开发者开放。

通过对推理系统的效率改进,我们得以在GPT-4.1系列上提供更低的价格。GPT-4.1的中位查询价格比GPT-4o低26%,GPT-4.1 nano是我们最便宜且最快的模型。对于重复传递相同上下文的查询,我们将这些新模型的提示缓存折扣提高到75%(此前为50%)。最后,我们对长上下文请求不收取额外费用,仅按标准每令牌成本计费。

结论

GPT-4.1在AI的实际应用中迈出了重要一步。通过密切关注现实世界的开发者需求——从编程到指令遵循和长上下文理解——这些模型为构建智能系统和复杂的代理应用开启了新的可能性。我们一直受到开发者社区创造力的启发,期待看到您用GPT-4.1构建的内容。

附录

有关学术、编程、指令遵循、长上下文、视觉和函数调用评估的完整结果列表,请见下文。

相关文章