由上海交通大学 IPADS 实验室、人工智能学院与 Zenergize AI 联合研发的 SmallThinker 系列模型,是一组专为设备端部署设计的原生混合专家(MoE)语言模型。其核心目标是在资源受限的环境中,实现高性能、低延迟、高隐私性的本地推理,无需依赖云端服务。

- GitHub:https://github.com/SJTU-IPADS/PowerInfer/tree/main/smallthinker

- 模型:https://huggingface.co/PowerInfer

SmallThinker 从架构层面针对边缘设备进行了优化,兼顾推理效率与模型能力,适用于手机、嵌入式设备甚至树莓派等低功耗平台。它不仅支持完整功能的语言理解与生成,还能在内存受限条件下稳定运行,是迈向真正“个人 AI”的重要一步。

核心性能表现:在多维度评测中领先同类模型

我们选取了多个主流开源模型,在标准基准上对 SmallThinker-21BA3B-Instruct 进行横向对比。所有测试均在非思考模式下完成,MMLU 使用 0-shot Chain-of-Thought 设置。

| 模型 | MMLU | GPQA-diamond | MATH-500 | IFEVAL | LIVEBENCH | HUMANEVAL | 平均得分 |

|---|---|---|---|---|---|---|---|

| SmallThinker-21BA3B-Instruct | 84.43 | 55.05 | 82.4 | 85.77 | 60.3 | 89.63 | 76.26 |

| Gemma3-12b-it | 78.52 | 34.85 | 82.4 | 74.68 | 44.5 | 82.93 | 66.31 |

| Qwen3-14B | 84.82 | 50.00 | 84.6 | 85.21 | 59.5 | 88.41 | 75.42 |

| Qwen3-30BA3B | 85.10 | 44.40 | 84.4 | 84.29 | 58.8 | 90.24 | 74.54 |

| Qwen3-8B | 81.79 | 38.89 | 81.6 | 83.92 | 49.5 | 85.90 | 70.26 |

| Phi-4-14B | 84.58 | 55.45 | 80.2 | 63.22 | 42.4 | 87.20 | 68.84 |

从数据可见,SmallThinker 在 GPQA-diamond 和 IFEVAL 等强调逻辑与事实准确性的任务中显著优于多数竞品,尤其在 GPQA 上仅次于 Phi-4-14B,展现出 MoE 架构在知识推理方面的潜力。其综合平均分达到 76.26,位居前列。

值得注意的是,SmallThinker 的激活参数仅为 3B,远低于 Qwen3-30B 或 Gemma3-12B 的完整激活规模,却实现了接近甚至超越它们的表现,体现了 MoE 结构在“激活效率”上的优势。

推理速度与资源占用:面向真实设备优化

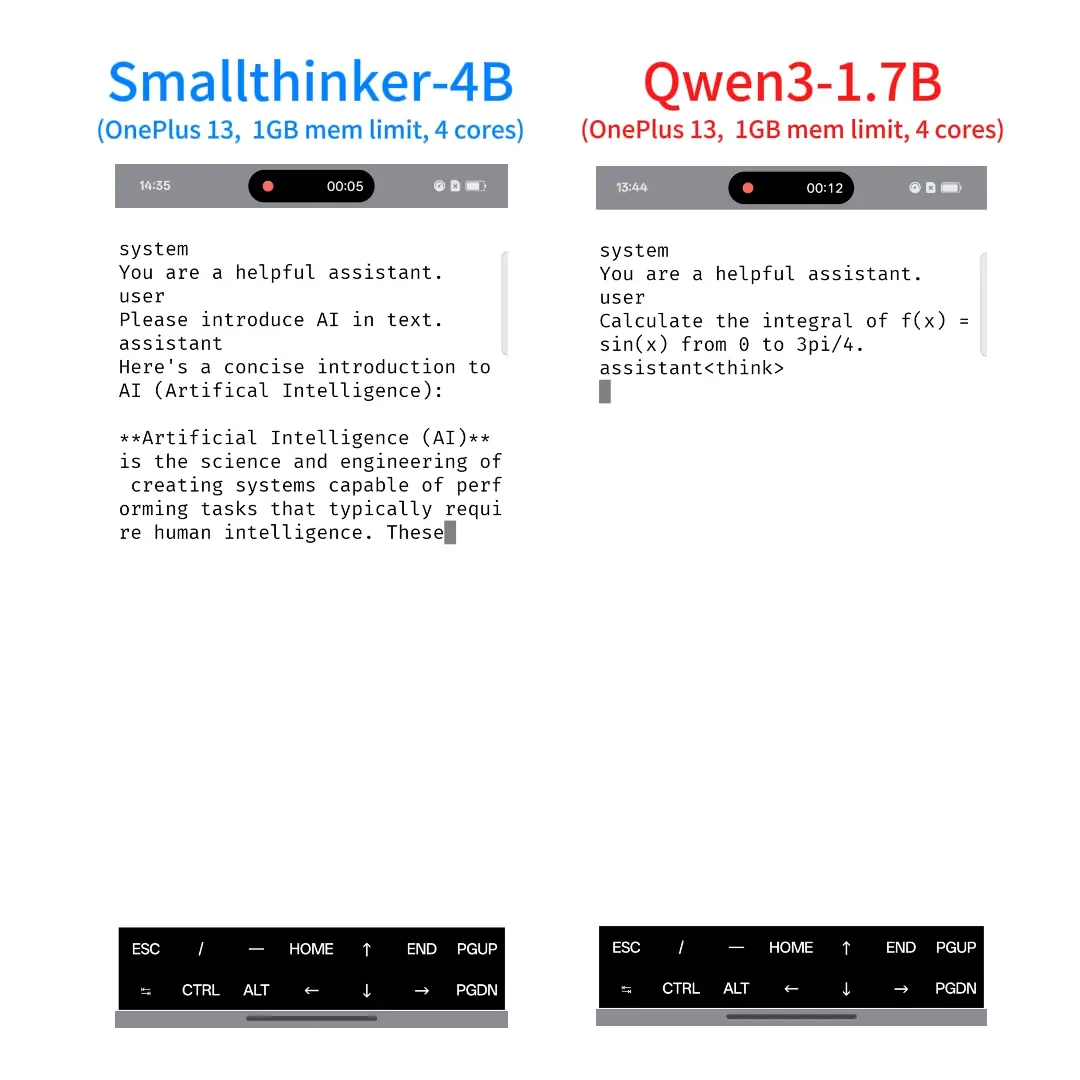

在边缘计算场景中,推理速度和内存占用往往比绝对性能更重要。SmallThinker 针对常见硬件平台进行了深度优化,以下是在不同设备上的 token 生成速度(tokens/s)与内存占用对比:

| 模型 | 内存 (GiB) | i9-14900 (4线程) | 1+13 8ge4 (4线程) | rk3588 (16G) | Raspberry Pi 5 |

|---|---|---|---|---|---|

| SmallThinker 21B+sparse | 11.47 | 30.19 | 23.03 | 10.84 | 6.61 |

| SmallThinker +8G内存限制 | ≤8 | 20.30 | 15.50 | 8.56 | - |

| Qwen3-30B A3B | 16.20 | 33.52 | 20.18 | 9.07 | - |

| Qwen3-30B A3B +8G限制 | ≤8 | 10.11 | 0.18 | 6.32 | - |

| Gemma3-nano E2B | 1(理论) | 36.88 | 27.06 | 12.50 | 6.66 |

| Gemma3-nano E4B | 2(理论) | 21.93 | 16.58 | 7.37 | 4.01 |

注:所有模型均已量化为

q4_0格式;线程配置根据设备调整以最大化吞吐。

尽管 Qwen3-30B 在高端 CPU 上略快,但在 内存受限场景(如 8GB 限制)下,其性能急剧下降(如在 1+13 平台上仅 0.18 tokens/s),而 SmallThinker 仍能维持可用速度。这表明其在 实际部署中的鲁棒性更强。

此外,SmallThinker 支持通过 PowerInfer 技术进行 GPU 卸载加速,进一步提升在集成显卡或轻量独立显卡设备上的表现。

模型架构概览

| 属性 | 值 |

|---|---|

| 架构 | 混合专家(MoE) |

| 总参数量 | 21B |

| 激活参数量 | 3B |

| 层数 | 52 |

| 注意力隐藏维度 | 2560 |

| MoE 隐藏维度(每专家) | 768 |

| 注意力头数 | 28 |

| KV 头数 | 4(GQA) |

| 专家数量 | 64 |

| 每 token 激活专家数 | 6 |

| 词汇表大小 | 151,936 |

| 上下文长度 | 16K |

| 注意力机制 | GQA |

| 激活函数 | ReGLU |

该架构通过稀疏激活机制,仅在推理时调用部分专家网络,大幅降低计算开销。同时,16K 的上下文长度支持长文本处理,适用于摘要、代码生成等任务。

适用场景与部署建议

SmallThinker 特别适合以下使用场景:

- 本地化 AI 助手:运行在个人手机或笔记本上,保护用户数据隐私;

- 离线环境应用:工业现场、车载系统、野外设备等无法联网的场合;

- 低成本硬件部署:如基于 rk3588 的开发板或树莓派 5,实现轻量 AI 推理;

- 教育与研究:作为 MoE 架构的教学案例或边缘 AI 实验平台。

开发者可通过 GGUF 等格式将其部署至 llama.cpp、MLC LLM 或支持 PowerInfer 的运行时环境,快速集成进现有应用。

相关文章