智谱AI正式推出 GLM-4.5 与 GLM-4.5-Air —— GLM 系列最新旗舰大模型。这两款模型专为代理(Agent)导向应用设计,首次在单一架构中深度融合了复杂推理、高效编码与多工具协同能力,标志着向通用智能基座迈出了关键一步。

- ✅ GLM-4.5:355B 总参数,32B 激活参数,性能全球前三

- ✅ GLM-4.5-Air:106B 总参数,12B 激活参数,轻量高能

模型已在 Z.ai 平台开放使用,支持 OpenAI 兼容 API,同时基础模型权重已开源,可在 HuggingFace 和 ModelScope 获取。

- 项目主页:https://z.ai/blog/glm-4.5

- API:https://docs.z.ai/guides/llm/glm-4.5

- GitHub:https://github.com/zai-org/GLM-4.5

- Hugging Face:https://huggingface.co/collections/zai-org/glm-45-687c621d34bda8c9e4bf503b

- 魔塔:https://modelscope.cn/collections/GLM-45-b8693e2a08984f

背景

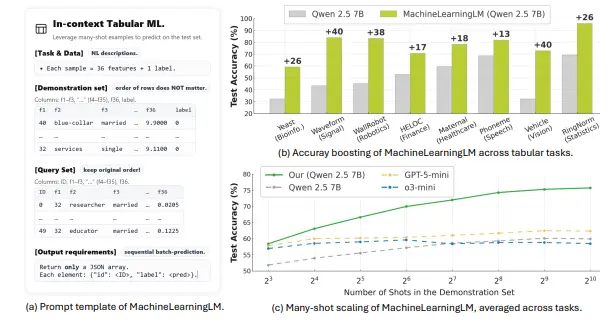

大语言模型(LLM)始终以实现人类水平的广泛领域认知能力为目标,而非针对特定任务设计。作为一个优秀的大语言模型,必须具备通用问题解决、泛化、常识推理和自我改进能力。在过去五年中,OpenAI 的 GPT-3 学习了常识知识,o1 通过强化学习在响应前进行思考,显著提升了编码、数据分析和复杂数学的推理能力。然而,现有模型仍未真正实现全面通用:有些擅长编码,有些擅长数学,有些擅长推理,但没有一个模型能在所有不同任务中实现最佳性能。GLM-4.5 致力于统一这些不同能力的目标。

总体性能

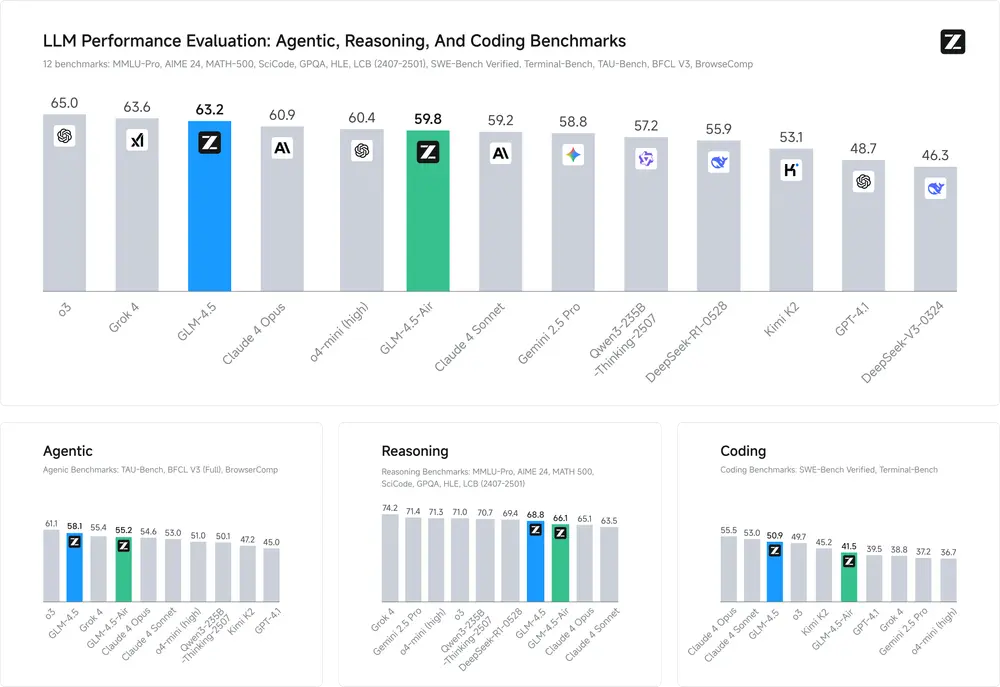

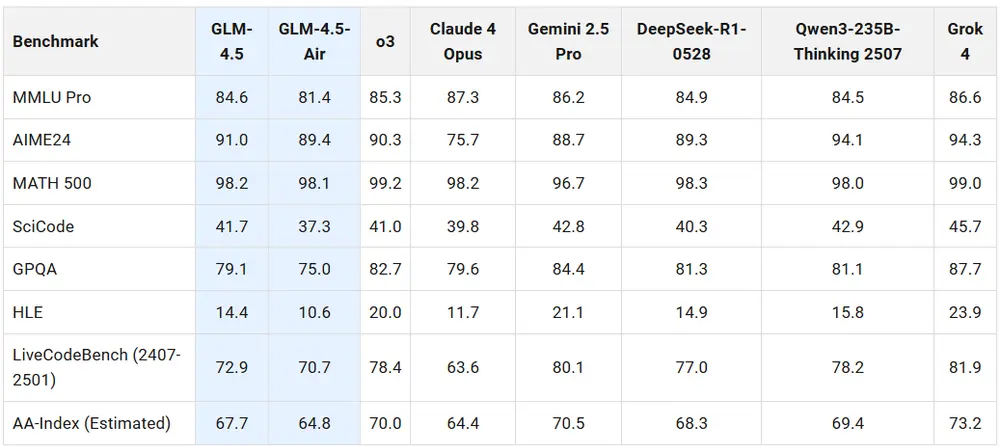

智谱AI在涵盖代理(3 个)、推理(7 个)和编码(2 个)的 12 个基准测试中,将 GLM-4.5 与 OpenAI、Anthropic、Google DeepMind、xAI、阿里巴巴、Moonshot 和 DeepSeek 的多种模型进行比较。总体而言,GLM-4.5 排名第 3,GLM-4.5-Air 排名第 6。

代理(Agentic )任务

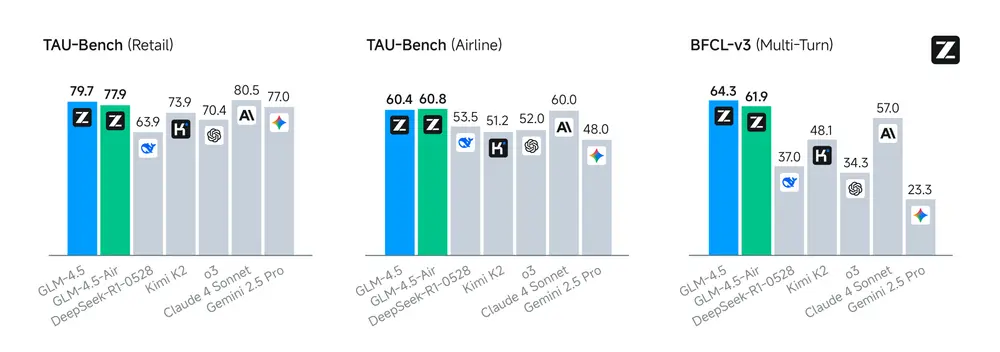

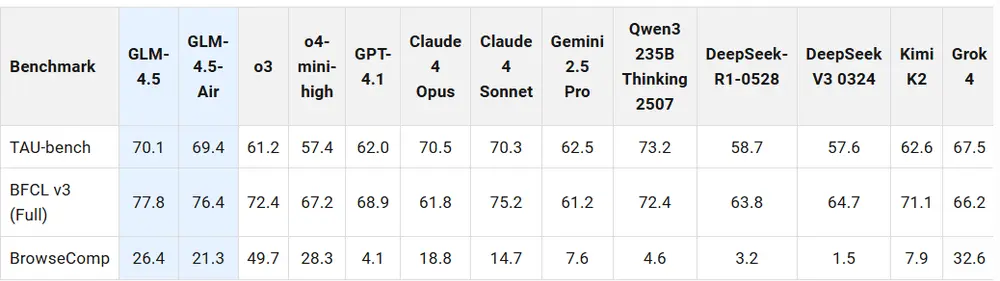

GLM-4.5 是一个为代理任务优化的基础模型,提供 128k 上下文长度和原生函数调用能力。智谱AI在 𝜏-bench 和 BFCL-v3(伯克利函数调用排行榜 v3)上测量其代理能力。在这两个基准测试中,GLM-4.5 的表现与 Claude 4 Sonnet 相当。

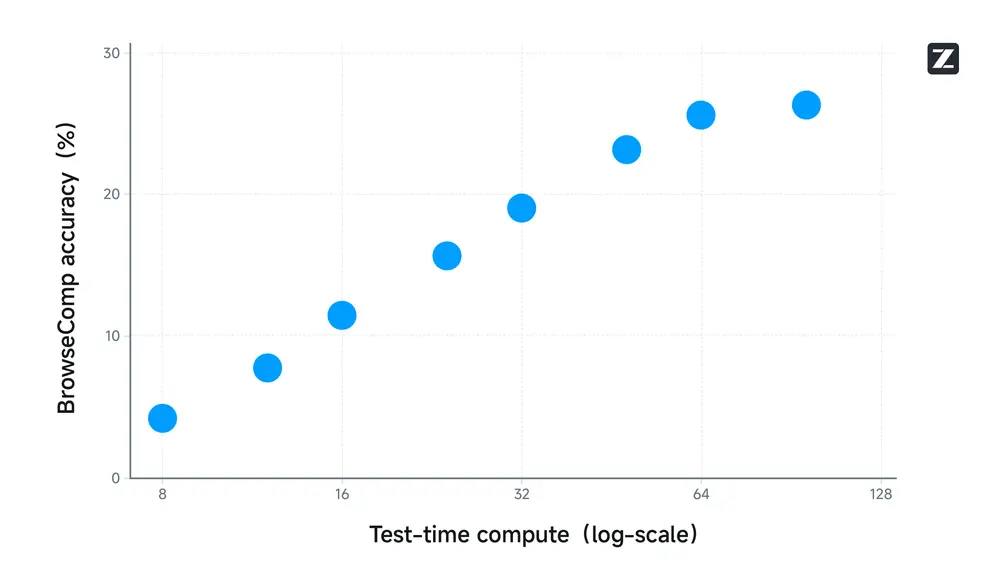

网页浏览是一个需要复杂推理和多轮工具使用的流行代理应用。智谱AI在 BrowseComp 基准测试上评估了 GLM-4.5,这是一个针对网页浏览的挑战性基准测试,包含需要简短回答的复杂问题。在使用网页浏览工具时,GLM-4.5 正确回答了 26.4% 的问题,明显优于 Claude-4-Opus(18.8%),并接近 o4-mini-high(28.3%)。下图展示了 GLM-4.5 在 BrowseComp 上的测试时扩展准确率。

所有用于评估模型代理能力的三个基准测试中不同比较模型的详细结果列于下表:

推理

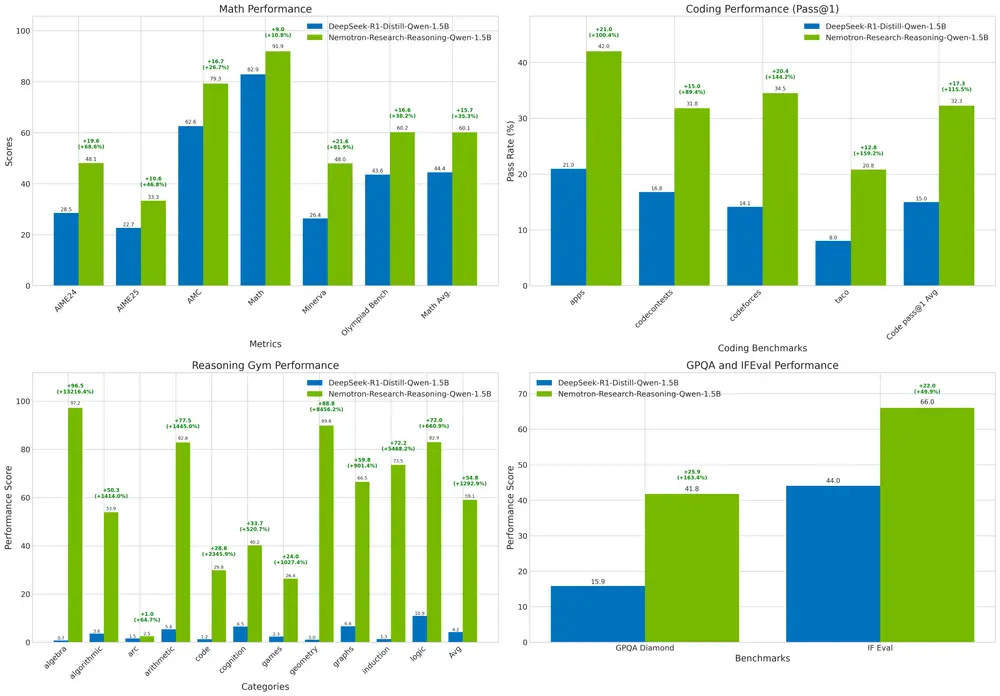

在思考模式下,GLM-4.5 和 GLM-4.5-Air 能够解决包括数学、科学和逻辑问题在内的复杂推理问题。

编码

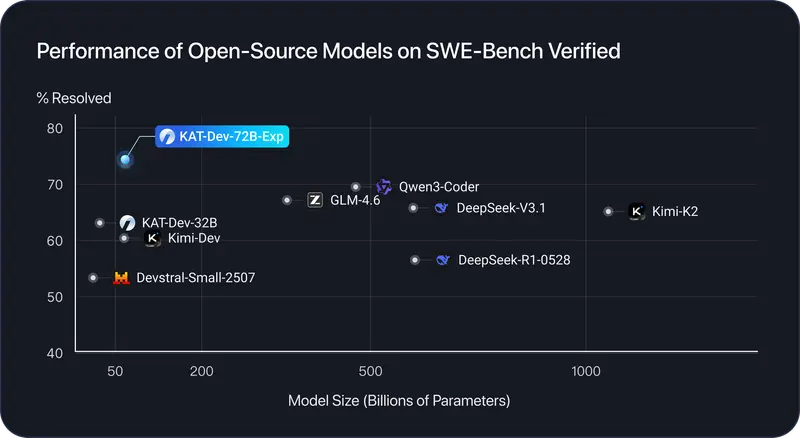

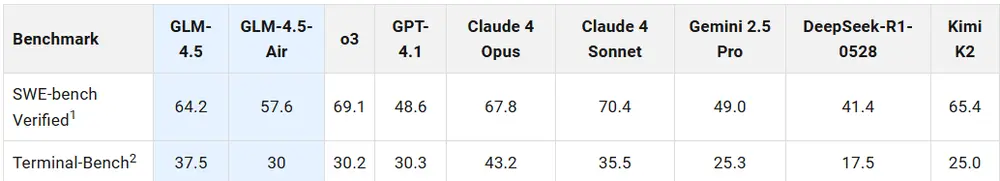

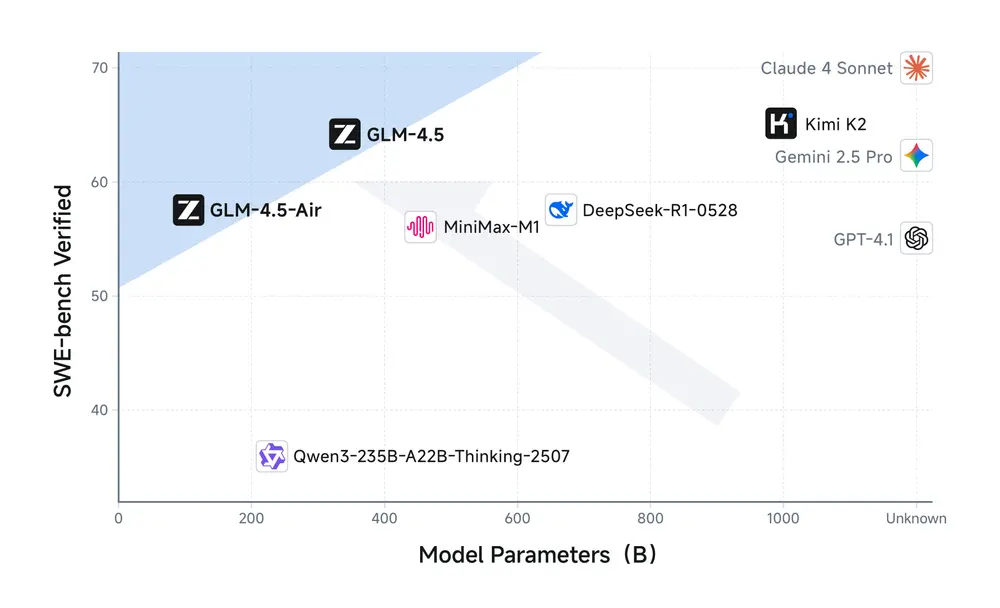

GLM-4.5 在编码方面表现出色,包括从零开始构建编码项目以及在现有项目中代理解决编码任务。它可以与现有编码工具包(如 Claude Code、Roo Code 和 CodeGeex)无缝结合。为评估编码能力,我智谱AI在 SWE-bench Verified 和 Terminal Bench 上比较了不同模型。结果如下表所示。

智谱AI对所有比较模型进行了帕累托前沿分析(如图所示)。GLM-4.5 和 GLM-4.5-Air 相对于同等规模的模型展现出优越性能,在性能-规模权衡边界上实现最佳效率。

GLM-4.5 展示出全面的全栈开发能力,能够无缝创建包括前端实现、数据库管理和后端部署的网页应用。GLM-4.5 生成的前端界面展现出增强的功能性和美观性,表现出与人类设计偏见的高度一致性。此外,GLM-4.5 在生成演示材料(如幻灯片和海报)方面表现优异,结合代理工具进行信息检索和语境增强时能力显著提升。

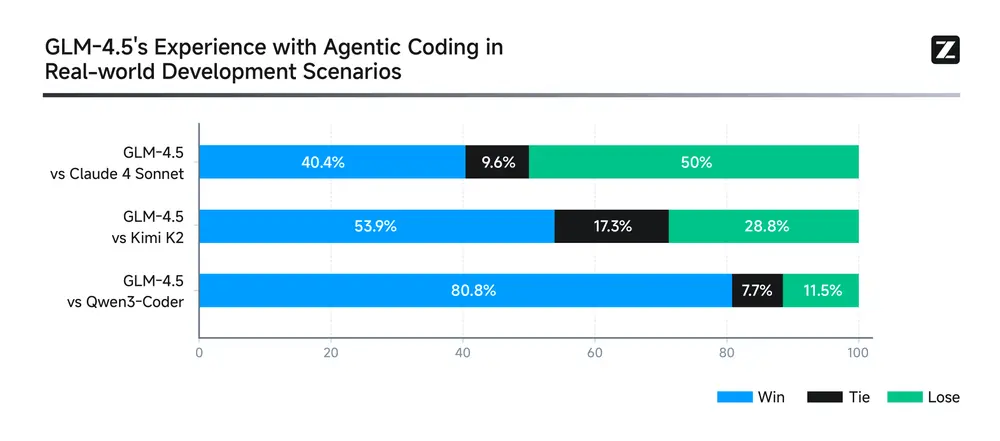

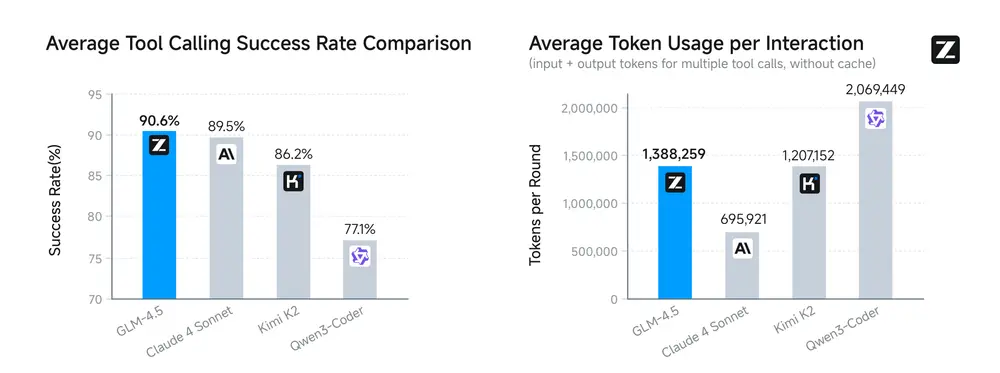

为评估 GLM-4.5 的代理编码能力,智谱AI使用 Claude Code 针对 Claude-4-Sonnet、Kimi K2 和 Qwen3-Coder,跨前端开发、工具开发、数据分析、测试和算法实现的 52 个编码任务进行性能评估。所有评估均通过多轮人工交互在隔离测试环境中进行,采用标准化评估标准以确保一致性和可重复性。实证结果显示,GLM-4.5 对 Kimi K2 的胜率为 53.9%,对 Qwen3-Coder 的成功率为 80.8%。尽管 GLM-4.5 展现出竞争力,但与 Claude-4-Sonnet 相比仍有进一步优化的空间。

值得注意的是,GLM-4.5 的平均工具调用成功率达到 90.6%,优于 Claude-4-Sonnet(89.5%)、Kimi K2(86.2%) 和 Qwen3-Coder(77.1%),展示了在代理编码任务中更高的可靠性和效率。所有 52 个编码任务的轨迹已公开,供社区进一步研究,详见此处。

演示

产物

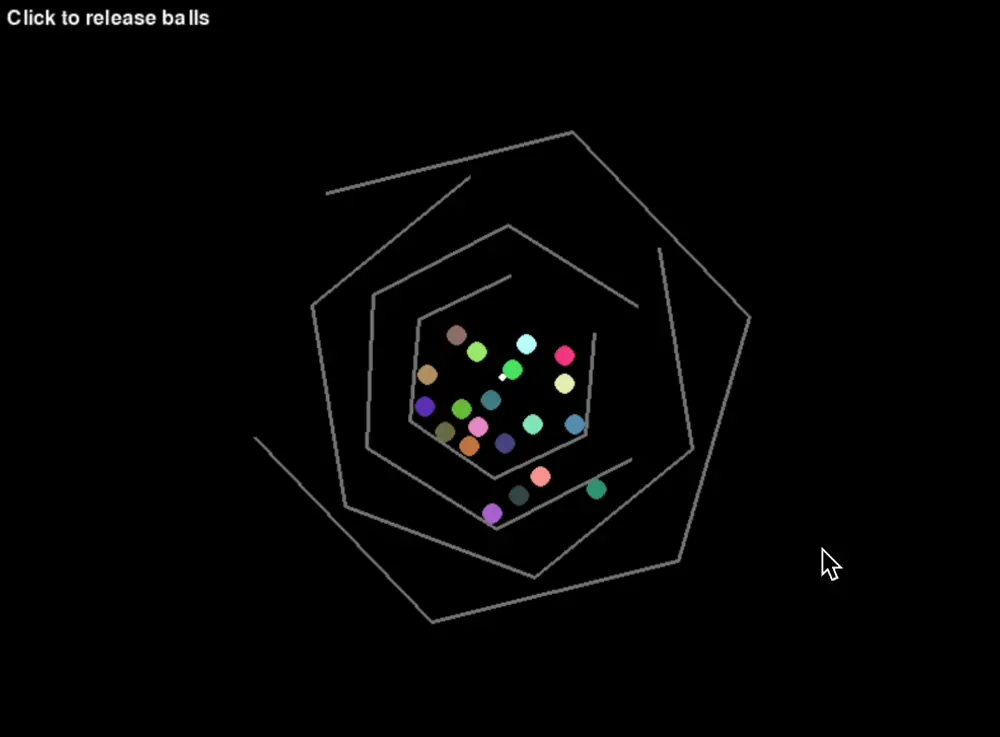

GLM-4.5 增强了 GLM-4 四月发布中引入的复杂代码生成能力。该模型现可创建复杂的独立产物——从交互式迷你游戏到物理模拟,涵盖 HTML、SVG、Python 等多种格式。这些改进提供卓越的用户体验,同时为高级代理编码应用奠定基础。

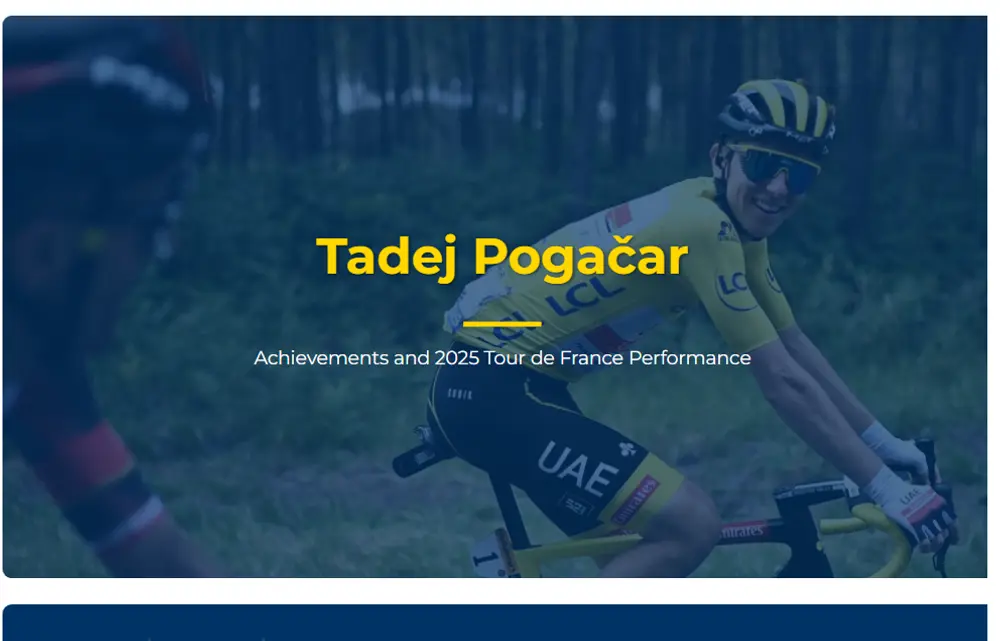

幻灯片创建

利用 GLM-4.5 强大的代理工具使用和 HTML 编码能力,智谱AI开发了一个模型原生的 PPT/海报代理。用户可以请求简单或复杂的设计,或上传文档,代理会自主搜索网络或检索图像,然后创建幻灯片。

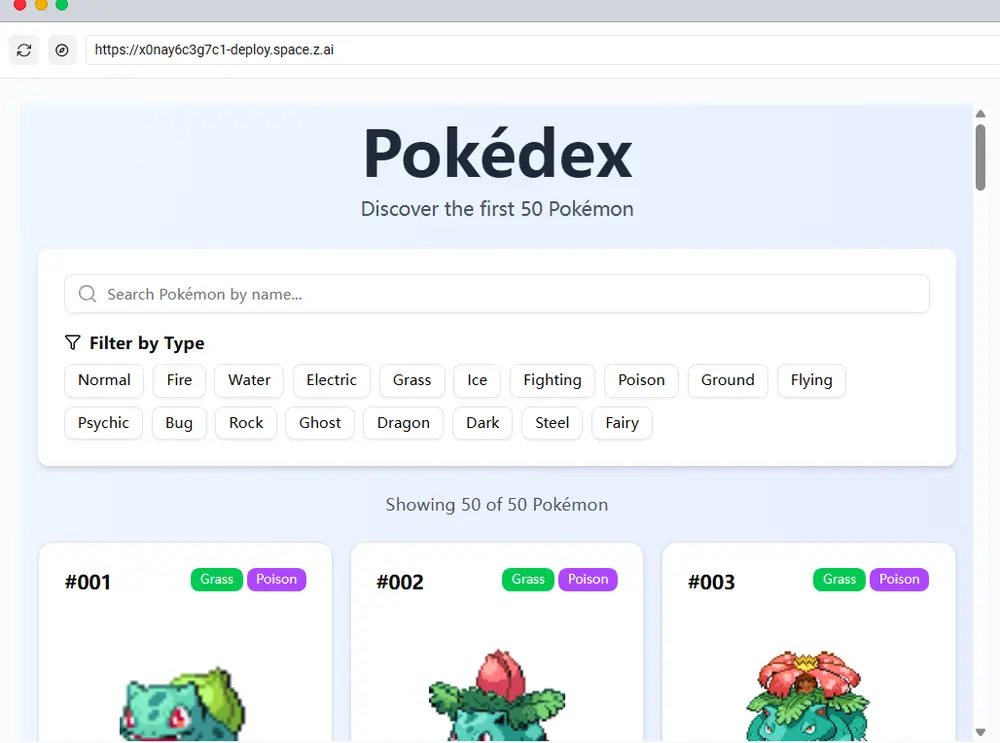

全栈开发

GLM-4.5 在前端和后端开发中表现出色,使其成为构建现代网页应用的强大工具。为更好地展示其能力,智谱AI开发了一个受 Claude Code 启发的编码代理。通过提供基本的 full-stack 网站样板,代理可让用户仅用几句话创建整个网站。用户可通过多轮对话轻松添加功能并完善项目,使编码过程顺畅且愉悦。在 Z.ai 上放松心情,让 GLM-4.5 将您的想法变为现实。

GLM-4.5 入门

在 Z.ai 上与 GLM-4.5 聊天

通过在 Z.ai 平台上选择 GLM-4.5 模型选项即可访问 GLM-4.5。该平台为产物生成、演示幻灯片创建和全栈开发能力提供全面支持。

在 Z.ai API 上调用 GLM-4.5 API

Z.ai API 平台为 GLM-4.5 和 GLM-4.5-Air 模型提供与 OpenAI 兼容的接口。有关全面的 API 文档和集成指南,请参阅 GLM-4.5 User Guide - Z.AI。

将 GLM-4.5 与编码代理结合使用

有关将 GLM-4.5 与 Claude Code 和其他编码代理框架集成的详细说明,请参阅 Z.ai API 的文档。

本地运行 GLM-4.5

GLM-4.5 和 GLM-4.5-Air 的基础模型和聊天变体权重已在 HuggingFace 和 ModelScope 上公开。对于本地部署,GLM-4.5 支持 vLLM 和 SGLang 等推理框架。官方 GitHub 仓库中提供全面的部署说明。

技术

模型架构与预训练

在 GLM-4.5 系列中,智谱AI采用 MoE 架构,提升了训练和推理的计算效率。智谱AI使用无损失平衡路由和 sigmoid 门控用于 MoE 层。与 DeepSeek-V3 和 Kimi K2 不同,智谱AI减少了模型的宽度(隐藏维度和路由专家数量),同时增加高度(层数),因为智谱AI发现更深的模型展现出更好的推理能力。在自注意力组件中,智谱AI采用分组查询注意力(Grouped-Query Attention)结合部分 RoPE。此外,智谱AI使用了 2.5 倍的注意力头数(5120 隐藏维度下 96 个头)。出人意料的是,虽然增加头数未改善训练损失,但它在 MMLU 和 BBH 等推理基准测试中始终提升性能。对于 GLM-4.5,智谱AI使用 Muon 优化器,加速收敛并容忍更大的批量大小。智谱AI还引入 QK-Norm 以稳定注意力 logits 的范围。对于 GLM-4.5 和 GLM-4.5-Air,智谱AI添加了 MTP(多标记预测)层以支持推理期间的推测解码。

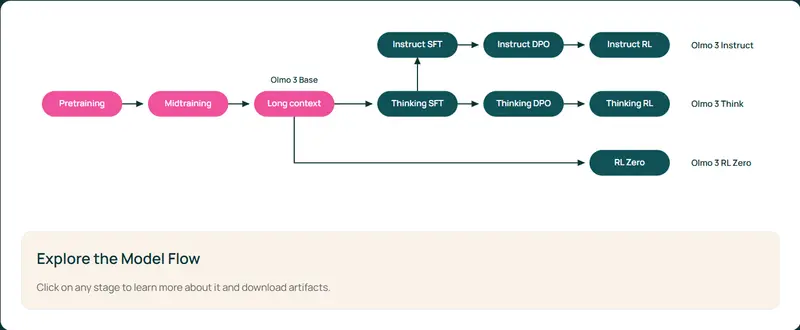

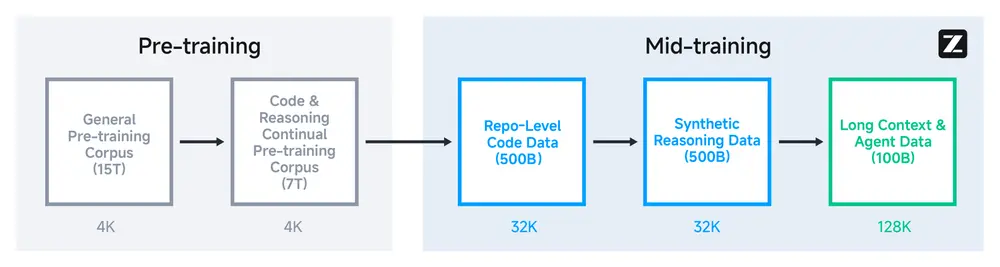

智谱AI的基础模型经历了多个训练阶段。在预训练期间,模型首先在 15T 标记的通用预训练语料库上训练,然后在 7T 标记的编码与推理语料库上训练。预训练后,智谱AI引入额外阶段以进一步增强模型在关键下游领域的性能。与早期大规模通用文档预训练不同,这些阶段利用中等规模的领域特定数据集,包括指令数据。

使用 slime 进行大规模模型的强化学习

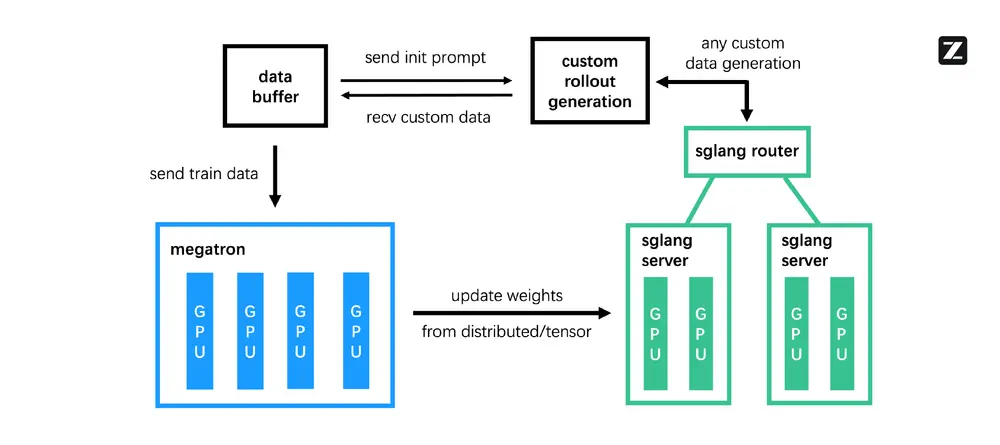

为支持 GLM-4.5 等大规模模型所需的高效强化学习(RL)训练,智谱AI设计、开发并开源了 slime。这一 RL 基础设施以卓越的灵活性、效率和可扩展性为目标,智谱AI积极鼓励社区使用和贡献。

slime 的主要创新旨在克服常见的 RL 瓶颈,特别是在复杂代理任务中。

- 灵活的混合训练架构:slime 的核心优势在于其多功能的混合架构。它支持同步、同地训练,适用于推理和通用 RL 等传统应用,以及解耦的异步训练模式。这种异步模式对于高级代理 RL 至关重要,因为数据生成可能是一个缓慢的外部过程。通过将训练与数据收集解耦,确保训练 GPU 保持完全饱和,最大化硬件利用率。

- 解耦的代理导向设计:代理 RL 常因环境展开中的慢速和长尾延迟分布而导致训练吞吐量受限。为解决这一问题,slime 实现了一个完全解耦的基础设施,将展开引擎与训练引擎分离。这些组件在不同硬件上独立运行,将数据生成瓶颈转化为并行化、非阻塞过程。这一设计是加速长时域代理任务的基础。

- 混合精度加速数据生成:为进一步提升吞吐量,slime 使用混合精度推理加速展开。它战略性地采用高效的 FP8 格式进行数据生成,同时保留 BF16 的稳定性用于模型训练循环。这项技术显著提升数据生成速度,同时不影响训练质量。

这一连贯的设计使 slime 能够无缝集成多种代理框架,支持多样化任务,并通过统一的强大接口高效管理长时域展开。

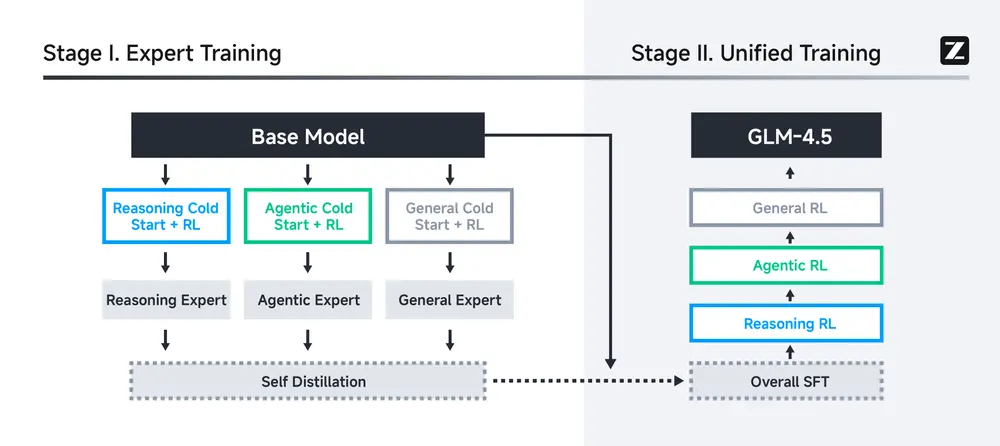

通过强化学习进行后训练以增强代理能力

后训练对于大语言模型通过自我生成的探索性经验迭代增强策略至关重要。强化学习(RL)是推动模型能力边界的关键步骤。对于 GLM-4.5,除了整合 GLM-4-0414 的通用能力和 GLM-Z1 的推理能力外,智谱AI特别增强了代理能力,包括代理编码、深度搜索和通用工具使用。

该过程始于在精选推理数据和合成代理场景上的监督微调,随后进行专门的 RL 阶段以培养专家模型。

- 对于推理,智谱AI在完整的 64K 上下文上进行单阶段 RL,采用基于难度的课程表,智谱AI发现这优于渐进式调度。智谱AI引入了修改后的 RL 技术以确保稳定性:动态采样温度以平衡探索与利用,以及在 STEM 问题上的自适应剪切以实现稳健的策略更新。

- 对于代理任务,训练在两个可验证任务上运行:基于信息搜索的问答和软件工程。智谱AI开发了可扩展的策略,基于人工参与的提取和网页内容的 selective obfuscation 合成基于搜索的问答对。编码任务由真实世界软件工程任务的执行反馈驱动。

尽管 RL 课程针对有限的验证任务集,但其收益可转移到通用工具使用等相关能力。接下来,专家蒸馏整合了这些专业技能,使 GLM-4.5 在所有任务中具备全面实力。

相关文章