大语言模型(LLMs)之所以具备强大的推理能力,关键在于其通过可验证奖励机制的强化学习所涌现的认知行为。那么,是否可以将这一原则迁移至多模态大语言模型(MLLMs),从而解锁其高级视觉推理能力?

本研究由约翰·霍普金斯大学、StepAI、北京邮电大学、中国科学院大学、纽约大学、华中科技大学等机构联合完成,提出了一种基于 Qwen2.5-VL-7B 的双阶段训练范式,首次在开源领域实现了大规模、长周期的多模态强化学习(RL),训练步数接近1000步,远超以往研究。

- 项目主页:https://weiyana.github.io/Open-Vision-Reasoner

- GitHub:https://github.com/Open-Reasoner-Zero/Open-Vision-Reasoner

- 模型:https://huggingface.co/Kangheng/OVR-7B-RL

通过这一开创性工作,研究团队揭示了三个核心发现:

- 语言冷启动阶段中,视觉认知行为意外地早期涌现;

- 冷启动广泛记忆视觉行为,而强化学习关键性识别并放大有效模式;

- 行为转移具有战略性,优先放大高实用性行为,如视觉反思与目标追踪。

研究团队最终训练出的模型——Open-Vision-Reasoner(OVR),在多个高级视觉推理基准测试中取得了当前7B级别模型中的最优性能:

- MATH500:95.3%

- MathVision:51.8%

- MathVerse:54.6%

研究团队已公开模型、训练数据与完整训练动态,旨在推动更强大、行为对齐的多模态推理器的发展。

视觉认知行为的定义与迁移

研究团队认为,语言模型中的认知行为(如回溯、子目标分解、验证等)在多模态场景中可以拓展为一系列视觉认知行为。这些行为包括:

| 行为 | 定义 | 示例 |

|---|---|---|

| 视觉反思(Visual Reflection) | 模型在视觉任务中回顾和评估自身推理过程 | “让我再仔细看一下这张图” |

| 分而治之(Divide and Conquer) | 将复杂视觉任务分解为多个子任务处理 | “我需要先识别图中各个物体,再分析它们的关系” |

| 视觉验证(Visual Validation) | 通过视觉信息验证中间推理结果 | “图中显示的数字是5,所以我的计算应该是正确的” |

| 目标驱动的视觉追踪(Goal-Driven Visual Tracking) | 以目标为导向,逐步追踪视觉信息 | “我需要找到图中红色区域,然后判断其是否与其他区域重叠” |

这些行为不仅在语言任务中广泛存在,也在多模态任务中展现出显著的迁移能力。

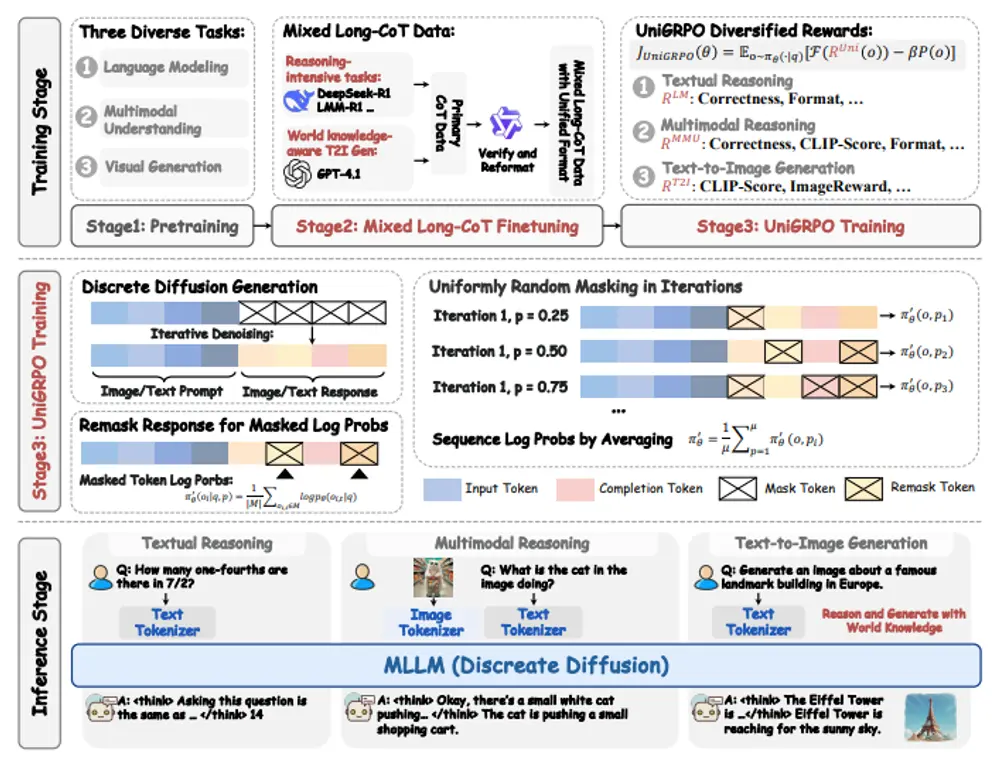

训练范式设计:语言冷启动 + 多模态强化学习

为实现高效的多模态认知迁移,研究团队采用了“带冷启动的强化学习”训练范式,分为两个阶段:

阶段1:语言冷启动(Language Cold Start)

- 使用从 DeepSeek-R1 提炼出的纯语言推理数据集,进行监督微调

- 在纯语言环境中建立基础认知行为,如回溯、验证、子目标分解等

- 模型在这一阶段展现出意外的视觉认知行为早期涌现,表明语言推理能力对视觉推理具有潜在迁移价值

阶段2:多模态强化学习(Multimodal Reinforcement Learning)

- 在文本与多模态任务上,使用基于可验证匹配奖励的强化学习策略

- 推动推理泛化能力提升,并将已有的语言认知行为与视觉上下文对齐

- 这一阶段是行为筛选与放大的关键过程,有效提升了模型的跨模态泛化能力

模型性能表现

✅ 语言推理能力

OVR 在语言推理任务中表现出色:

- 在 AIME 2024/2025 上,平均性能超越其他 7B 级别开源模型 10% 以上,接近 32B 级别模型

- 在 MMLU 和 MMLU-Pro 上分别提升 +4.6% 和 +10.4%,显著优于参数相近的模型

这表明研究团队所采用的高质量冷启动训练数据具有极高的有效性。

✅ 视觉推理能力

OVR 在 7B 规模的视觉推理任务中取得突破性进展:

| 基准 | 性能 | 说明 |

|---|---|---|

| MathVision | 51.8% | 首个突破50%门槛的7B级模型 |

| MathVerse | 54.6% | 当前7B级模型中表现最佳 |

| DynaMath | 优异表现 | 展现出强大的动态视觉推理能力 |

| MMMU-Pro | +7.2% 提升 | 表明其在复杂多模态任务中具有广泛适应性 |

这些结果表明,语言推理能力可以通过有效训练迁移到视觉任务中,并显著提升多模态模型的推理表现。

训练动态分析

研究团队对训练过程中的关键指标进行了深入分析:

- 冷启动阶段:损失逐步下降,行为模式快速建立;

- 强化学习阶段:奖励(紫色,左轴)与响应长度(橙色,右轴)稳步增长,在每次序列扩展后出现显著上升。

这表明:响应长度可以作为奖励的代理指标,反映出推理深度与资源消耗之间的关系。

深入行为分析

1. 视觉行为在冷启动阶段即已显现

令人惊讶的是,即便在纯语言任务中,DeepSeek-R1 的输出也频繁展现出心理意象的特征,例如:

- “让我想象一下这个场景”

- “我可以通过图像来理解这个问题”

这表明,语言模型在冷启动阶段已经开始构建内部视觉表示,以辅助推理过程。

2. 冷启动广泛记忆,强化学习关键识别

训练数据显示:

- 冷启动阶段快速灌输大量模式

- 随后在强化学习阶段,这些模式被筛选、放大,最终保留最有效的认知行为

这种机制类似于“先广度后深度”的学习策略,表明:冷启动负责记忆,强化学习负责筛选。

3. 行为转移具有战略性

研究团队观察到,回溯行为的转移率从 2.5% 提升至 17.3%,而验证行为在冷启动和强化学习阶段几乎为零。

这说明:

- 回溯行为更容易从语言任务迁移到视觉任务,可能源于其与“心理想象”能力的天然关联;

- 验证行为缺乏语言前身,因此在多模态任务中更难内化;

- 强化学习阶段优先放大对视觉推理更为基础的行为,如回溯,体现了其战略性选择机制。

视觉感知分析与未来方向

冷启动削弱感知,强化学习增强感知

研究团队在 OVR 的两个训练阶段以及基础模型 Qwen2.5-VL-7B 上进行了多模态感知评估,结果如下:

| 任务 | 性能变化 | 说明 |

|---|---|---|

| MMBench | 显著提升 | 强化学习有效恢复感知能力 |

| PhyX | 稳步增长 | 表明训练范式对物理推理有效 |

| BLINK | 有所恢复 | 显示多模态强化学习对幻觉问题有缓解作用 |

然而,研究团队也发现:

- 冷启动阶段在某些任务中导致性能下降,尤其在大规模语言数据导致的标签分布变化下,幻觉增加;

- 但多模态强化学习阶段能够有效识别关键感知能力,从而恢复并提升性能。

感知策略的强化学习当前不可扩展

研究团队在训练中观察到:

- 奖励与响应长度之间存在强相关性,这与以往研究一致;

- 然而在 OCR、计数等特定任务中,奖励增长与响应长度无关,表明某些核心视觉认知行为仍缺失。

这一发现提示我们:当前的多模态强化学习机制在某些感知任务上仍不具备良好的可扩展性,未来的研究应聚焦于更精细的行为建模与奖励机制设计。

相关文章