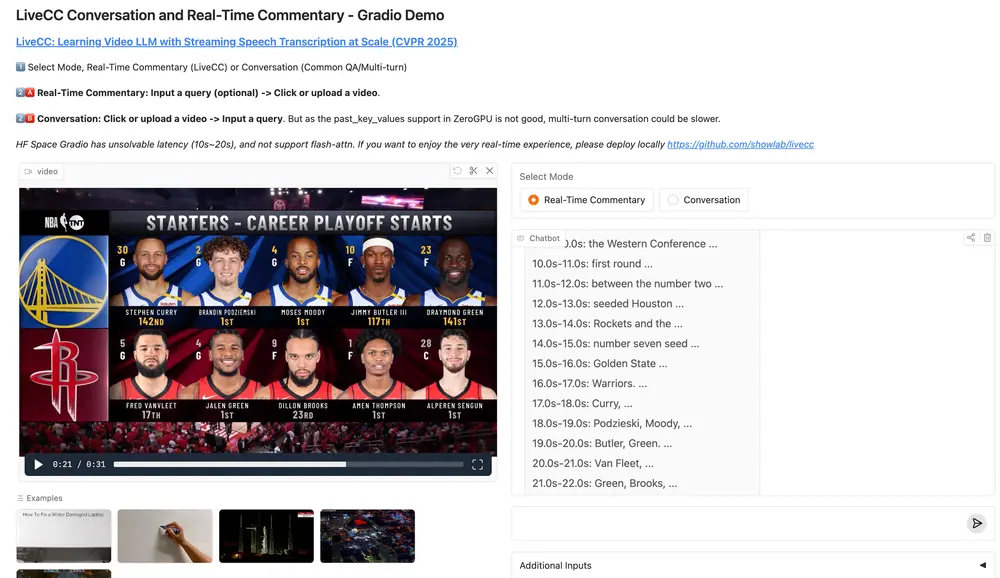

新加坡国立大学和字节跳动的研究人员推出基于 Qwen2-VL-7B 开发的实时视频理解大模型LiveCC,能够像专业解说员一样快速分析视频内容,并同步生成自然流畅的语音或文字解说。特别适合需要即时反馈的场景,比如体育赛事直播时自动生成战术分析,或是游戏直播中实时解说。

- 项目主页:https://showlab.github.io/livecc

- GitHub:https://github.com/showlab/livecc

- 模型:https://huggingface.co/collections/chenjoya/livecc-67e29b3df1b6b5c6d5d682f4

- Demo:https://huggingface.co/spaces/chenjoya/LiveCC

LiveCC通过大规模的流式语音转录(Streaming Speech Transcription)数据进行训练,能够实时生成视频解说(commentary)和回答视频相关问题。该模型的核心在于利用自动语音识别(ASR)生成的字幕作为训练数据,通过一种新颖的流式训练方法,将视频帧与对应的 ASR 单词紧密对齐,从而实现细粒度的视听语言建模。

主要功能

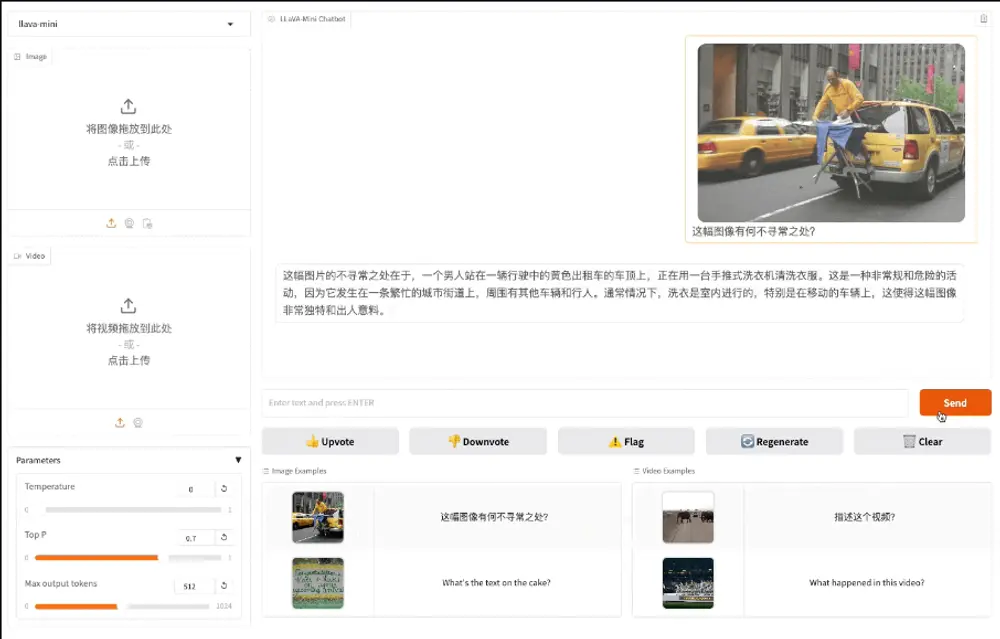

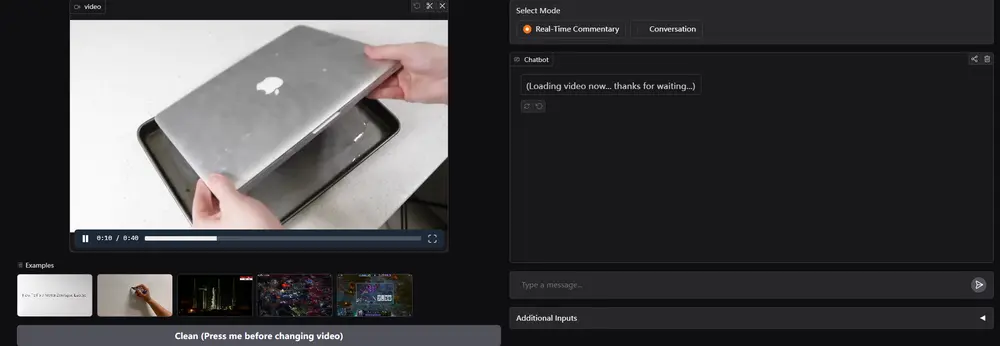

实时视频解说:LiveCC 能够在视频播放的同时,逐帧生成与视频内容紧密相关的解说词,适用于体育赛事、新闻报道、教学视频等多种场景。 视频问答:模型可以回答与视频内容相关的问题,支持多种类型的问答任务,如物体识别、动作理解、事件推理等。 低延迟处理:LiveCC 在处理视频流时,每帧的延迟小于0.5秒,能够支持实时应用场景,如增强现实(AR)眼镜、实时直播等。

主要特点

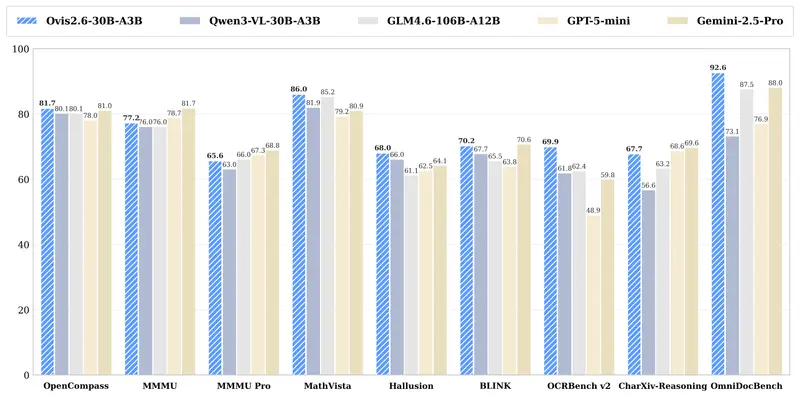

大规模数据驱动:LiveCC 使用了大规模的 YouTube 视频及其自动生成的字幕(ASR)作为训练数据,通过构建 Live-CC-5M 和 Live-WhisperX-526K 数据集,实现了低成本、高效率的模型训练。 细粒度视听对齐:模型采用了流式训练方法,将 ASR 单词与视频帧按照时间戳密集交错排列,使得模型能够学习到视频帧与语音之间的细粒度时间对齐关系。 实时性与低延迟:LiveCC 在推理时逐帧生成文本,仅需处理少量单词,确保了极低的延迟,适合实时视频处理。 强大的泛化能力:通过在多个视频问答基准测试(如 VideoMME、OVOBench)上验证,LiveCC 展示了其在不同任务上的广泛适用性。

工作原理

数据收集与处理: Live-CC-5M 数据集:从 YouTube 视频中提取原始字幕(CC),经过过滤和剪辑,生成大规模的预训练数据集。 Live-WhisperX-526K 数据集:使用高质量的 ASR 转录工具 WhisperX 生成更准确的字幕,并结合人工标注的提示(prompt)用于指令微调(SFT)。

模型架构: 基于 Qwen2-VL 模型,结合视觉编码器(Vision Transformer)和语言模型(LLM)。 在训练时,将视频帧和对应的 ASR 单词按照时间顺序交错排列,形成密集的输入序列,模型通过自回归预测文本标记。

训练与推理: 预训练:模型在 Live-CC-5M 数据集上进行预训练,学习视频帧与 ASR 单词之间的对齐关系。 指令微调(SFT):在 Live-WhisperX-526K 数据集上进行微调,进一步提升模型在特定任务上的性能。 推理:在推理时,模型逐帧处理视频输入,生成与视频内容相关的文本输出,支持实时交互。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...