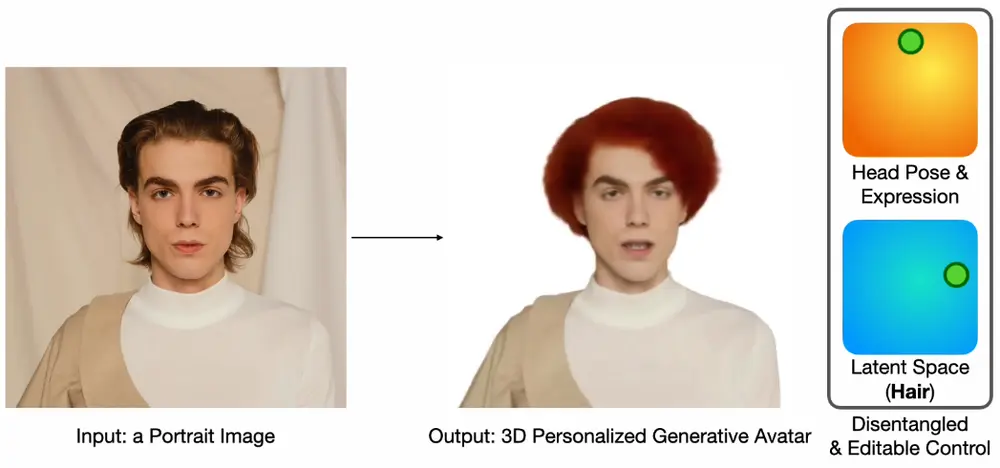

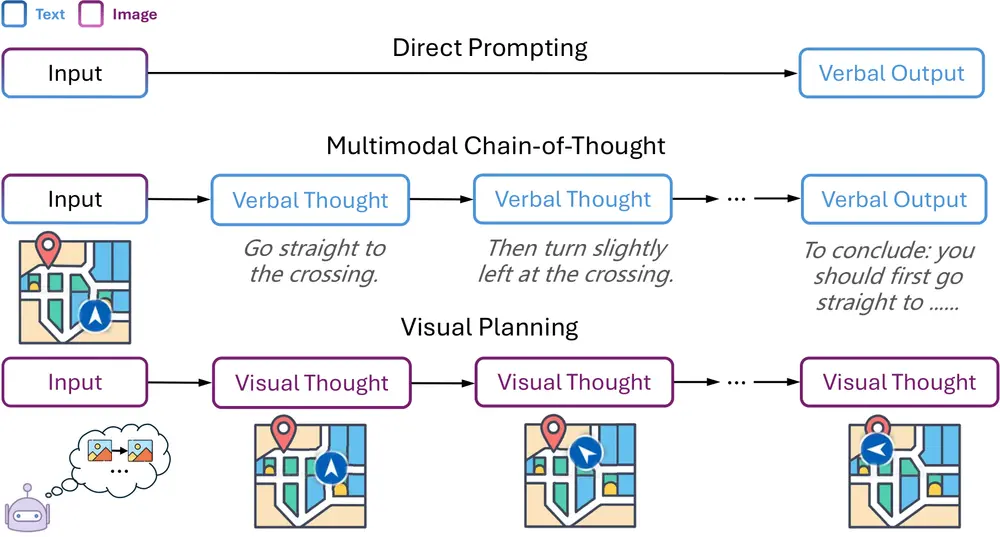

剑桥大学语言技术实验室、伦敦大学学院和谷歌的研究人员一种名为“Visual Planning(视觉规划)”的新范式,通过纯视觉表征进行规划,无需依赖文本。该范式受到认知科学中双重编码理论的启发,主张人类认知通过言语和非言语两个渠道运作,而以往的多模态模型大多依赖文本进行推理,忽略了视觉信息在空间和几何任务中的直观优势。例如,在规划穿越迷宫的路线时,视觉表征往往比文字描述更能准确捕捉复杂的空间推理关系。

主要功能

- 纯视觉推理:使模型能够仅通过图像序列进行规划,无需将视觉信息转换为文本。

- 强化学习框架:提出了一种名为“Visual Planning via Reinforcement Learning(VPRL)”的两阶段强化学习框架,通过GRPO(Group Relative Policy Optimization)对大型视觉模型进行后训练,显著提升了视觉导航任务中的规划性能。

主要特点

- 创新性:首次尝试让模型完全通过视觉表征进行规划,避免了将视觉问题强行转换为文本解释的模态不匹配问题。

- 高效性:VPRL框架通过随机初始化策略模型,鼓励探索,然后利用强化学习优化模型,使其能够更好地学习有效的视觉规划策略。

- 泛化能力:在实验中,VPRL不仅在训练集上表现出色,还展现出更强的泛化能力,能够更好地应对分布外的场景。

工作原理

- 第一阶段:策略初始化:通过在环境中进行随机漫步生成随机轨迹,训练模型生成有效的视觉状态序列,并保留探索能力。

- 第二阶段:强化学习:基于第一阶段初始化的模型,利用强化学习优化模型的规划能力。通过比较当前状态和生成的候选状态,计算奖励信号,引导模型朝着目标方向前进。

测试结果

- 性能提升:在FROZENLAKE、MAZE和MINIBEHAVIOR三个视觉导航任务中,VPRL的平均精确匹配率比传统的文本推理方法高出40%以上。

- 泛化能力:在分布外的测试场景中,VPRL展现出更强的泛化能力,能够更好地适应未见过的环境配置。

应用场景

- 机器人导航:帮助机器人在复杂环境中规划路径,避开障碍物,到达目标位置。

- 游戏设计:在游戏开发中,用于生成游戏关卡的布局或规划角色的行动路径。

- 辅助技术:为视障人士提供更直观的导航辅助,通过视觉规划帮助他们更好地理解周围环境。

- 自动驾驶:在自动驾驶领域,用于规划车辆的行驶路径,提高驾驶的安全性和效率。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...