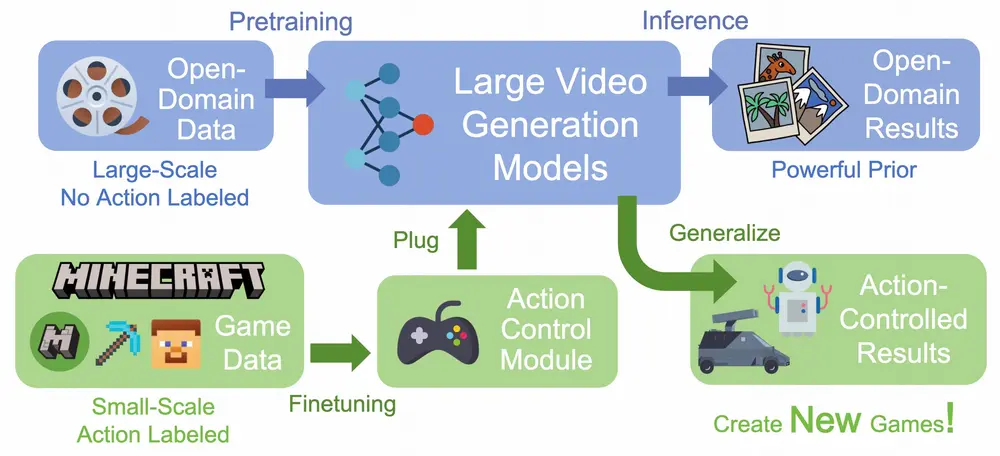

香港大学和快手科技的研究人员推出GameFactory框架,旨在通过生成式交互视频来创建全新的游戏。该框架利用预训练的视频扩散模型(video diffusion models),结合少量的第一人称游戏数据(如Minecraft数据),实现了在开放领域(open-domain)场景中生成可交互、可控制的游戏视频。这种方法突破了传统游戏生成方法在场景泛化(scene generalization)方面的限制,为游戏开发带来了全新的可能性。

- 项目主页:https://vvictoryuki.github.io/gamefactory

- GitHub:https://github.com/KwaiVGI/GameFactory

- 数据:https://huggingface.co/datasets/KwaiVGI/GameFactory-Dataset

例如,用户可以输入一个简单的提示(prompt),如“站在樱花森林中,手持枪械,第一人称视角”,GameFactory 能够生成一个符合该描述的游戏场景,并且用户可以通过键盘和鼠标操作(如WASD移动、鼠标转动视角)与场景进行交互,仿佛置身于一个真实的游戏世界中。此外,该框架还支持生成不同风格和场景的游戏,如文艺复兴时期的宫殿、雪山、赛车游戏等。

主要功能

- 生成开放领域的游戏场景:能够生成各种风格和场景的游戏视频,超越了传统方法对特定游戏或场景的限制。

- 可交互性:支持用户通过键盘和鼠标输入操作指令,实现对游戏场景的实时控制。

- 无限长度的视频生成:通过自回归(autoregressive)生成机制,可以生成任意长度的游戏视频,满足实际游戏开发的需求。

- 数据集生成:能够生成带有动作标注的数据集,为游戏开发和人工智能研究提供丰富的数据资源。

主要特点

- 场景泛化能力:通过预训练模型和少量游戏数据的结合,实现了从特定游戏风格到开放领域的泛化。

- 多阶段训练策略:采用分阶段训练方法,将游戏风格学习与动作控制学习解耦,避免了风格偏见对动作控制的影响。

- 高效的数据利用:利用开源的Minecraft游戏作为数据源,通过自动化生成动作标注数据,降低了数据收集成本。

- 自回归生成机制:支持连续视频流的生成,满足游戏开发中对连续交互的需求。

工作原理

- 预训练模型:基于大规模开放领域视频数据预训练的视频扩散模型,具备强大的生成能力。

- 动作控制模块:通过在预训练模型中嵌入动作控制模块,实现对用户输入(如键盘按键和鼠标移动)的响应。

- 多阶段训练:

- 阶段1(Phase #1):使用LoRA(Low-Rank Adaptation)技术对预训练模型进行微调,使其适应游戏视频数据,同时保留大部分原始参数。

- 阶段2(Phase #2):冻结预训练参数和LoRA参数,仅训练动作控制模块,专注于动作控制的学习,避免风格学习对动作控制的干扰。

- 阶段3(Phase #3):在推理阶段,移除LoRA权重,仅保留动作控制模块参数,实现开放领域的动作控制生成。

- 自回归生成:通过逐步生成后续帧的方式,实现无限长度的视频生成,支持连续的游戏体验。

具体应用场景

- 游戏开发:快速生成新的游戏场景和关卡,减少游戏开发中的人力和时间成本。

- 游戏测试:自动生成多样化的游戏场景,用于测试游戏的稳定性和兼容性。

- 人工智能研究:为研究自主智能体(如自动驾驶、机器人导航)提供丰富的模拟环境。

- 教育和娱乐:为教育和娱乐应用生成个性化的互动内容,如虚拟现实(VR)和增强现实(AR)体验。

- 内容创作:为视频创作者提供灵感,快速生成各种风格和场景的视频素材。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...