虚拟试穿(VTON)作为电子商务领域的一项关键技术,能够帮助消费者真实地预览服装在自己身上的效果。然而,早期的VTON技术受限于单一生成网络,在保留细粒度的服装细节方面存在不足。为了解决这个问题,研究人员尝试了双网络范式,尽管提高了性能,但也带来了计算成本增加的问题。

MN-VTON:一种新型虚拟试穿方法

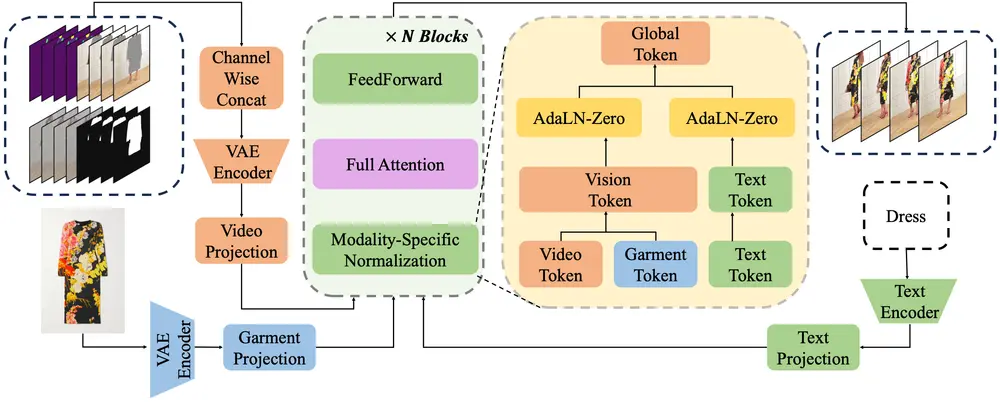

来自香港中文大学(深圳)和卡迪夫大学的研究团队提出了一种名为MN-VTON的的新型虚拟试穿(Virtual Try-On, VTON)方法,该方法旨在通过单个生成网络实现高质量的虚拟试穿效果,挑战了当前依赖双网络范式的主流方法。MN-VTON 通过引入模态特定归一化(Modality-specific Normalization)策略,解决了传统单网络方法在细节保留和特征融合方面的局限性,同时显著降低了计算开销。

- 项目主页:https://ningshuliang.github.io/2023/Arxiv/index.html

- GitHub:https://github.com/ningshuliang/1-2-1-MNVTON

例如,你是一名在线购物者,对某件衣服感兴趣,但不确定是否适合自己。通过 MN-VTON,你可以上传一张自己的照片和衣服的图片,系统将在几秒钟内生成一张你“试穿”该衣服的图像。你甚至可以上传一段视频,生成一个穿着该衣服的虚拟试穿视频,查看衣服在不同动作下的效果。这种技术不仅节省了时间和成本,还提供了高度个性化的购物体验。

主要功能

MN-VTON 的主要功能是将用户选择的服装(通过图像或视频形式提供)虚拟地“试穿”到目标人物身上,同时保留目标人物的原始姿态和外观。该方法支持以下功能:

- 图像虚拟试穿:将指定服装图像合成到目标人物图像上。

- 视频虚拟试穿:将服装图像或视频合成到目标人物视频中,同时保持时间连贯性。

- 多模态输入支持:同时处理文本描述、服装图像和目标视频/图像输入。

主要特点

- 单网络范式:与传统的双网络方法不同,MN-VTON 仅使用一个生成网络,显著减少了计算开销,提高了效率。

- 模态特定归一化:通过独立处理不同模态(文本、图像、视频)的输入,MN-VTON 能够更好地融合多模态特征,保留服装细节。

- 高质量细节保留:在图像和视频虚拟试穿中,MN-VTON 能够保留服装的纹理、图案和细节,同时避免模糊和失真。

- 可扩展性:该方法支持高分辨率图像和长时序视频的虚拟试穿,适用于多种应用场景。

工作原理

MN-VTON 的工作原理基于以下核心机制:

- 特征分裂与融合:通过将网络层的特征分裂为两部分(如文本特征和图像特征),并分别进行归一化处理,MN-VTON 能够有效融合多模态输入。

- 模态特定归一化:对不同模态的输入(如文本描述、服装图像、目标图像/视频)分别进行归一化处理,保留服装细节并增强特征融合效果。

- 图像-视频联合训练:通过在图像和视频数据集上联合训练,MN-VTON 学会了在保持时间连贯性的同时生成高质量的服装细节。

具体应用场景

- 电子商务:在在线购物中,消费者可以通过 MN-VTON 虚拟试穿不同服装,提升购物体验,减少退货率。

- 时尚设计:设计师可以利用该技术快速预览服装设计效果,优化设计流程。

- 娱乐与社交媒体:用户可以创建个性化的虚拟试穿视频或图像,用于社交媒体分享或娱乐应用。

- 虚拟现实与增强现实:在虚拟现实(VR)或增强现实(AR)应用中,MN-VTON 可以实时生成虚拟试穿效果,增强用户体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...