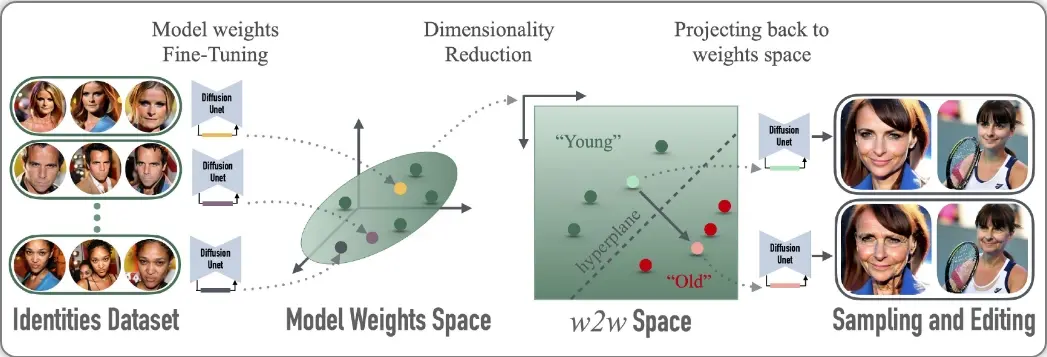

基于定制化扩散模型权重的子空间weights2weights(w2w):能够支持从单一图像中提取视觉身份,编辑模型中编码的身份,以及采样新模型来编码多样化的人物实例

加州大学伯克利分校、Snap和斯坦福大学的研究人员推出weights2weights(w2w),这是一个基于定制化扩散模型权重的子空间,能够支持从单一图像中提取视觉身份,编辑模型中编码的身份,以及采样新模型来编码多样化的人物实例。例如,我们有一台能够生成人脸图像的机器。通常,这台机器会随机生成各种各样的面孔。但是,如果我们想要生成特定人物的图像,或者在生成的图像中做出一些特定的改变(比如给人物加上胡子),我们就需要对这台机器进行一些调整。这篇论文介绍的方法,就像是给这台机器提供了一个可以精细调节的旋钮,让我们可以精确地控制生成的面孔的身份特征。

- 项目主页:https://snap-research.github.io/weights2weights

- GitHub:https://github.com/snap-research/weights2weights

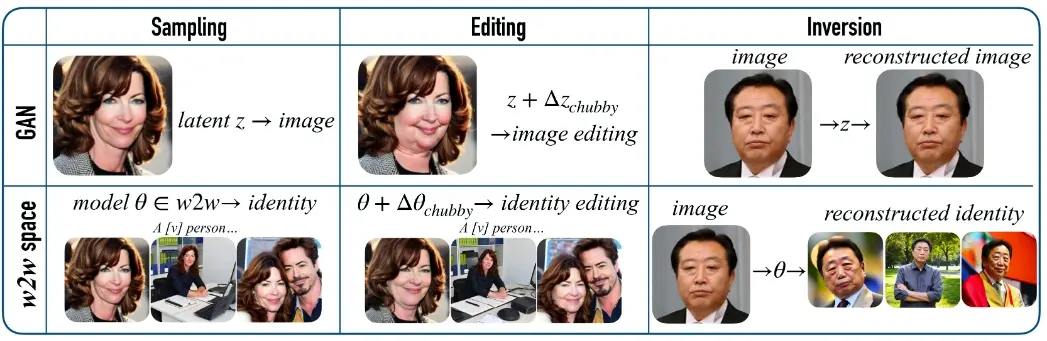

研究人员探究了一个由大量定制化扩散模型界定的权重空间。为了构建这一空间,研究人员创建了一个包含超过60,000个模型的数据集,每个模型都是通过对基础模型进行微调以植入不同个人的视觉特征得到的。研究人员把这众多权重背后的流形视作一个子空间,称之为“weights2weights”。研究人员展示了该空间三大即时应用:取样、编辑及反转。首先,因为空间内的每一个点都代表一种身份,故从此空间中抽取一套权重就能生成一个表达新身份的模型。其次,研究人员发现在此空间中存在与身份语义修改(例如,增添胡须)相应的线性路径。这些修改效果在生成的各个样本中表现一致。最后,实验证明了即便是输入一张分布外的图像(如一幅画),将其反转映射到这一空间中也能重建出一个逼真的人像身份。研究结果揭示,经微调的扩散模型的权重空间堪比一个可解读的身份隐含空间。

主要功能:

- 采样(Sampling):从w2w空间中采样新的模型权重,以生成具有新颖身份特征的图像。

- 编辑(Editing):在w2w空间中找到与特定身份属性(如胡须、年龄等)相关的权重方向,并对生成的图像进行语义编辑。

- 反演(Inversion):将单一图像的视觉身份特征反演到w2w空间中,重构出能够一致生成该身份特征的模型。

主要特点:

- 权重空间的可解释性:与传统的生成对抗网络(GANs)不同,w2w空间直接在模型权重上进行操作,提供了一种可解释的方式来控制和编辑生成图像的身份特征。

- 高效率:通过低秩近似(LoRA)和主成分分析(PCA),研究者们能够高效地处理和操作大量的模型权重。

- 跨领域应用:w2w空间不仅可以用于人脸图像的生成,还有潜力被推广到其他类型的视觉数据生成和编辑。

工作原理:

- 创建权重数据集:通过Dreambooth方法对大量不同个体进行定制化扩散模型的微调,得到一组权重数据点,每个数据点代表一个特定身份。

- 建立权重子空间:使用PCA对这些权重数据点进行降维处理,形成一个低维的权重子空间,即w2w空间。

- 探索权重空间:在w2w空间中找到与特定身份属性相关的线性方向,用于编辑身份特征;通过采样新的权重组合,生成具有新身份特征的模型。

- 反演和编辑:将单一图像的视觉身份特征映射到w2w空间中,优化模型权重以重构该身份特征;在w2w空间中对权重进行微调,实现对生成图像的精确编辑。

具体应用场景:

- 个性化图像生成:为每个人创建独特的虚拟形象或头像。

- 艺术创作:通过编辑特定的身份特征,辅助艺术家进行创作。

- 娱乐和游戏:在视频游戏或电影制作中生成具有特定身份特征的角色。

- 身份验证和安全:利用身份特征的编辑和重构,提高身份验证系统的准确性和安全性。

总结来说,研究人员提出了一种新的方法来探索和操作生成模型的权重空间,使得我们可以更加精细和直观地控制生成图像的身份特征,为视觉艺术创作、个性化内容生成和身份编辑提供了强大的工具。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...