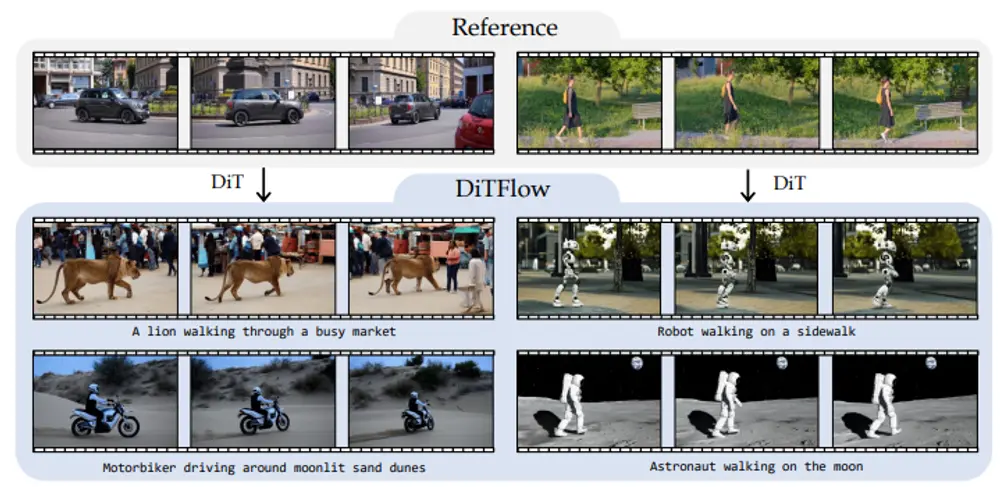

介绍了一种名为DiTFlow的方法,它是一种专为DiT架构模型设计的运动转移方法。DiTFlow通过分析参考视频,提取出一种名为注意力运动流(Attention Motion Flow,简称AMF)的补丁级运动信号,并在无需训练的情况下,通过优化潜在表示来引导新合成视频内容的生成,使其复现参考视频的运动。

例如,我们有一个参考视频,显示一只狮子在繁忙的市场中行走。我们想要合成一个新的视频,内容是一个机器人在人行道上行走,但要保留狮子行走的运动模式。DiTFlow能够分析狮子行走的运动模式,并将其应用到机器人的视频内容中,使得机器人的行走方式与狮子相似。

主要功能:

DiTFlow的主要功能是将一个参考视频中的运动模式转移到新合成的视频内容中。这使得用户可以控制合成视频的动态,而不仅仅是其外观。

主要特点:

- 训练自由:DiTFlow不需要额外的训练步骤,它通过优化过程来实现运动转移。

- 注意力运动流(AMF):DiTFlow提出了AMF这一新的运动表示方法,它通过分析DiT中的注意力机制来提取运动信息。

- 零样本运动转移:通过优化DiT中的位置嵌入,DiTFlow能够在不需要进一步优化的情况下,将学习到的运动模式应用到新的合成视频中,实现零样本(zero-shot)运动转移。

- 跨架构适用性:DiTFlow的运动表示独立于输入内容,可以应用于不同的目标条件。

工作原理:

DiTFlow首先使用预训练的DiT处理参考视频,分析跨帧注意力图,并提取AMF。然后,它通过优化潜在表示来引导新视频内容的生成,使其复现参考视频的运动。具体来说,DiTFlow通过优化步骤来最小化参考AMF和当前去噪步骤之间的距离,从而在中间去噪步骤中为生成的视频复现相同的AMF。

具体应用场景:

- 视频编辑和创作:DiTFlow可以用于视频编辑工作流程中,将特定的运动模式应用到新的场景中,创造新的视频内容。

- 机器人模拟:在机器人训练和模拟中,DiTFlow可以用来生成具有现实运动模式的视频,以提高模拟的真实性。

- 内容创作:在电影制作或游戏设计中,DiTFlow可以帮助创作者将现实世界的运动转移到虚拟角色上,增强视觉效果。

- 教育和培训:DiTFlow可以用于创建教育视频,通过将特定的运动模式转移到教学内容中,提高学习效果。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...