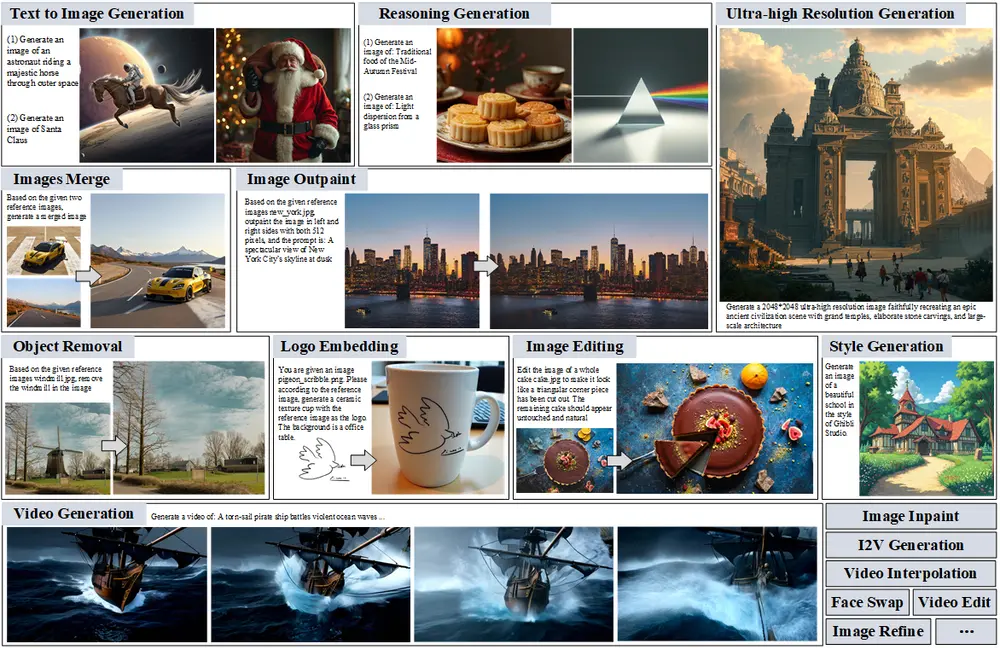

随着生成模型的飞速发展,“通用生成(General-Purpose Generation)”正成为 AI 领域的新焦点。它旨在通过一个统一系统,支持图像、视频、文本等多种模态任务的生成与编辑,为复杂创作流程提供端到端解决方案。

然而,尽管已有不少开源框架尝试实现这一目标,但普遍存在结构脆弱、反馈机制缺失、难以应对真实世界需求等问题。

为了解决这些挑战,来自香港科技大学与字节跳动的研究团队提出了一项全新方案 —— ComfyMind,一个基于 ComfyUI 平台构建的协作式 AI 系统,致力于打造稳定、灵活、可扩展的通用生成平台。

什么是 ComfyMind?

ComfyMind 是一个面向视觉内容生成的协作 AI 系统,其核心理念是将复杂的生成任务视为模块化、语义化的规划过程,并通过树形搜索规划 + 局部反馈执行机制,显著提升生成工作流的稳定性与灵活性。

该系统已在多个公共基准测试中表现出色,性能媲美 OpenAI 的 GPT-Image-1,并超越现有主流开源基线模型。

ComfyMind 的两大核心技术

✅ 1. 语义工作流接口(Semantic Workflow Interface, SWI)

传统工作流系统依赖复杂的节点图配置,对用户操作门槛高且容易出错。

而 SWI 将这些低级节点抽象为自然语言描述的功能模块,使用户能像调用 API 一样使用预定义的“原子工作流”。

例如:"生成一个月光下的精灵跳舞画面"

会被自动拆解为:

- 生成精灵主体图像

- 添加月光效果

- 调整姿势为舞蹈动作

这种设计不仅降低了使用难度,也提升了模块之间的组合能力。

✅ 2. 搜索树规划 + 局部反馈执行机制

ComfyMind 将生成过程建模为层次化决策问题,每个子任务对应一个节点,每条路径代表一种可能的工作流组合。

更关键的是,系统在执行过程中会根据局部反馈进行动态调整,而不是简单地失败回滚。这大大提高了复杂任务的成功率,并增强了系统的容错能力。

主要功能

- 通用生成与编辑:支持多种图像和视频生成及编辑任务,涵盖文本到图像生成、图像编辑、视频生成、视频插值等。

- 语义工作流接口(SWI):将低级节点图抽象为可调用的功能模块,减少结构错误,提升工作流的灵活性和可扩展性。

- 搜索树规划与局部反馈执行:将生成任务建模为分层决策过程,允许在每个阶段进行自适应校正,显著增强系统的稳定性和灵活性。

- 模块化工作流组合:通过语义组合模板工作流,实现更稳定和可控的任务组合,支持快速适应社区贡献的新模型和任务。

主要特点

- 模块化与语义化:通过语义工作流接口(SWI),将复杂的生成任务分解为模块化的子任务,每个子任务对应一个原子工作流。

- 自适应规划与反馈:搜索树规划机制允许系统在执行过程中根据局部反馈进行自适应调整,避免全局回滚,提高任务成功率。

- 灵活性与可扩展性:系统支持快速集成社区贡献的新工作流和模型,能够快速适应新任务和新需求。

- 高性能与稳定性:在多个基准测试中,ComfyMind 显著超越了现有的开源基线模型,并达到了与 GPT-Image-1 相当的性能。

工作原理

- 语义工作流接口(SWI):将低级节点图抽象为自然语言描述的功能模块,减少对平台特定语法的依赖,降低结构错误。

- 搜索树规划:将任务执行建模为分层决策过程,每个节点代表一个子任务,每条边对应一个 SWI 模块。在执行过程中,失败会触发当前层级的局部校正。

- 局部反馈执行:在每个规划节点,执行代理将选定的功能映射为其对应的 JSON 表示形式,并在 ComfyUI 平台上执行工作流。执行结果会反馈给规划代理,用于后续决策。

- 自适应参数调整:执行代理根据高级约束对 JSON 进行轻量级参数调整,确保生成结果满足用户需求。

测试结果

- ComfyBench:ComfyMind 在 ComfyBench 基准测试中实现了 100% 的通过率和 83.0% 的任务解决率,显著优于现有的开源基线模型。

- GenEval:在文本到图像生成任务中,ComfyMind 实现了 0.90 的整体性能评分,超越了所有基线方法,包括 GPT-Image-1。

- Reason - Edit:在图像编辑任务中,ComfyMind 达到了 0.906 的 GPT 分数,超越了所有开源系统,并与专有模型的性能相当。

ComfyMind 的出现,为开源通用生成 AI 系统的开发开辟了一条充满前景的道路,有望推动生成模型在更多领域的广泛应用。

相关文章