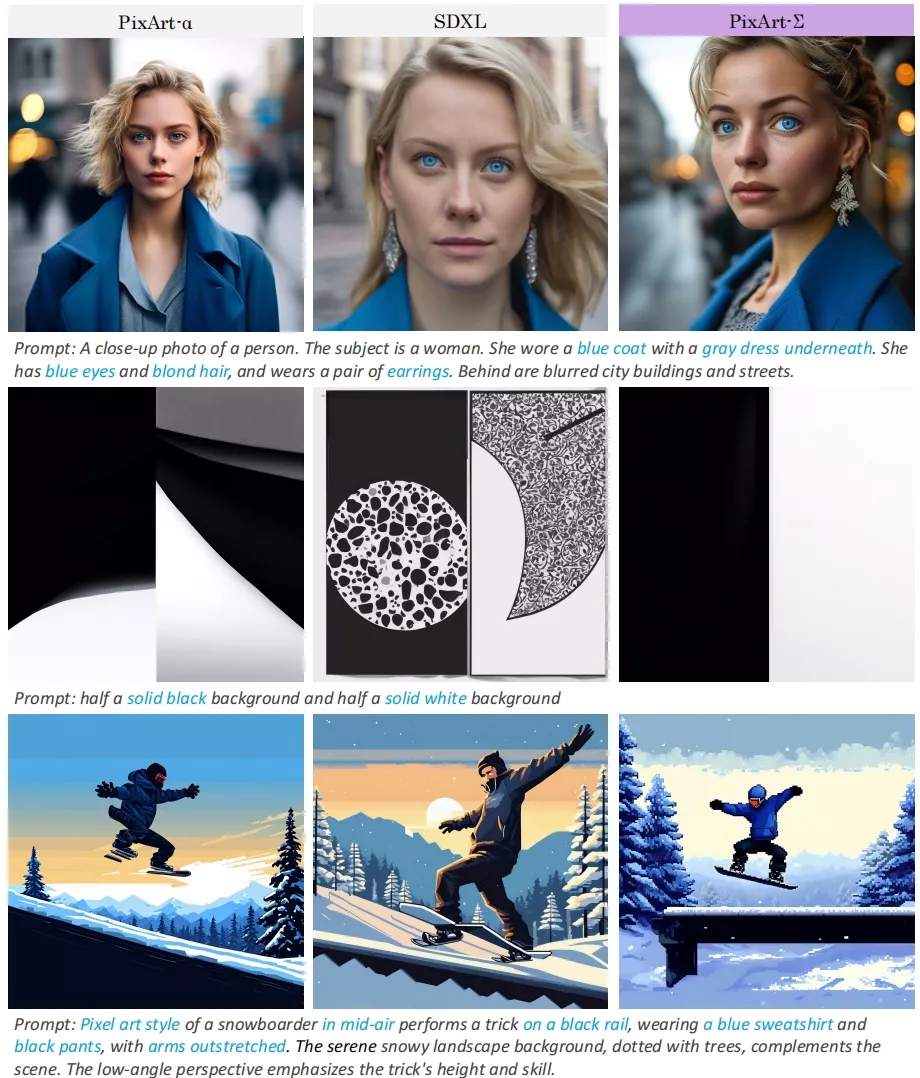

PixArt-α与PixArt-LCM模型

来自华为诺亚方舟实验室、大连理工大学、香港大学的研究团队推出的开源文生图模型PixArt系列,在近期发布了基于DiT架构的新模型PixArt-Σ,可以直出4K图片,不过官方尚未释出模型,但之前推出的PixArt-α与PixArt-LCM模型已经能够生成质量非常高的图片了,只是关注度小,针对此系列模型的优化、第三方应用及衍生模型都非常少。

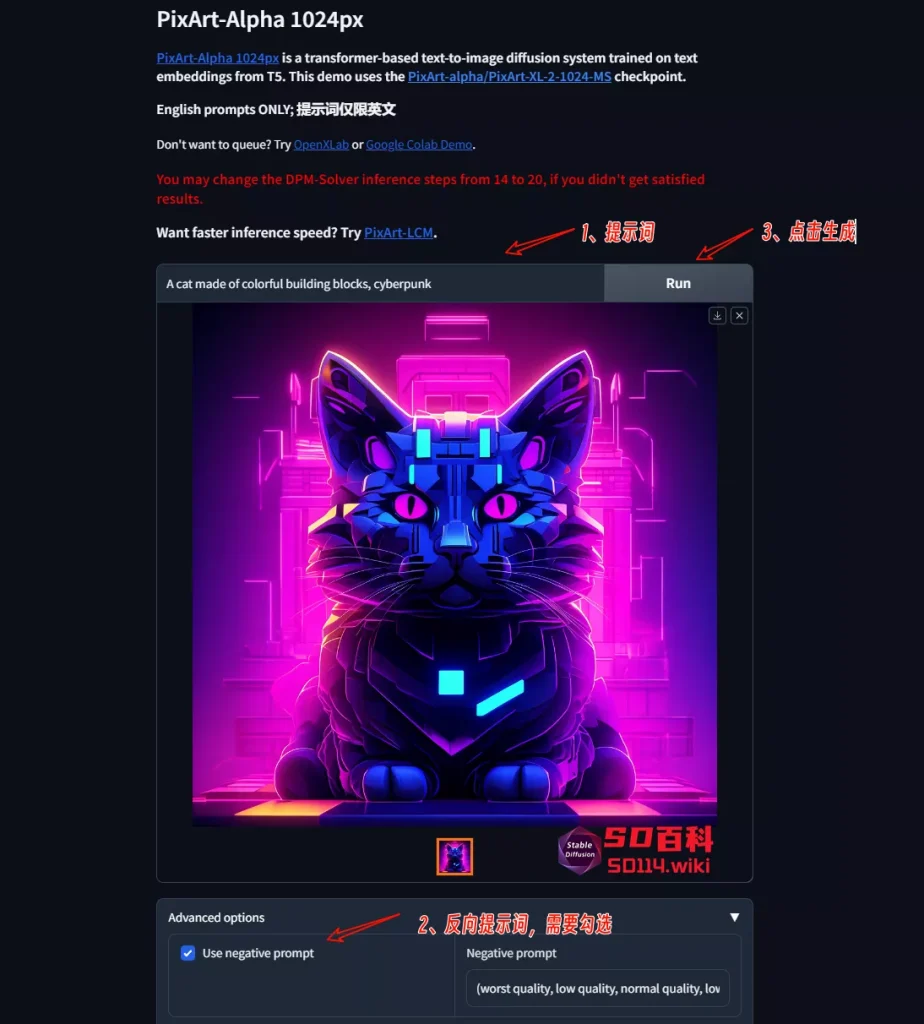

想要体验此模型可以使用官方提供的Demo,也可以本地自己搭建,目前ComfyUI已有两款插件支持在本地运行此模型,今天就来看看吧!

视频说明:

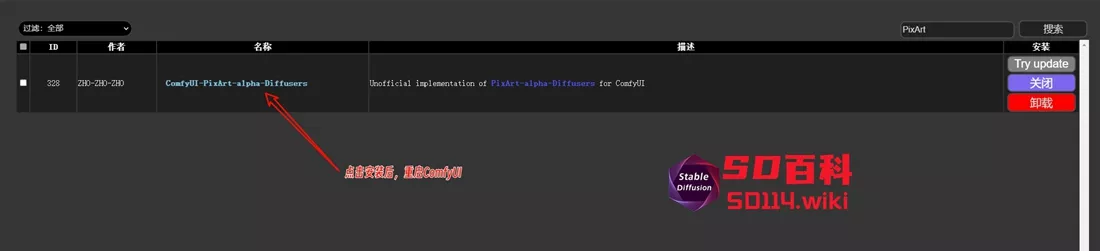

ComfyUI-PixArt-alpha-Diffusers

插件地址:https://github.com/ZHO-ZHO-ZHO/ComfyUI-PixArt-alpha-Diffusers

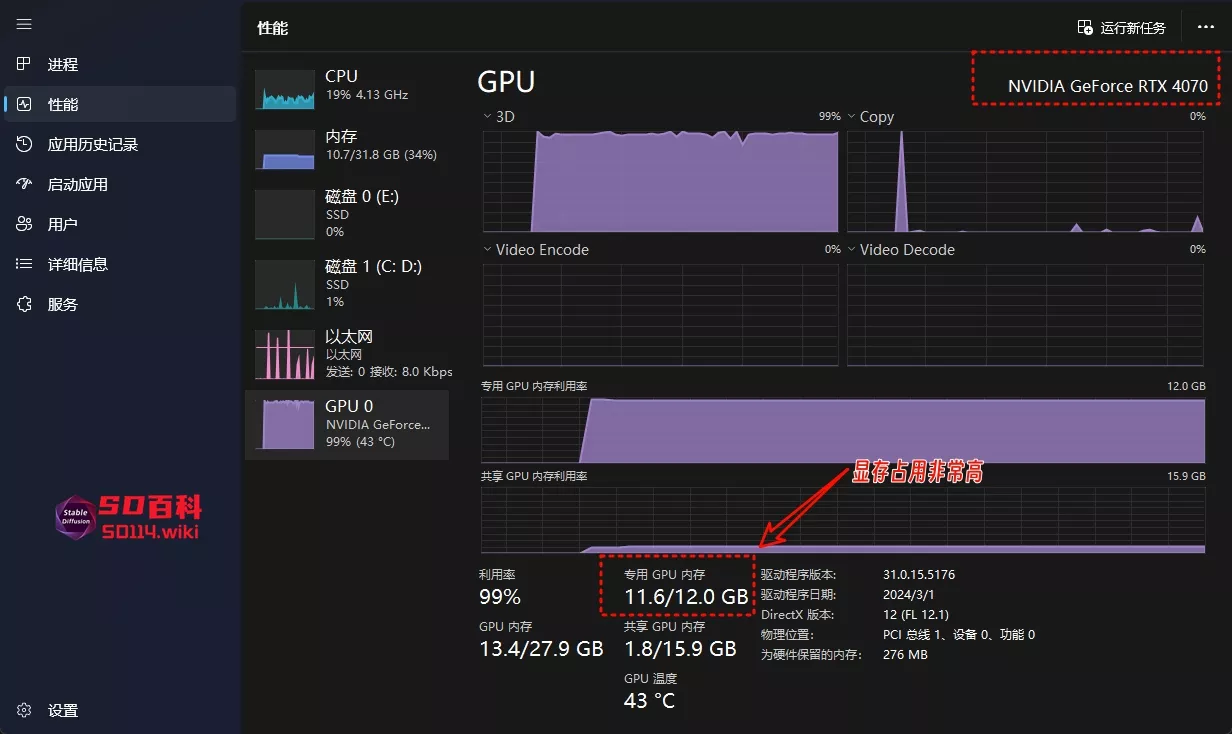

此插件是由ZHO-ZHO-ZHO开发,这位开发者对于新模型及技术反应非常快,基本上新出的模型及技术,他都会第一时间在ComfyUI上推出插件,提供接近于官方Demo的体验,但官方Demo在Hugging Face所使用的GPU,基本都是A10甚至A100,而普通用户所使用的GPU在运行这些新模型的时候就比较吃力,比如此插件在运行PixArt-α模型进行图片生成对应显存占用就非常高,生成时间非常长。

如何安装

对于插件安装,请参考:插件安装

1、推荐使用管理器 ComfyUI Manager 安装

2、手动安装:

cd custom_nodes

git clone https://github.com/ZHO-ZHO-ZHO/ComfyUI-PixArt-alpha-Diffusers.git

cd custom_nodes/ComfyUI-PixArt-alpha-Diffusers

pip install -r requirements.txt

重启 ComfyUI如何使用

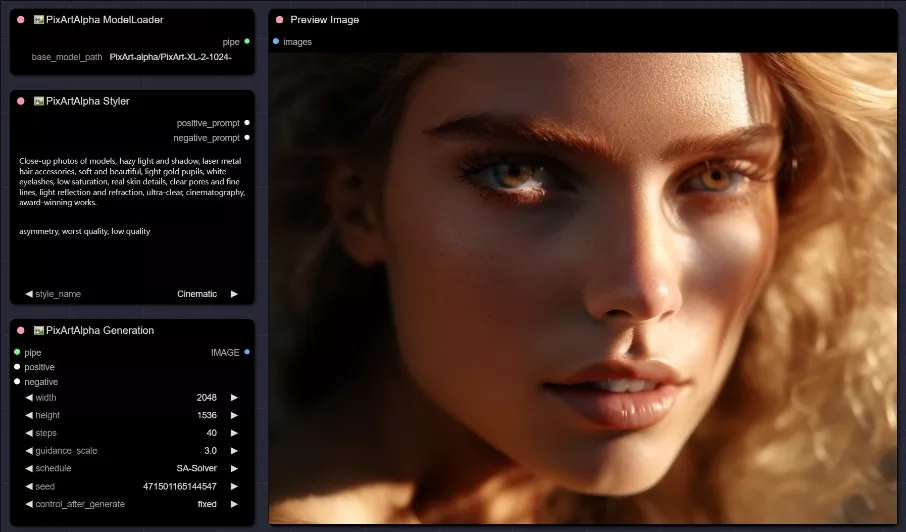

此插件提供了三个节点,基本上就是复刻官方Demo提供的功能,那么你的设置就可以参考官方Demo所给出的设置。

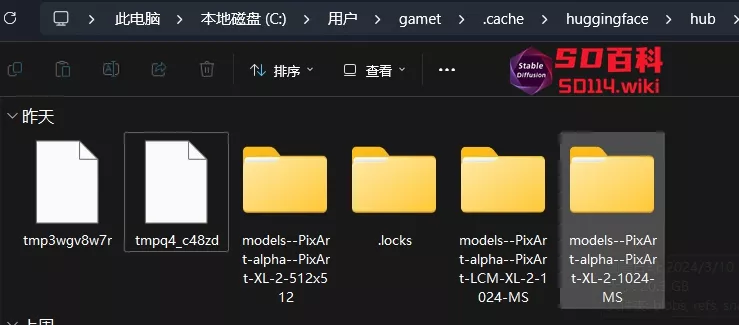

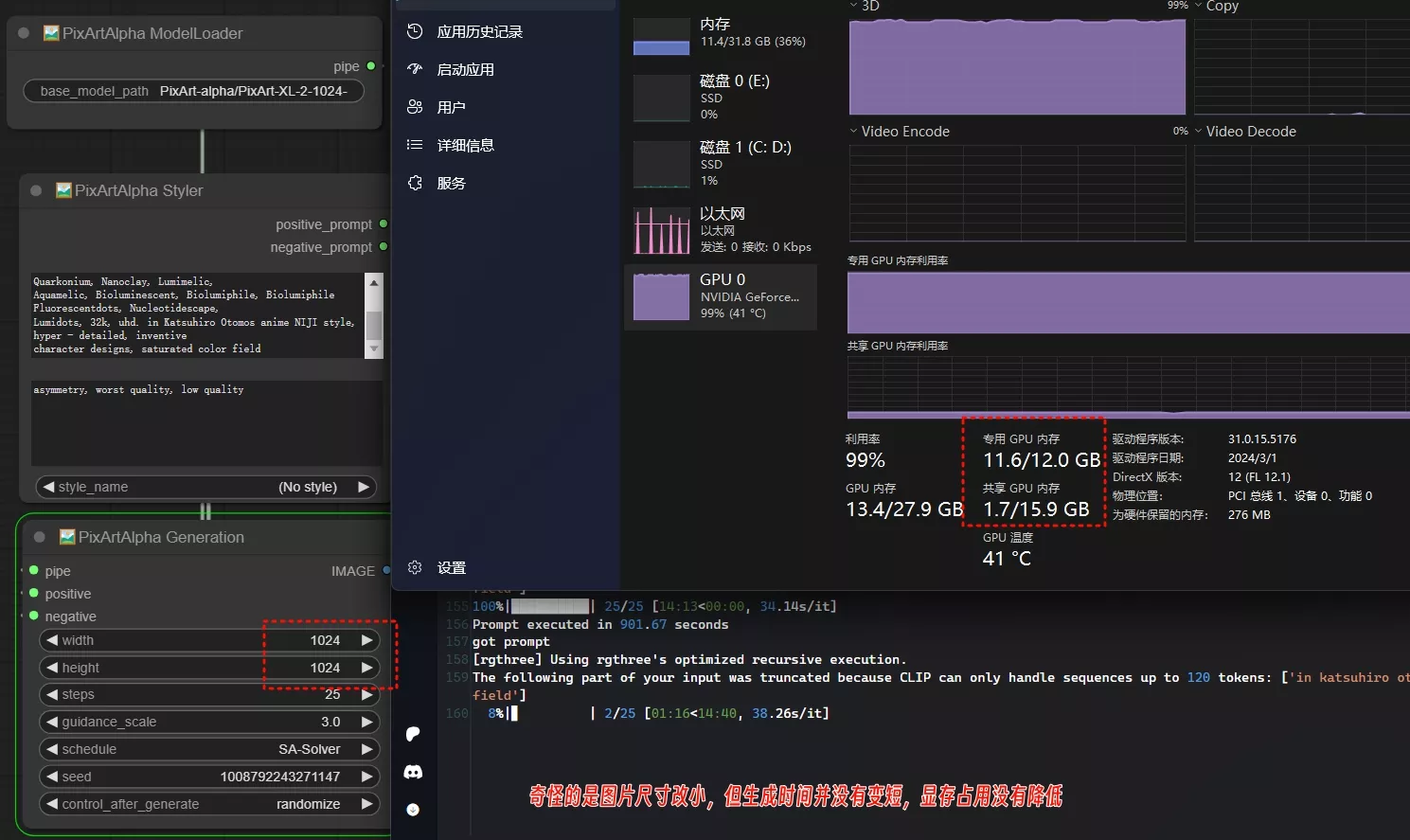

🖼️PixArtAlpha ModelLoader:加载模型

支持从 huggingface hub 自动下载模型,输入模型名称(如:PixArt-alpha/PixArt-XL-2-1024-MS)即可,模型会下载到C:\Users\用户名\.cache\huggingface\hub文件夹下,模型有20.3G这么大,因此C盘空间小的朋友谨慎下载

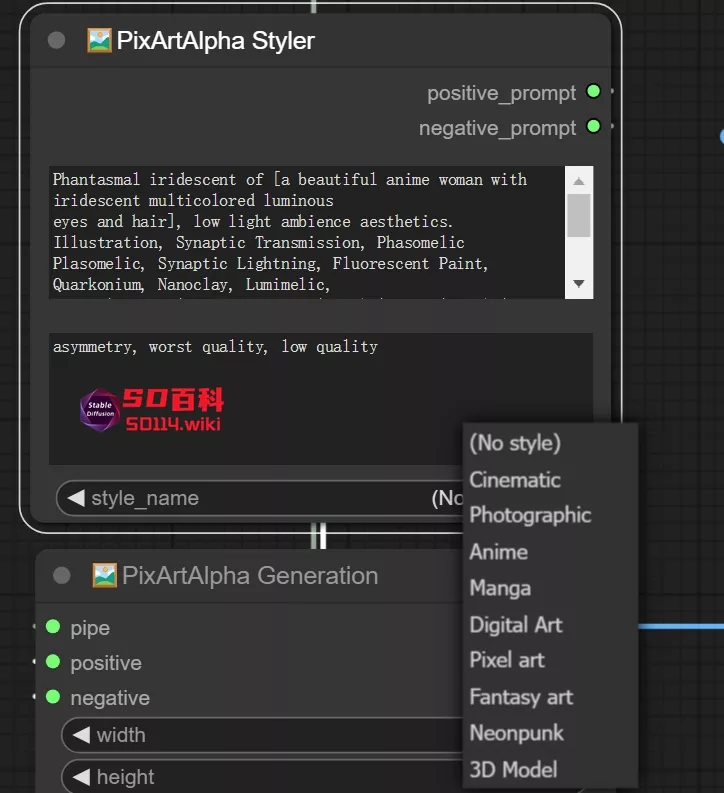

🖼️PixArtAlpha Styler:提示词与风格

- 与各种提示词(文本)输入(如肖像大师等)、styler、 Photomaker Prompt_Styler 兼容

- prompt、negative:正负提示词

- style_name:支持官方提供的10种风格

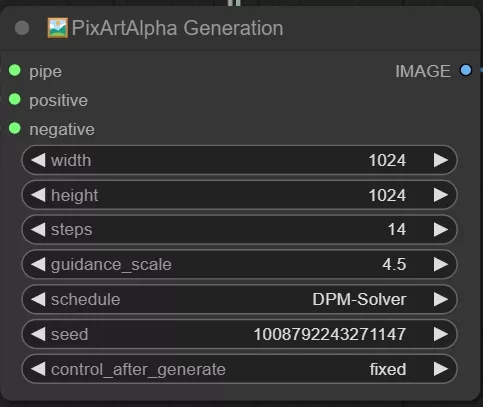

🖼️PixArtAlpha Generation:参数设置

- pipe:接入模型

- positivet、negative:正负提示词

- width、height:宽度、高度

- step:步数,官方默认20-25步

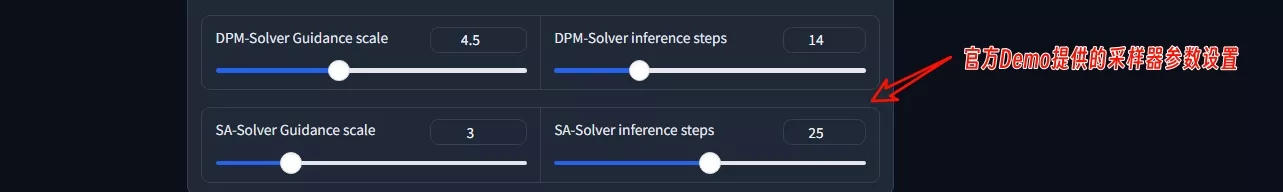

- guidance_scale:提示词相关度,DPM-Solver默认为4.5,SA-Solver默认为3

- schedule:2种调度器,DPM-Solver 和 SA-Solver

- seed:种子

对于采样器的设置大家可以参考官方Demo,DPM-Solver可设置范围5~40,SA-Solver可设置范围10~40

三个节点即可组成一个PixArt模型基础工作流

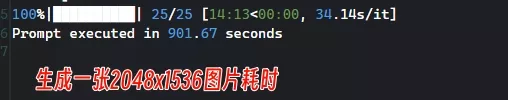

此模型及插件没有优化,因此在生成图片的时候对于显存占用非常高,生成图片速度也非常慢,一张2048x1536的图片生成要14分钟多。

奇怪的是将尺寸更改为1024x1024,显存占用及生成时间并没有降低

更改采样器,生成速度基本没有改变,对于显卡不好的朋友,此插件谨慎尝试

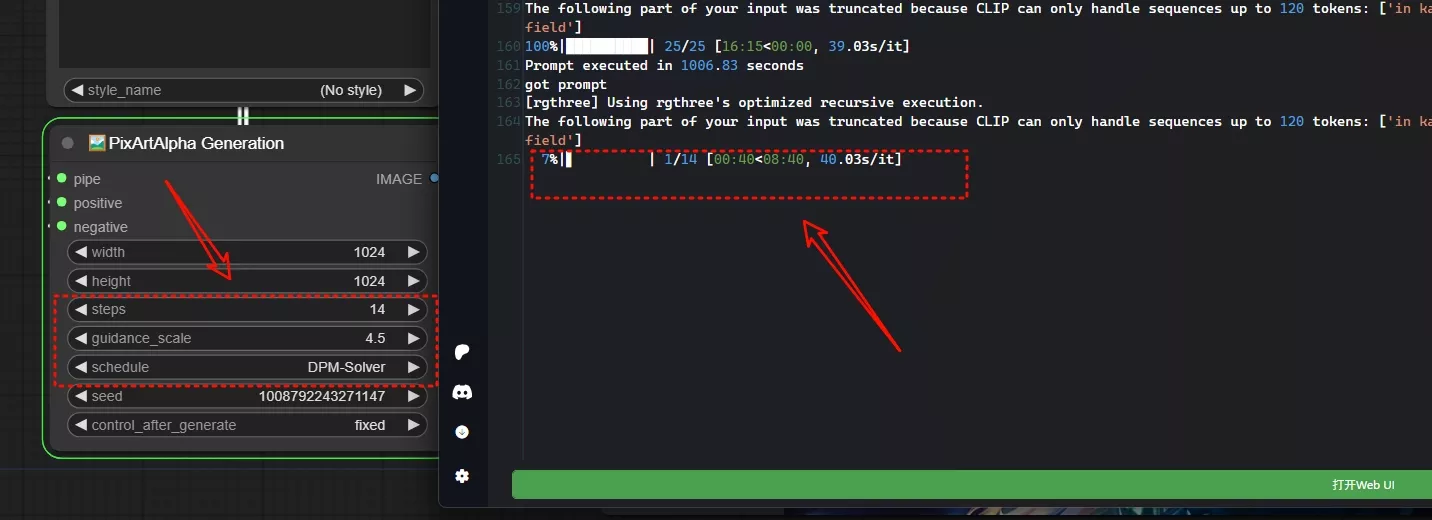

生成效果

提示词:

Phantasmal iridescent of [a beautiful anime woman with iridescent multicolored luminous eyes and hair], low light ambience aesthetics. Illustration, Synaptic Transmission, Phasomelic

Plasomelic, Synaptic Lightning, Fluorescent Paint, Quarkonium, Nanoclay, Lumimelic,Aquamelic, Bioluminescent, Biolumiphile, Biolumiphile Fluorescentdots, Nucleotidescape,

Lumidots, 32k, uhd. in Katsuhiro Otomos anime NIJI style, hyper - detailed, inventive character designs, saturated color field尺寸:2048x1536 (图片上传网站,有压缩)

尺寸:1024x1024

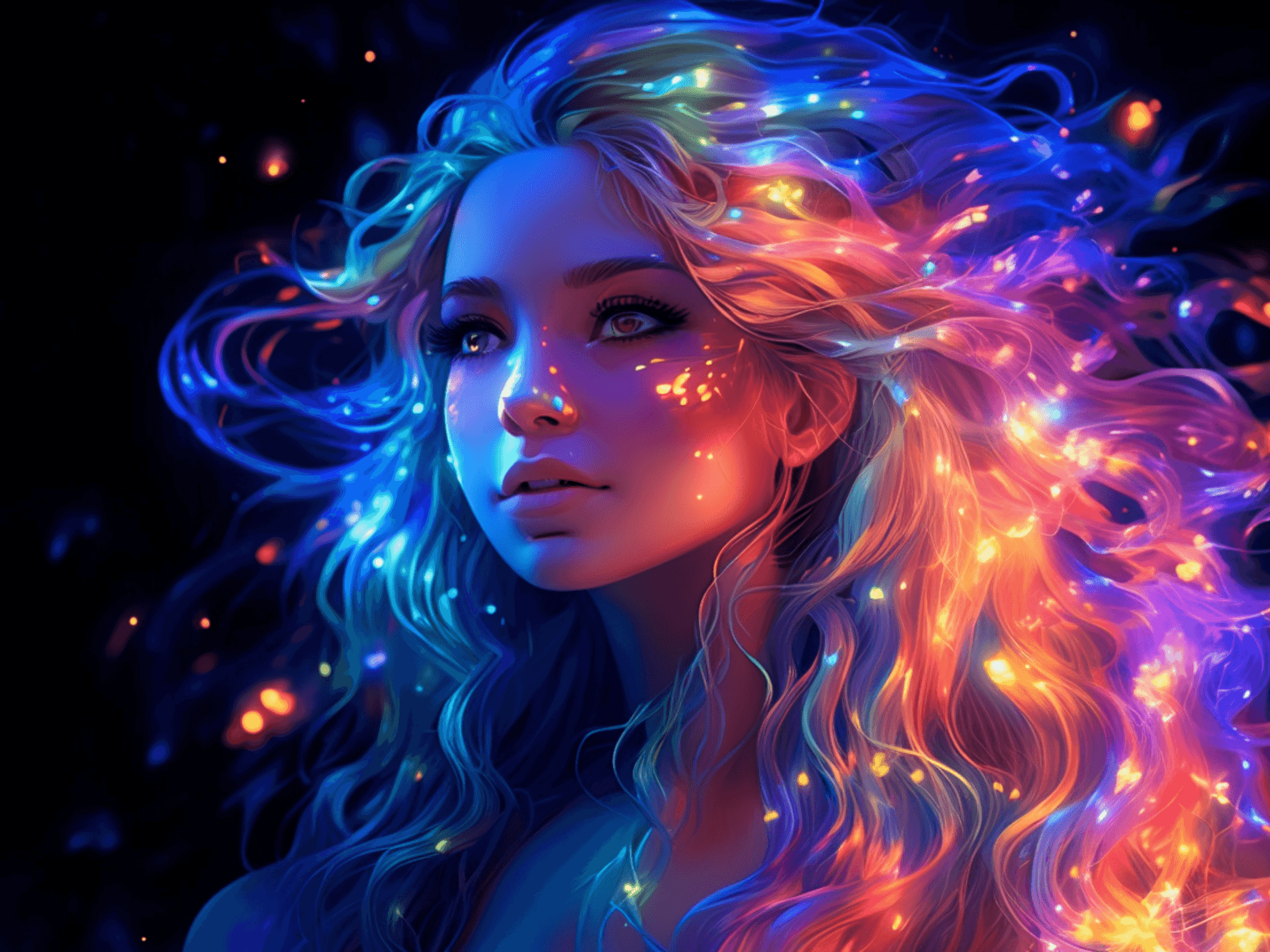

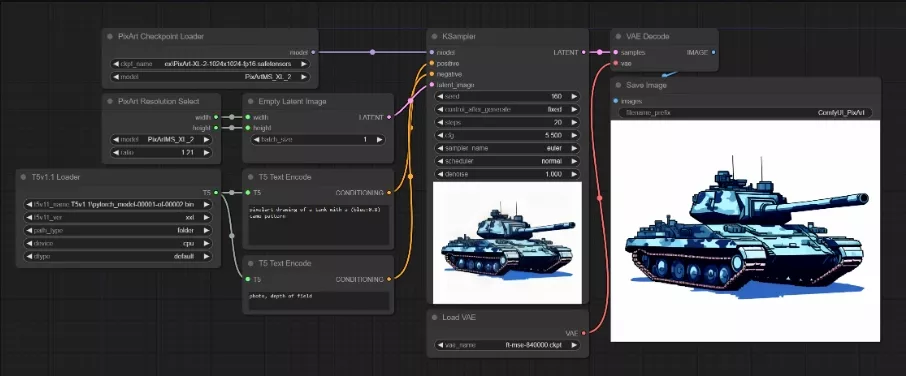

Extra Models for ComfyUI

插件地址:https://github.com/city96/ComfyUI_ExtraModels

PixArt开发者官方推荐的ComfyUI插件,但此插件更新较少,对于官方的采样、风格支持并不好,但生成速度比ComfyUI-PixArt-alpha-Diffusers快非常多,只是在加载T5模型的时候对于电脑内存占用非常高,还有爆内存的风险。

如何安装

手动安装依赖会比较麻烦,使用管理器 ComfyUI Manager 安装。

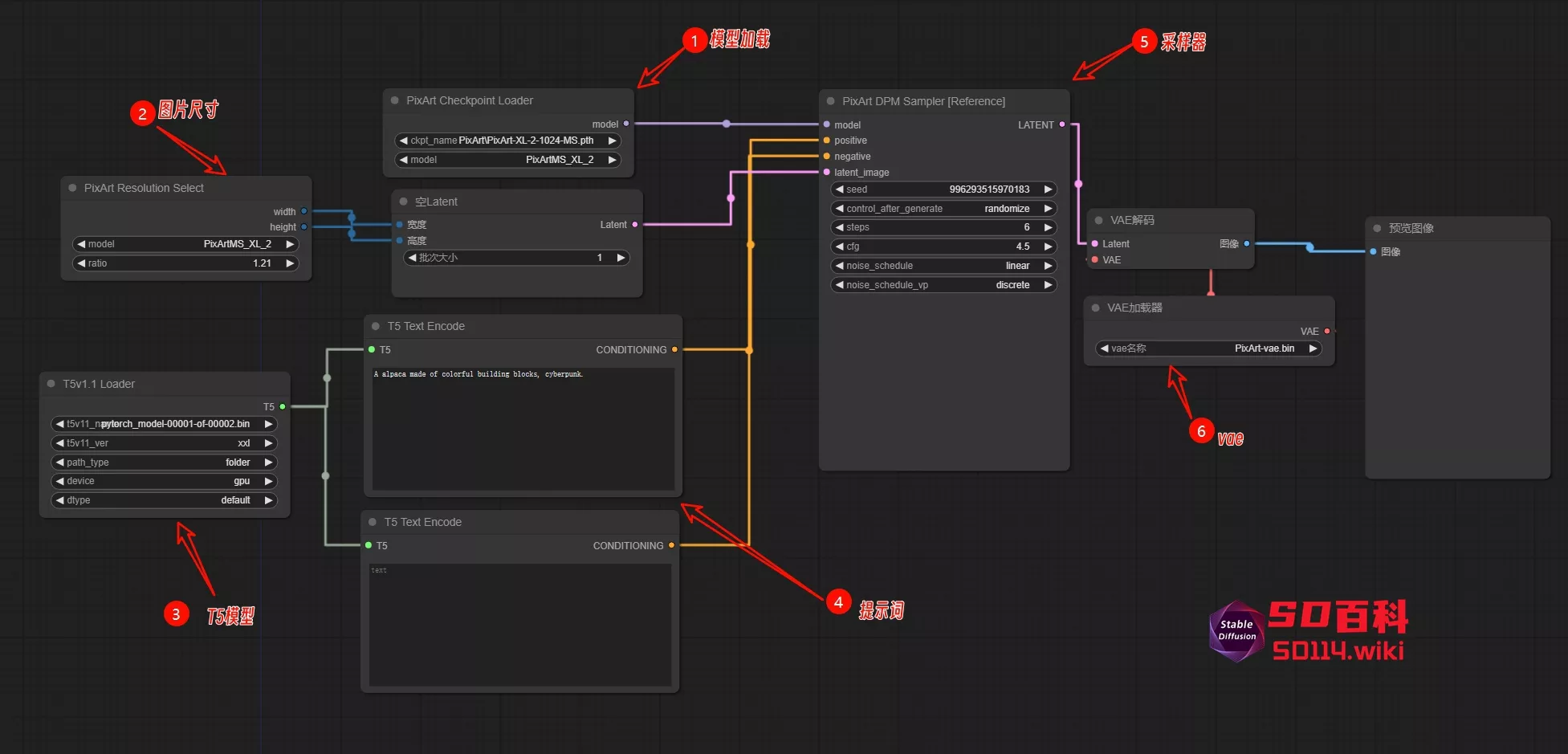

如何使用

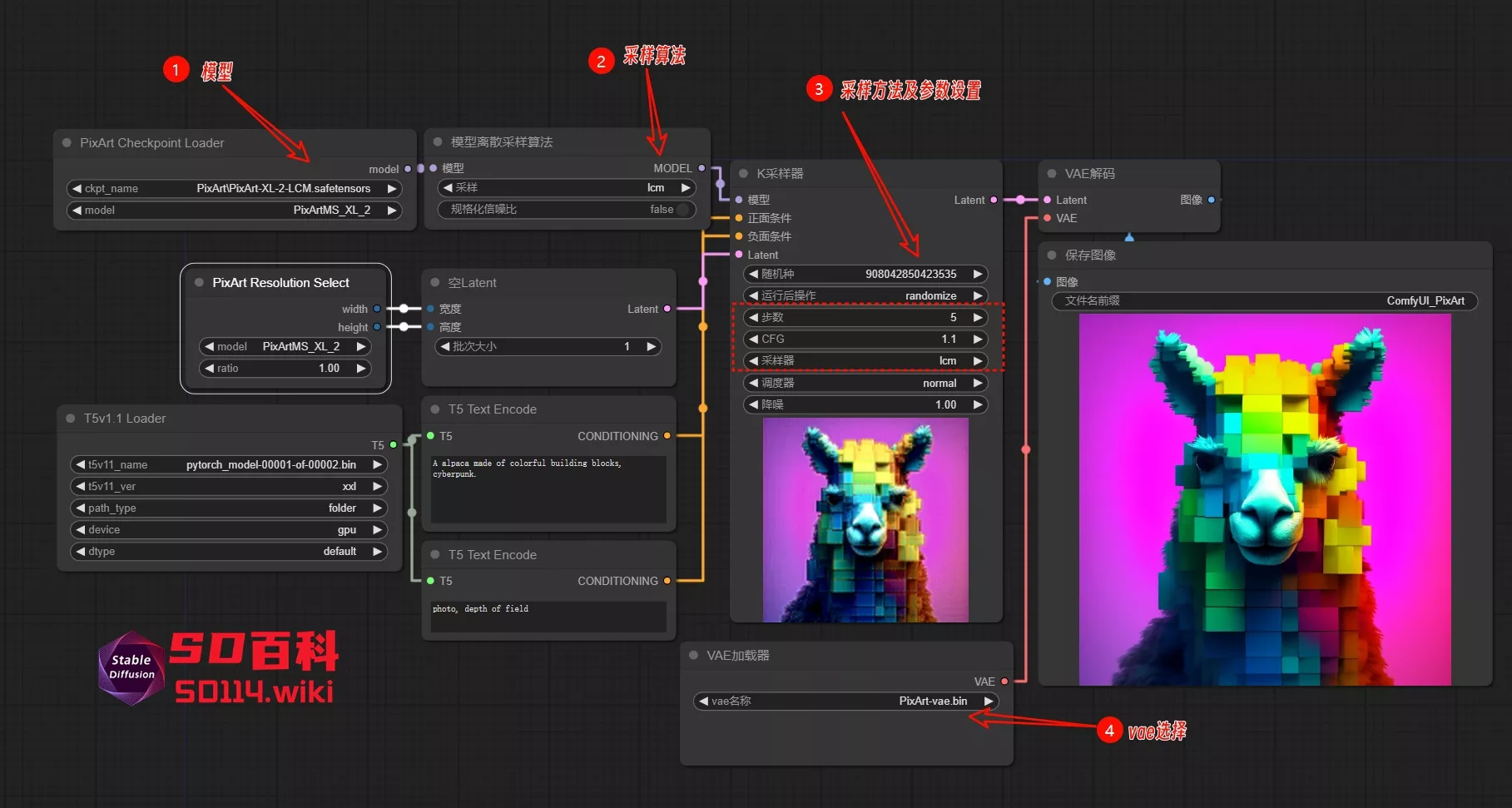

PixArt工作流

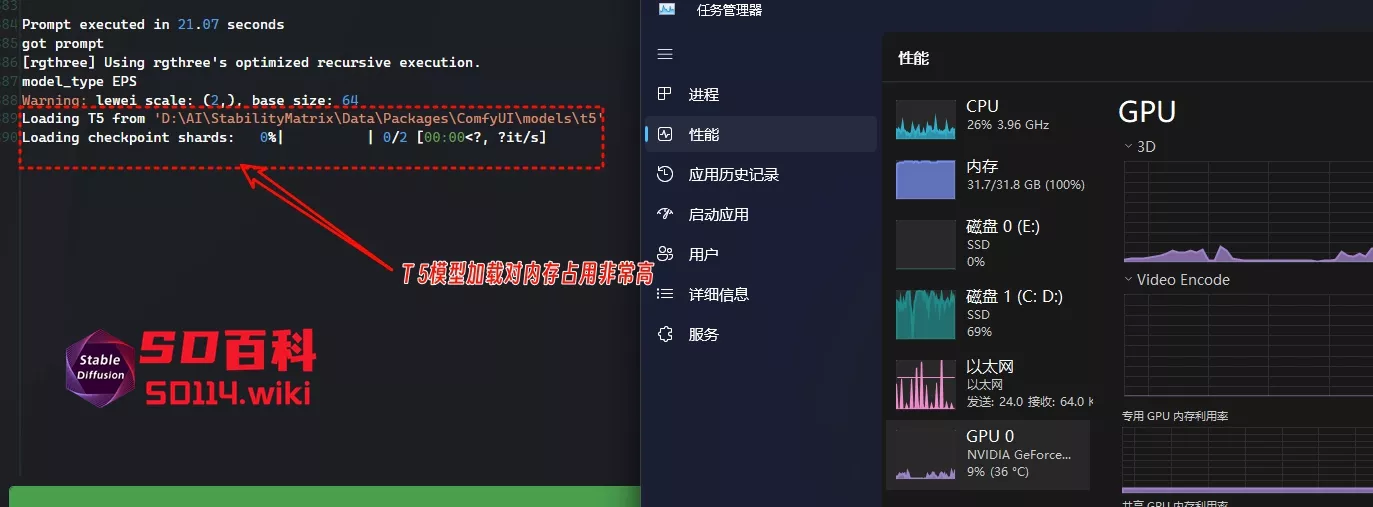

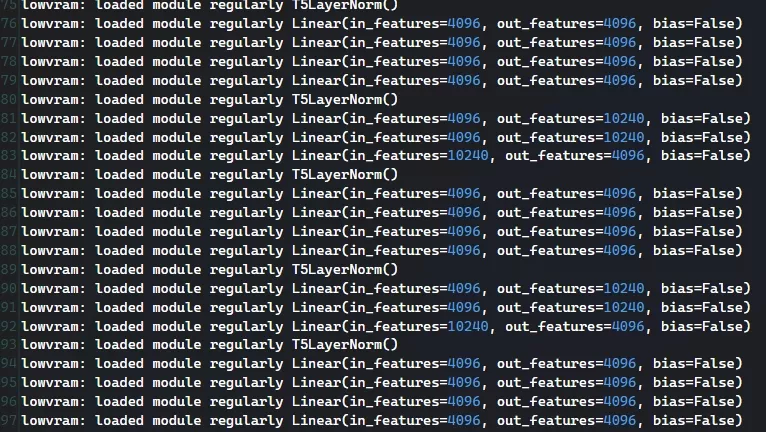

此插件将PixArt模型与T5模型分开加载,每次重写提示词都会加载一次T5模型,T5模型加载的时候,电脑内存占用非常高,虽然有爆内存的风险。

T5模型:由Google Brain团队在2019年提出的一种基于Transformer结构的预训练语言模型,全称为Text-to-Text Transfer Transformer,即文本到文本转移Transformer。T5模型的主要目标是通过一种统一的文本到文本的预训练框架,实现多种NLP任务的预训练和微调。

模型下载:

- PixArt-XL-2-1024-MS.pth下载后放到ComfyUI\models\checkpoints文件夹下

- t5-v1_1-xxl文件夹下载所有文件都下载,下载后放到ComfyUI\models\t5文件夹下

- diffusion_pytorch_model.bin下载后放到ComfyUI\models\vae文件夹下

对内存占用直接飙到100%,因此在使用此工作流的时候,请关闭其他应用

每次生成都有爆内存的风险

PixArt LCM工作流

此工作流在基础的PixArt工作流上添加一个ModelSamplingDiscrete节点,然后采样算法和采样器都选择lcm,参数方面CFG 应该设置在1.1~1.5,步数设置在4~10

此插件图片尺寸设置方面比较特殊,通过调整ratio参数来改变大小,基础的1是1024x1024

模型及工作流下载

123网盘:https://www.123pan.com/s/I1oZVv-kaSGA.html 提取码:UpYy