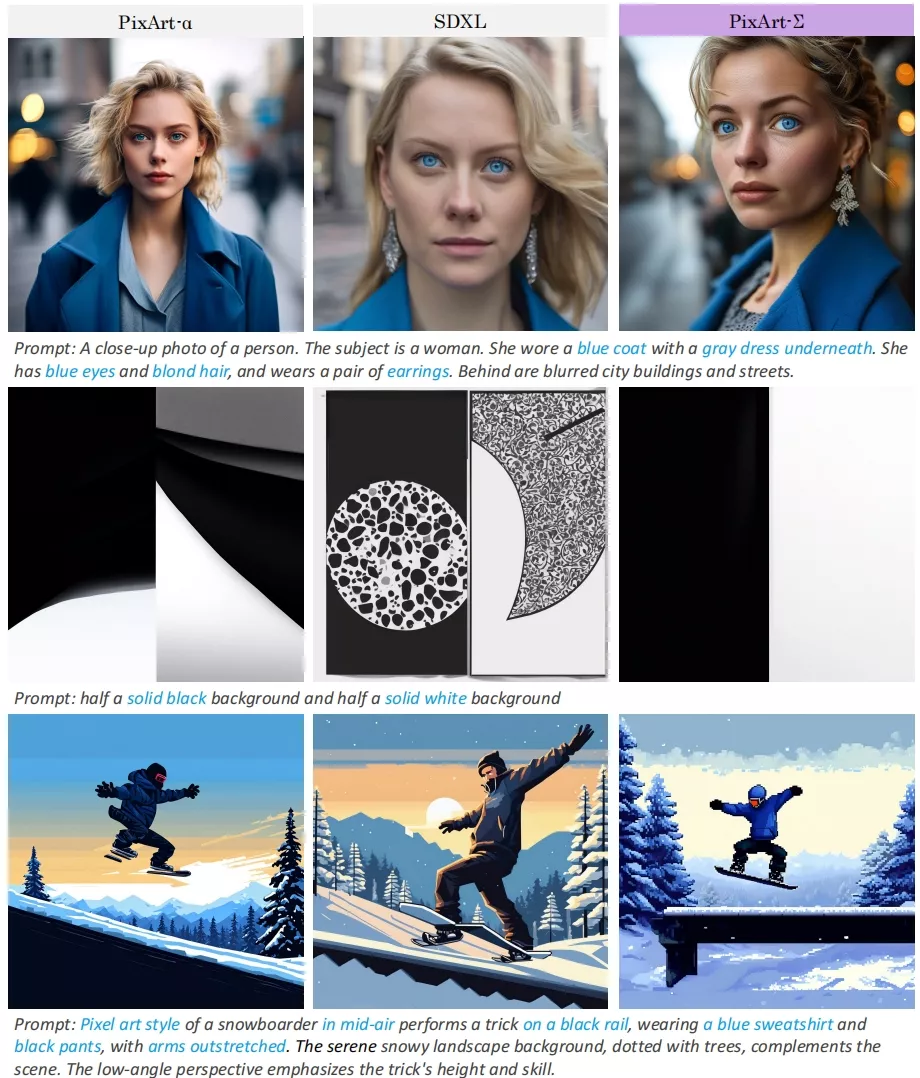

来自华为诺亚方舟实验室、大连理工大学、香港大学的研究人员推出了最新的PixArt模型—PIXART-Σ,PixArt-Σ基于Diffusion Transformer架构 (DiT,与Sora、Stable Diffusion 3相同),能够直接生成4K分辨率的图像。(参考:文本到图像合成框架PIXART-δ)

- 项目主页:https://pixart-alpha.github.io/PixArt-sigma-project

- GitHub:https://github.com/PixArt-alpha/PixArt-sigma

- Demo:https://huggingface.co/spaces/PixArt-alpha/PixArt-Sigma

相较于其前身PixArt-α,PixArt-Σ取得了显著进步,不仅生成的图像保真度更高,而且与文本提示的匹配度也更好。

PixArt-Σ的一个关键特性在于其训练效率。它借助PixArt-α的基础预训练,通过融入更高质量的数据,从“较弱”的基线模型进化为“更强”的模型,我们称之为“弱到强”的训练过程。

PixArt-Σ的进步主要体现在以下两方面:

- 高质量训练数据:PixArt-Σ采用了更优质的图像数据,并配备了更精确、更详细的图像说明。

- 高效的令牌压缩:在DiT框架内提出了一种新型注意力模块,该模块能够压缩键和值,从而显著提高效率并促进超高分辨率图像的生成。

由于这些改进,PixArt-Σ(6亿参数)在保持模型大小显著小于现有文本到图像扩散模型(如SDXL的26亿参数和SD Cascade的51亿参数)的同时,实现了更出色的图像质量和用户提示遵循能力。

此外,PixArt-Σ生成4K图像的能力支持创建高分辨率海报和壁纸,从而有效推动电影和游戏等行业高质量视觉内容的制作。

主要功能:

- 文本到图像的转换: 用户可以输入任何文本描述,PixArt-Σ能够理解这些描述并生成相应的图像。

- 高分辨率图像生成: 它能够直接生成4K分辨率的图像,这意味着图片非常清晰,细节丰富。

主要特点:

- 高保真度: 生成的图像质量非常高,与真实照片非常接近。

- 高效的训练过程: 通过所谓的“弱到强训练”,PixArt-Σ能够在较小的模型大小(0.6B参数)下,实现比现有模型更高效的训练。

- 精确的文本对齐: 它能够很好地理解文本描述,并生成与描述高度一致的图像。

工作原理:

- 数据集: PixArt-Σ使用了高质量的图像数据集,这些图像与详细准确的图像标题配对,帮助模型更好地理解文本和图像之间的关系。

- 注意力模块: 它引入了一个新颖的注意力模块,这个模块能够在保持图像质量的同时,压缩图像的关键信息,从而提高生成效率。

- 训练策略: 通过一系列的微调技术,PixArt-Σ能够从一个较弱的模型快速适应并进化到一个更强的模型。

PixArt-Σ模型在训练过程中采用了几种关键的微调技术,以实现从较弱模型到较强模型的高效转变。这些技术包括:

- 更换更强大的变分自编码器(VAE):为了适应新的VAE,模型会从PixArt-α的VAE更换为SDXL的VAE,然后继续对扩散模型进行微调。这种方法可以快速适应新的VAE,而不需要从头开始训练。

- 从低分辨率到高分辨率的微调:在将模型从低分辨率(如256px)微调到高分辨率(如512px、1024px、2K和4K)时,为了解决不同分辨率之间位置嵌入(PE)的差异问题,研究者们使用了“PE插值”技巧。这通过在高分辨率模型中初始化PE,通过插值低分辨率模型的PE来实现,从而显著提高了高分辨率模型的初始状态,并加速了微调过程。

- 适应关键-值(KV)压缩:在从没有KV压缩的低分辨率预训练模型进行微调时,可以直接使用KV压缩。通过“Conv Avg Init”策略,PixArt-Σ从一个更好的初始状态开始,使得收敛更容易和更快。

- 高效的DiT(Diffusion Transformer)设计:为了应对在超高分辨率下生成图像时显著增加的计算需求,研究者们在PixArt-α的基础上引入了KV压缩,以减少计算成本。这种设计仅增加了0.018%的总参数,但通过令牌压缩有效地降低了计算成本,同时保留了空间和语义信息。

这些微调技术使得PixArt-Σ能够在保持较小模型大小的同时,实现高质量的4K图像生成,并且与文本提示的对齐能力显著提高。通过这些策略,PixArt-Σ在训练和推理时间上实现了约34%的加速。

对比PixArt-α

PixArt-Σ与之前的PixArt-α相比,在多个方面进行了显著的改进和优化,以实现更高质量的图像生成和更高效的训练过程。以下是PixArt-Σ相较于PixArt-α的主要改进点:

- 图像质量:PixArt-Σ在图像质量上有了显著提升,能够生成更高保真度的图像,这意味着生成的图像更加逼真,细节更加丰富。

- 文本对齐:PixArt-Σ在文本和图像之间的对齐能力上也有所增强,能够更准确地根据文本描述生成相应的图像,减少了模型的幻觉(hallucination)倾向。

- 训练效率:通过“弱到强训练”(weak-to-strong training)的方法,PixArt-Σ在训练效率上取得了显著进步。它利用了PixArt-α的预训练基础,通过引入更高质量的数据和高效的令牌压缩技术,实现了更快的训练速度和更小的模型大小。

- 模型大小:尽管PixArt-Σ在功能上有所增强,但其模型大小(0.6B参数)却比现有的文本到图像扩散模型(如SDXL的2.6B参数和SD Cascade的5.1B参数)要小,这使得模型更加轻量化,便于部署和使用。

- 生成分辨率:PixArt-Σ能够直接生成4K分辨率的图像,而无需后续处理。这在PixArt-α中是无法实现的,因为PixArt-α主要针对1024px的图像生成。

- 数据集和训练数据:PixArt-Σ使用了更高质量的训练数据集,包括更高分辨率的图像和更精确、详细的图像标题,这有助于模型更好地理解和生成图像。

- 注意力模块:PixArt-Σ引入了一个新的注意力模块,该模块在DiT框架内压缩键(keys)和值(values),显著提高了效率,这对于生成超高分辨率图像尤为重要。

相关文章