SD混合专家模型SegMoE:允许多个模型混合成一个模型,无需训练

SegMoE是由Segmind开发的SD混合专家模型,它无需训练就可以混合多个Stable Diffusion模型组成一个新的模型,类似大语言模型中的MoE模型。该框架允许即时创建更大的模型,提供更丰富的知识、更好的一致性和更好的图像质量。

MoE(Mixture of Experts),中文通常翻译为“专家混合模型”。这个概念来源于机器学习领域,是一种提高模型处理能力的方法。可以把MoE模型想象成是一个“专家团队”。在这个团队里,每个“专家”(模型)都有自己擅长的领域。当有任务(比如数学题)需要解决时,MoE模型会根据问题的难度和类型,选择最合适的“专家”来处理。这样,每个“专家”只需要处理自己擅长的问题,大大提高了效率。

目前开发者提供了三个已经混合好的模型,分别由2个SDXL、4个SDXL和4个SD1.5模型组成。

- SegMoE 2x1 混合了2个SDXL模型

- SegMoE 4x2 混合了4个SDXL模型

- SegMoE SD 4x2 混合了4个SD1.5模型

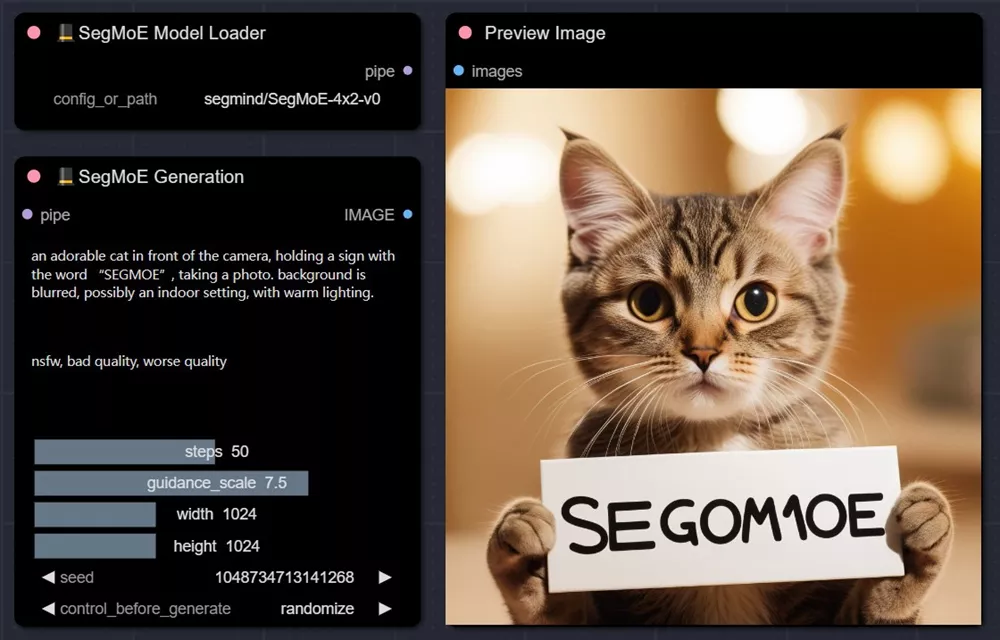

ComfyUI-SegMoE

目前已经有开发者ZHO-ZHO-ZHO打造了ComfyUI插件ComfyUI-SegMoE,实现了SegMoE模型在ComfyUI运行,不过由于SegMoE模型本身显存占用高的问题,插件开发者表示此插件对显存要求较高,建议20GB以上显存显卡。(插件安装请查看:插件)

节点说明

SegMoE Model Loader(模型加载)

- 支持 SegMoE 2x1、SegMoE 4x2、SegMoE SD 4x2 模型,输入模型名称(如:SegMoE 4x2)即可,会自动下载)

SegMoE Generation(SegMoE 生成)

- pipe:接入模型

- positivet、negative:正负提示词

- step:步数,官方默认30步

- guidance_scale:提示词相关度,一般默认为5

- width、height:宽度、高度

- seed:种子