在 AI 大模型领域,运行像 DeepSeek-R1 这样的千亿级参数模型一直是个难题。普通用户要么依赖云服务,要么只能运行大幅缩水的本地版本,而租赁服务器的成本也让开发者望而却步。但现在,这一局面正在被打破!

清华大学与趋境科技的突破

本周,清华大学 KVCache.AI 团队与趋境科技联合发布的 KTransformers 开源项目迎来了重大更新。这个项目成功破解了千亿级大模型本地部署的难题,标志着大模型推理从“云端垄断”迈向“普惠化”的重要一步。

重大突破:24GB 显存运行 DeepSeek-R1 满血版

- 2月10日:KTransformers 团队在一台仅配备 24GB 显存 + 382GB 内存 的 PC 上成功运行了 DeepSeek-R1 和 V3 的 671B 满血版,推理速度提升了 3~28倍。

- 2月15日:进一步优化,支持更长的上下文(单卡 24GB 支持 4~8K),并实现 15% 的加速(每秒最多 16 个 Tokens)。

KTransformers 的优势

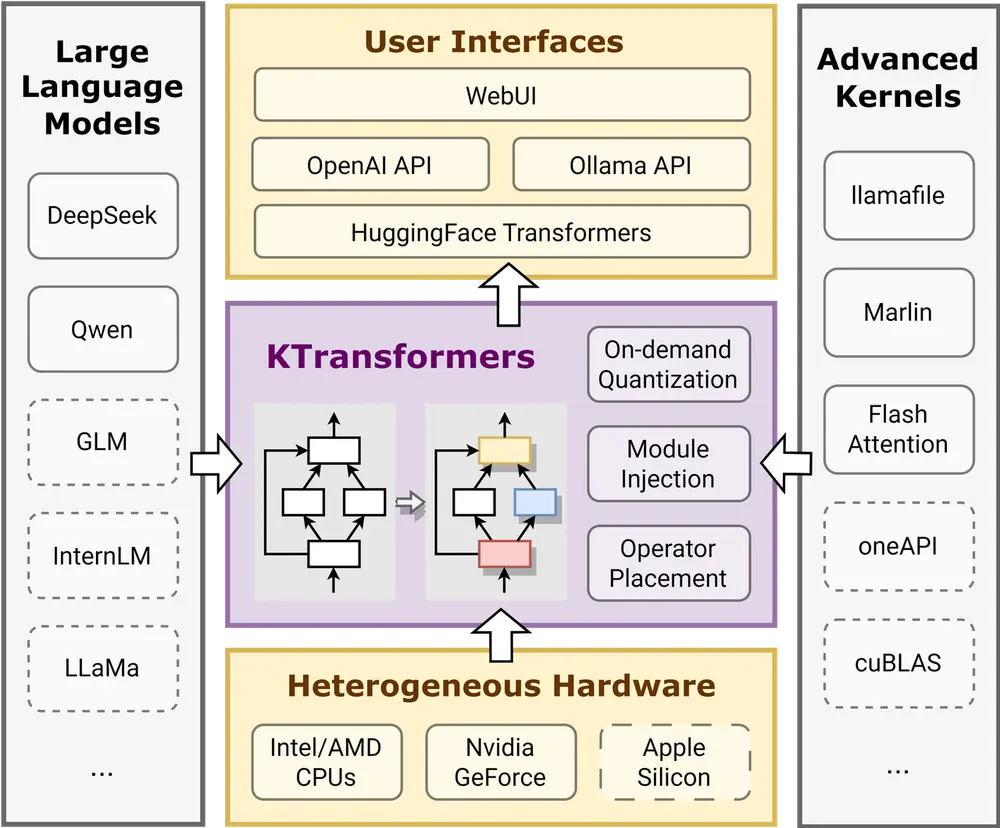

KTransformers 是一个灵活的、以 Python 为中心的框架,其核心是可扩展性。通过一行代码实现和注入优化模块,用户可以访问兼容 Transformers 的界面,以及符合 OpenAI 和 Ollama 标准的 RESTful API。

技术亮点

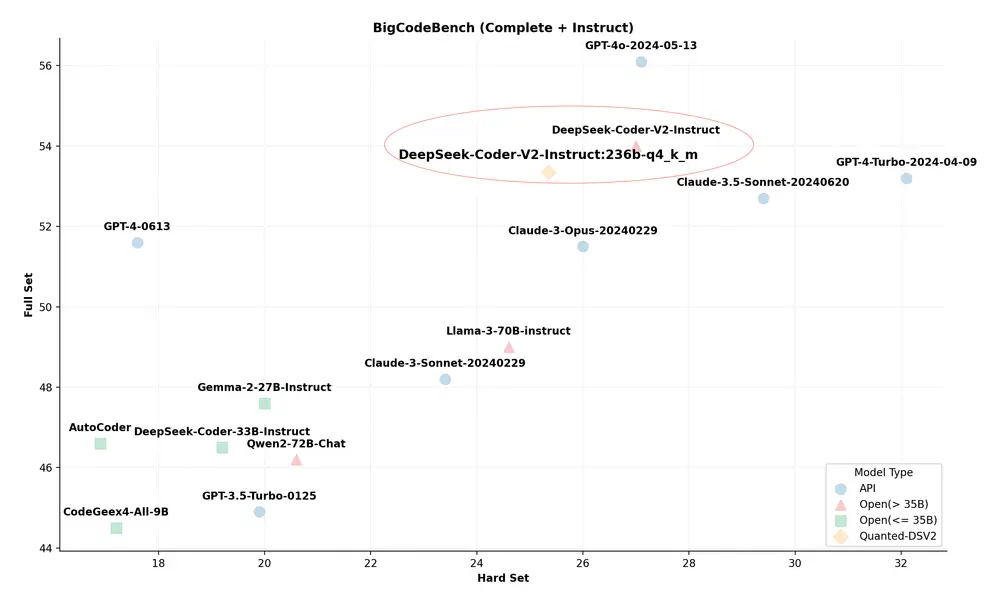

- 单卡运行:首次支持在单张 24GB 显存的消费级显卡(如 RTX 4090D)上运行 DeepSeek-R1/V3 的 671B 参数满血版。

- 高效推理:预处理速度最高达 286 tokens/s,推理生成速度达 14 tokens/s。

- 硬件优化:通过 Marlin GPU 算子实现量化矩阵计算,效率提升 3.87倍;CPU 端采用多线程并行和英特尔 AMX 指令集优化,预填充速度较传统方案提升 28倍。

- 成本降低:整机成本约 2万元,仅为传统 8 卡 A100 方案的 2%。

如何使用 KTransformers?

硬件要求

虽然 KTransformers 让运行大模型变得更加亲民,但仍然有一定硬件门槛:

- CPU:英特尔至强 Gold 6454S 1T DRAM(2 个 NUMA 节点)

- GPU:RTX 4090D(24GB VRAM)

- 内存:标准 DDR5-4800 服务器 DRAM(1TB)

- CUDA:12.1 或更高版本

安装步骤

1. 安装依赖

对于 Linux-x86_64 系统,运行以下命令安装必要工具:

sudo apt-get update

sudo apt-get install gcc g++ cmake ninja-build

2. 创建虚拟环境

强烈建议使用 Conda 创建一个包含 Python 3.11 的虚拟环境:

conda create --name ktransformers python=3.11

conda activate ktransformers3. 安装 Python 依赖

pip install torch packaging ninja cpufeature numpy4. 安装 KTransformers

pip install ktransformers --no-build-isolation5. 快速启动

运行以下命令启动本地聊天界面:

python -m ktransformers.local_chat --model_path <your_model_path> --gguf_path <your_gguf_path> --prompt_file <your_prompt_txt_file> --cpu_infer 65 --max_new_tokens 1000当看到提示时,按回车加载文本提示文件即可。

实测数据

以下是 RTX 4090D + 双路 Xeon Gold 的实测数据:

| 任务类型 | KTrans V0.3 (6 位专家) | KTrans V0.2 (8 位专家) | llama.cpp (FP16) |

|---|---|---|---|

| 8K 上下文预填充 | 207.20 tokens/s | 195.62 tokens/s | 7.43 tokens/s |

| 短文本解码 | 13.69 tokens/s | 8.73 tokens/s | 4.51 tokens/s |

| 长序列吞吐量 | 19.8 GB/s | 15.2 GB/s | 4.8 GB/s |

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...