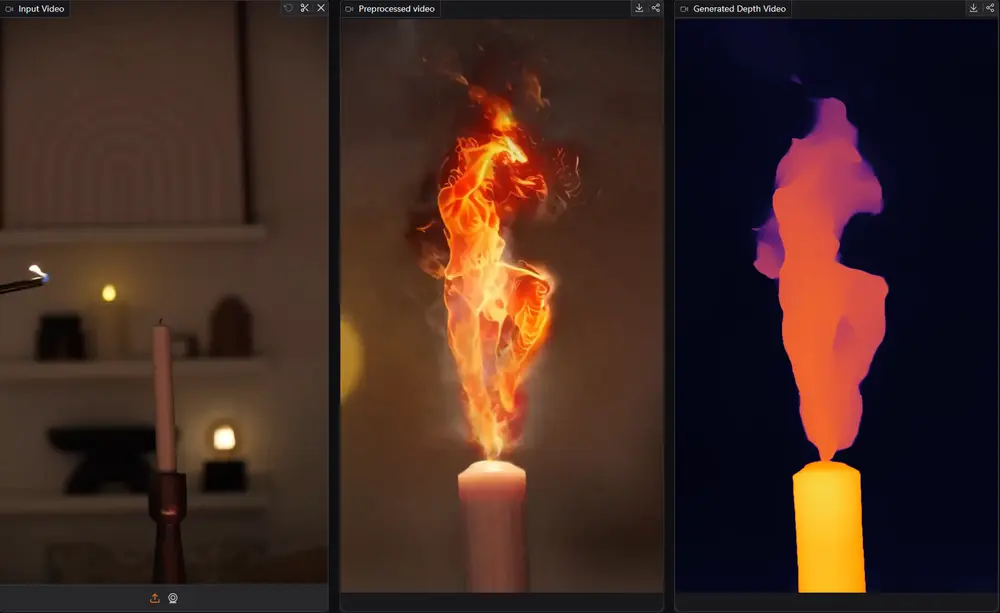

字节跳动推出新型单目深度估计方法Video Depth Anything,专门用于超长视频(数分钟)的高质量、一致的深度估计。该方法基于 Depth Anything V2,通过引入高效的空间-时间头部(Spatial-Temporal Head)和一种简单但有效的时序一致性损失函数(Temporal Gradient Matching Loss),解决了现有方法在视频深度估计中时间不一致的问题。此外,该方法还提出了一种新颖的基于关键帧的推理策略,支持对任意长度视频的深度估计,且不会牺牲效率。

- 项目主页:https://videodepthanything.github.io

- GitHub:https://github.com/DepthAnything/Video-Depth-Anything

- 模型:https://huggingface.co/depth-anything

- Demo:https://huggingface.co/spaces/depth-anything/Video-Depth-Anything

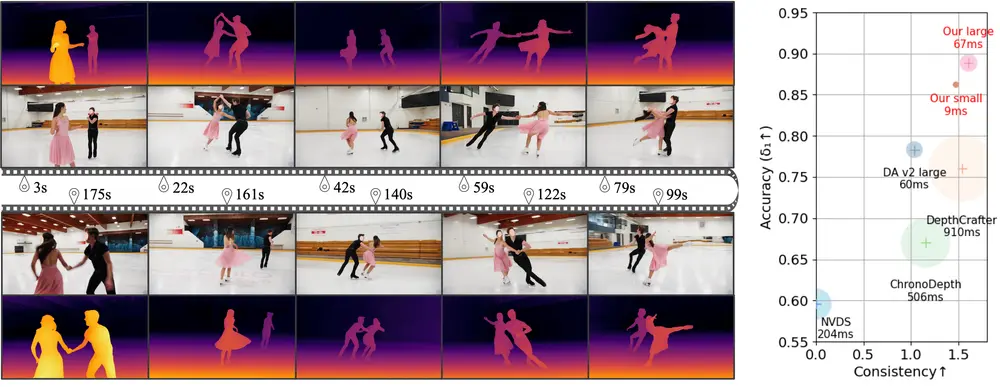

例如,有一个长达数分钟的花样滑冰视频,使用 Video Depth Anything 方法,可以生成与视频内容一致的深度图,这些深度图不仅在空间上具有高精度,而且在时间上也保持高度一致性,避免了现有方法中常见的闪烁和运动模糊问题。例如,当运动员在视频中快速移动时,该方法能够准确地估计出运动员和背景的深度变化,同时保持深度图的平滑过渡。

主要功能

- 高质量深度估计:生成具有丰富细节的深度图,适用于各种场景。

- 时序一致性:确保视频中深度图的时间一致性,避免闪烁和运动模糊。

- 支持超长视频:能够处理任意长度的视频,而不会出现深度估计的漂移或不一致。

- 高效推理:保持高效的推理速度,支持实时应用。

主要特点

- 空间-时间头部(Spatial-Temporal Head):通过引入时间注意力层,捕捉视频帧之间的时间信息,增强模型对动态场景的处理能力。

- 时序梯度匹配损失(Temporal Gradient Matching Loss):通过约束深度预测的时间梯度与真实深度的时间梯度一致,确保深度图的时间一致性,无需额外的几何或生成先验知识。

- 关键帧推理策略:通过引入关键帧和重叠帧,确保在长视频推理中保持全局尺度一致性和深度图的平滑过渡。

- 联合训练:在包含视频深度数据和未标注图像的联合数据集上进行训练,继承了 Depth Anything V2 的强大泛化能力和细节表现力。

工作原理

架构设计:

- 空间-时间头部(Spatial-Temporal Head):在 Depth Anything V2 的基础上,引入了四个时间注意力层,专门用于处理视频帧之间的时间信息。这些层通过自注意力机制,捕捉帧之间的时间关系,增强模型对动态场景的处理能力。

- 特征金字塔融合:通过重新组装(Reassemble)和融合(Fusion)层,将不同分辨率的特征图逐步融合,生成高分辨率的深度图。

时序梯度匹配损失(Temporal Gradient Matching Loss):

- 该损失函数通过计算相邻帧之间深度变化的梯度,并将其与真实深度的变化梯度进行匹配,确保深度图的时间一致性。具体来说,损失函数计算相邻帧深度变化的绝对值之差,约束预测深度的变化与真实深度的变化一致。

推理策略:

- 关键帧引用:在长视频推理中,通过引入关键帧,继承之前预测的尺度和偏移信息,避免累积误差。

- 重叠帧插值:通过在相邻窗口之间引入重叠帧,并对这些帧的深度进行线性插值,确保深度图的平滑过渡。

具体应用场景

- 机器人导航:为机器人提供实时、一致的深度信息,帮助其在动态环境中进行导航和避障。

- 增强现实(AR):生成与真实世界一致的深度图,增强虚拟物体与真实场景的融合效果。

- 视频编辑:在视频后期制作中,提供高质量的深度图,支持各种视觉特效的实现,如背景虚化、3D 转换等。

- 自动驾驶:为自动驾驶系统提供准确的深度信息,帮助车辆更好地理解周围环境,提高安全性。

- 3D 重建:通过生成的深度图生成密集的点云,用于 3D 场景重建和建模。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...