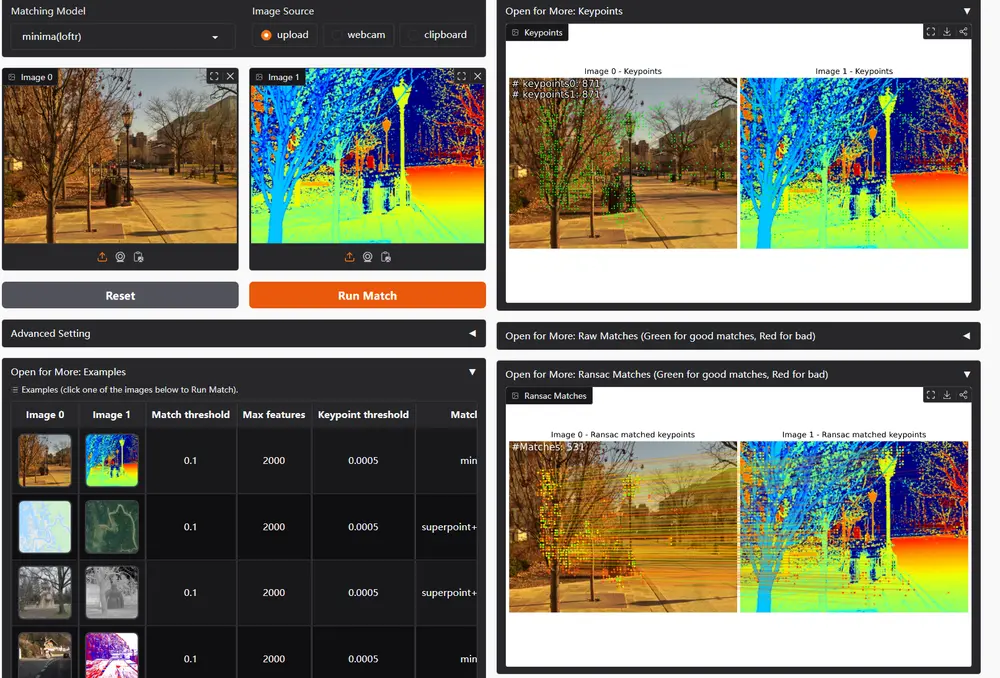

华中科技大学和武汉大学的研究人员推出一个统一的图像匹配框架MINIMA,即模态不变图像匹配。这项研究旨在解决多模态感知中的图像匹配问题,特别是在跨视图和跨模态的情况下。例如,在自动驾驶中,需要将可见光相机拍摄的图像与红外相机拍摄的图像进行匹配,以实现更准确的目标检测和定位。然而,由于不同成像系统或风格导致的模态差异,使得匹配任务极具挑战性。

主要功能

MINIMA的主要功能是提供一个统一的图像匹配框架,能够处理多种跨模态情况。它能够从简单的RGB图像数据中生成包含多种模态(如红外、深度、事件等)的大型数据集,并利用这些数据集训练出具有跨模态能力的匹配模型。具体来说,MINIMA可以:

- 从RGB图像数据中生成多种伪模态图像,如红外、深度、事件等。

- 构建一个包含丰富场景和精确匹配标签的综合数据集MD-syn,填补了多模态图像匹配领域的数据空白。

- 直接在随机选择的模态对上训练先进的匹配流程,以获得跨模态能力。

主要特点

- 数据驱动:MINIMA通过生成模型从大量的RGB图像中生成多模态数据,而不是依赖于有限的手工标注数据。这种方法能够提供更丰富、更多样化的训练样本。

- 跨模态能力:MINIMA能够在多种模态对之间进行匹配,如RGB-IR、RGB-Depth、RGB-Event等,展现出强大的跨模态匹配能力。

- 高效训练:通过预训练和微调策略,MINIMA能够在大规模数据上快速收敛,提高了训练效率。

- 泛化能力强:在多个真实世界的跨模态数据集上,MINIMA展现出了良好的泛化能力,即使在未见过的模态对上也能取得较好的匹配效果。

工作原理

MINIMA的工作原理可以分为以下几个步骤:

- 数据生成:利用生成模型从RGB图像对中生成多种伪模态图像。这些生成模型包括基于扩散的模型(用于生成红外图像)、深度估计模型(用于生成深度图像)等。生成的图像继承了RGB图像的匹配标签和场景多样性。

- 构建数据集:将生成的多模态图像与原始RGB图像配对,构建一个大型的多模态图像匹配数据集MD-syn。该数据集包含丰富的场景和精确的匹配标签。

- 模型训练:首先在多视图RGB数据上预训练先进的匹配模型,然后在随机选择的跨模态图像对上进行微调。预训练阶段利用RGB数据的丰富性和多样性,为模型提供良好的初始匹配先验;微调阶段则使模型适应跨模态匹配任务。

- 匹配应用:训练好的MINIMA模型可以直接应用于各种跨模态图像匹配任务,如视觉定位、目标检测等。

具体应用场景

- 自动驾驶:在自动驾驶中,MINIMA可以将可见光相机拍摄的图像与红外相机或激光雷达(LiDAR)生成的深度图像进行匹配,提高目标检测和定位的准确性,增强自动驾驶系统的鲁棒性。

- 遥感监测:在遥感领域,MINIMA可以匹配光学卫星图像与合成孔径雷达(SAR)图像,帮助监测环境变化、土地利用变化等。

- 医学成像:在医学成像中,MINIMA可以匹配不同模态的医学图像,如MRI和PET图像,辅助医生进行更准确的诊断。

- 机器人导航:在机器人导航中,MINIMA可以匹配机器人携带的不同传感器(如RGB相机和事件相机)拍摄的图像,提高机器人在复杂环境中的导航能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...