字节跳动和浦项科技大学的研究人员提出了一种名为TA-TiTok的新型图像分词器。这是一种基于Transformer架构的文本感知一维分词器,能够高效处理离散或连续的一维标记。基于TA-TiTok的成功,研究团队进一步开发了一个名为MaskGen的掩码生成模型系列。这些模型完全使用开放数据进行训练,并实现了与那些依赖私有数据集训练的模型相当的性能。

主要功能

- 高效图像令牌化:TA-TiTok能够将图像高效地转换为一维令牌,支持离散和连续的令牌表示,加速模型收敛并提升性能。

- 文本感知解码:在解码阶段引入文本信息,增强生成图像与文本描述的语义对齐。

- 简化训练过程:通过一阶段训练流程,简化了传统两阶段训练的复杂性,支持大规模数据集的训练。

- 高性能生成:MaskGen在公开数据集上训练,性能与私有数据训练的模型相当,同时显著降低了训练成本和推理时间。

主要特点

- 高效性:TA-TiTok通过一维令牌化显著提高了采样速度,减少了训练和推理成本。

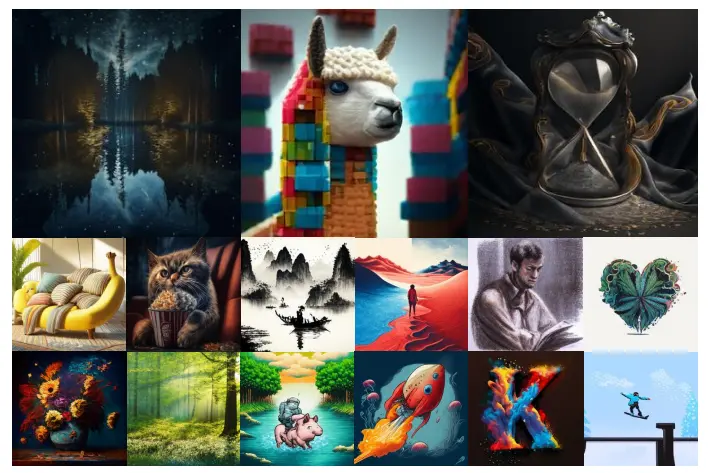

- 高质量生成:通过文本感知解码和连续令牌表示,MaskGen能够生成高质量、高分辨率的图像。

- 开放性:完全基于公开数据训练,模型权重和训练代码将公开发布,促进研究社区的复现和进一步研究。

- 灵活性:支持离散和连续令牌,适用于不同的生成任务和模型架构。

工作原理

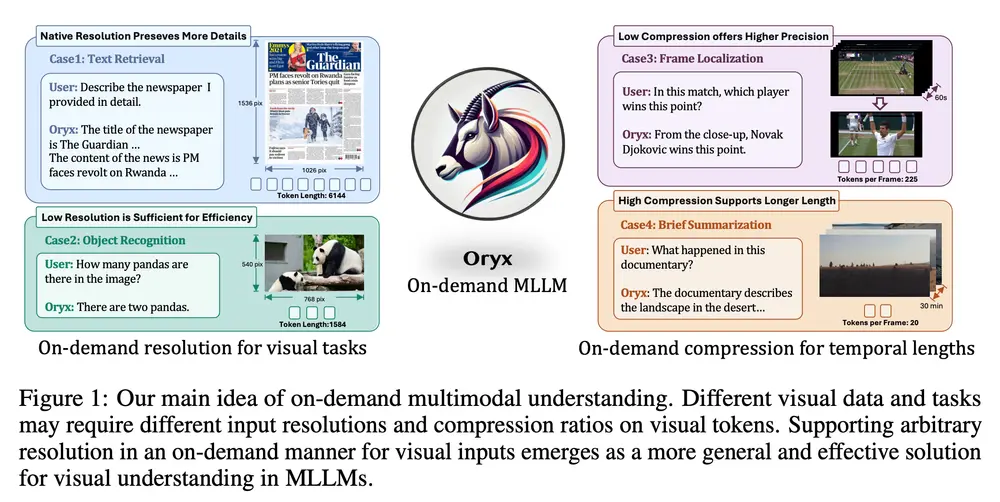

MaskGen是一个创新的文本到图像掩码生成模型框架,它引入了一种新型且高效的图像分词器——TA-TiTok。这一框架支持生成离散和连续的一维(1D)标记,并通过其独特的设计实现了显著的技术进步。

1、TA-TiTok:

- 一维令牌化:将图像转换为紧凑的一维令牌序列,每个令牌可以表示图像的任意区域,而不是固定对应某个特定的图像块。

- 文本感知解码:在解码阶段,将CLIP生成的文本嵌入与图像令牌拼接,增强生成图像的语义对齐。

- 一阶段训练:简化了传统的两阶段训练流程,直接在大规模数据集上进行训练,提高了训练效率。

2、MaskGen:

- 多模态融合:将TA-TiTok生成的图像令牌与CLIP提取的文本嵌入拼接,输入到多模态扩散Transformer(MM-DiT)块中进行注意力操作。

- 自适应LayerNorm:为文本和图像模态分别应用自适应LayerNorm(adaLN),提升模型的适应性和生成质量。

- 扩散损失:对于连续令牌,使用扩散损失进行训练,直接近似每个掩码令牌的分布,提高生成效率。

具体应用场景

- 内容创作:艺术家和设计师可以利用MaskGen生成高质量的图像,用于创意设计、插画、动画等。

- 教育:教育工作者可以生成与教学内容相关的图像,增强教学效果。

- 广告和营销:营销人员可以快速生成符合品牌风格的图像,用于广告宣传和社交媒体内容。

- 游戏开发:游戏开发者可以生成游戏中的角色、场景和道具,加速游戏开发过程。

- 科研:研究人员可以利用MaskGen生成特定条件下的图像,用于模拟和实验研究。

通过这些功能和特点,MaskGen不仅提高了文本到图像生成的效率和质量,还降低了研究和应用的门槛,推动了该领域的民主化发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...