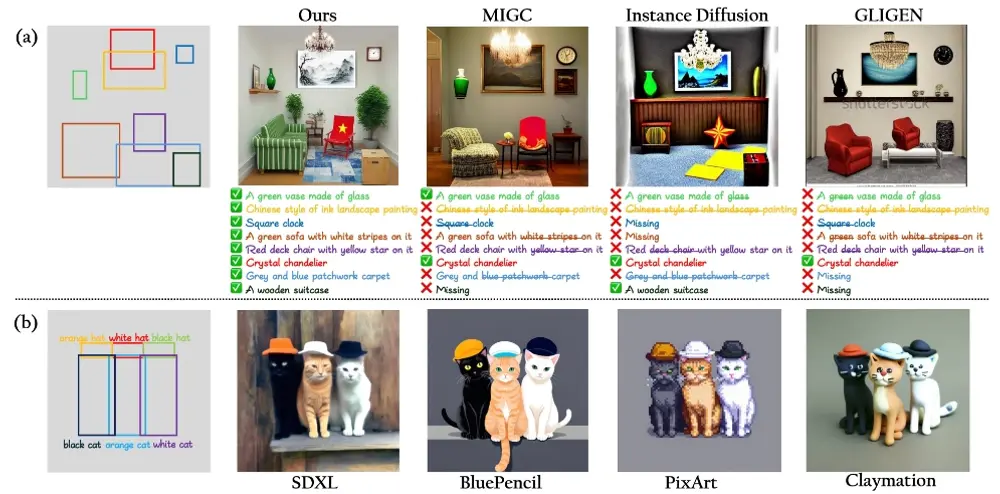

腾讯PCG和新加坡国立大学的研究人员推出新型方法IFAdapter,它是为了提升基于文本生成图像(Text-to-Image,简称T2I)的扩散模型在生成多个实例时的精确度和细节控制能力而设计的。简单来说,IFAdapter 就像是一个高级的图像编辑器,它可以帮助我们在电脑里生成的图像更加精确地反映出我们通过文字描述的内容,尤其是在图像中包含多个不同对象时。

例如,你想要通过一段描述来生成一张图片,比如“一个绿色的花瓶放在一张木桌上”。现在的技术可能只能生成一个简单的绿色花瓶,但可能无法精确地表达出“木桌”的细节。IFAdapter 就是为了解决这个问题,它能够更细致地控制图像中每个对象的位置和特征,让生成的图像更加符合我们的描述。

主要功能:

- 精确控制: 能够精确控制图像中每个对象的位置和特征。

- 细节生成: 生成具有复杂纹理和颜色的图像。

- 即插即用: 可以轻松集成到现有的图像生成模型中,无需重新训练。

主要特点:

- 外观令牌(Appearance Tokens): 引入了一种新的可学习的外观查询,用于从描述中提取特定于实例的特征信息。

- 实例语义图(Instance Semantic Map): 构建一个二维语义图,将实例特征与指定的空间位置关联起来,提供更强的空间引导。

- 生成过程控制: 在扩散模型的特定层中集成语义图,增强了模型对实例特征的控制能力。

工作原理:

IFAdapter 通过两个主要组件来工作:

- 外观令牌: 利用可学习的外观查询与文本特征进行交互,提取出描述中的关键视觉特征。

- 实例语义图: 为每个实例生成一个语义图,然后在模型的生成过程中使用这些图来指导图像的生成,确保每个对象的特征和位置都符合输入的文本描述。

具体应用场景:

- 图形设计: 在设计领域,可以用于生成具有精确细节的图像,如复杂的图案或纹理。

- 时尚设计: 用于生成具有特定颜色和材质的服装图像。

- 虚拟场景构建: 在游戏或电影制作中,用于快速生成场景中的多个对象。

总的来说,IFAdapter 提供了一种新的方法来提高文本到图像生成任务中的控制精度和细节表现,使得生成的图像更加符合用户的描述和预期。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...