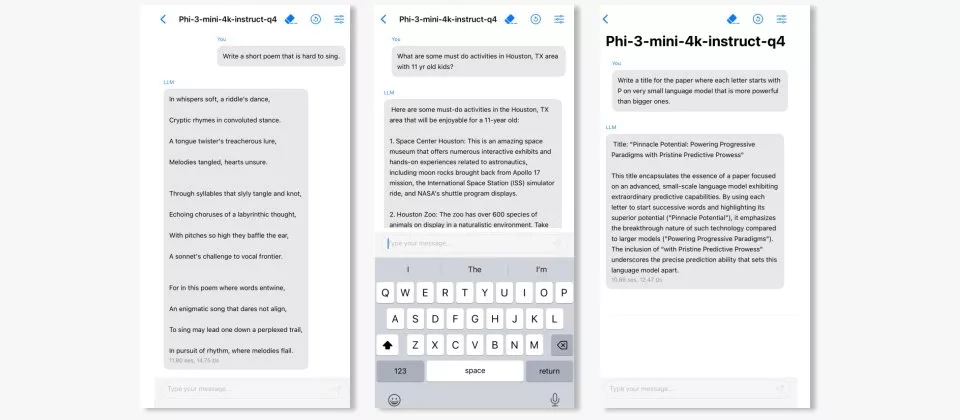

微软推出小型语言模型Phi-3系列,它在性能上可以与一些大型模型相媲美,如Mixtral 8x7B和GPT-3.5,但大小却足以部署在手机上。这项技术的创新之处在于其训练数据集,这是phi-2数据集的一个扩展版本,包含了大量过滤过的网络数据和合成数据。

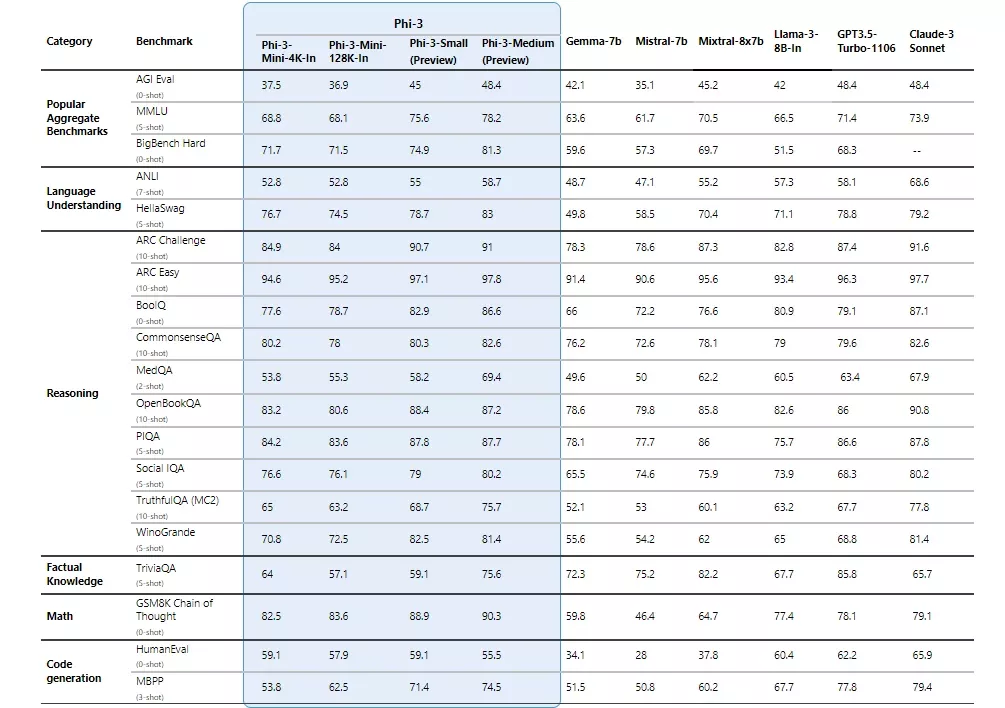

Phi-3系列包含三款模型,分别是Phi-3-mini(3.8B)、Phi-3-small(7B)、及Phi-3-medium(14B)。 目前Phi-3-mini已在Azure AI Studio模型库、Hugging Face、轻量框架Ollama上架,之后Phi-3-small及Phi-3-medium也会在Azure AI模型库及其他网站公开。 微软强调,Phi-3家族虽然参数量相较少,但效能却大于参数较多的模型。 根据微软提供的数据,Phi-3-mini在多语言理解、推理、数学及写程式等标竿测试上,超过谷歌Gemma-7B与Mistral-7B,而Phi-3-small及Phi-3-medium 甚至超过Mixtral 8x7B、Claude-3 Sonnet与GPT-3.5 Turbo。

- 模型地址:https://huggingface.co/collections/microsoft/phi-3-6626e15e9585a200d2d761e3

- Azure AI Studio模型库:https://ai.azure.com/explore/models?&selectedCollection=phi

- Ollama:https://ollama.com/library/phi3

除了使用简单、适合特定AI任务外,微软并强调Phi-3可用于运算效能有限或离线环境,这允许资源有限的组织将之部署在成本较低的装置以及频宽受限的环境下,确保 回应速度。其中已经公布的Phi-3-mini具有特别轻巧、容易使用、跨平台等特色。 仅38亿参数的规模使Phi-3-mini可执行于本地装置,如笔电上,它还经过微软推论框架ONNX Runtime优化并支持Windows DirectML,可在多种硬体平台如CPU、GPU、FPGA甚至手机上执行。 Phi-3-mini也已为英伟达GPU优化,还可作为英伟达NIM微服务以标准API执行,可部署在任何地方。

另一方面,mini版Phi-3分提供二种脉络空间(context-length)版本,分别为4K及128K token。 微软表示Phi-3-mini也是同等级模型中首个能支持到128K token的SLM。 更大的脉络赋予Phi-3-mini强大的文本输入与理解能力,使其适合进行分析任务。

例如。你有一个智能手机,上面安装了一个虚拟助手应用,这个应用需要理解你的问题并给出回答。传统的大型语言模型由于体积庞大,无法直接部署在手机上。但phi-3-mini模型虽然小到足以安装在手机上,却仍然能够提供与大型模型相媲美的性能,使得你的虚拟助手既高效又智能。

主要功能和特点:

- 小型化:phi-3-mini足够小,可以部署在现代智能手机上,同时保持高性能。

- 高性能:尽管体积小,但它在学术基准测试和内部测试中的表现与一些大型模型相当。

- 训练数据集:模型使用了经过大量过滤的网络数据和合成数据进行训练,这有助于提高模型的性能。

- 安全性和鲁棒性:phi-3-mini在训练过程中进一步对齐,以提高其在安全性、鲁棒性和聊天格式方面的表现。

- 参数扩展:除了phi-3-mini,研究者还提供了7B和14B参数的模型(phi-3-small和phi-3-medium),这些模型的性能显著优于phi-3-mini。

工作原理:

- 数据集过滤:使用高质量的训练数据,通过精心筛选和优化数据集,研究人员可以显著减少模型的大小,而不影响其性能。

- 合成数据:结合了基于LLM(大型语言模型)过滤的网络数据和LLM创建的合成数据,使得较小的语言模型也能表现出色。

- 后训练:模型经过监督指令微调和偏好调整,以提高模型的聊天能力、鲁棒性以及安全性。

具体应用场景:

- 移动设备:由于模型体积小,可以轻松地在智能手机上进行本地推理,适用于需要快速响应的应用,如语音助手、翻译应用等。

- 资源受限的环境:在计算资源受限的环境中,如某些嵌入式系统或老旧设备,phi-3-mini可以作为一个高效的语言模型解决方案。

- 安全性要求高的场景:对于需要高安全性和鲁棒性的聊天机器人或自动客服系统,phi-3-mini提供了一个可靠的选择。

相关文章