Bolt.diy 是 Bolt.new 的官方开源版本,它不仅继承了 Bolt.new 的强大功能,还提供了更多灵活性和自定义选项。用户可以根据自己的需求选择不同的大语言模型(LLM),并轻松扩展以使用 Vercel AI SDK 支持的任何其他模型。

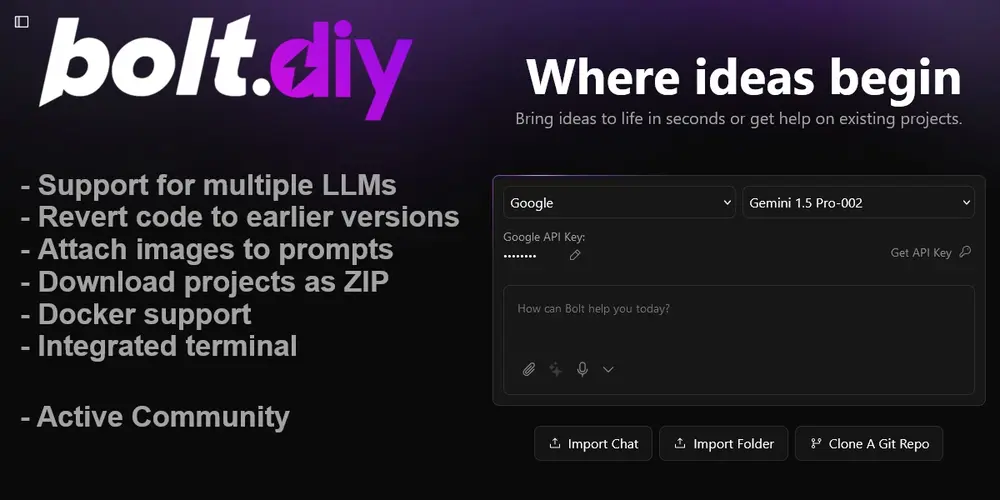

功能亮点

1. 自定义 LLM 选择

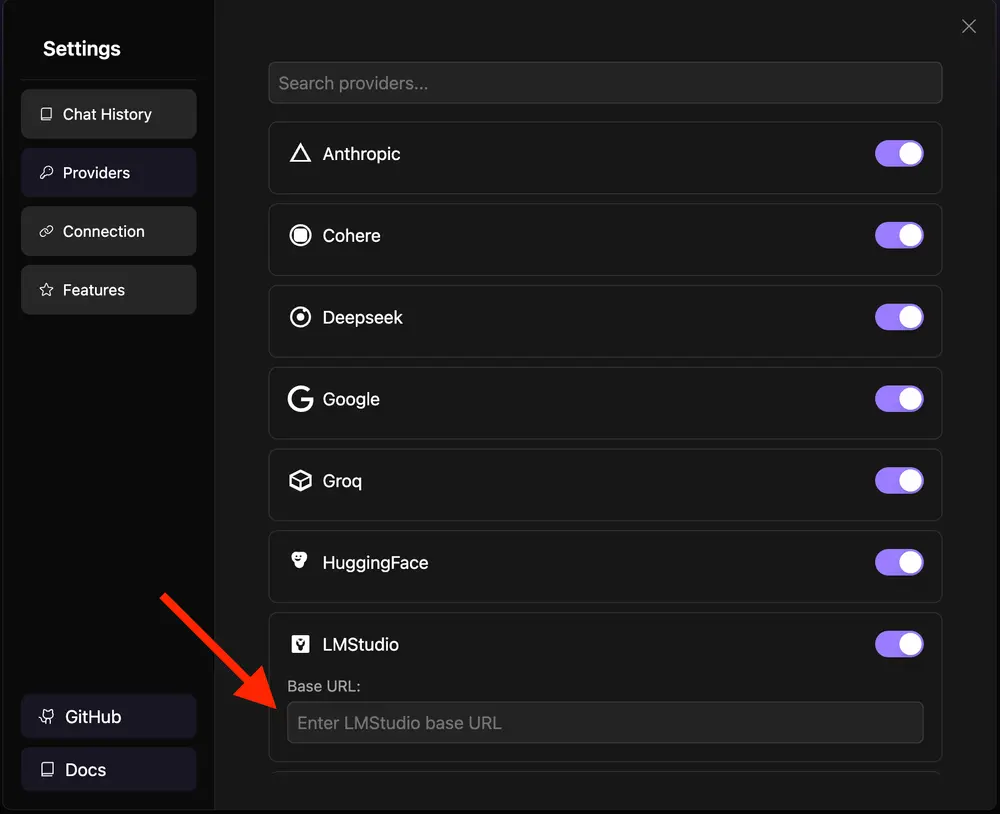

Bolt.diy 允许用户为每个提示选择使用的 LLM,目前支持以下模型:

- OpenAI

- Anthropic

- Ollama

- OpenRouter

- Gemini

- LMStudio

- Mistral

- xAI

- HuggingFace

- DeepSeek

- Groq

用户可以根据自己的需求选择最适合的模型,甚至可以轻松扩展以使用 Vercel AI SDK 支持的任何其他模型。

2. 浏览器中的 AI 驱动全栈 Web 开发

Bolt.diy 提供了直接在浏览器中进行 AI 驱动的全栈 Web 开发的能力。用户可以快速生成和优化代码,无需安装任何本地工具。

3. 图像附加功能

用户可以将图像附加到提示中,以提供更好的上下文理解。这一功能特别适用于需要视觉参考的开发场景,例如界面设计或图像处理。

4. 集成终端

Bolt.diy 集成了终端,用户可以实时查看 LLM 运行命令的输出。这一功能方便用户监控和调试开发过程。

5. 代码版本管理

用户可以将代码恢复到早期版本,以便更轻松地调试和更快地进行更改。这一功能类似于版本控制系统,帮助用户管理开发过程中的代码变更。

6. 项目下载与携带

用户可以将项目下载为 ZIP 文件,方便在不同设备之间携带和备份。

7. Docker 支持

Bolt.diy 提供了集成就绪的 Docker 支持,用户可以轻松设置开发环境,确保一致性和可移植性。

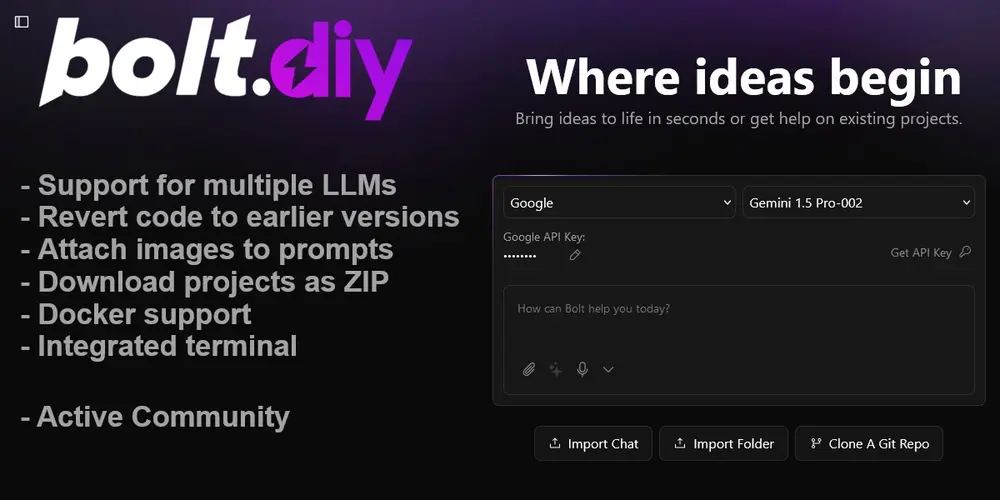

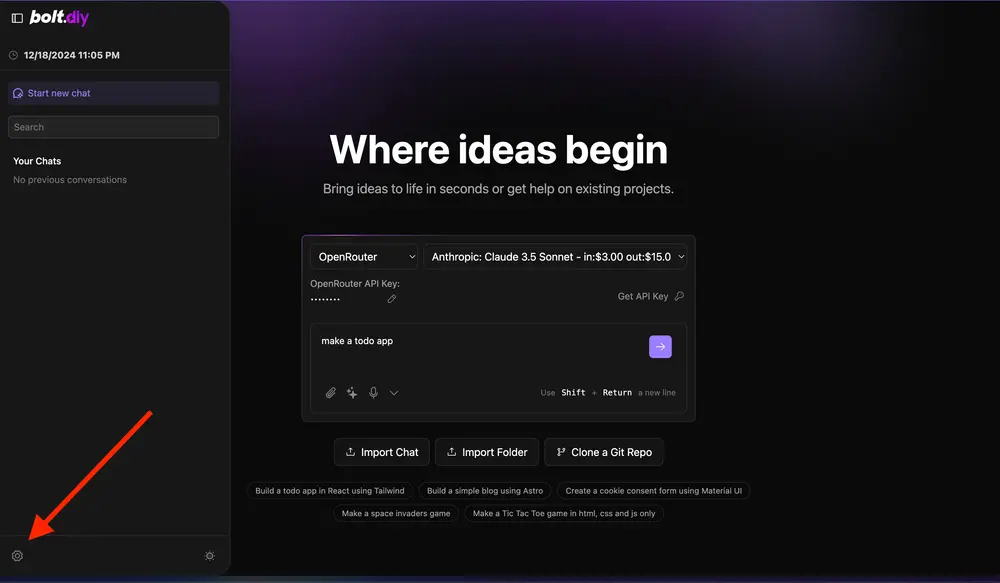

如何使用 Bolt.diy?

使用 Bolt.diy 非常简单,只需按照以下步骤操作:

- 访问 Bolt.diy

转到 Bolt.diy 并创建一个新项目。 - 选择 LLM

在项目设置中,选择你希望使用的 LLM。你可以根据需求选择 OpenAI、Anthropic 等模型,甚至可以扩展以使用其他支持的模型。 - 描述你的需求

通过日常语言描述你想要的应用或功能。例如:“我想要一个专业的博客应用,包含主页、关于页面和文章列表页面。” - 附加图像(可选)

如果需要,可以将图像附加到提示中,以提供更好的上下文理解。 - 提交提示

提交描述后,Bolt.diy 的 AI 代理将开始生成代码。几秒钟之内,你就会看到生成的应用或功能。 - 实时预览与调试

生成的应用将实时显示在浏览器中,你可以查看并提供反馈。如果需要,可以使用集成终端查看 LLM 的输出。 - 下载项目

满意后,点击“下载”按钮,将项目保存为 ZIP 文件,方便携带和备份。

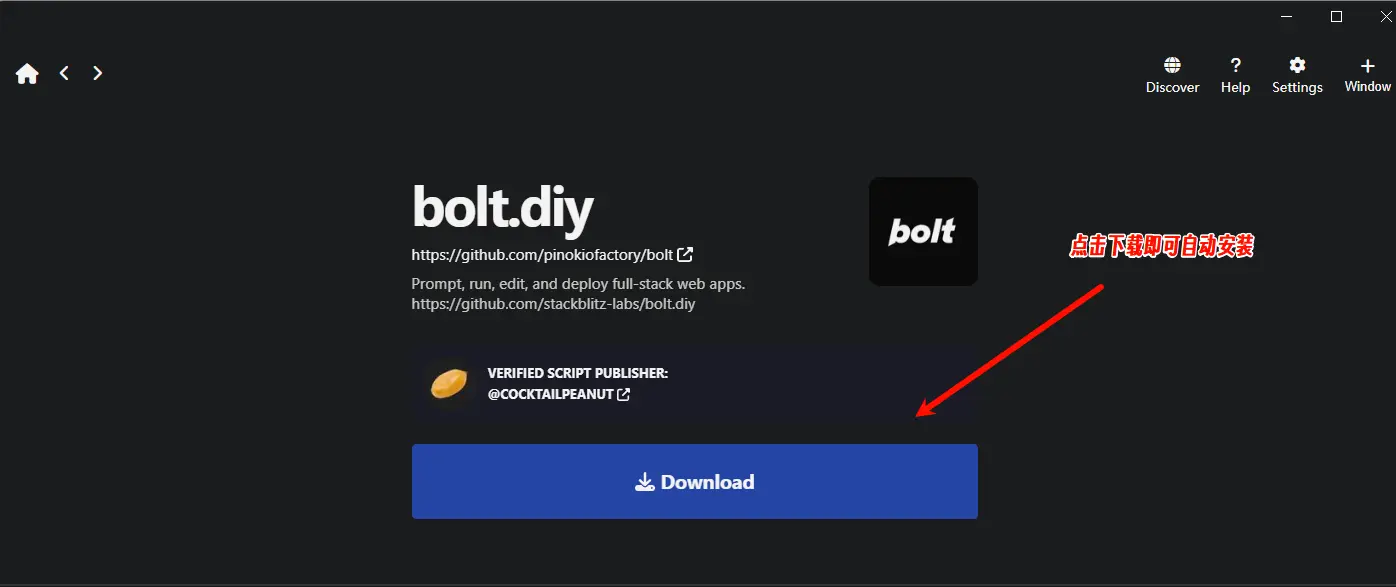

如何安装?

官方文档给出了详细的安装教程,如果你是新手,建议使用Pinokio进行安装,它提供了一键安装此应用的方法。

未来计划

Bolt.diy 的开发团队将继续扩展其功能,包括更多的 LLM 集成和更强大的开发工具。未来,Bolt.diy 还将支持更复杂的项目管理和协作功能,进一步提升用户体验。

数据统计

相关导航

Claude Code Bridge

GitHub Spark

Humanizer-zh

Cursor CLI

Flowise

Disco

Lovable