随着视频对象分割(VOS)和跟踪任务的日益复杂,现有的强大工具如SAM 2虽然在准确性和功能上表现出色,但其高计算复杂性限制了其在移动设备等资源受限环境中的应用。为了解决这一问题,Meta和南洋理工大学的研究团队共同开发了EfficientTAM——一种轻量级的新型视频对象分割和跟踪模型,它能够在保持高质量结果的同时显著降低计算成本和延迟,提供一个轻量级、低延迟且模型尺寸小的解决方案,用于视频对象的分割和跟踪任务。

例如,你正在拍摄一个关于野生动物的纪录片,需要在后期制作中将一只特定的鸟从背景中分离出来。使用EfficientTAM,你可以在拍摄过程中或之后,快速地在视频帧中识别和跟踪这只鸟,即使它飞入树丛或被其他鸟类遮挡。这样,后期制作人员就可以更容易地对这只鸟进行编辑,比如更换背景或添加特效,而不需要手动跟踪和分割对象,大大节省了时间和资源。

关键技术创新

1. 轻量级ViT作为图像编码器

EfficientTAM摒弃了传统的多阶段图像编码器,转而采用普通的非分层视觉Transformer(ViT)作为视频对象分割的图像编码器。这种设计不仅简化了模型结构,还减少了计算复杂度,使得模型可以在低功耗设备上高效运行。

2. 高效的记忆模块

为了进一步优化性能,研究团队引入了一个高效的记忆模块,该模块旨在降低当前帧分割时的特征提取和记忆计算负担。通过优化内存管理和计算流程,这个记忆模块能够快速检索并利用过去帧的信息,辅助当前帧的精准分割。这不仅提高了处理速度,还保证了长时间序列中的一致性和准确性。

特点

- 轻量化:EfficientTAM使用了一个简化的、非分层的Vision Transformer(ViT)作为图像编码器,以及一个高效的内存模块,这使得模型在保持高性能的同时,减少了计算复杂度和模型大小。

- 快速响应:由于模型的轻量化设计,EfficientTAM能够在移动设备上实现接近实时的处理速度,例如在iPhone 15 Pro Max上以大约10 FPS的速度运行视频对象分割。

- 参数减少:与SAM 2模型相比,EfficientTAM在参数数量上减少了约2.4倍。

- 性能提升:在A100 GPU上,EfficientTAM的速度提升了约2倍。

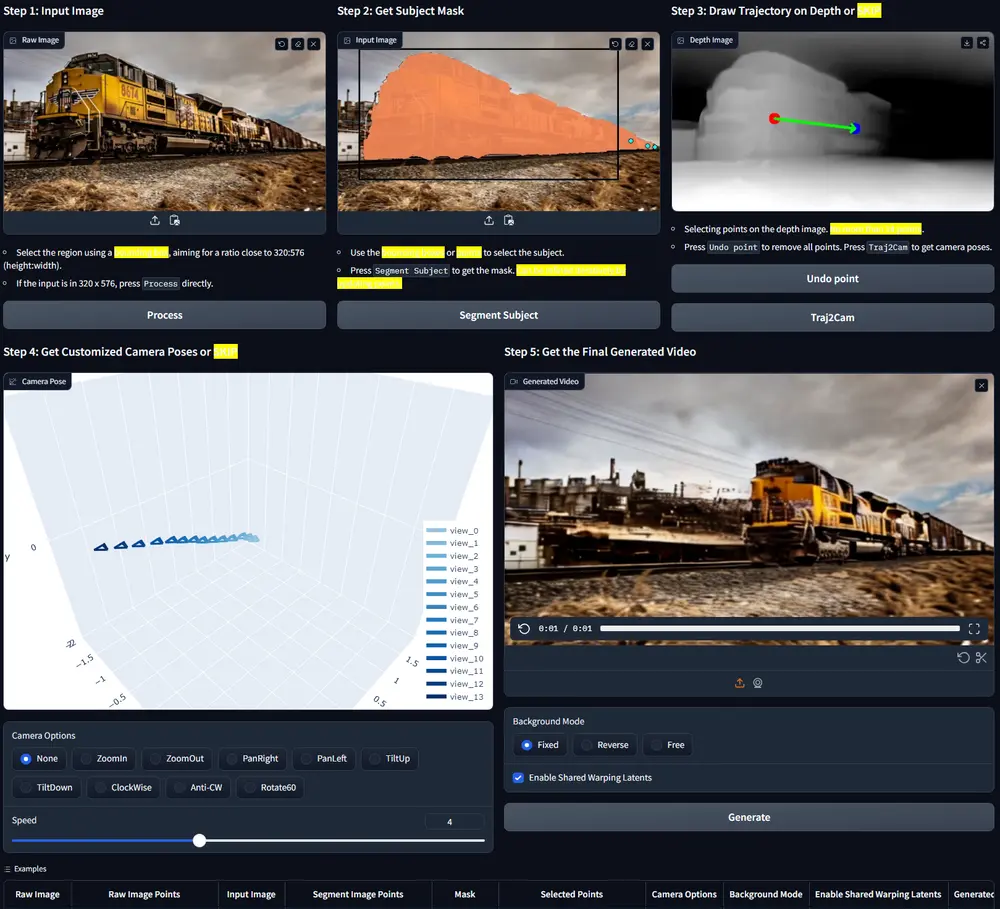

工作原理

EfficientTAM的工作原理基于以下几个关键组件:

- 图像编码器:使用一个预训练的轻量级ViT来提取视频帧的特征。

- 内存机制:通过存储过去帧的记忆上下文来辅助当前帧的分割。

- 高效内存模块:利用记忆空间标记的局部性和粗略表示来减少计算复杂度。

- 跨注意力机制:通过在当前帧特征和存储记忆中执行交叉注意力来理解视频帧之间的时间依赖性。

训练与评估

EfficientTAM在两个大规模数据集SA-1B和SA-V上进行了训练,这两个数据集涵盖了广泛的视频对象分割和跟踪场景。经过充分训练后,EfficientTAM在多个基准测试中展示了卓越的表现,包括但不限于:

- 半监督VOS:在A100 GPU上,EfficientTAM实现了约2倍于SAM 2(HieraB+SAM 2)的加速,并且参数量减少了大约2.4倍。

- 可提示的视频分割:同样在A100 GPU上,EfficientTAM相比原始SAM模型,在分割任务上实现了约20倍的加速和约20倍的参数减少。

- 移动设备性能:在iPhone 15 Pro Max等移动设备上,EfficientTAM可以以约10 FPS的速度稳定运行,提供合理的视频对象分割质量,证明了小模型在实际应用中的潜力。

应用前景

EfficientTAM的推出,标志着视频对象分割和跟踪领域的一个重要进展。凭借其轻量化设计和高效的处理能力,EfficientTAM不仅能够在高端服务器上实现快速、精确的任务处理,还能在移动设备和其他资源受限环境中提供实用的解决方案。这为视频编辑、增强现实、智能监控等多个领域带来了新的可能性。

相关文章