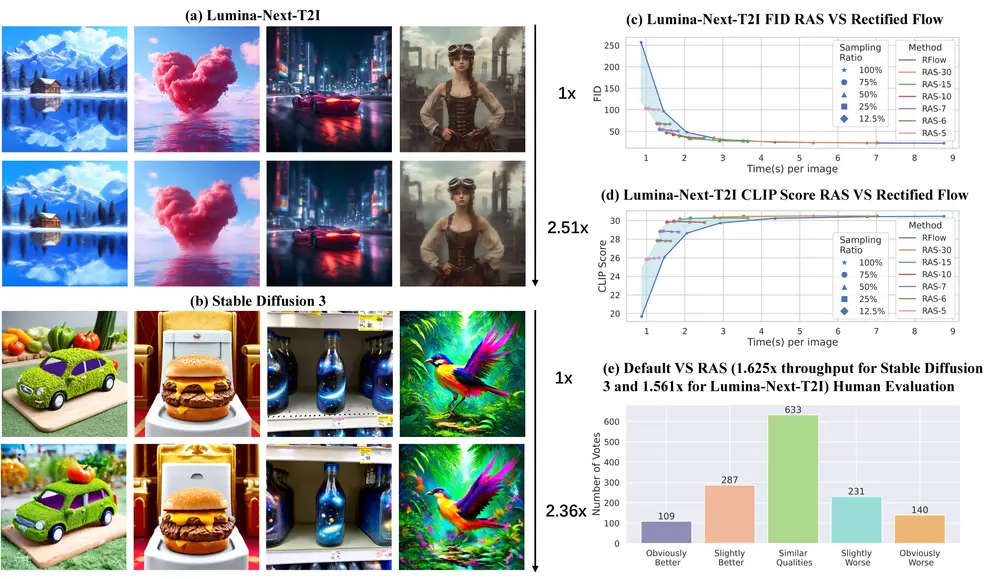

在视觉领域,自回归模型的扩展并没有像在大语言模型中那样取得显著的成功。为了探索这一问题,Google DeepMind 和麻省理工学院的研究人员进行了一项研究,重点探讨了两个关键因素:模型是使用离散还是连续的 Token,以及 Token 是使用 BERT 或 GPT 类 Transformer 架构以随机还是固定光栅顺序生成。研究结果表明,尽管所有模型在验证损失方面都有效扩展,但它们的评估性能(通过 FID、GenEval 分数和视觉质量来衡量)却表现出不同的趋势。

主要发现

- 连续 Token vs. 离散 Token

- 连续 Token:在视觉质量上显著优于使用离散 Token 的模型。连续 Token 允许模型更精细地处理图像数据,减少信息丢失,生成更高质量的图像。

- 离散 Token:虽然在某些任务中表现良好,但在视觉质量上不如连续 Token。

- 生成顺序

- 随机顺序:与固定光栅顺序相比,随机顺序生成显著提高了 GenEval 分数。随机顺序生成有助于模型更好地理解和处理整个图像的内容,而不仅仅是局部细节。

Fluid 模型

基于上述发现,研究人员训练了一个名为 Fluid 的新型自回归文本到图像生成模型。Fluid 的主要特点如下:

- 连续 Token

- 使用连续的 Token 处理图像数据,减少了信息丢失,生成更高质量的图像。

- 随机顺序生成

- 不按固定的光栅顺序生成图像,而是随机选择图像中的任意位置进行生成。这有助于模型更好地理解整体图像的上下文。

- 大规模参数化

- Fluid 模型的参数量达到 10.5B(10.5亿),能够捕捉和学习更复杂的模式和细节。

- 高评分

- 在标准的图像生成评估指标上,如 FID(Fréchet Inception Distance)和 GenEval,Fluid 模型取得了领先的成绩。

- FID:在 MS-COCO 30K 数据集上实现了 6.16 的零样本 FID 新纪录。

- GenEval:在 GenEval 基准测试中获得了 0.69 的总体分数。

工作原理

- 图像令牌化:使用预训练的图像令牌化器将输入图像转换成一系列的 Token。

- Transformer 网络:使用 Transformer 网络根据文本提示预测并生成缺失的 Token。由于使用连续 Token,不需要传统的向量量化步骤,从而保留更多的图像细节。

- 随机顺序生成:在每一步生成过程中,随机选择图像中的任意位置进行生成,考虑整个图像的上下文,而不仅仅是局部顺序。

Fluid 模型通过其创新的连续 Token 和随机顺序生成方法,为文本到图像生成任务提供了一个强大的工具。它在多种评估指标上取得了领先的成绩,展示了在艺术创作、游戏开发、广告营销和社交媒体等多个领域的广泛应用潜力。未来的工作将进一步探索如何缩小视觉和语言模型之间的扩展差距,推动自回归模型在视觉领域的进一步发展。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...