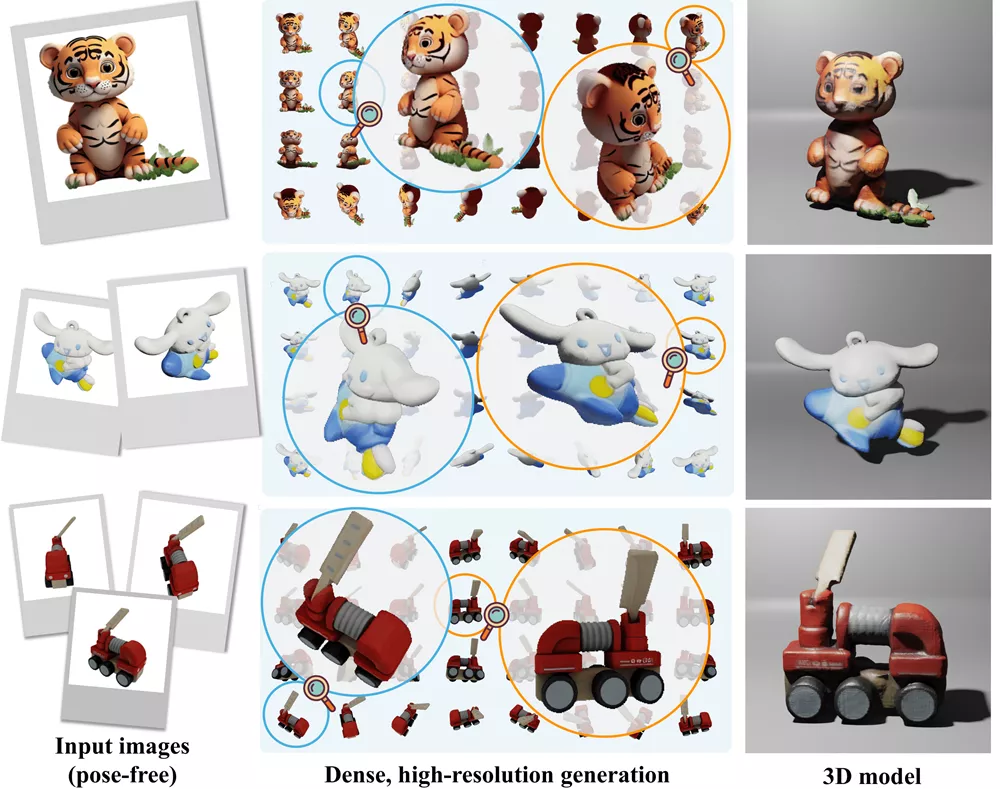

来自西蒙弗雷泽大学和Meta Reality Labs的研究人员推出神经网络架构MVDiffusion++,它用于从单个或少量图像中重建3D物体。这个模型能够在没有相机姿态信息的情况下,生成密集且高分辨率的3D物体视图。

MVDiffusion++的核心创新点有两个:一是“无姿态架构”,它通过2D潜在特征之间的自注意力学习3D一致性,而无需显式使用相机姿态信息;二是“视图丢弃策略”,在训练过程中随机丢弃大量输出视图,减少了训练时的内存占用,并能在测试时生成所有图像的高质量密集视图。

主要功能:

- 生成密集(32个视图)和高分辨率(512×512像素)的3D物体视图。

- 能够在没有相机姿态信息的情况下,从单个或少量图像中重建3D模型。

主要特点:

- 提供了一种灵活且可扩展的方法,用于从少量图像中重建3D物体。

- 使用自注意力机制在2D特征之间学习3D一致性,无需依赖精确的图像投影模型或相机参数。

- 通过视图丢弃策略,模型能够在训练时处理高分辨率图像,同时保持训练效率。

工作原理:

- MVDiffusion++基于一个条件分支和生成分支的多视图潜在扩散模型。条件分支处理输入图像,生成分支生成输出视图。

- 在去噪过程中,模型通过自注意力模块学习不同视图之间的3D一致性,同时通过交叉注意力模块将条件图像的CLIP嵌入注入到其他图像中。

- 在训练时,模型采用视图丢弃策略,随机排除一部分视图,以减少内存消耗。在测试时,模型能够生成所有视图的高质量图像。

应用场景:

- 在计算机视觉和图形学领域,MVDiffusion++可以用于从少量图像中创建3D模型,这对于游戏开发、电影制作、虚拟现实(VR)和增强现实(AR)等领域非常有价值。

- 在教育和研究中,MVDiffusion++可以帮助学生和研究人员更好地理解3D物体的结构和形状,通过从2D图像中重建3D模型。

- 在产品设计和原型制作中,设计师可以快速从概念图或草图中生成3D模型,加速产品开发过程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...