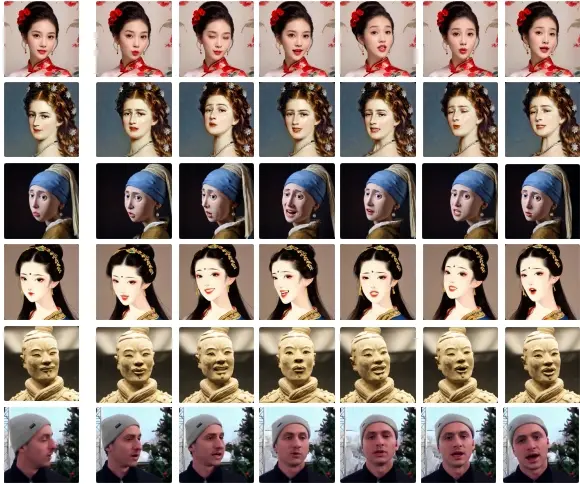

字节跳动和浙江大学的研究人员推出新型人工智能模型Loopy,它专门用于生成与音频同步的逼真人像视频。Loopy的核心特点是完全基于音频信号来驱动人像动作,而不需要额外的空间信号来辅助控制动作,这使得生成的视频更加自然和流畅。具体来说,研究团队设计了一个跨帧和帧内的时间模块以及一个音频到潜在变量的模块,使模型能够利用数据中的长期运动信息来学习自然的运动模式,并提高音频与肖像动作的相关性。这种方法去除了现有方法在推理过程中用于约束动作的手动指定的空间运动模板。

你是一名视频编辑,需要为一个在线课程制作一系列的讲解视频,但讲师无法亲自录制。你可以使用Loopy,只需提供讲师的音频录音,Loopy就能生成讲师的动态讲课视频,包括自然的面部表情和头部动作,让课程看起来就像讲师亲自录制的一样。

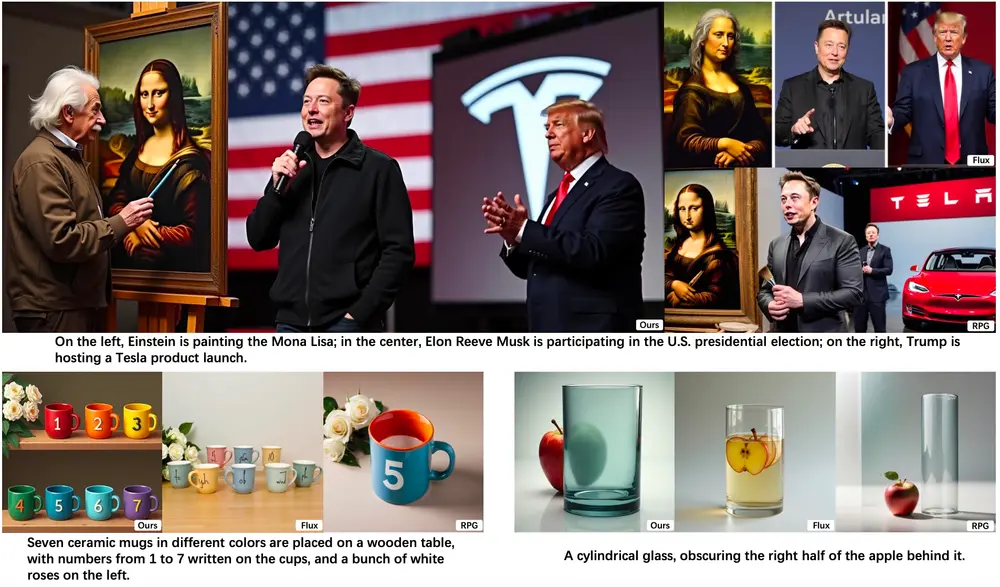

目前类似项目有:

- 闭源:Emo(阿里)、VASA-1(微软)、Hedra(已经产品化)、HeyGen Expressive Photos(已经产品化)

- 开源:Hallo、AniTalker、EchoMimic、AniPortrait、InstructAvatar、V-Express

主要功能:

Loopy的主要功能是将音频输入转换成具有相应面部表情和头部动作的视频。这意味着,只需要给Loopy一段音频,比如人的说话声,它就能自动生成一个看起来像是正在说话的人像视频。

主要特点:

- 音频驱动: Loopy完全依赖音频来生成视频,不需要额外的面部定位器或速度层等空间条件。

- 长期动作依赖: 它通过分析音频和长期动作信息来学习自然的动作模式,提高了音频与人像动作之间的关联性。

- 端到端模型: Loopy是一个端到端的模型,意味着它可以从音频输入直接生成视频输出,无需任何中间步骤。

工作原理:

Loopy的工作原理包括以下几个关键部分:

- 音频处理: 使用wav2vec等工具从音频中提取特征。

- 双时序模块: 设计了跨剪辑和内部剪辑的时序模块,以捕捉不同剪辑之间的动作关系和单个剪辑内的时间关系。

- 音频到潜在空间的转换: 将音频和面部动作相关的特征转换为潜在空间中的动态潜在表示,这些潜在表示在生成过程中作为条件输入。

- 训练策略: 采用多阶段训练和特定的掩码策略,以更好地学习不同条件信息。

具体应用场景:

- 虚拟主播: 在新闻播报或直播中,使用Loopy生成的虚拟形象可以朗读新闻稿或演讲稿。

- 视频会议: 在远程工作中,可以使用Loopy生成的动态人像来提高会议的互动性和真实感。

- 娱乐和游戏: 在游戏或虚拟现实中,Loopy可以用来创建逼真的非玩家角色(NPC),使他们的动作更加自然和符合对话内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...