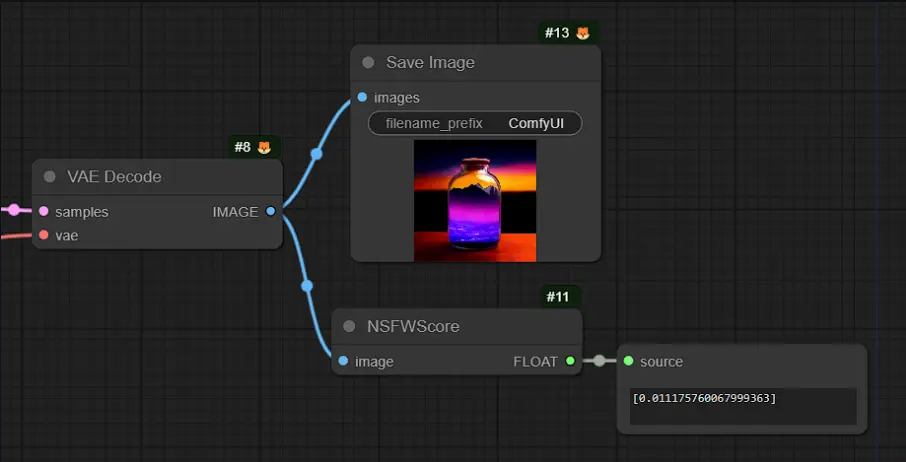

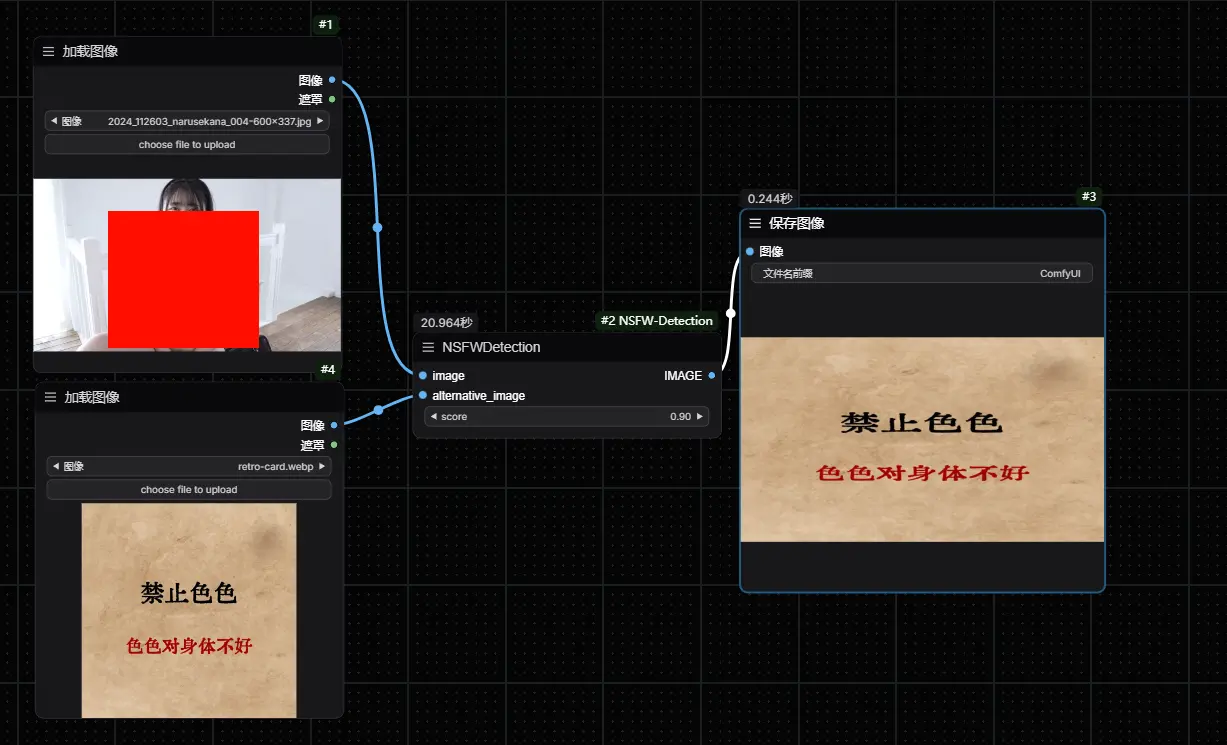

NSFW Check for ComfyUI 是一款专为 ComfyUI 用户设计的插件,旨在检测由 ComfyUI 生成的内容是否包含不适合工作场所展示的元素(NSFW,色情)。该插件利用先进的机器学习技术,能够有效地将图像划分为“适合工作”与“不适合工作”两类,并给出相应的置信度评分。通过这个评分,用户可以在自己的工作流中加入逻辑判断,从而过滤掉潜在的问题图像。对于那些在专业环境中使用 ComfyUI 的个人或团队而言,这一工具显得尤为重要,因为它们需要确保所有生成的内容都是适宜公开分享的。

使用方法

此插件不仅支持用户直接查看单张图片的 NSFW 分数,还特别适用于将 ComfyUI 作为 API 进行集成的场景。通过编程接口,用户可以轻松地实现对 NSFW 内容的自动过滤,并根据实际情况调整敏感度阈值。插件输出的是一个包含多张图片评分的列表,便于进一步处理。

技术细节

NSFW Check for ComfyUI 基于 trumanwong 开发的 ComfyUI-NSFW-Detection 插件构建。核心功能位于 node.py 文件内的 NSFWDetection 类中,该类提供了一个名为 run 的方法,用于执行实际的检测任务。

此方法接收三个参数:

- image: 需要进行分类的图像。

- score: 判定图像为 NSFW 的阈值,通常建议设置为 0.95。

- alternative_image: 若原始图像被判为 NSFW,则返回此备用图像。

注意事项

在安装和使用过程中,请注意以下几点:

- 版本兼容性:

requirements.txt文件中指定了某些依赖库的特定版本(如transformers和Pillow),这些设定可能与其他插件不兼容。建议移除版本限制,以避免潜在冲突。 - 初次使用体验:首次启用节点时,系统会从 Hugging Face 下载必要的检测模型至本地缓存目录(默认路径为

ComfyUI\.cache\huggingface\hub或C:\Users\[用户名]\.cache\huggingface\hub)。请确保网络连接畅通,以便顺利完成下载过程。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...