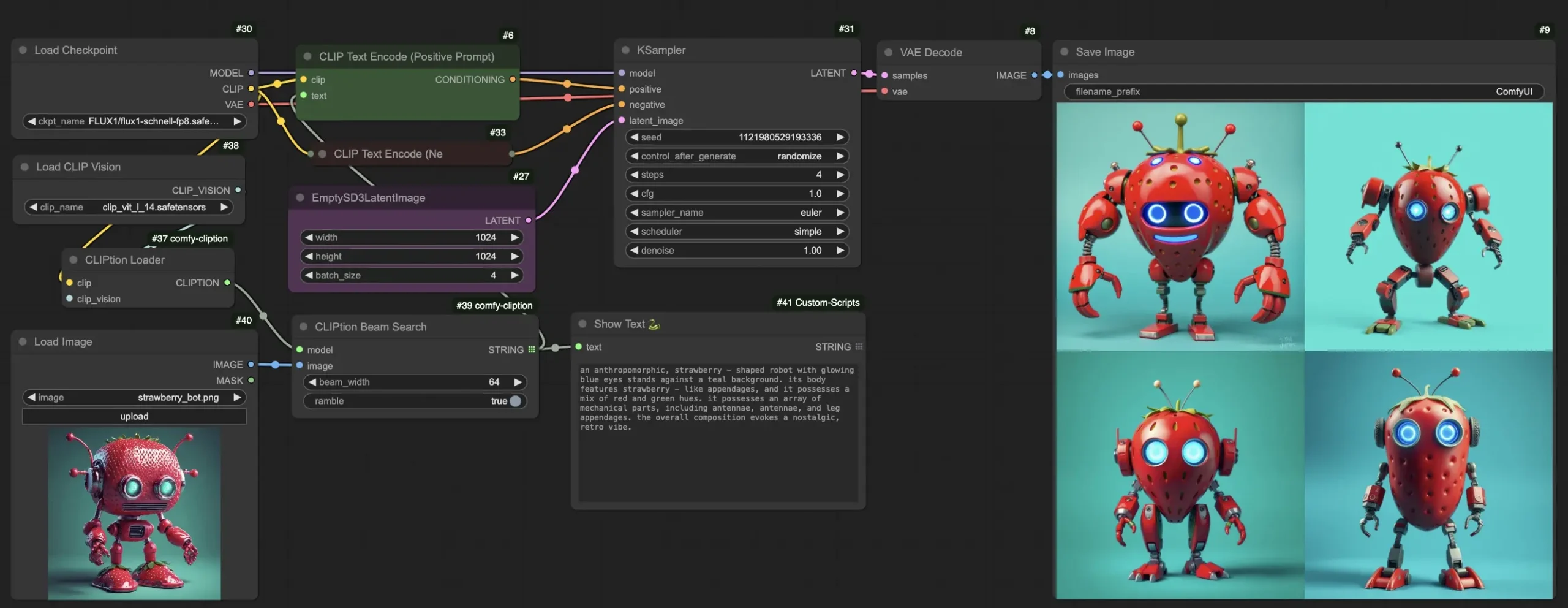

CLIPtion 是一个轻量级且高效的图片描述生成扩展,基于 OpenAI 的 CLIP ViT-L/14 模型。它特别适合与 Stable Diffusion、SDXL、SD3、FLUX 等图像生成模型一起使用。由于这些模型已经加载了 ViT-L,CLIPtion 仅需额外占用约 100MB 内存,即可在工作流中生成图片描述,用于图生图(image-to-image)任务。相比其他更大型的专用图片描述生成模型和视觉语言模型(VLM),CLIPtion 虽然体积小、速度快,但依然提供了良好的 CLIP 对齐选项,使其成为一种高效的选择。

- GitHub:https://github.com/pharmapsychotic/comfy-cliption

- 模型:https://huggingface.co/pharmapsychotic/CLIPtion

安装方法

目前,CLIPtion 尚未在 ComfyUI-Manager 上线,因此需要手动安装。以下是详细的安装步骤:

1、克隆仓库:

- 打开终端或命令行工具,导航到

ComfyUI/custom_nodes目录 - 执行以下命令克隆 CLIPtion 仓库:

cd custom_nodes git clone

https://github.com/pharmapsychotic/comfy-cliption.git2、安装依赖项:

- 进入

comfy-cliption目录并安装所需的 Python 包:

pip install -r comfy-cliption/requirements.txt3、下载模型文件:

- 下载

CLIPtion_20241219_fp16.safetensors文件,并将其放入ComfyUI/custom_nodes/comfy-cliption目录中。如果跳过此步骤,模型将在首次使用时自动下载到您的 Hugging Face 缓存目录中。

4、重启 ComfyUI:

- 完成上述步骤后,重启 ComfyUI 以使新节点生效。

使用方法

CLIPtion 提供了几个关键节点,帮助您生成高质量的图片描述。以下是主要节点及其功能介绍:

CLIPtion Loader

- 功能:加载 CLIPtion 模型。

- 说明:如果

CLIPtion_20241219_fp16.safetensors尚未下载,加载器将在首次运行时自动从 Hugging Face CLIPtion 仓库下载模型。模型将存储在 Hugging Face 缓存目录中(由环境变量HF_HOME控制)。

CLIPtion Generate

- 功能:从单张图像或图像批次生成描述。

- 参数:

- temperature:控制生成的随机性。值越高,输出越多样化;值越低,输出越集中且可预测。

- best_of:并行生成多个描述,并选择与图像 CLIP 相似度最高的描述。

- ramble:强制生成完整的 77 个令牌(适用于某些特定应用)。

CLIPtion Beam Search

- 功能:使用束搜索(beam search)生成描述。

- 参数:

- beam_width:并行考虑的备选描述数量。值越高,探索的可能性越多,但耗时更长。

- ramble:强制生成完整的 77 个令牌(适用于某些特定应用)。

优势

- 轻量高效:仅需额外占用约 100MB 内存,复用了已加载的 ViT-L 模型,减少了资源消耗。

- 快速生成:相比大型专用模型,CLIPtion 生成速度更快,适合实时应用。

- 良好对齐:提供了更好的 CLIP 对齐选项,确保生成的描述与图像内容高度相关。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...