ComfyUI-MultiGPU 是一个实验性的扩展,旨在为ComfyUI工作流中的模型加载节点添加设备选择功能,使用户能够在单个工作流中利用多个GPU。该扩展通过在模型加载节点中引入device参数,允许用户指定模型应加载到哪个GPU上。尽管这并不是一个全面的解决方案,且尚未经过充分测试,但它提供了一种方法来减少VRAM中频繁加载和卸载模型带来的开销,从而可能加速工作流的执行。

注意事项

- 风险自负:由于这是一个实验性扩展,使用时请自行承担风险。

- 非并行执行:工作流步骤仍然是按顺序执行的,只是分配到不同的GPU上。这意味着不会增加并行性,潜在的加速主要来自于减少模型加载/卸载的时间。

- 持续开发:此插件最初由neuratech开发,但已经几个月没有更新。目前,pollockjj接手继续开发,增加了对更多节点的支持。

安装方法

1、通过ComfyUI-Manager安装:

- 打开ComfyUI-Manager,搜索并安装ComfyUI-MultiGPU扩展。

2、手动安装:

- 下载ComfyUI-MultiGPU的代码库。

- 将下载的文件夹复制到ComfyUI的

custom_nodes/目录下。

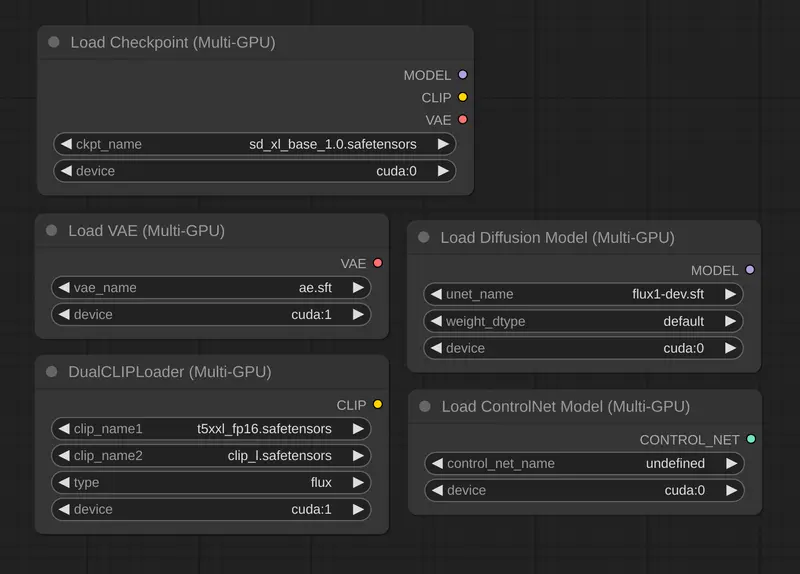

支持的节点

ComfyUI-MultiGPU会自动创建标准加载器节点的MultiGPU版本,并为每个节点添加一个device参数,允许您指定使用的GPU。以下是目前支持的节点列表(如果可用,则会自动检测):

标准ComfyUI加载器

- CheckpointLoaderSimpleMultiGPU

- CLIPLoaderMultiGPU

- ControlNetLoaderMultiGPU

- DualCLIPLoaderMultiGPU

- TripleCLIPLoaderMultiGPU

- UNETLoaderMultiGPU

- VAELoaderMultiGPU

GGUF加载器(需要ComfyUI-GGUF)

- UnetLoaderGGUFMultiGPU(支持量化模型,如flux1-dev-gguf)

- UnetLoaderGGUFAdvancedMultiGPU

- CLIPLoaderGGUFMultiGPU

- DualCLIPLoaderGGUFMultiGPU

- TripleCLIPLoaderGGUFMultiGPU

XLabAI FLUX ControlNet(需要x-flux-comfy)

- LoadFluxControlNetMultiGPU

Florence2(需要ComfyUI-Florence2)

- Florence2ModelLoaderMultiGPU

- DownloadAndLoadFlorence2ModelMultiGPU

LTX Video Custom Checkpoint Loader(需要ComfyUI-LTXVideo)

- LTXVLoaderMultiGPU

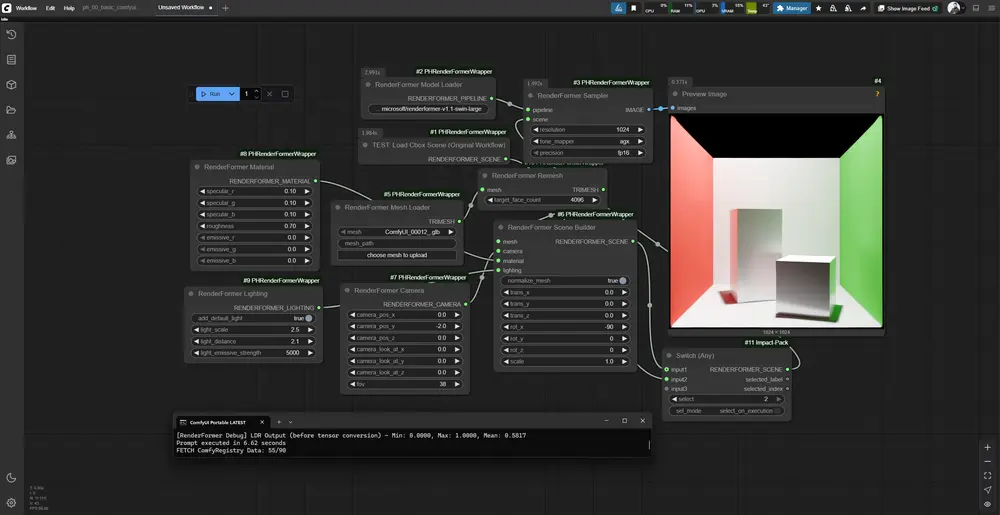

使用方法

所有MultiGPU节点都可以在节点菜单的multigpu类别中找到。在选择这些节点后,您可以在节点设置中看到一个额外的device参数,用于指定要使用的GPU。例如,您可以将某些模型加载到GPU 0,而将其他模型加载到GPU 1,以优化VRAM的使用和减少模型切换的时间。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...