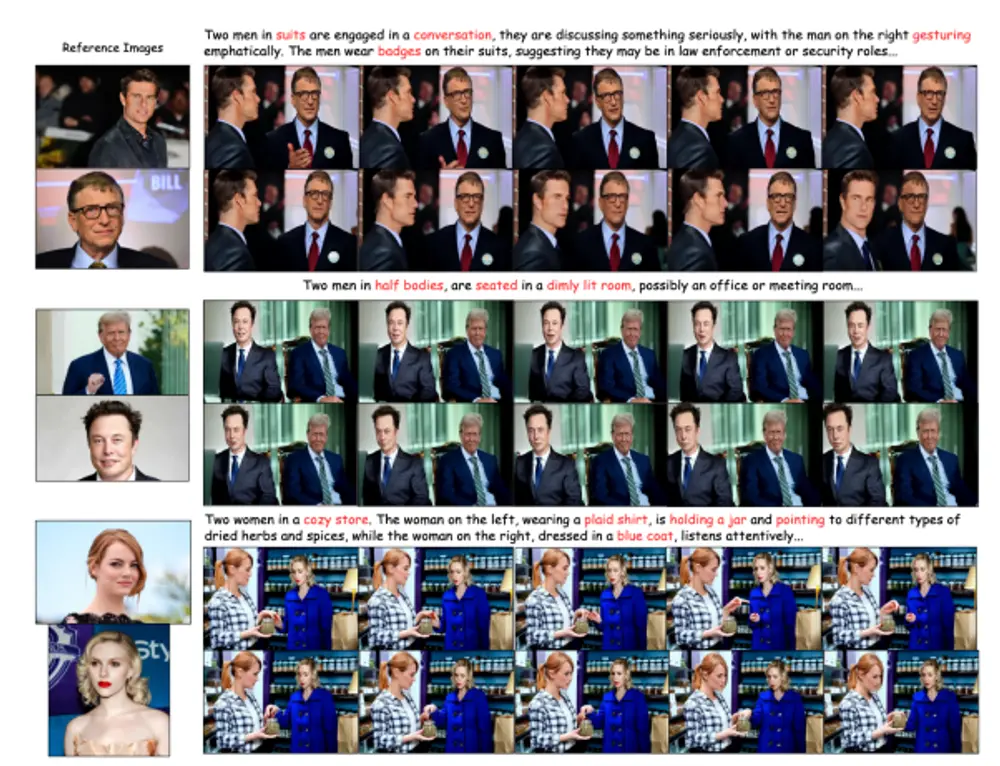

微软亚洲研究院推出新框架VASA-1,它可以根据单张静态图像和语音音频片段,生成具有吸引力的视觉情感技能(VAS)的虚拟角色栩栩如生的说话面孔。这个技术的核心在于它能够精确地捕捉到人脸的微妙动态和头部动作,让生成的视频看起来既真实又生动。VASA-1不仅与音频精准同步地产生唇部动作,还能捕捉丰富的面部细微表情和自然头部运动,从而增强角色的真实感和生动性。该框架的核心创新在于一个面部潜在空间内的全面面部动态和头部运动生成模型,以及利用视频开发的这种具有表现力和解耦的面部潜在空间。

该模型的训练基于 2018 年由牛津大学研究人员创建的 VoxCeleb2 数据库,该数据库包含来自 6,112 名知名人士的超过一百万条语音资料,这些资料均来自 YouTube。 VASA-1 能生成 512×512 像素解像度的影片,每秒最多 40 帧,几乎无延迟,这意味着其潜在应用可包括实时视像会议。

相关:

例如,你是一名教师,想要创建一个虚拟的教学助手,VASA-1可以根据你的一张个人照片和你的语音录音,生成一个看起来像你并且能够讲课的虚拟面孔视频。这个视频可以被用在在线课程中,让远程学习的学生感觉就像在教室里上课一样。这项技术开辟了与逼真的虚拟角色进行实时交流的新途径,这些角色能够模仿人类的对话行为,具有吸引人的视觉情感技能,为更动态和富有同情心的信息交流提供了可能。

主要功能:

- 唇动同步:VASA-1能够生成与音频精确同步的唇部动作。

- 面部表情:它还能够捕捉到丰富的面部表情和微妙的面部动态。

- 头部动作:包括自然的头部运动,增加了视频的真实感。

主要特点:

- 高保真度:生成的视频具有高分辨率和高质量的视觉效果。

- 实时生成:支持在线生成高帧率(高达40 FPS)的视频,且几乎没有启动延迟。

- 表达性与可分离性:通过使用视频数据构建了一个具有表达性和可分离性的面孔潜在空间。

工作原理:

VASA-1采用了基于扩散的全面面部动态和头部运动生成模型,这个模型在一个面部潜在空间内工作。它将所有可能的面部动态(包括唇部动作、表情、眼球运动和眨眼等)视为单一潜在变量,并以统一的方式对其概率分布进行建模。此外,它还结合了一系列可选的条件信号,如主要凝视方向、头部与摄像机的距离和情感偏移,使生成建模更加可行,并提高了生成的可控性。

具体应用场景:

- 数字通信:增强人与人、人与AI之间的交流,使数字通信更加丰富。

- 辅助交流:帮助有沟通障碍的人通过AI生成的面孔进行交流。

- 教育方法:通过交互式AI辅导,改变传统的教育方式。

- 医疗保健:在医疗领域提供治疗支持和社交互动,例如通过虚拟治疗师进行心理治疗。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)