卡内基·梅隆大学的研究人员推出合成语言-视觉数据集StableSemantics,它专注于自然图像中的语义表示。简单来说,这个数据集旨在帮助计算机视觉系统更好地理解图像中的场景和对象的语义含义。它涵盖了22.4万个经过人工精选的提示语句、经过处理的自然语言描述、超200万幅合成图像,以及与各名词短语相对应的1000万份注意力图。

开发人员特意纳入了与视觉效果吸睛的扩散生成图像相匹配的人工创意提示,每个提示下生成10幅图像,并为每一幅图像抽取交叉注意力图谱。开发人员深入分析了生成图像的语义分布特性,考察了图像内部物体的布局分布,并利用数据集对图像描述生成及开放词汇场景分割技术进行了性能评估。

主题介绍

在计算机视觉领域,理解图像中的场景和对象是一个基础但又极具挑战的任务。例如,当我们看到一张图片,我们能够轻易地识别出图片中的建筑、动物或者人,但计算机要做到这一点却非常困难。这是因为即使外观差异很大的物体,也可能具有相似的语义含义或功能。

主要功能

- 图像与文本的关联:数据集通过将自然语言描述与合成图像相结合,帮助模型学习图像内容与文本描述之间的关联。

- 语义分布探索:分析图像和文本中语义概念的分布,以及图像中对象的空间分布。

- 模型评估:提供基准测试,以评估和比较不同图像描述和开放词汇分割模型的性能。

主要特点

- 大规模数据集:包含224千条人工筛选的提示、处理过的自然语言字幕、超过200万张合成图像和1000万个与名词块对应的注意力图。

- 人类生成的提示:利用人类生成的提示,这些提示对应于视觉上有趣的稳定扩散生成图像。

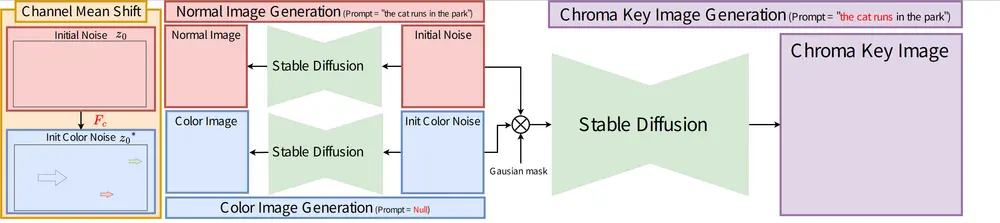

- 跨注意力机制:通过跨注意力机制,模型能够将文本输入链接到视觉表示,生成与输入文本的语义内容相关的图像。

工作原理

- 数据收集:从在线用户公开提交的提示中收集数据,这些提示用于生成图像。

- 文本清理与生成:使用大型语言模型(LLM)对原始用户提示进行清理,并生成自然语言字幕。

- 图像生成:利用稳定的扩散模型(Stable Diffusion XL)根据自然语言字幕生成高分辨率、可复现的图像。

- 语义归因:记录图像生成过程中使用的密集文本到图像的跨注意力图,以确定图像区域与特定名词块的对应关系。

具体应用场景

- 视觉场景理解:帮助模型更好地理解复杂视觉场景,提高深度学习基础的视觉系统的鲁棒性。

- 图像分割和对象检测:数据集可以用于训练和评估图像分割、对象检测/分类模型。

- 视觉问答(VQA):可以用于开发能够回答关于图像内容的问题的模型。

- 图像修复和上色:利用对图像内容的深入理解,进行图像修复或上色等任务。

总的来说,StableSemantics数据集通过结合人类生成的提示、自然语言处理和先进的图像生成技术,为计算机视觉领域提供了一个强大的工具,以推动对图像中语义内容更深层次的理解。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...