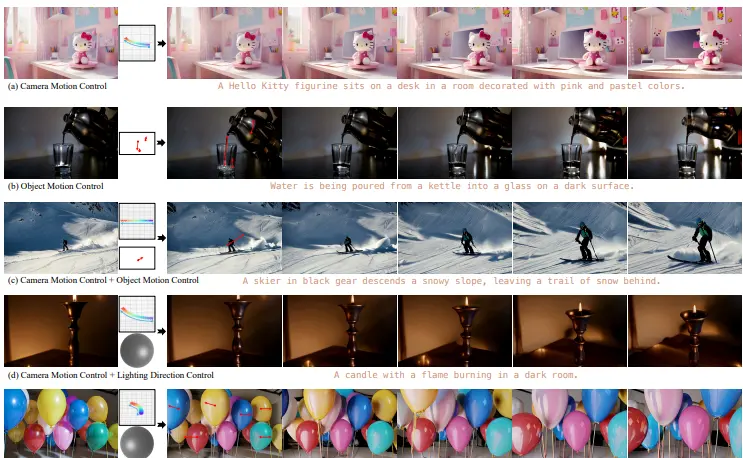

复旦大学、浙江大学、华为诺亚方舟实验室、西湖大学的研究人员推出新型高质量图像到视频生成模型VidCRAFT3 ,能够同时控制相机运动、物体运动和光照方向。它通过解耦这些视觉元素的控制,实现了对生成视频的精细操作。

例如,用户可以输入一张静态图像和一段描述,然后通过定义相机的运动轨迹、物体的运动路径和光照方向,生成一段连贯且自然的视频。

主要功能

- 相机运动控制:用户可以定义相机的运动轨迹,例如围绕物体旋转、推进或拉远,生成具有动态视角变化的视频。

- 物体运动控制:用户可以通过稀疏轨迹定义物体的运动,例如让一个物体在场景中移动或改变姿态。

- 光照方向控制:用户可以调整光照方向,模拟不同角度的光源对场景的影响,例如从左侧照亮物体或模拟逆光效果。

- 多元素组合控制:VidCRAFT3 支持同时使用以上三种控制信号的任意组合,生成符合用户需求的复杂视频内容。

主要特点

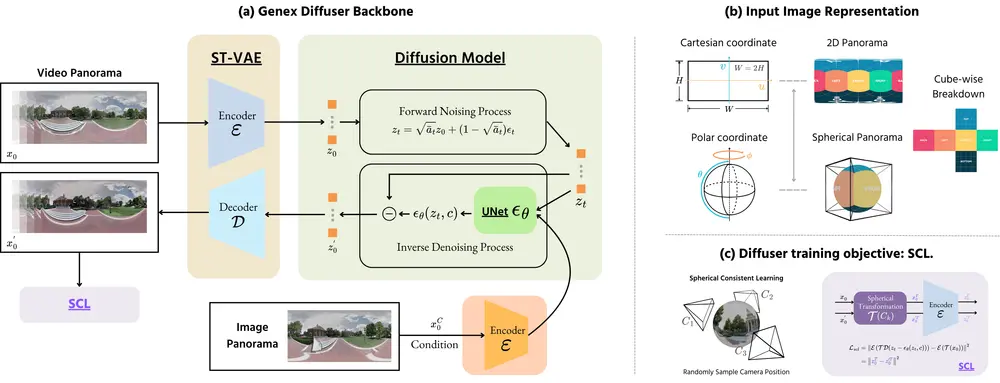

- 解耦控制架构:通过 3D 点云渲染、轨迹编码和光照感知注意力机制,实现了对相机运动、物体运动和光照方向的独立控制。

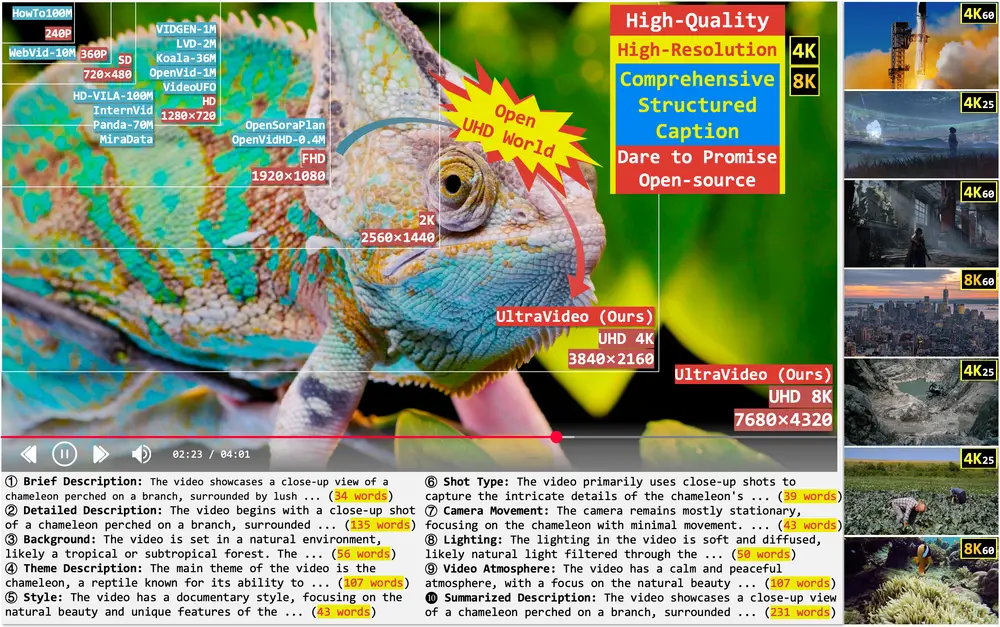

- 高质量合成:生成的视频在视觉质量、时间连贯性和语义一致性方面表现出色,能够处理复杂的光照和物体运动。

- 数据集与训练策略:构建了高质量的合成视频数据集(VideoLightingDirection, VLD),并提出了三阶段训练策略,无需同时标注多种视觉元素的数据。

- 灵活性与通用性:模型能够处理多种场景和物体类别,适用于开放域的视频生成任务。

工作原理

- 相机运动控制:

- 使用 Image2Cloud 模块,将输入图像转换为 3D 点云,并沿用户定义的相机轨迹进行渲染。

- 通过 DUSt3R 模型估计相机参数,生成点云渲染图,然后结合输入图像和文本描述,通过 Video Diffusion Model (VDM) 生成高质量视频。

- 物体运动控制:

- 使用 ObjMotionNet 模块,从高斯平滑的光流图中提取多尺度运动特征,编码稀疏物体运动轨迹。

- 将提取的运动特征通过元素级加法集成到 UNet 编码器中,确保物体运动的精确控制。

- 光照方向控制:

- 使用 Spatial Triple-Attention Transformer,将光照方向嵌入与图像和文本嵌入通过并行交叉注意力层进行融合。

- 通过 Spherical Harmonic (SH) Encoding 将光照方向编码为高维特征,然后通过多层感知机(MLP)投影到 UNet 的特征空间中。

- 三阶段训练策略:

- 第一阶段:使用相机运动控制数据集训练模型,学习空间结构和时间动态。

- 第二阶段:结合物体运动和光照方向控制数据集进行混合微调,优化模型对复杂运动和光照交互的学习。

- 第三阶段:使用稀疏物体轨迹进行微调,增强模型对有限输入的泛化能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...