清华大学联合腾讯混元项目组研发的InteractAvatar,是一款创新的双流DiT(扩散变换器)框架,首次让说话虚拟化身突破简单手势局限,实现基于静态场景的文本驱动可控人-物交互。该模型能从参考图像中感知环境与物体位置,在保持高保真唇部同步和视频质量的同时,精准执行文本指令要求的复杂物体交互动作,彻底解决了传统方法的控制-质量两难问题,成为虚拟化身交互生成领域的全新突破。

- 项目主页:https://interactavatar.github.io

- GitHub:https://github.com/angzong/InteractAvatar

- 模型:https://huggingface.co/youliang1233214/InteractAvatar

核心痛点:传统方法的控制与质量难以兼顾

当前说话虚拟化身生成的核心难题,在于控制精准度与视频保真度的矛盾:

- 部分方法侧重动作控制,却无法让交互动作在真实场景中合理落地,与物体的相对位置、交互方式缺乏合理性;

- 部分方法侧重视频生成质量,却在执行复杂运动和交互时,出现唇部不同步、动作失真、视频帧一致性差等问题;

- 多数方法仅能生成简单手势,无法实现与场景中物体的针对性、复杂交互,应用场景受限。

InteractAvatar的诞生,正是通过全新的双流架构设计,将感知规划与视频合成解耦,从底层解决了这一行业痛点。

核心创新:双流DiT框架,感知规划与视频合成解耦

InteractAvatar的核心设计是两个并行的DiT流模块,通过明确的功能划分实现“精准控制”与“高保真生成”的双重目标,同时引入运动到视频对齐器(M2V) 实现两个模块的协同联动,保证交互动作与视频生成的高度匹配。

1. 感知与交互模块(PIM):交互动作的“规划大脑”

PIM是模型的环境感知与动作规划核心,核心输入为静态参考图像和文本交互指令,采用“感知即生成”的训练策略,最终输出结构化的运动序列(包含人体骨骼姿态、物体边界框定位)。

- 环境感知:从静态参考图像中自动检测物体位置、类别、与化身的相对空间关系,为交互动作规划提供场景依据;

- 指令解析:精准理解文本指令的交互要求,明确“与哪个物体交互、执行何种动作、动作的时序与细节”;

- 动作生成:基于感知结果和指令要求,生成合理、自然的结构化运动序列,确保动作在场景中落地的合理性,解决“控制落地”问题。

2. 音频-交互感知生成模块(AIM):高保真视频的“合成工匠”

AIM是模型的视频与唇部同步生成核心,核心输入为音频、静态参考图像,并通过M2V对齐器接收PIM生成的运动特征,最终输出执行交互动作的高保真说话化身视频。

- 多模态融合:将音频信息(用于唇部同步)、场景信息(参考图像)、动作信息(PIM运动特征)深度融合,保证生成的动作与交互指令、场景环境高度匹配;

- 高保真生成:基于DiT架构实现高质量视频帧生成,保持帧间一致性、化身身份特征不变;

- 精准唇部同步:在执行复杂交互动作的同时,实现音频与唇部动态的精准对齐,保留说话化身的核心表现力。

3. 核心联动:M2V对齐器

作为连接PIM与AIM的关键组件,M2V对齐器负责将PIM生成的结构化运动特征,转化为AIM可识别的生成引导信号,确保两个并行模块的协同工作,让生成的视频帧精准还原规划的交互动作,避免“动作规划”与“视频生成”脱节。

核心优势:四大能力,重构虚拟化身交互生成体验

InteractAvatar在解决控制-质量两难的基础上,实现了多维度能力突破,覆盖场景交互、多模态控制、高保真生成、多场景适配等核心需求,远超传统说话化身生成方法:

- ✅ 基于场景的精准人-物交互

能从静态参考图像中自主感知环境,生成的交互动作与物体位置、场景空间高度匹配,可执行“拿起桌上的杯子”“指向墙上的画”“打开抽屉”等针对性物体交互,而非通用化简单手势。 - ✅ 多模态输入任意组合,控制灵活性拉满

支持文本、音频、运动三种输入的任意组合控制,适配不同使用场景:- 文本+音频:核心使用方式,文本指定交互动作,音频驱动唇部同步;

- 仅音频:无交互指令时,生成高保真唇部同步和自然伴随手势;

- 运动+音频/文本:基于显式运动信号,结合其他输入实现定制化生成;

真正成为统一的多模态可控虚拟化身模型。

- ✅ 说话、行动、交互一体化生成

打破“说话仅动嘴、动作无交互”的局限,实现虚拟化身说话(唇部同步)+ 身体动作 + 物体交互的一体化生成,让虚拟化身的表达更自然、更贴近真实人类行为。 - ✅ 高保真度与强一致性,兼顾质量与体验

通过双流并行协同生成策略,既保证了交互动作的精准控制,又实现了三大高保真效果:- 唇部与音频的精准同步,即使复杂动作也无脱节;

- 视频帧的时间一致性,无帧间失真、跳变问题;

- 化身身份特征一致性,生成过程中保留参考图像的化身外貌、风格特征。

性能表现:多维度实测领先,鲁棒性与泛化能力优异

研究团队在自研的GroundedInter基准测试集(包含400张参考图像、100+种物体类型,覆盖多场景、多物体、多交互动作)上完成全面评估,结果显示InteractAvatar在交互质量、视频一致性、指令跟随能力等方面均显著优于当前SOTA方法,且在多维度场景中展现出强大的鲁棒性和泛化能力。

1. 多物体场景交互:自主感知,精准匹配

从包含多个物体的非交互式参考帧出发,模型能自主判断文本指令指定的交互物体,精准推断其位置和属性,生成的交互动作与物体、场景的空间关系合理,无穿模、位置偏移等问题,同时保持视听高度一致。

2. 多步骤/多动作交互:精准跟随时序指令

面对包含细粒度多步骤、多连续动作的文本指令,模型能准确理解指令的时序逻辑,按照正确的时间顺序依次执行每个动作,动作之间的过渡自然,无卡顿、错乱,展现出极强的复杂指令跟随能力。

3. 长视频与中文能力:保持一致性,适配中文场景

支持长视频分段生成,即使将长视频拆分为多个片段并搭配独立动作描述,模型也能保证帧间时间连贯性、化身身份一致性,无特征漂移;同时完美支持中文文本指令,适配中文场景的实际应用需求。

4. 歌曲驱动生成:高难度场景下的唇部与动作同步

在歌唱这一高难度场景中,模型能基于歌曲音频和分段动作描述,生成高质量唇部动态和匹配歌曲节奏的伴随手势/交互动作,音频与唇部的同步精度高,动作与歌曲的韵律契合度优异。

5. 32种物体交互:鲁棒性强,泛化能力优异

成功实现与32种不同类型日常物体的稳定交互,涵盖餐具、文具、家具、电子设备等多个类别,在所有物体类别上均保持一致的交互质量和视频效果,无明显性能衰减,展现出极强的泛化能力。

6. 多模态控制全覆盖:从交互到纯动作,按需生成

- 可从物体交互自然外推到纯人体动作控制,根据文本指令精准生成无物体交互的身体动作;

- 支持仅音频输入,生成高保真唇部同步和自然伴随手势,保留传统说话化身的核心能力;

- 响应显式运动信号,实现运动驱动的定制化生成,真正做到多模态输入的任意组合控制。

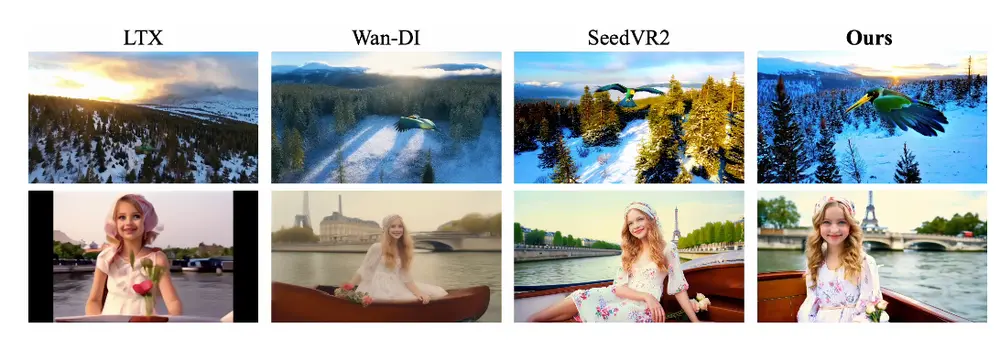

7. 对比SOTA方法:全面领先,解决核心痛点

与当前行业内SOTA说话化身生成方法相比,InteractAvatar展现出压倒性优势:

- 传统SOTA方法多仅能生成唇部动态和简单手势,完全忽略文本交互指令,无法实现人-物交互;

- InteractAvatar在精准执行文本驱动的复杂人-物交互的同时,极大保留了音频驱动的表现力,唇部同步、视频质量、动作自然度均不逊色于专注于生成质量的SOTA方法;

- 彻底解决“控制-质量两难”,实现“精准控制”与“高保真生成”的双重目标。

应用前景:多场景落地,解锁虚拟化身全新价值

InteractAvatar凭借场景化人-物交互、多模态可控、高保真生成的核心能力,打破了虚拟化身的应用边界,可广泛落地于多个实际场景:

- 虚拟数字人直播/客服:让虚拟主播/客服能在固定场景中,根据文本指令与场景中的商品、道具进行交互展示,提升直播/服务的直观性和互动性;

- 虚拟教学/培训:在虚拟教学场景中,让虚拟教师与教学器材、实验道具进行精准交互演示,还原真实教学动作,提升教学效果;

- 元宇宙/虚拟社交:让元宇宙中的虚拟化身能与场景中的物体、道具进行自然交互,提升虚拟社交的沉浸感和真实感;

- 影视/动画制作:快速生成虚拟角色与场景物体的交互视频,降低动画制作中动作设计和视频合成的成本,提升制作效率;

- 智能助手/虚拟导购:让线下/线上的虚拟助手/导购能与周边环境、商品进行交互,为用户提供更直观的指引和展示服务。

研究价值:为虚拟化身交互生成奠定全新框架

InteractAvatar的研发,不仅在性能上实现了突破,更在技术框架上为虚拟化身交互生成领域提供了全新思路:

- 提出感知规划与视频合成解耦的双流DiT架构,为解决“控制-质量两难”提供了可复制的底层设计方案;

- 验证了“从静态参考图像中感知环境并实现精准交互”的可行性,让虚拟化身的交互生成更贴近真实场景;

- 实现了文本、音频、运动多模态输入的统一控制,为多模态可控虚拟化身的研发奠定了基础;

- 自研GroundedInter基准测试集,为后续人-物交互虚拟化身的研究提供了标准化的评估依据。

未来,随着模型的进一步优化(如更长视频生成、更复杂交互动作、动态场景适配),InteractAvatar有望成为虚拟化身交互生成的通用框架,推动虚拟数字人在各行业的规模化落地。

相关文章