谷歌DeepMind发布通用AI智能体下一代产品SIMA 2的研究预览,通过深度整合大语言模型Gemini的语言与推理能力,实现从“单纯遵循指令”到“理解环境并互动”的核心突破。这款由Gemini 2.5 flash-lite驱动的具身智能体,在虚拟世界中展现出自主推理、自我改进、跨环境适配的强大能力,被视为谷歌迈向人工通用智能(AGI)与通用机器人的关键一步。

核心升级:从SIMA 1到SIMA 2的能力飞跃

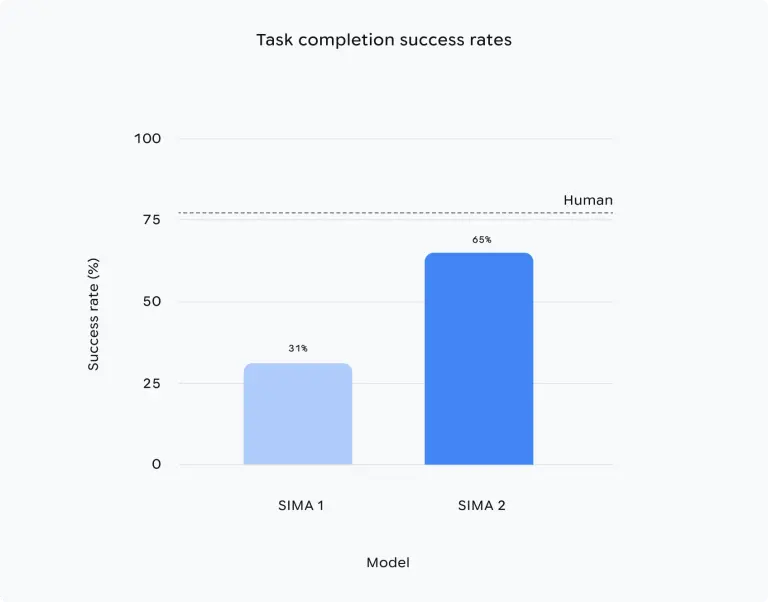

SIMA(Scalable Integrated Model for Agent)系列始于2024年3月发布的第一版,通过数百小时游戏数据训练,能在3D虚拟环境中遵循基本指令,但复杂任务成功率仅31%(人类为71%)。而SIMA 2凭借Gemini的加持,实现了全方位能力升级:

- 性能翻倍:复杂任务处理能力较前代大幅提升,从“被动执行”转向“主动理解与推理”;

- 通用适配:能在未训练过的全新虚拟环境(包括照片级真实场景)中完成复杂任务,泛化能力显著增强;

- 自我改进:无需依赖大量人类数据,通过AI生成任务与反馈实现试错学习,自主优化表现;

- 交互升级:支持自然语言、表情符号等多种指令形式,理解更贴近人类沟通习惯。

核心能力:Gemini赋能的推理与行动

SIMA 2的核心突破源于Gemini大模型的深度整合,使其在虚拟世界中具备类人级的认知与行动能力:

1. 高级推理与环境理解

- 场景分析:能精准描述周围环境(如“No Man’s Sky”中的岩石行星表面),并基于环境判断下一步行动(如识别求救信标并互动);

- 逻辑推导:面对模糊指令时,会通过内部推理明确目标——例如被要求走向“成熟番茄颜色的房子”时,会先得出“成熟番茄是红色”的结论,再定位并接近红房子;

- 常识应用:能以常识性方式回应需求,理解任务背后的核心意图,而非机械执行指令。

2. 多形式指令交互

- 自然语言:支持复杂语义指令,无需简化表达即可准确理解;

- 表情符号:能解析符号化指令,例如收到“🪓🌲”(斧头+树)指令时,会自动执行“砍树”动作,降低交互门槛。

3. 跨环境适配与物体识别

即使在DeepMind世界模型Genie生成的全新照片级真实场景中,SIMA 2也能正确识别长椅、树木、蝴蝶等物体,并实现精准互动,展现出极强的环境适应性。

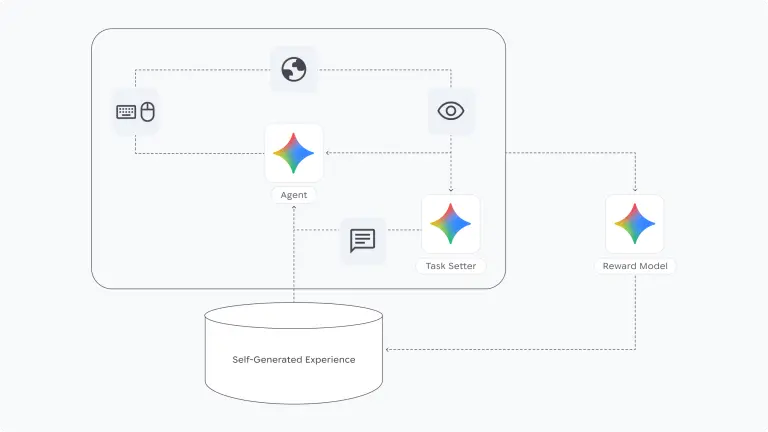

自我改进机制:AI驱动的试错学习

SIMA 2摆脱了对人类训练数据的过度依赖,构建了AI自主迭代的学习闭环:

- 基线基础:以人类游戏玩法数据训练的初始模型为基础,奠定核心能力;

- 任务生成:进入新环境后,由另一Gemini模型自动创建全新任务,模拟多样化场景;

- 反馈评分:通过单独的奖励模型,对SIMA 2的任务尝试进行评分,明确错误与改进方向;

- 迭代优化:将自我生成的任务经验作为训练数据,从试错中自主学习,逐步提升表现——类似人类的自主学习模式,但由AI反馈引导,效率更高。

长远目标:迈向通用机器人与AGI

DeepMind将SIMA 2定位为“解锁更通用机器人”的关键铺垫,其核心价值在于解决现实世界任务所需的“高级理解与推理能力”:

- 能力聚焦:SIMA 2不关注机器人关节控制、轮子驱动等低级物理动作,而是专注于高层级行为——如理解“豆子”“橱柜”等概念,规划导航路径,完成“检查橱柜里豆子数量”这类复杂任务;

- 技术协同:与DeepMind近期发布的机器人基础模型(专注物理世界推理与多步计划)形成互补,共同推进通用机器人的研发;

- AGI导向:SIMA 2的设计完全契合DeepMind对AGI的定义——能处理广泛智力任务、学习新技能、跨领域泛化知识,为未来更全面的通用智能系统奠定基础。

现状与未来:研究预览阶段,暂无明确落地时间表

目前,SIMA 2仍处于研究预览阶段,DeepMind暂未公布以下关键信息:

- 物理机器人落地时间表:团队明确表示SIMA 2与现有机器人基础模型是独立训练的,未透露两者融合应用的具体计划;

- 公开发布时间:尚未确定何时向外界开放SIMA 2的使用权限;

- 合作与应用:当前核心目标是展示技术成果,探索潜在的合作方向与应用场景,而非直接落地产品。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...