字节跳动Seed团队正式推出Seed-OSS系列开放权重模型,该系列均为36B参数规模,聚焦长上下文处理、推理能力与代理任务优化,以Apache-2.0许可证开源,为开发者与研究社区提供高实用性工具。

- GitHub:https://github.com/ByteDance-Seed/seed-oss

- 模型:https://huggingface.co/collections/ByteDance-Seed/seed-oss-68a609f4201e788db05b5dcd

模型家族:3款36B模型,覆盖不同需求场景

Seed-OSS系列包含3款核心模型,均基于统一架构开发,仅在预训练数据与微调方向上存在差异,可满足基础研究、下游应用等不同场景需求:

- Seed-OSS-36B-Base:基础模型,经过合成指令数据预训练,具备更均衡的通用能力,适合作为各类应用的基础底座。

- Seed-OSS-36B-Base-woSyn:基础模型“纯净版”,未引入合成指令数据预训练,为研究社区提供无指令数据干扰的基准模型,便于开展对比实验。

- Seed-OSS-36B-Instruct:指令微调模型,针对下游任务优化,在智能体(Agent)任务(如工具使用、问题解决)与推理能力上表现突出,可直接用于实际应用场景。

核心特性:5大优势,兼顾性能与灵活性

Seed-OSS系列围绕“实用化”与“研究友好”设计,核心特性可概括为5点:

- 灵活控制思考预算:支持动态调整推理长度(类似GPT-OSS的low-high模式),简单任务可缩短思考链提升效率,复杂任务可延长思考链保证精度。

- 增强推理能力:在数学计算、逻辑分析等推理任务中专项优化,同时保持通用能力均衡,避免“偏科”。

- 优化代理智能:针对工具调用、多步骤问题解决等Agent任务打磨,在零售、航空等场景的代理测试中表现优异。

- 研究友好设计:同步提供“含合成指令数据”与“不含合成指令数据”的基础模型,帮助研究者分析指令数据对模型性能的影响。

- 原生长上下文支持:原生上下文长度达512K,可直接处理超长文本(如完整文档、长对话),无需额外截断或拼接。

模型架构:主流技术融合,保障高效运行

Seed-OSS采用因果语言模型架构,整合多项成熟技术,在性能与效率间取得平衡,具体参数如下:

| 核心参数 | 配置详情 |

|---|---|

| 参数量 | 36B |

| 注意力机制 | GQA(分组查询注意力) |

| 激活函数 | SwiGLU |

| 网络层数 | 64层 |

| QKV头数 | 80 / 8 / 8 |

| 头维度 | 128 |

| 隐藏层维度 | 5120 |

| 词汇量 | 155K |

| 上下文长度 | 512K |

| RoPE基础频率 | 1e7 |

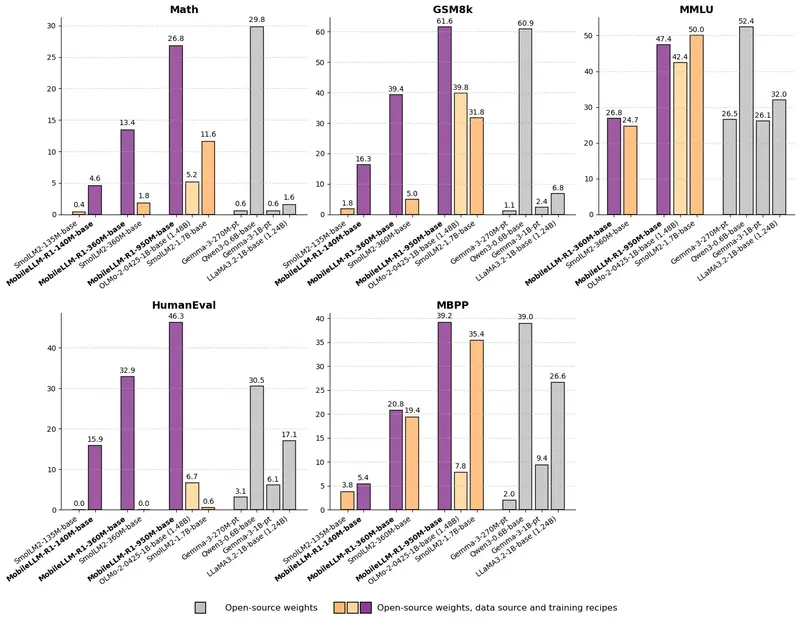

评估结果:多维度测试表现优异,部分指标开源领先

团队针对基础模型与指令微调模型,分别在知识、推理、数学、编程、代理等维度进行测试,部分结果如下(加粗为开源模型最佳表现):

1. Seed-OSS-36B-Base:基础能力扎实

在基础模型对比中,含合成指令数据的Base版本(w/ syn.)在多数基准测试中优于“纯净版”(w/o syn.),尤其在数学任务中优势明显:

| 测试类别 | 基准测试 | Seed-OSS-36B-Base (w/ syn.) | Seed-OSS-36B-Base (w/o syn.) | 其他开源模型参考(如Qwen2.5-32B-Base) |

|---|---|---|---|---|

| 知识 | MMLU-Pro | 65.1 | 60.4 | 58.5 (55.1) |

| 推理 | BBH | 87.7 | 87.2 | 79.1 (84.5) |

| 数学 | MATH | 81.7 | 61.3 | 63.5 (57.7) |

| 编程 | HumanEval | 76.8 | 75.6 | 47.6 (58.5) |

2. Seed-OSS-36B-Instruct:下游任务与代理能力突出

指令微调模型在Agent任务与长上下文测试中表现亮眼,部分指标超越主流开源模型:

| 测试类别 | 基准测试 | Seed-OSS-36B-Instruct | 其他开源模型参考(如OAI-OSS-20B) |

|---|---|---|---|

| 代理 | TAU1-Retail | 70.4 | (54.8) |

| 代理 | SWE-Bench Verified | 56 | (60.7) |

| 长上下文 | RULER (128K) | 94.6 | 78.7 |

| 编程 | LiveCodeBench v6 | 67.4 | 63.8 |

使用建议:采样参数与思考预算调整

为保障模型输出效果,团队提供2点核心使用建议:

- 推荐采样参数:默认使用

temperature=1.1、top_p=0.95;若为Taubench测试场景,建议调整为temperature=1、top_p=0.7。 - 思考预算适配:根据任务复杂度调整思考长度——简单任务(如IFEval指令遵循)无需过长思考链,评分随预算增加可能波动;复杂任务(如AIME数学题、LiveCodeBench编程)建议延长思考链,评分随预算增加呈上升趋势。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...