在 LLM(大语言模型)应用场景日益复杂的背景下,如何将用户查询智能路由到最合适的模型,成为提升效率和体验的关键挑战。

近日,Katanemo Labs 推出了一个创新的解决方案 —— Arch-Router,这是一个基于 1.5B 参数的轻量级路由模型,能够准确识别用户意图,并将其引导至最适合的 LLM,而无需高昂的重新训练成本。

这项技术不仅提高了多模型系统的调度效率,也为开发者提供了一种灵活、可扩展的模型管理方式。

为什么需要 LLM 路由?

随着 LLM 的数量不断增加,企业越来越倾向于采用“多模型架构”,即根据任务类型选择最优模型:

- 代码生成 → 使用 Codestral 或 CodeQwen

- 文案撰写 → 使用 Claude 或 GPT

- 图像理解 → 使用 Gemini Pro 或 Qwen VL

但问题也随之而来:

- 用户输入模糊时,该如何判断使用哪个模型?

- 新模型上线后,是否要重新训练整个系统?

- 如何在性能与成本之间取得平衡?

这就催生了 LLM 路由机制的诞生。

Arch-Router 是什么?

Arch-Router 是一种新型的“偏好对齐路由”系统,其核心目标是:

在不依赖硬编码规则或昂贵再训练的前提下,将用户请求精准匹配到最合适的 LLM。

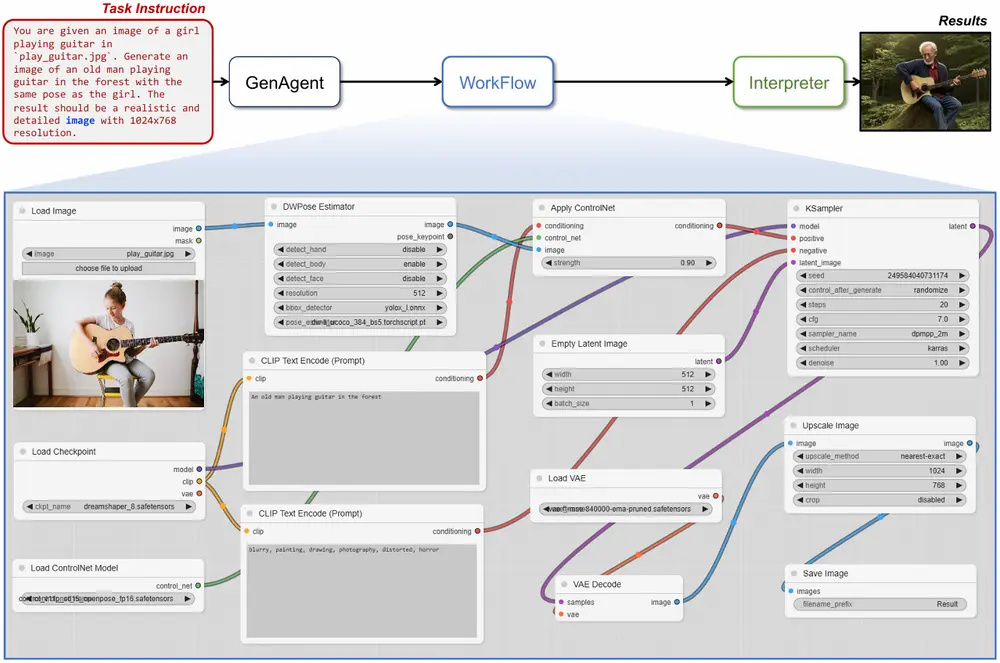

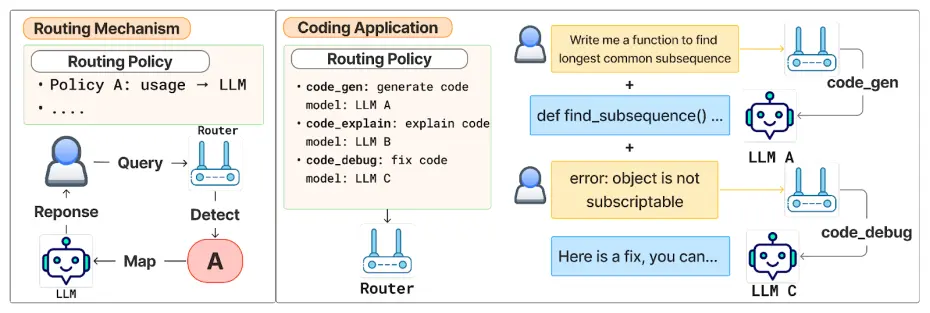

它通过一个两阶段流程完成路由决策:

- 策略选择阶段:根据用户查询语义,从预定义的“领域-动作”分类法中选出最匹配的策略;

- 模型映射阶段:将所选策略映射到对应的 LLM 上执行任务。

这种方式让开发者可以自由添加、替换或移除模型,只需修改策略配置,无需重训路由模型。

技术亮点解析

✅ 偏好对齐路由(Preference-Aligned Routing)

传统路由方法通常依赖固定规则或基准测试分数,而 Arch-Router 更注重人类主观偏好。它允许开发者以自然语言描述任务需求,例如:

- 领域:“法律”

- 动作:“摘要”

这种结构化策略设计不仅易于维护,也更贴近真实世界的任务表达方式。

✨ 上下文学习 + 无需微调

由于策略本身作为提示的一部分传入模型,Arch-Router 可以在推理时动态适应新策略或新模型,无需额外训练。

这意味着:

- 新增模型时,只需更新策略配置文件即可;

- 修改任务分配逻辑时,无需重新部署模型;

- 模型切换更加灵活,适应快速变化的业务需求。

⚡ 高效推理设计,延迟可控

尽管策略可能较长,但研究人员指出,Arch-Router 的输出仅为一个简短的策略 ID(如 code_generation),因此推理速度依然非常快。

CEO Salman Paracha 表示:

“我们可以通过扩展上下文窗口来容纳更多策略,同时保持极低的延迟影响。”

性能表现亮眼:93.17% 准确率

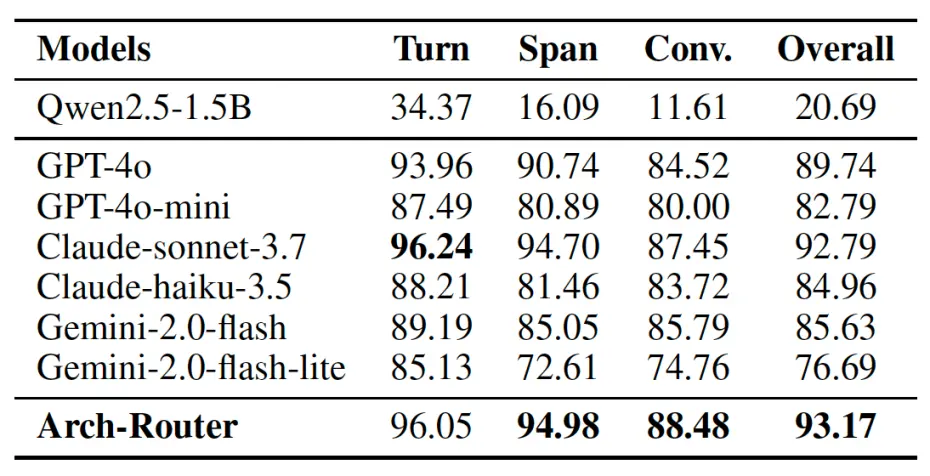

研究人员在包含 43,000 条数据的定制数据集上对 Arch-Router 进行训练,并在多个公共对话评估数据集上与其他主流模型进行对比测试。

结果显示:

| 模型 | 平均路由准确率 |

|---|---|

| Arch-Router(Qwen 2.5 1.5B 微调版) | 93.17% ✅ |

| OpenAI 系列模型 | ~85.46% |

| Anthropic 系列模型 | ~87.32% |

| Google Gemini 系列 | ~89.01% |

尤其是在处理长对话或多轮交互任务时,Arch-Router 展现出更强的上下文理解和一致性判断能力。

实际应用案例

目前,Arch-Router 已成功应用于多个场景:

- 开源编程工具:自动将不同编码任务(如“代码设计”、“代码生成”)路由至最适合的模型

- 文档创作平台:将“文本摘要”导向 Claude,将“创意写作”导向 GPT

- 图像编辑助手:结合 Gemini 和 Qwen-VL,按任务类型自动选择最佳视觉模型

Paracha 表示,该系统特别适用于那些任务类型多样化、模型版本频繁迭代的企业环境。

与 Katanemo Arch 框架深度集成

Arch-Router 是 Katanemo AI 代理服务器 Arch 的一部分,后者是一个完整的 AI 服务代理框架,支持:

- 流量整形与 A/B 测试

- 安全防护与访问控制

- 多模型统一接口管理

- 自动化测试与评估流程

借助 Arch,开发者可以轻松实现以下操作:

- 将少量流量导向新模型进行验证

- 根据内部指标评估性能

- 在确认稳定后逐步扩大流量比例

这使得新模型上线过程更加安全可控,极大降低了试错成本。

Arch-Router 的适用人群

| 角色 | 优势 |

|---|---|

| AI 工程师 | 快速构建多模型系统,避免重复开发 |

| 产品负责人 | 提升用户体验一致性,减少模型切换感知 |

| 运维团队 | 降低部署与更新成本,增强系统弹性 |

| 企业 CTO | 控制模型调用成本,提升整体系统效率 |

相关文章