在图像生成领域,自回归模型长期被视作“文本专家,视觉弱项”——它们擅长逐词生成语言,却难以像扩散模型那样精细构建图像。而如今,阶跃星辰(StepFun)正试图打破这一边界。

- GitHub:https://github.com/stepfun-ai/NextStep-1

- 模型:https://huggingface.co/collections/stepfun-ai/nextstep-1-689d80238a01322b93b8a3dc

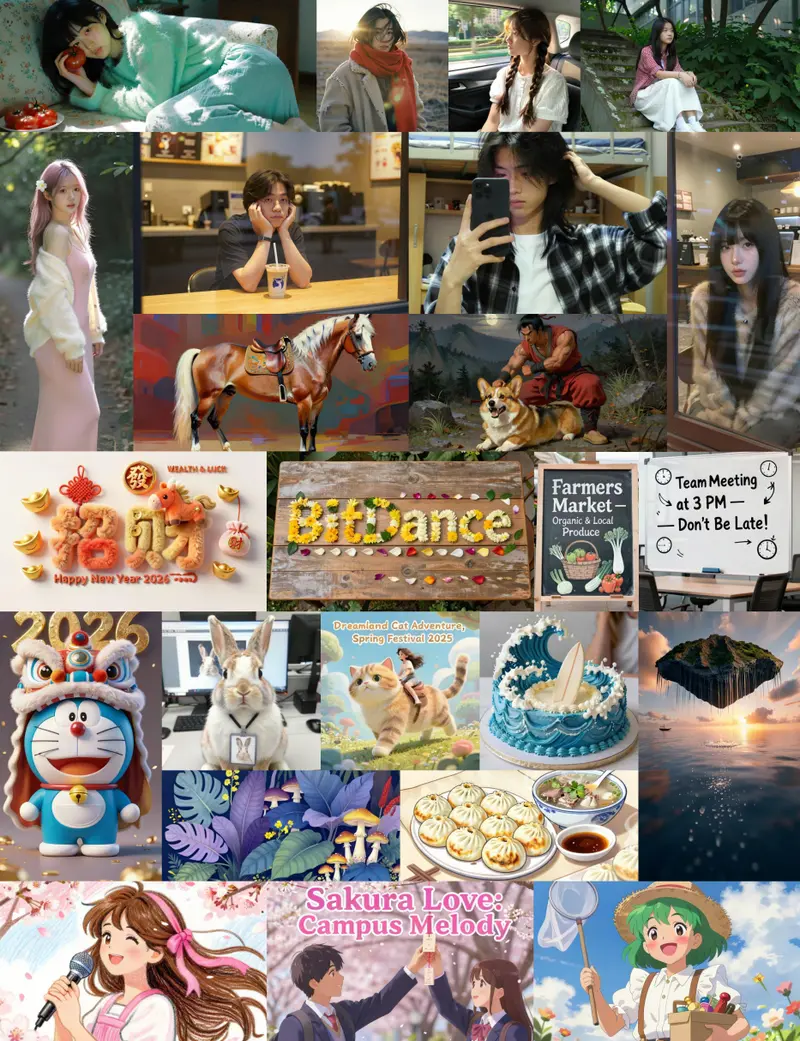

阶跃星辰正式推出 NextStep-1 系列模型,包括 NextStep-1-Large(图像生成)和 NextStep-1-Large-Edit(图像编辑),通过一项关键技术创新:直接处理连续图像令牌,为自回归图像生成开辟了一条新路径。

摆脱“有损压缩”,保留视觉完整性

传统自回归图像模型面临一个根本难题:如何将高维图像转化为模型可处理的“令牌”?多数方案采用矢量量化(VQ),将图像压缩为离散的、低分辨率的视觉令牌,但这一过程不可避免地造成信息损失,导致生成图像模糊或失真。

NextStep-1 的突破在于——不量化。它直接在连续潜空间中操作,保留了视觉数据的完整丰富性。输入图像通过图像编码器(如 Flux VAE)转换为连续潜变量,再经像素洗牌(pixel-shuffling)组织为紧凑序列,供模型处理。

这就像用“模拟信号”代替“数字采样”,避免了传统VQ方法的“音质损失”。

统一框架:文本与图像共用“下一令牌”预测

NextStep-1 采用统一的自回归架构,将离散文本令牌与连续图像令牌混合成单一序列进行建模。其核心组件包括:

- 主干模型:一个拥有 140 亿参数的因果 Transformer,负责整体序列建模;

- 双头输出:

- 文本分支:标准语言模型(LM)头部,预测下一个词;

- 视觉分支:轻量级 1.57 亿参数流匹配头部(Flow Matching Head),预测图像块的连续流。

训练目标是经典的“下一令牌预测”,但视觉部分通过流匹配(Flow Matching)实现:模型学习从噪声逐步“流动”到目标图像的路径,实现高质量生成。

多阶段训练,追求高质量与可控性

NextStep-1 采用三阶段训练策略:

- 预训练:在大规模图文对数据上学习基础生成能力;

- 监督微调(SFT):使用高质量标注数据提升指令遵循与细节表现;

- 直接偏好优化(DPO):对齐人类审美偏好,提升生成结果的自然度与可用性。

这种流程确保模型不仅“能生成”,更能“生成得好”。

性能表现:自回归模型中的领跑者

在多项权威基准测试中,NextStep-1 展现出领先性能:

| 基准 | 指标 | 成绩 |

|---|---|---|

| GenAI-Bench | 高级提示理解 | 0.67 |

| DPG-Bench | 图像保真度 | 85.28 |

| OneIG-Bench | 综合得分 | 0.417(显著优于同类) |

| WISE | 世界知识理解 | 0.54 |

| GEdit-Bench(英语) | 图像编辑能力 | 6.58 |

| ImgEdit-Bench | 编辑准确性 | 3.71 |

尤其在复杂提示理解和细节还原方面,NextStep-1 显示出强大的高保真合成能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...