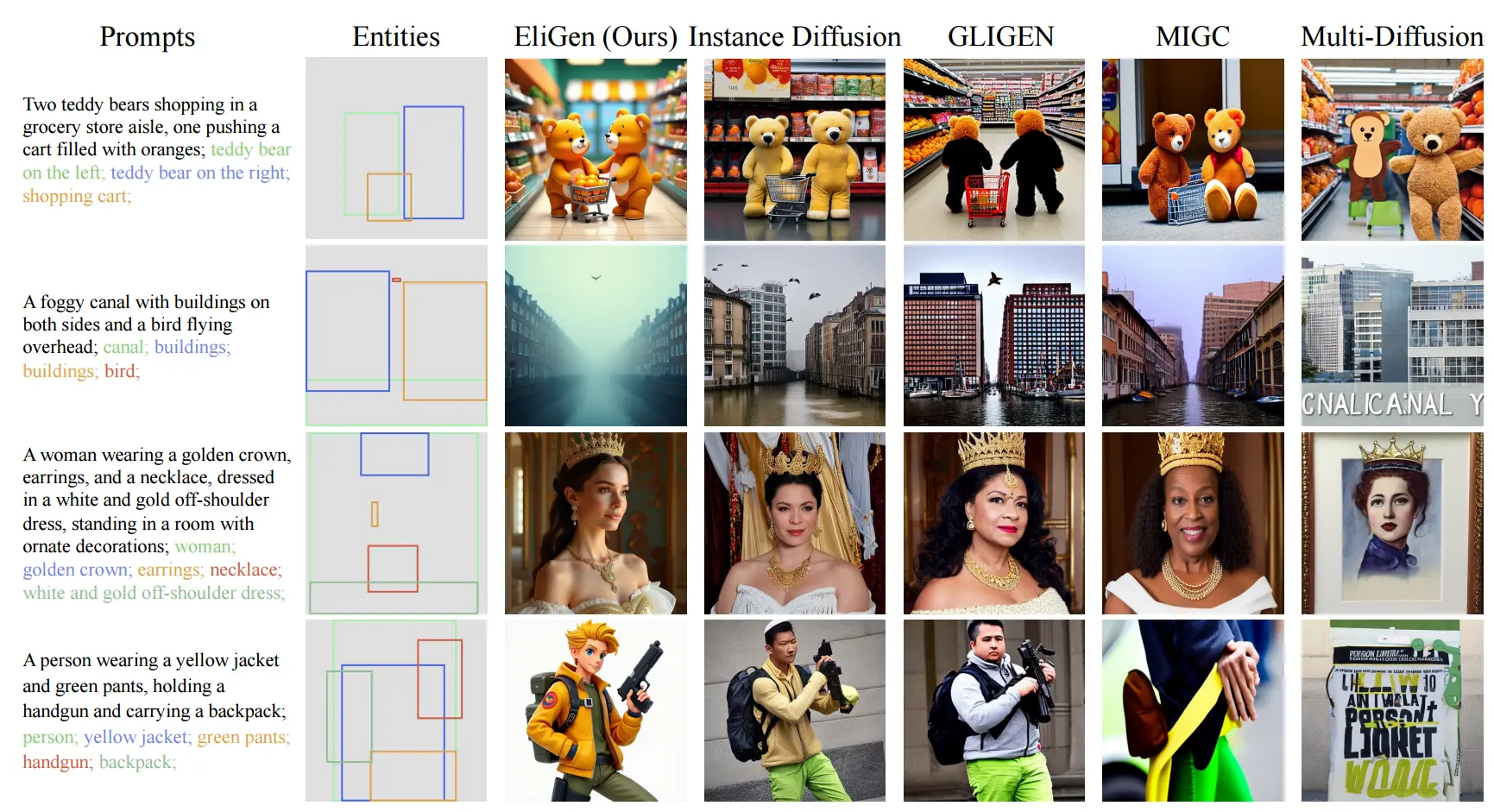

浙江大学控制科学与工程学院、阿里巴巴集团ModelScope团队和华东师范大学的研究人员推出新型框架 EliGen,用于实现图像生成中的实体级控制。EliGen 通过引入区域注意力(Regional Attention)机制,能够在生成图像时对特定实体进行精确控制,同时保持图像的整体质量和一致性。这一框架特别适用于需要对图像中的多个实体进行精细布局和语义控制的场景。

例如,用户希望生成一幅图像,描述的是“一位穿着汉服的女性在花园中跳舞,背景是樱花树”。用户可以提供以下输入:

- 全局文本描述:“一位穿着汉服的女性在花园中跳舞,背景是樱花树。”

- 局部文本描述:

- 女性:穿着汉服

- 背景:樱花树

- 空间掩码:定义女性和背景的位置

EliGen 将这些输入转化为一个联合的文本和图像生成任务,生成一幅符合描述的图像,同时确保每个实体(如女性和背景)的位置和细节与输入描述一致。

主要功能

- 实体级控制:能够对图像中的每个实体进行精确的空间和语义控制。

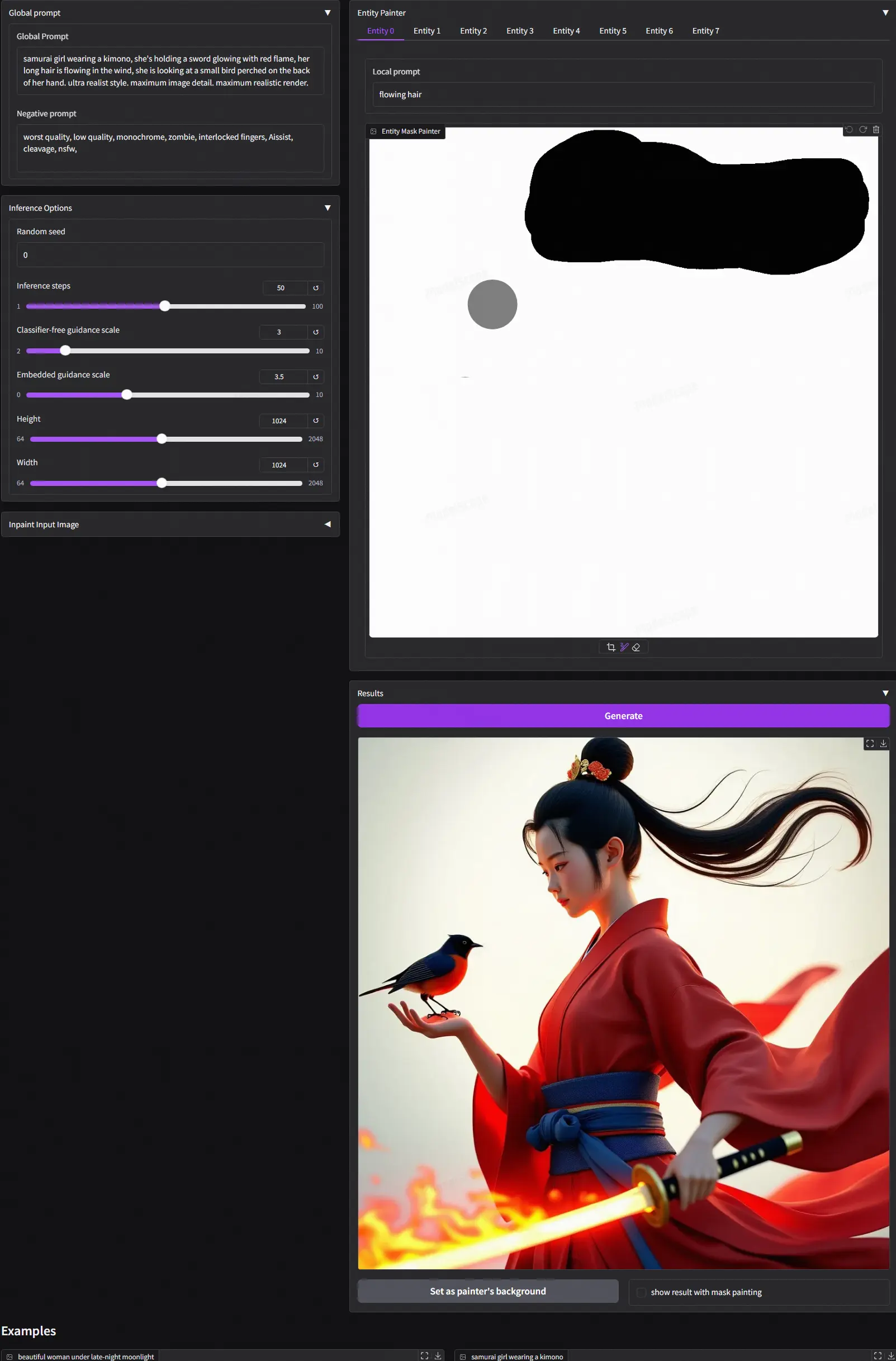

- 任意形状掩码支持:支持任意形状的空间掩码,而不仅仅是矩形框,从而提供更高的灵活性。

- 高质量图像生成:生成的图像在细节和整体质量上均优于现有方法。

- 图像修复(Inpainting):通过区域噪声融合操作,EliGen 还可以用于图像修复任务,如在指定位置添加或替换对象。

- 与其他模型集成:EliGen 可以与现有的开源模型(如 IP-Adapter、In-Context LoRA 和 MLLM)无缝集成,实现更多创意应用。

主要特点

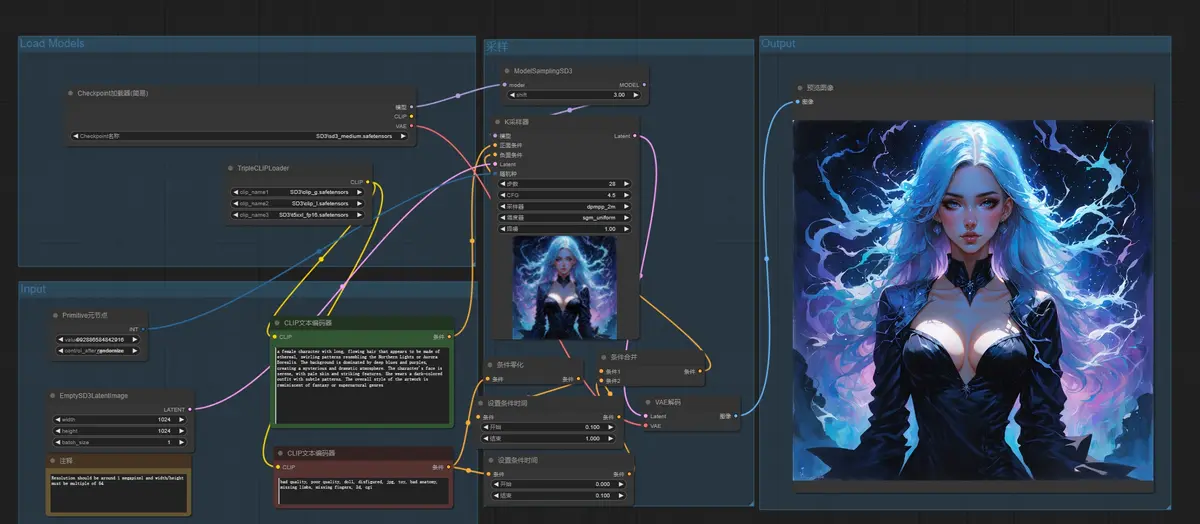

- 区域注意力机制:EliGen 引入了一种无需额外参数的区域注意力机制,能够将实体提示和任意形状的空间掩码无缝集成到扩散模型中。

- 高质量数据集:为了训练 EliGen,作者构建了一个包含 500K 高质量标注样本的数据集,确保模型能够学习到精确的实体级控制能力。

- 高效训练:通过 LoRA(Low-Rank Adaptation)方法进行微调,确保模型能够快速收敛并保持与社区的对齐。

- 灵活的生成能力:EliGen 不仅支持实体级控制,还可以在没有实体输入的情况下生成高质量的图像。

工作原理

EliGen 的工作原理基于以下步骤:

- 问题定义:EliGen 的目标是根据全局文本描述和多个实体级条件(包括局部文本描述和空间掩码)生成图像。

- 区域注意力机制:EliGen 通过扩展扩散模型的注意力模块,将实体提示和空间掩码集成到生成过程中。具体来说,EliGen 使用结构化的文本嵌入来表示语义信息,并构建联合注意力掩码(包括实体-潜在、实体间和实体内注意力掩码),从而实现对每个实体的区域注意力。

- 数据集构建:为了训练 EliGen,作者构建了一个包含 500K 高质量标注样本的数据集,使用 FLUX.1-dev 生成图像,并通过 Qwen2-VL 进行标注。

- 训练和微调:EliGen 使用 LoRA 方法进行微调,确保模型能够快速收敛并保持与社区的对齐。

- 图像修复:EliGen 提出了一种基于区域的噪声融合操作,称为图像修复融合管道,用于在指定位置添加或替换对象。

应用场景

- 创意设计:EliGen 可以用于生成具有特定布局和风格的创意图像,例如广告设计、海报设计等。

- 虚拟场景生成:在虚拟现实和增强现实应用中,EliGen 可以生成具有精确实体控制的虚拟场景。

- 图像修复:EliGen 可以用于修复图像中的缺失部分,例如在照片编辑中添加或替换对象。

- 艺术创作:艺术家可以利用 EliGen 的实体级控制能力,生成具有特定风格和布局的艺术作品。

- 教育和培训:在教育领域,EliGen 可以生成与教学内容相关的图像,帮助学生更好地理解和记忆。

EliGen 通过其强大的实体级控制能力和高效的生成机制,为图像生成任务提供了一个灵活且高效的解决方案,有望在创意设计和虚拟场景生成等领域发挥重要作用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...