蚂蚁集团 inclusionAI 团队正式推出 Ring-2.5-1T,这是全球首个基于混合线性注意力架构的开源万亿参数思维模型,标志着向通用人工智能体迈出关键一步。

- Hugging Face :https://huggingface.co/inclusionAI/Ring-2.5-1T

- ModelScope:https://modelscope.cn/models/inclusionAI/Ring-2.5-1T

在 Ring-2.5-1T 中,团队在预训练与强化学习(RL)全阶段深度扩展混合线性注意力机制,以 1:7 MLA + Lightning 线性注意力 的高效组合大幅提升模型推理速度与自主探索能力;同时通过扩展强化学习训练体系,进一步强化模型的深度思考链与长周期任务自主执行能力,让万亿模型真正实现“想得深、推得快、做得久”。

相较于前代 Ring-1T,Ring-2.5-1T 在三大核心维度实现质的飞跃:生成效率、推理深度、长周期任务执行能力,并在高难度数学、复杂编程、长程智能体等一系列权威基准上达到开源模型顶尖水平。

三大核心突破:效率·思考·长程能力全面跃升

1. 生成效率:长序列吞吐量暴涨,内存开销骤减

依托高比例混合线性注意力架构,Ring-2.5-1T 在超长序列生成场景下实现颠覆性效率提升:

- 在 32K+ token 超长序列生成中,内存访问开销降低 10 倍以上

- 生成吞吐量提升 3 倍以上

- 特别适配深度思考、长文本生成、长周期智能体执行等重度推理场景

即使在万亿参数规模下,模型依然能以轻量化开销稳定运行,生成长度越长,优势越明显。

2. 深度思考:金牌级数学推理,严谨性全面强化

Ring-2.5-1T 在 RLVR 框架基础上创新引入密集奖励机制,对模型每一步推理逻辑、证明严谨性、步骤合理性提供精细化反馈,让思考链更稳定、更可靠。

这一升级直接带来顶级数学能力:

- IMO 2025:满分 42 分,取得 35 分,达到国际金牌水平

- CMO 2025:满分 126 分,取得 105 分

- 远超金牌线(78 分)

- 远超国家集训队选拔线(87 分)

与 Ring-1T 对比,Ring-2.5-1T 在逻辑严谨性、高阶证明技巧、表述完整性上实现全面跃升。团队已公开完整解题过程,可在 GitHub 查看详细推导与证明步骤。

3. 长周期任务执行:全异步智能体强化学习,支持复杂自主任务

通过大规模全异步智能体强化学习,Ring-2.5-1T 具备了真正意义上的长期自主规划、多步工具调用、复杂任务闭环执行能力,可稳定适配主流智能体框架:

- Claude Code

- OpenClaw 个人 AI 助手

- 各类智能体编程、软件工程系统

模型不再局限于“单轮回答”,而是能够像智能体一样自主拆解目标、持续推进任务、长期保持状态一致性。

权威基准表现:开源思维模型新标杆

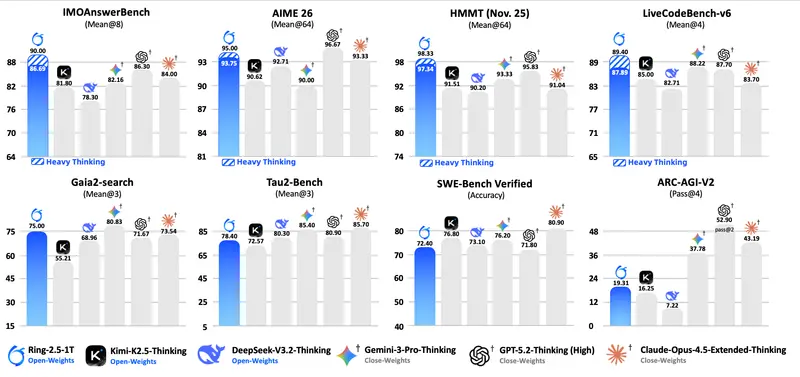

为全面验证深度思考与长程执行能力,团队将 Ring-2.5-1T 与当前主流开源思维模型(DeepSeek-v3.2-Thinking、Kimi-K2.5-Thinking)及头部闭源 API(GPT-5.2、Gemini-3.0-Pro、Claude-Opus-4.5-Extended)进行系统对比。

结果显示:Ring-2.5-1T 在高难度推理与长周期智能体任务两大方向均达到开源模型 SOTA 水平。

高难度推理(数学、编程、逻辑)

- IMOAnswerBench

- AIME 26

- HMMT 25

- LiveCodeBench

- ARC-AGI-V2

长周期智能体任务(搜索、工具调用、软件工程)

- Gaia2-search

- Tau2-bench

- SWE-Bench Verified

特别在 Gaia2-search 这一强调跨应用工具协作、复杂多步规划、长程执行的挑战性任务中,Ring-2.5-1T 取得开源模型 SOTA,展现出极强的规划生成与工具调用准确性。

此外,模型支持重度思考模式:在推理阶段扩展并行思考 + 总结增强,通过推理时缩放(test-time scaling)进一步提升推理深度与广度,应对超难问题更稳定。

核心架构:万亿参数混合线性注意力,长视野推理新范式

通用智能体时代,深度思考 + 长视野已成为大模型核心能力范式,而这对模型架构、长序列解码效率提出极高要求。

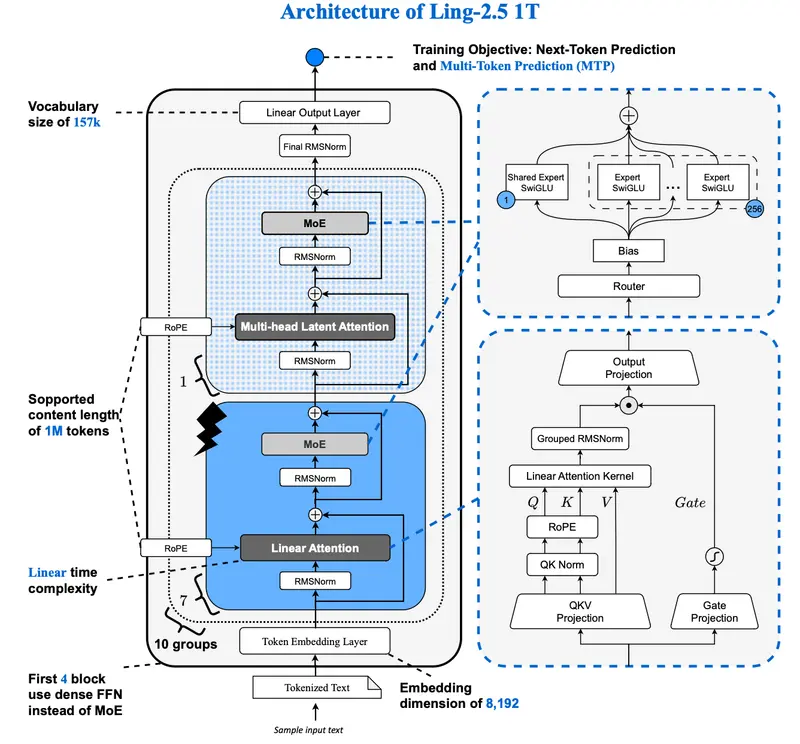

Ring-2.5-1T 所基于的 Ling 2.5 架构,正是为解决这一难题而设计的下一代架构:

在 Ring 2.0 基础上,团队将原有的 GQA(分组查询注意力) 全面升级为:

1:7 比例混合的 MLA(多头线性注意力)+ Lightning Linear Attention

具体技术路径:

- 在 Ring-flash-linear-2.0 技术路线上,将部分 GQA 层替换为 Lightning Linear Attention,大幅提升长视野吞吐量

- 将剩余 GQA 层近似转换为 MLA,进一步压缩 KV Cache

- 针对性适配 QK Norm、Partial RoPE 等特性,增强模型表达能力

升级后,万亿级 Ling 2.5 架构的激活参数量从 51B 提升至 63B,但推理效率仍显著超越 Ling 2.0。

即使与仅 32B 激活参数的 Kimi K2.5 架构相比,Ring-2.5-1T 在长视野任务吞吐量仍保持明显优势,且生成长度越长,优势越显著。

团队已在以下环境完成实测:

- 单机 8 × H20-3e GPU,batch size=64

- 单机 8 × H200 GPU,batch size=64

在不同生成长度下,解码吞吐量均展现出领先的效率表现。

Ring-2.5-1T 重新定义万亿思维模型

Ring-2.5-1T 不仅是全球首个万亿参数混合线性注意力思维模型,更是一套面向通用智能体的完整系统:

- 更快:长序列开销降低 10 倍,吞吐量提升 3 倍

- 更深:IMO/CMO 双金牌,推理严谨性达到竞赛级

- 更远:支持 500+ 轮长程工具调用,适配主流智能体框架

- 更开放:开源架构、开源权重、开源解题过程,推动思维模型生态发展

它证明:万亿模型不必笨重,小激活参数也能拥有深度思考,线性注意力可以支撑真正的通用智能体。

相关文章