阿里通义实验室正式发布 Qwen3-Max-Thinking,作为 Qwen 系列的最新旗舰推理模型。通过显著扩大参数规模并投入大量强化学习训练算力,该模型在事实准确性、复杂推理、指令遵循、人类偏好对齐和智能体能力等关键维度上实现全面提升。

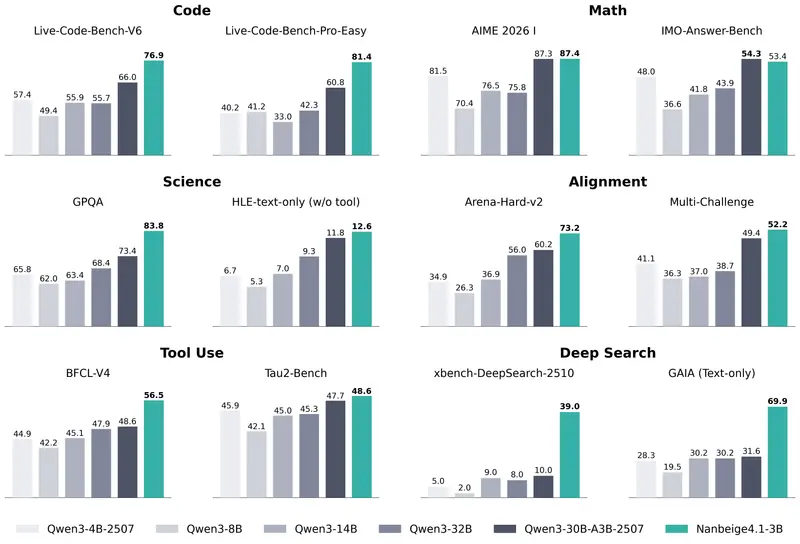

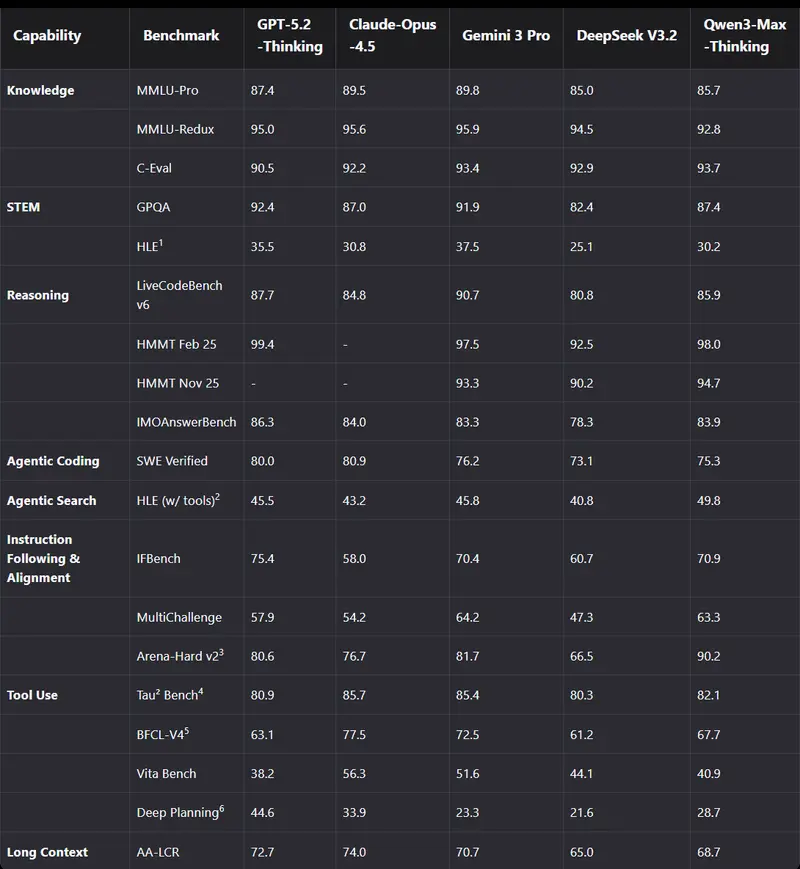

在 19 项权威基准测试中,Qwen3-Max-Thinking 的性能已可媲美 GPT-5.2-Thinking、Claude Opus 4.5 和 Gemini 3 Pro 等国际顶尖模型,并在部分任务上实现超越。

两大核心技术突破

1. 自适应工具调用(Adaptive Tool Use)

不同于早期需用户手动选择工具的方式,Qwen3-Max-Thinking 能在对话中自主判断是否需要调用外部工具,并动态选择以下内置能力:

- 搜索引擎:获取实时信息,缓解幻觉问题

- 记忆模块:结合历史上下文提供个性化回复

- 代码解释器:执行 Python 等代码片段,完成数值计算、数据处理或逻辑验证

该能力源于两阶段训练:先进行工具使用微调,再通过基于规则与模型反馈的强化学习,在多样化任务中优化决策策略。

目前,自适应工具调用功能已在 chat.qwen.ai 上线,用户可直接体验“思考-调用-回答”的完整智能体工作流。

2. 测试时扩展(Test-Time Scaling)

Qwen3-Max-Thinking 引入一种经验累积式、多轮迭代的测试时扩展策略,显著提升复杂推理性能。

传统方法通常通过增加并行推理路径(N 个独立采样)来提升效果,但易导致冗余计算。而 Qwen3-Max-Thinking 采用更高效的设计:

- 限制并行轨迹数量,节省计算资源

- 通过 “经验提取”机制,从历史推理轮次中提炼关键洞见

- 在后续迭代中聚焦未解决的不确定性,避免重复推导已知结论

- 相比直接拼接原始轨迹,该机制在相同上下文窗口内实现更高信息融合效率

性能提升实测(相同 token 消耗下):

| 基准 | 原始 | + Test-Time Scaling |

|---|---|---|

| GPQA | 90.3 | → 92.8 |

| HLE | 34.1 | → 36.5 |

| LiveCodeBench v6 | 88.0 | → 91.4 |

| IMO-AnswerBench | 89.5 | → 91.5 |

| HLE (w/ tools) | 55.8 | → 58.3 |

该技术使模型在数学、代码、科学推理等高难度任务上表现更接近人类专家水平。

开发者快速接入

Qwen3-Max-Thinking 已开放 API(模型名:qwen3-max-2026-01-23),并完全兼容 OpenAI 与 Anthropic API 协议,极大降低迁移成本。

方式一:通过 OpenAI 兼容接口调用

from openai import OpenAI

import os

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

)

completion = client.chat.completions.create(

model="qwen3-max-2026-01-23",

messages=[{"role": "user", "content": "简要介绍大语言模型"}],

extra_body={"enable_thinking": True} # 启用 Thinking 能力

)

print(completion.choices[0].message.content)

方式二:与 Claude Code 集成(支持 Anthropic 协议)

# 安装 Claude Code

npm install -g @anthropic-ai/claude-code

# 配置环境变量

export ANTHROPIC_MODEL="qwen3-max-2026-01-23"

export ANTHROPIC_SMALL_FAST_MODEL="qwen3-max-2026-01-23"

export ANTHROPIC_BASE_URL="https://dashscope.aliyuncs.com/apps/anthropic"

export ANTHROPIC_AUTH_TOKEN="your-dashscope-api-key"

# 启动

claude

用户可在本地终端中直接使用 Qwen3-Max-Thinking 进行编程、调试与智能辅助,享受与 Claude 生态无缝集成的体验。

如何获取 API 访问权限?

- 注册 阿里云账号

- 开通 Model Studio 服务

- 在控制台创建 DashScope API Key

- 即可调用

qwen3-max-2026-01-23模型

当前 API 支持国际站(

dashscope-intl.aliyuncs.com)与国内站,开发者可根据部署需求选择端点。

相关文章