腾讯推出了Hunyuan-TurboS,这是一个新型的大型混合 Transformer-Mamba 专家混合(MoE)模型。它结合了 Mamba 架构在长序列处理上的高效性与 Transformer 架构在上下文理解上的优势,并采用了自适应长短链思考(CoT)机制,能够根据问题的复杂程度动态切换响应模式,优化计算资源的使用。

- GitHub:https://github.com/Tencent-Hunyuan/Hunyuan-TurboS

- Demo:https://huggingface.co/spaces/tencent/hunyuan-turbos

主要功能

- 高效长序列处理:通过 Mamba 架构,能够高效处理长序列数据,支持长达 256K 的上下文长度。

- 上下文理解:借助 Transformer 架构,提供卓越的上下文理解能力,适用于多种自然语言处理任务。

- 自适应思考模式:根据问题的复杂性,自动在快速响应模式和深度思考模式之间切换,优化资源使用。

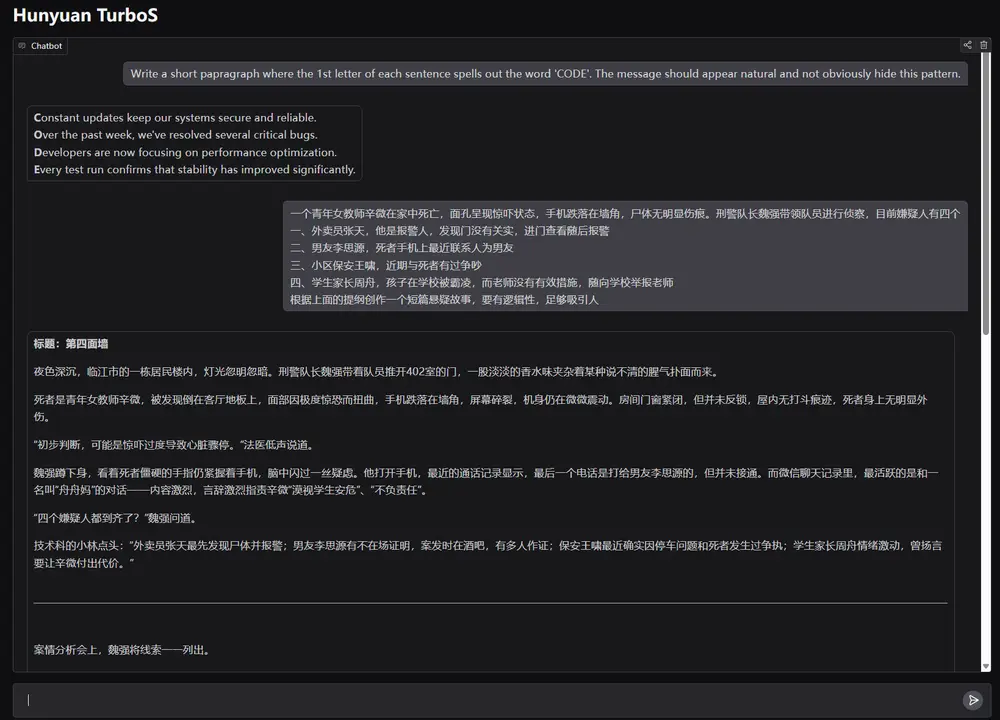

- 多领域任务支持:支持数学推理、逻辑推理、代码生成、知识问答等多种任务。

主要特点

- 混合架构:结合了 Transformer、Mamba2 和前馈网络(FFN)组件,兼具性能和效率。

- 自适应 CoT 机制:能够根据问题的复杂性动态选择思考模式,平衡推理质量和计算效率。

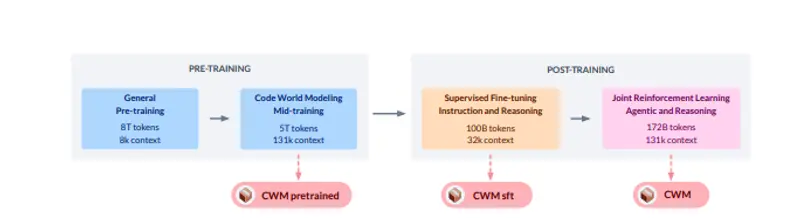

- 大规模预训练:在 16 万亿高质量标记上进行预训练,支持 256K 上下文长度。

- 多阶段后训练策略:包括监督微调、自适应长短 CoT 融合、多轮审议学习和两阶段大规模强化学习。

工作原理

- 混合架构设计:采用 128 层的混合架构,包含 57 层 Mamba、7 层注意力和 64 层 FFN,使用 AMF/MF 块模式平衡性能和效率。

- 自适应 CoT 机制:通过内部教师模型生成训练数据,训练模型自主选择思考模式,结合强化学习框架进一步优化。

- 多阶段后训练:先进行监督微调建立基础能力,再通过自适应 CoT 融合、多轮审议学习和两阶段强化学习逐步提升模型性能。

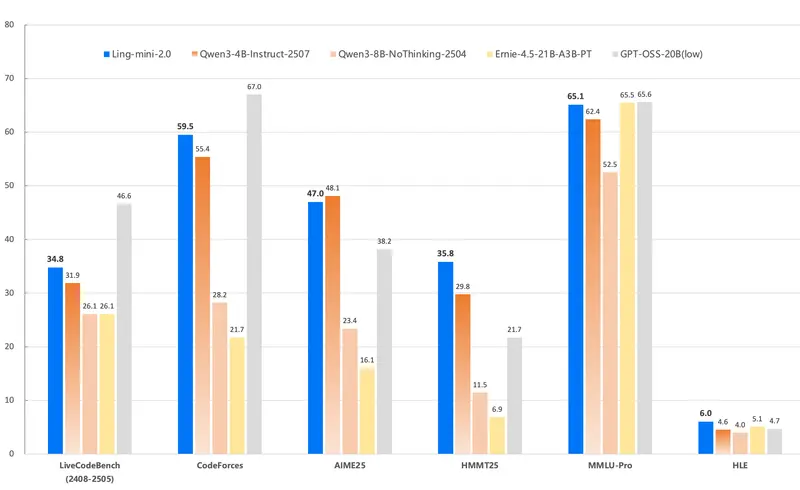

测试结果

- LMSYS Chatbot Arena:在 239 个模型中排名第 7,得分 1356,超过 Gemini-2.0-Flash-001 等领先模型。

- 自动化评估:在 23 个自动化基准测试中平均得分 77.9%,在数学、编程和一般领域表现突出。

- 推理效率:与 Deepseek-R1 和 Qwen3-235B-A22B 等模型相比,Hunyuan-TurboS 在保持高性能的同时,显著降低了推理成本。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...