艾伦AI研究所(AI2)于周四发布了 Olmo 2 1B,这是一个拥有 10 亿参数的 AI 模型。AI2 宣称,该模型在多项基准测试中击败了谷歌、Meta 和阿里巴巴的同规模模型。尽管参数数量相对较少,但 Olmo 2 1B 在性能上表现出色,尤其是在算术推理和事实准确性方面。

Olmo 2 1B 的独特之处

Olmo 2 1B 在 AI 开发平台 Hugging Face 上以宽松的 Apache 2.0 许可证提供,这意味着用户可以自由使用、修改和分发该模型。与大多数商业模型不同,AI2 还提供了用于开发该模型的代码和数据集(Olmo-mix-1124 和 Dolmino-mix-1124),用户可以从头开始复制和训练该模型。

小模型的优势

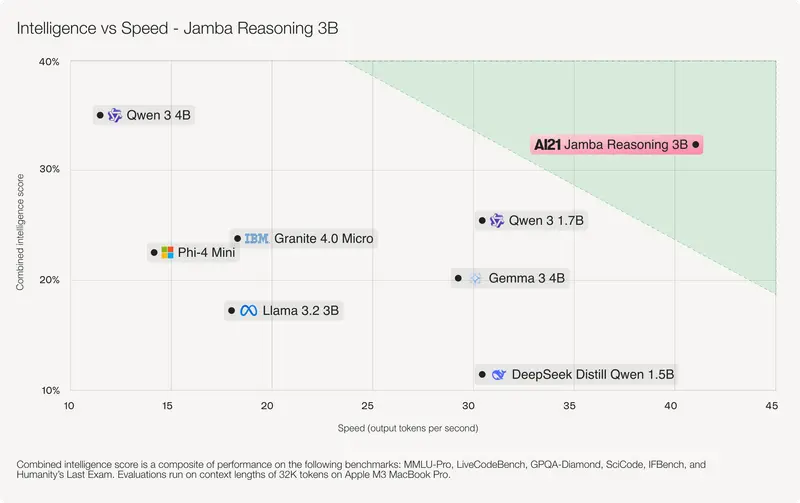

尽管小规模模型在功能上可能不如大型模型强大,但它们具有显著的优势:无需高端硬件即可运行。这意味着开发者和爱好者可以在低端硬件和消费级设备上轻松使用这些模型,大大降低了使用门槛。过去几天,市场上涌现出了一波小规模模型的发布,包括微软的 Phi 4 推理系列和 Qwen 的 2.5 Omni 3B。这些模型都能在现代笔记本电脑甚至移动设备上运行,极大地拓展了 AI 技术的应用场景。

强大的训练数据集

Olmo 2 1B 在包含 4 万亿个令牌的数据集上进行训练,数据来源包括公开可用的内容、AI 生成的内容和人工创建的内容。令牌是模型输入和生成的原始数据片段,100 万个令牌大约相当于 75 万个单词。这种多样化的数据集使得 Olmo 2 1B 在处理各种任务时表现出色。

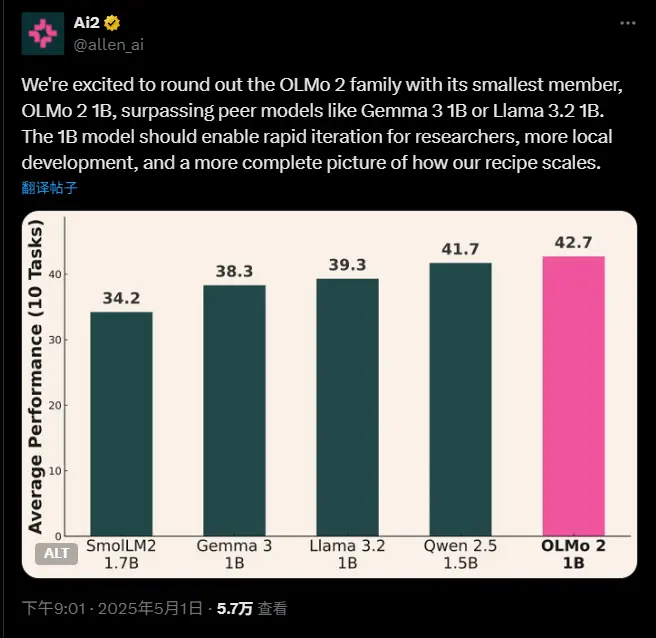

基准测试中的优异表现

在多项基准测试中,Olmo 2 1B 的表现尤为突出:

- GSM8K 基准测试:用于测量算术推理能力,Olmo 2 1B 的得分高于谷歌的 Gemma 3 1B、Meta 的 Llama 3.2 1B 和阿里巴巴的 Qwen 2.5 1.5B。

- TruthfulQA 测试:用于评估事实准确性,Olmo 2 1B 的性能也超过了上述三个模型。

这些测试结果表明,Olmo 2 1B 在处理复杂问题和提供准确信息方面具有显著优势。

使用风险与建议

尽管 Olmo 2 1B 在性能上表现出色,但 AI2 也提醒用户注意其潜在风险。与所有 AI 模型一样,Olmo 2 1B 可能会产生“有问题的输出”,包括有害和“敏感”内容,甚至可能出现事实不准确的陈述。因此,AI2 建议用户不要在商业环境中部署 Olmo 2 1B,以避免潜在的负面影响。

相关文章