阿里通义实验室推出一种创新的强化学习框架ZEROSEARCH,通过模拟搜索引擎来提升大语言模型(LLMs)的信息检索能力,而无需与真实搜索引擎进行交互。该框架通过轻量级的监督微调(SFT),将 LLM 转化为能够生成相关和噪声文档的检索模块,并通过课程式(curriculum-based)的 rollout 策略逐步提升模型的推理能力。

- 项目主页:https://alibaba-nlp.github.io/ZeroSearch

- GitHub:https://github.com/Alibaba-NLP/ZeroSearch

- 模型:https://huggingface.co/collections/sunhaonlp/zerosearch-681b4ce012b9b6899832f4d0

例如,一个场景,用户询问:“谁是为‘Smokey the Bear’配音的人的妻子?”ZEROSEARCH 的模型会首先在内部进行推理,生成一个搜索查询,例如“Smokey the Bear 配音演员”。然后,模拟的搜索引擎会返回一系列文档,这些文档可能是相关的,也可能是噪声的。模型会根据这些文档进一步推理,并生成下一个查询,例如“Sam Elliott 妻子”,最终找到答案“Katharine Ross”。这一过程展示了模型如何通过模拟的搜索引擎逐步推理并找到正确答案。

主要功能

- 提升搜索能力:通过模拟搜索引擎,ZEROSEARCH 能够提升 LLM 的信息检索能力,使其在生成回答时更加准确和可靠。

- 无需真实搜索引擎:该框架完全在离线环境中运行,无需与真实搜索引擎交互,避免了高昂的 API 成本和不可控的文档质量。

- 课程式训练:通过逐步增加检索文档的噪声水平,ZEROSEARCH 能够逐步提升模型的推理能力,使其适应更具挑战性的检索场景。

主要特点

- 模拟搜索引擎:通过轻量级的监督微调,将 LLM 转化为能够生成相关和噪声文档的检索模块。

- 课程式 rollout 策略:在训练过程中,逐步降低生成文档的质量,模拟更具挑战性的检索场景,从而提升模型的推理能力。

- 高效训练:ZEROSEARCH 支持大规模并行训练,通过增加 GPU 数量显著加速文档生成过程,提高训练效率。

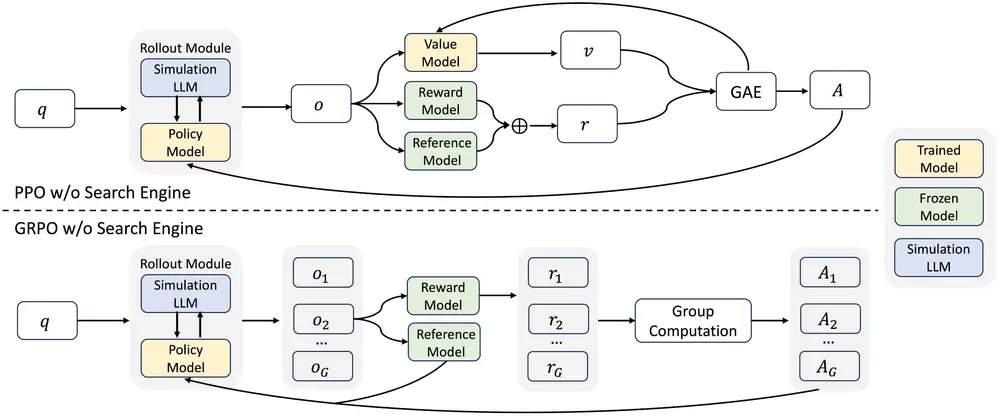

- 广泛的兼容性:该框架适用于不同参数规模的 LLM,包括基础模型和指令调优模型,并且与多种强化学习算法(如 PPO 和 GRPO)兼容。

工作原理

- 轻量级监督微调:通过收集与真实搜索引擎交互的数据,对 LLM 进行微调,使其能够生成相关和噪声文档。

- 课程式 rollout:在训练过程中,逐步增加检索文档的噪声水平,使模型逐步适应更具挑战性的检索场景。

- 强化学习优化:使用强化学习算法(如 PPO 和 GRPO)优化模型的搜索策略,通过奖励信号激励模型生成准确的答案。

- 损失掩码机制:对检索到的文档标记进行损失掩码,避免这些外部生成的标记对训练过程引入噪声。

测试结果

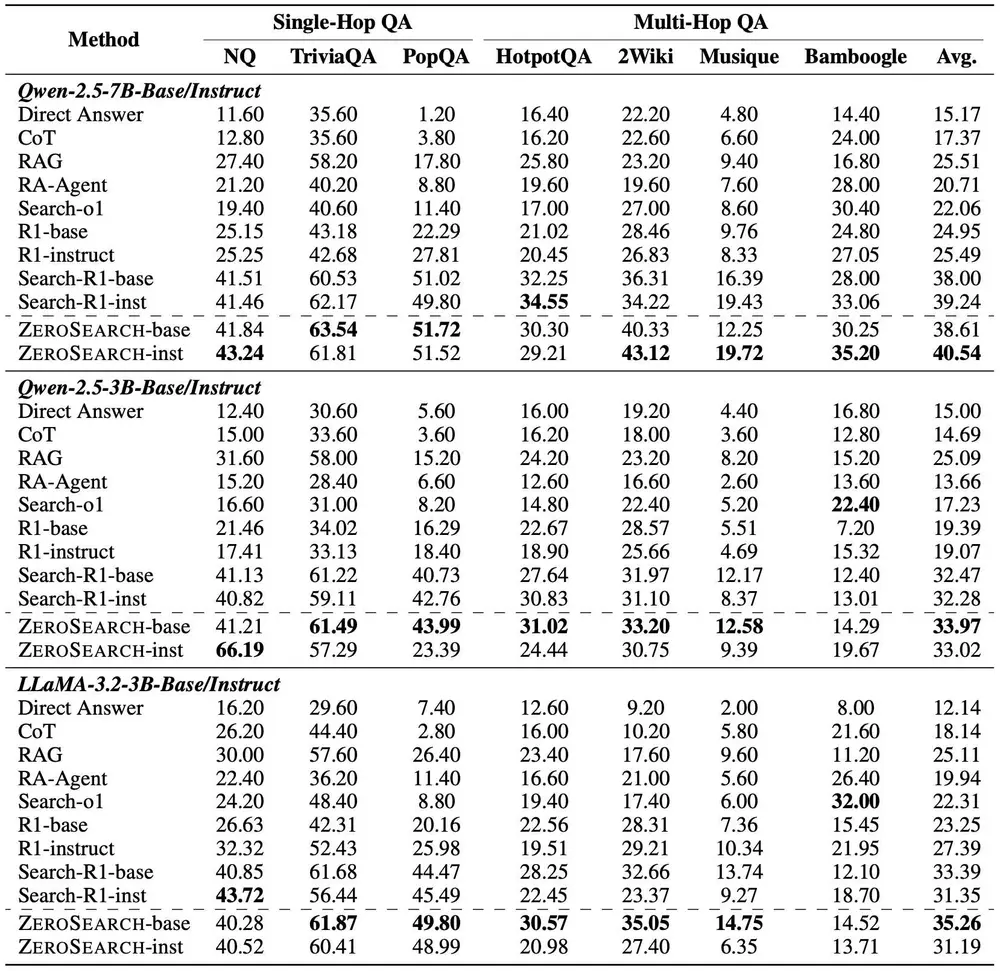

- 性能提升:ZEROSEARCH 在多个问答基准测试中表现出色,显著优于基于真实搜索引擎的模型。例如,在 NQ、TriviaQA 和 PopQA 等数据集上,ZEROSEARCH 的平均性能比 Search-R1(基于真实搜索引擎的模型)高出约 5-10 个百分点。

- 模型泛化能力:ZEROSEARCH 在不同参数规模的 LLM 上均表现出良好的泛化能力,无论是基础模型还是指令调优模型,都能有效提升搜索能力。

- 成本效益:与基于真实搜索引擎的方法相比,ZEROSEARCH 完全消除了 API 成本,仅需部署在 GPU 服务器上,显著降低了训练成本。

应用场景

- 问答系统:ZEROSEARCH 可以用于构建更智能的问答系统,提升系统在处理复杂问题时的准确性和可靠性。

- 内容创作:在内容创作领域,ZEROSEARCH 可以帮助生成更准确、更有依据的文章和报告。

- 教育和培训:通过提供更准确的信息检索能力,ZEROSEARCH 可以用于开发更有效的教育工具和培训材料。

- 企业应用:在企业环境中,ZEROSEARCH 可以集成到内部知识管理系统中,提升员工获取信息的效率和准确性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...